演習 - マッピング データ フローを使用して、タイプ 1 の緩やかに変化するディメンションを設計して実装する

この演習では、Azure Synapse 専用 SQL プールをソースとターゲットとして使用して、タイプ 1 の SCD のデータ フローを作成します。 このデータ フローを Synapse パイプラインに追加して、抽出、変換、読み込み (ETL) プロセスの一部として実行できます。

ソースとディメンション テーブルの設定

この演習では、Azure SQL、Azure ストレージなどのさまざまなシステムの種類のソース データから、Azure Synapse でディメンション テーブルを読み込む必要があります。この例では、Azure Synapse データベースにソース データを作成して、シンプルにします。

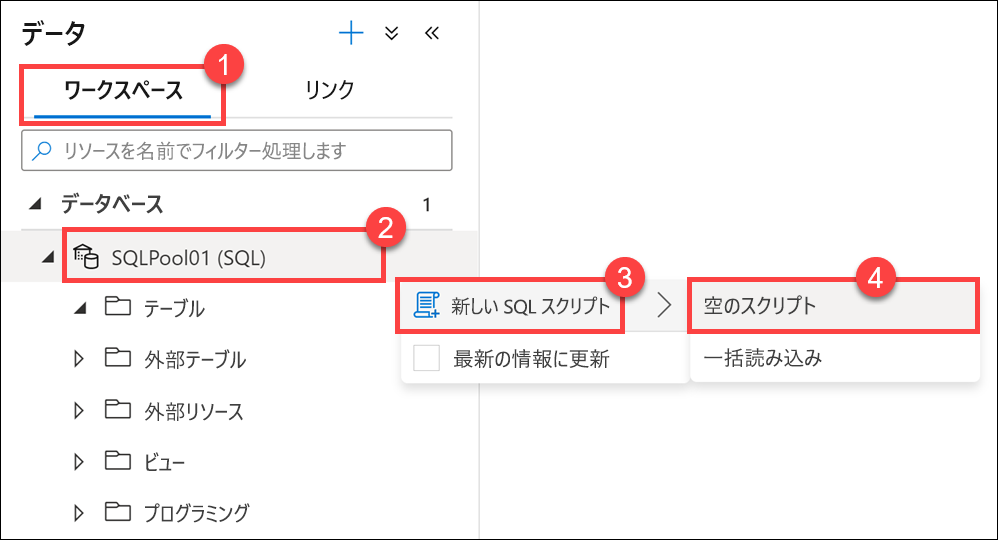

Synapse Studio から、[データ] ハブに移動します。

[ワークスペース] タブ (1) を選択し、[データベース] を展開して、SQLPool01 (2) を右クリックします。 [New SQL script](新しい SQL スクリプト) (3) を選択し、[Empty script](空のスクリプト) (4) を選択します。

次のスクリプトを空のスクリプト ウィンドウに貼り付け、[実行] または

F5キーを押してクエリを実行します。CREATE TABLE [dbo].[CustomerSource] ( [CustomerID] [int] NOT NULL, [Title] [nvarchar](8), [FirstName] [nvarchar](50), [MiddleName] [nvarchar](50), [LastName] [nvarchar](50), [Suffix] [nvarchar](10), [CompanyName] [nvarchar](128), [SalesPerson] [nvarchar](256), [EmailAddress] [nvarchar](50), [Phone] [nvarchar](25) ) WITH ( HEAP ) COPY INTO [dbo].[CustomerSource] FROM 'https://solliancepublicdata.blob.core.windows.net/dataengineering/dp-203/awdata/CustomerSource.csv' WITH ( FILE_TYPE='CSV', FIELDTERMINATOR='|', FIELDQUOTE='', ROWTERMINATOR='0x0a', ENCODING = 'UTF16' ) CREATE TABLE dbo.[DimCustomer]( [CustomerID] [int] NOT NULL, [Title] [nvarchar](8) NULL, [FirstName] [nvarchar](50) NOT NULL, [MiddleName] [nvarchar](50) NULL, [LastName] [nvarchar](50) NOT NULL, [Suffix] [nvarchar](10) NULL, [CompanyName] [nvarchar](128) NULL, [SalesPerson] [nvarchar](256) NULL, [EmailAddress] [nvarchar](50) NULL, [Phone] [nvarchar](25) NULL, [InsertedDate] [datetime] NOT NULL, [ModifiedDate] [datetime] NOT NULL, [HashKey] [char](64) ) WITH ( DISTRIBUTION = REPLICATE, CLUSTERED COLUMNSTORE INDEX )![Create table スクリプト スクリプトと [実行] ボタンの両方が強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/synapse-create-customer-table.png)

マッピング データ フローを作成する

マッピング データ フローはパイプライン アクティビティで、コードを書かないデータ変換方法を指定する視覚的な方法を提供します。 次に、タイプ 1 の SCD を作成するマッピング データ フローを作成します。

[開発] ハブに移動します。

[+] を選んでから、[データ フロー] を選びます。

![新しいデータ フロー プラス ボタンと [データ フロー] メニュー項目が強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/new-data-flow.png)

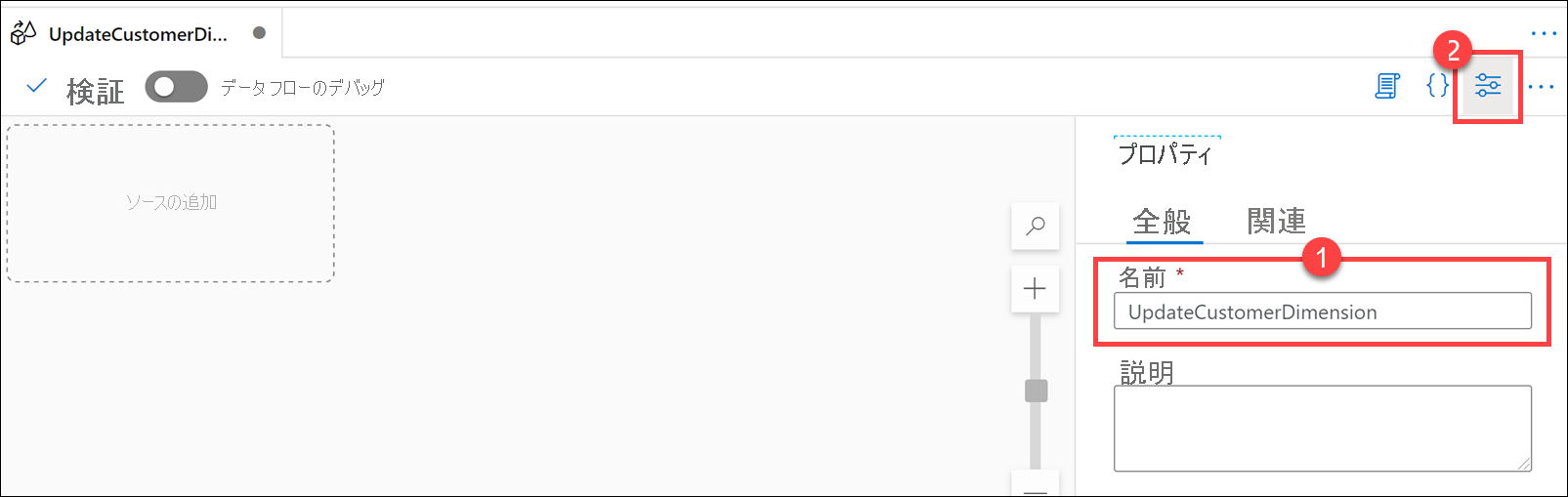

新しいデータ フローのプロパティ ペインで、[名前] フィールド (1) に「

UpdateCustomerDimension」と入力し、[プロパティ] ボタン (2) を選択してプロパティ ペインを非表示にします。

キャンバス上の [ソースの追加] を選択します。

![ソースの追加 データ フロー キャンバスの [ソースの追加] ボタンが強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-add-source.png)

Source settingsで、次のプロパティを構成します。- [出力ストリーム名]: 「

SourceDB」を入力します - [ソースの種類]:

Datasetを選択します - [オプション]:

Allow schema driftをオンにし、他のオプションをオフのままにします - [サンプリング]:

Disableを選択します - [データセット]: [+ 新規] を選択して、新しいデータセットを作成します

![ソースの設定 [データセット] の横にある [新規] ボタンが強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-source-new-dataset.png)

- [出力ストリーム名]: 「

新しい統合データセット ダイアログで、[Azure Synapse Analytics] を選択し、[続行] を選択します。

![新しい統合データセット Azure SQL Database と [続行] ボタンが強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-new-integration-dataset-synapse.png)

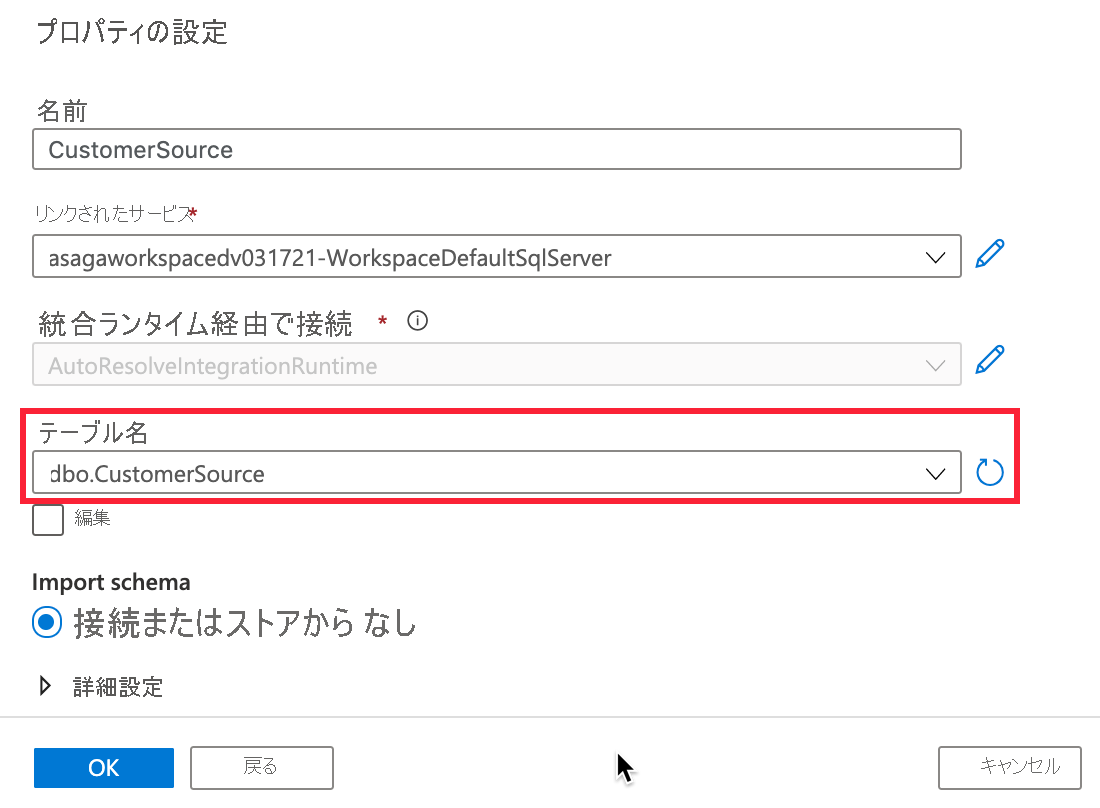

データセットのプロパティで、次のように構成します。

- [名前]: 「

CustomerSource」を入力します - [リンクされたサービス]: Synapse ワークスペースのリンクされたサービスを選択します

- [テーブル名]: ドロップダウンの横にある [更新] ボタンを選択します

![更新 フォームが説明に従って構成され、[更新] ボタンが強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-new-integration-dataset-source-refresh.png)

- [名前]: 「

[値] フィールドにご自分の SQL プール名を入力し、[OK] を選択します。

[テーブル名] で

dbo.CustomerSourceを選択し、[スキーマのインポート] でFrom connection/storeを選択し、[OK] を選択して、データセットを作成します。

追加した

CustomerSourceデータセットの横にある [開く] を選択します。![データセットを開く 新しいデータセットの横にある [開く] ボタンが強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-source-dataset-open.png)

DBNameの横にある [値] フィールドにご自分の SQL プール名を入力します。データ フロー エディターで、SourceDB アクティビティの下にある [ソースの追加] ボックスを選択します。 CustomerSource で使用したのと同じ手順に従って、このソースを DimCustomer テーブルとして構成します。

- [出力ストリーム名]: 「

DimCustomer」を入力します - [ソースの種類]:

Datasetを選択します - [オプション]:

Allow schema driftをオンにし、他のオプションをオフのままにします - [サンプリング]:

Disableを選択します - [データセット]: [+ 新規] を選択して、新しいデータセットを作成します。 リンクされたサービスの Azure Synapse を使用して、DimCustomer テーブルを選択します。 ご自分の SQL プール名には必ず DBName を設定してください。

![DimCustomer ソースの設定 [ソースの設定] で、ソースの追加、出力ストリーム名、データセット名が強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-source-dimcustomer.png)

- [出力ストリーム名]: 「

変換をデータ フローに追加する

キャンバス上の

SourceDBソースの右側にある [+] を選んでから、[派生列] を選びます。![新しい派生列 プラス ボタンと [派生列] メニュー項目が強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-new-derived-column.png)

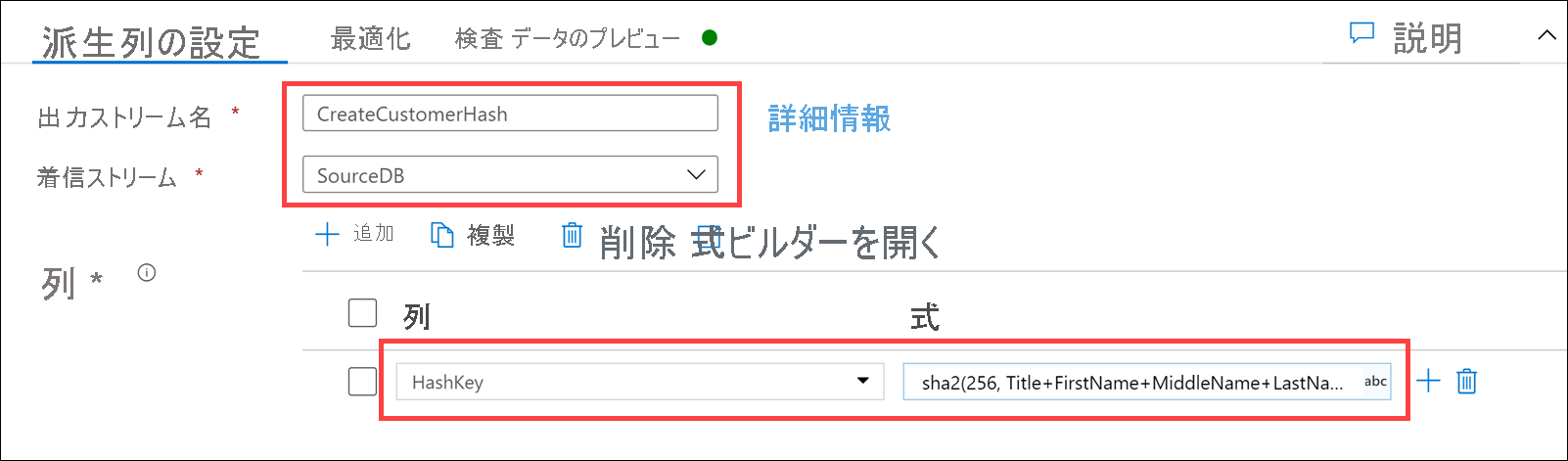

Derived column's settingsで、次のプロパティを構成します。- [出力ストリーム名]: 「

CreateCustomerHash」を入力します - [Incoming stream](受信ストリーム):

SourceDBを選択します - [列]: 次のように入力します。

列 式 説明 「 HashKey」を入力sha2(256, iifNull(Title,'') +FirstName +iifNull(MiddleName,'') +LastName +iifNull(Suffix,'') +iifNull(CompanyName,'') +iifNull(SalesPerson,'') +iifNull(EmailAddress,'') +iifNull(Phone,''))テーブル値の SHA256 ハッシュを作成します。 これを使用して、入力レコードのハッシュとターゲット レコードのハッシュ値を比較し、 CustomerID値で照合することで、行の変更を検出します。iifNull関数を使用して、null 値を空の文字列に置き換えます。 それ以外の場合、null エントリが存在すると、ハッシュ値が重複する傾向があります。

- [出力ストリーム名]: 「

キャンバス上の

CreateCustomerHash派生列の右側にある [+] を選んでから、[存在する] を選びます。![新しい存在 プラス ボタンと [存在する] メニュー項目の両方が強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-new-exists.png)

Exists settingsで、次のプロパティを構成します。- [出力ストリーム名]: 「

Exists」を入力します - [Left stream](左側のストリーム):

CreateCustomerHashを選択します - [Right stream](右側のストリーム):

SynapseDimCustomerを選択します - [Exist type](存在タイプ):

Doesn't existを選択します - [Exists conditions](存在条件): 左と右に次のように設定します。

左: CreateCustomerHash の列 右: SynapseDimCustomer の列 HashKeyHashKey![exists 設定 [exists 設定] フォームが説明に従って構成されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-exists-form.png)

- [出力ストリーム名]: 「

キャンバス上の

Existsの右側にある [+] を選んでから、[検索] を選びます。![新しい検索 プラス ボタンと [検索] メニュー項目の両方が強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-new-lookup.png)

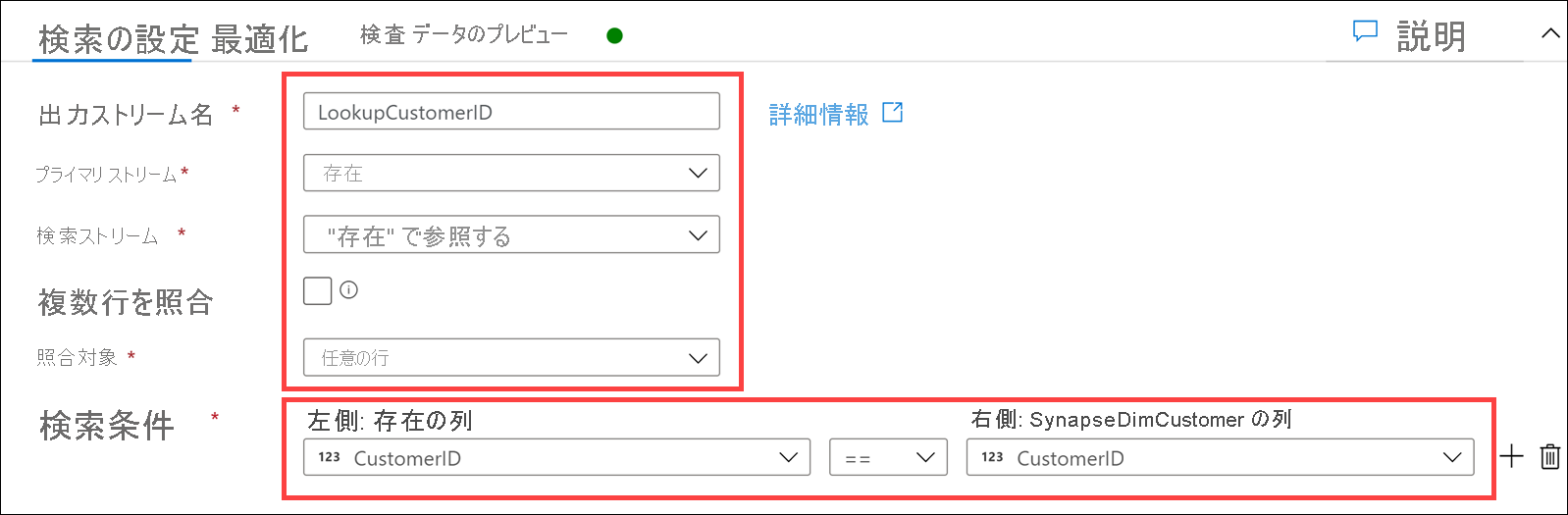

Lookup settingsで、次のプロパティを構成します。- [出力ストリーム名]: 「

LookupCustomerID」を入力します - [Primary stream](プライマリ ストリーム):

Existsを選択します - [Lookup stream](検索ストリーム):

SynapseDimCustomerを選択します - [Match multiple rows](複数の行の一致): オフ

- [Match on](一致対象):

Any rowを選択します - [Lookup conditions](検索条件): 左と右に次のように設定します。

左: Exists の列 右: SynapseDimCustomer の列 CustomerIDCustomerID

- [出力ストリーム名]: 「

キャンバス上の

LookupCustomerIDの右側にある [+] を選んでから、[派生列] を選択します。![新しい派生列 プラス ボタンと [派生列] メニュー項目の両方が強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-new-derived-column-2.png)

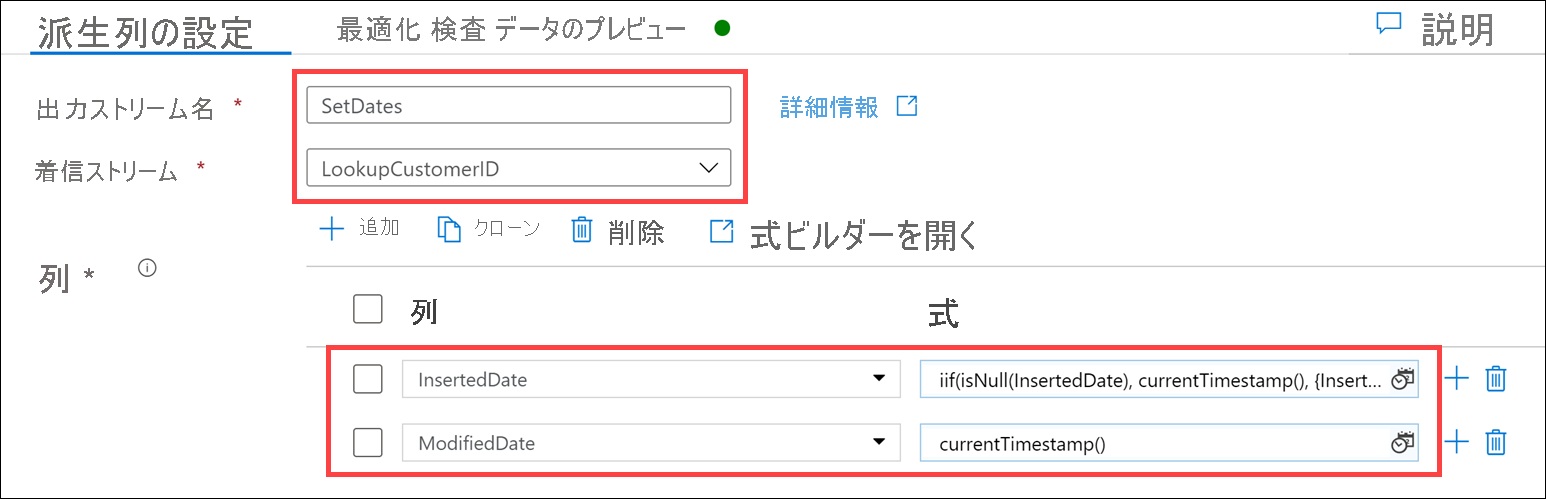

Derived column's settingsで、次のプロパティを構成します。- [出力ストリーム名]: 「

SetDates」を入力します - [Incoming stream](受信ストリーム):

LookupCustomerIDを選択します - [列]: 次のように入力します。

列 式 説明 [ InsertedDate] を選択しますiif(isNull(InsertedDate), currentTimestamp(), {InsertedDate})InsertedDate値が null の場合、現在のタイムスタンプを挿入します。 それ以外の場合は、InsertedDate値を使用します。[ ModifiedDate] を選択しますcurrentTimestamp()常に ModifiedDate値を現在のタイムスタンプで値を更新します。

注意

2 番目の列を挿入するには、[列] リストの上にある [+ 追加] を選択し、[列の追加] を選択します。

- [出力ストリーム名]: 「

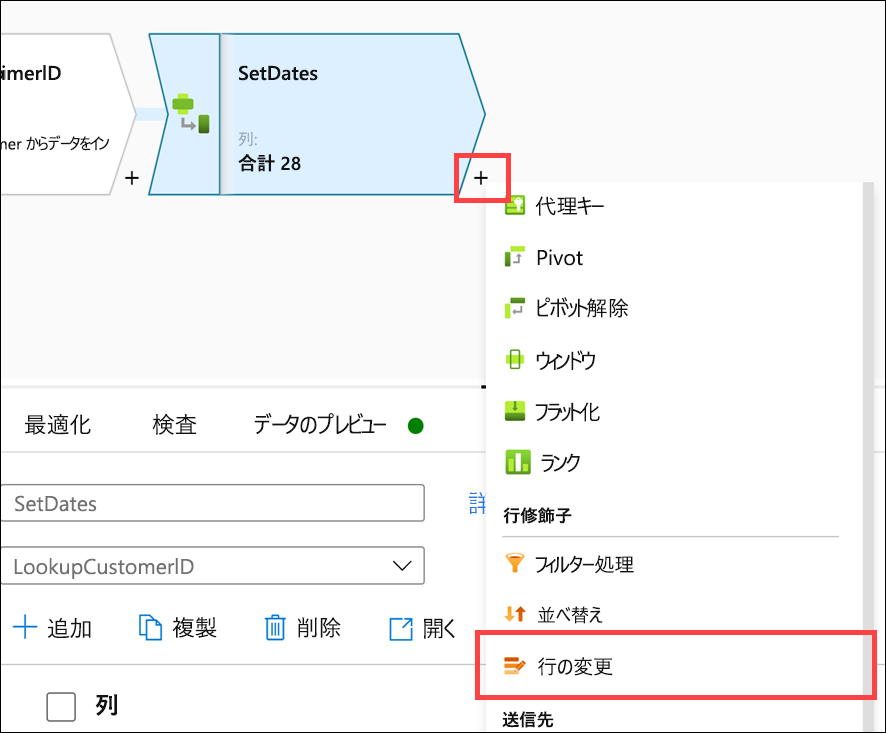

キャンバス上の

SetDates派生列の右側にある [+] を選んでから、[行の変更] を選びます。

Alter row settingsで、次のプロパティを構成します。- [出力ストリーム名]: 「

AllowUpserts」を入力します - [Incoming stream](受信ストリーム):

SetDatesを選択します - [Alter row conditions](行の変更条件): 次のように入力します。

条件 式 説明 [ Upsert if] を選択しますtrue()Upsert if条件で、条件をtrue()に設定して、アップサートを許可します。 これにより、マッピング データ フローのステップを通過するすべてのデータが確実にシンクに挿入または更新されるようになります。![行の変更の設定 [行の変更の設定] フォームが説明に従って構成されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-alter-row-settings.png)

- [出力ストリーム名]: 「

キャンバス上の

AllowUpserts行の変更ステップの右側にある [+] を選んでから、[シンク] を選びます。![新しいシンク プラス ボタンと [シンク] メニュー項目の両方が強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-new-sink.png)

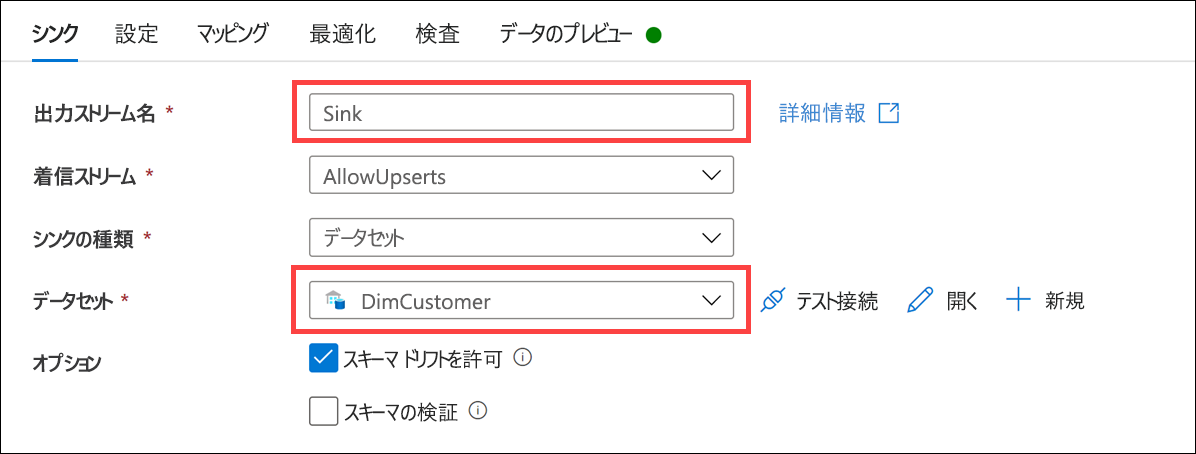

Sinkで、次のプロパティを構成します。- [出力ストリーム名]: 「

Sink」を入力します - [Incoming stream](受信ストリーム):

AllowUpsertsを選択します - [Sink type](シンクの種類):

Datasetを選択します - [データセット]:

DimCustomerを選択します - [オプション]:

Allow schema driftをオン、Validate schemaをオフにします

- [出力ストリーム名]: 「

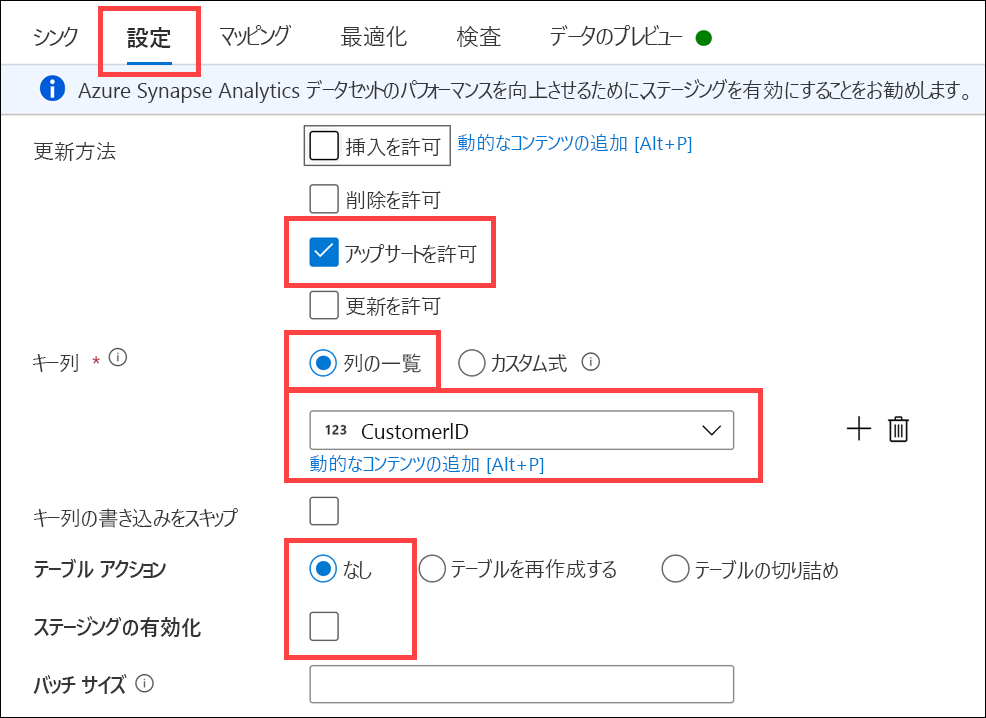

[設定] タブを選択し、次のプロパティを構成します。

- [更新方法]:

Allow upsertをオン、他のすべてのオプションをオフにします - [キー列]:

List of columnsを選択し、リスト内のCustomerIDを選択します - [Table action](テーブル アクション):

Noneを選択します - [Enable staging](ステージングを有効にする): オフ

- [更新方法]:

[マッピング] タブを選択し、[Auto mapping](自動マッピング) をオフにします。 次に示すように、入力列のマッピングを構成します。

入力列 出力列 SourceDB@CustomerIDCustomerIDSourceDB@TitleTitleSourceDB@FirstNameFirstNameSourceDB@MiddleNameMiddleNameSourceDB@LastNameLastNameSourceDB@SuffixSuffixSourceDB@CompanyNameCompanyNameSourceDB@SalesPersonSalesPersonSourceDB@EmailAddressEmailAddressSourceDB@PhonePhoneInsertedDateInsertedDateModifiedDateModifiedDateCreateCustomerHash@HashKeyHashKey![マッピング [マッピング] 設定が説明に従って構成されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-sink-mapping.png)

完成したマッピング フローは次のようになります。 [すべて公開] を選択して、変更を保存します。

![完成したデータ フロー - すべて公開 完成したデータ フローが表示され、[すべて公開] が強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/data-flow-publish-all.png)

[発行] を選びます。

![すべて公開 [公開] ボタンが強調表示されています。](../../wwl-data-ai/populate-slowly-changing-dimensions-azure-synapse-analytics-pipelines/media/publish-all.png)

データ フローをテストするには

タイプ 1 の SCD データ フローが完成しました。 これのテストを選択した場合は、このデータ フローを Synapse 統合パイプラインに追加できます。 次に、パイプラインを 1 回実行して、顧客ソース データをターゲットの DimCustomer に初期読み込みすることができます。

パイプラインを追加実行するたびに、ソース テーブル内のデータとディメンション テーブル内に既に存在するデータが (HashKey を使用して) 比較され、変更のあったレコードのみが更新されます。 これをテストするには、ソース テーブル内のレコードを更新した後、パイプラインを再度実行して、ディメンション テーブル内のレコードが更新されることを確認します。

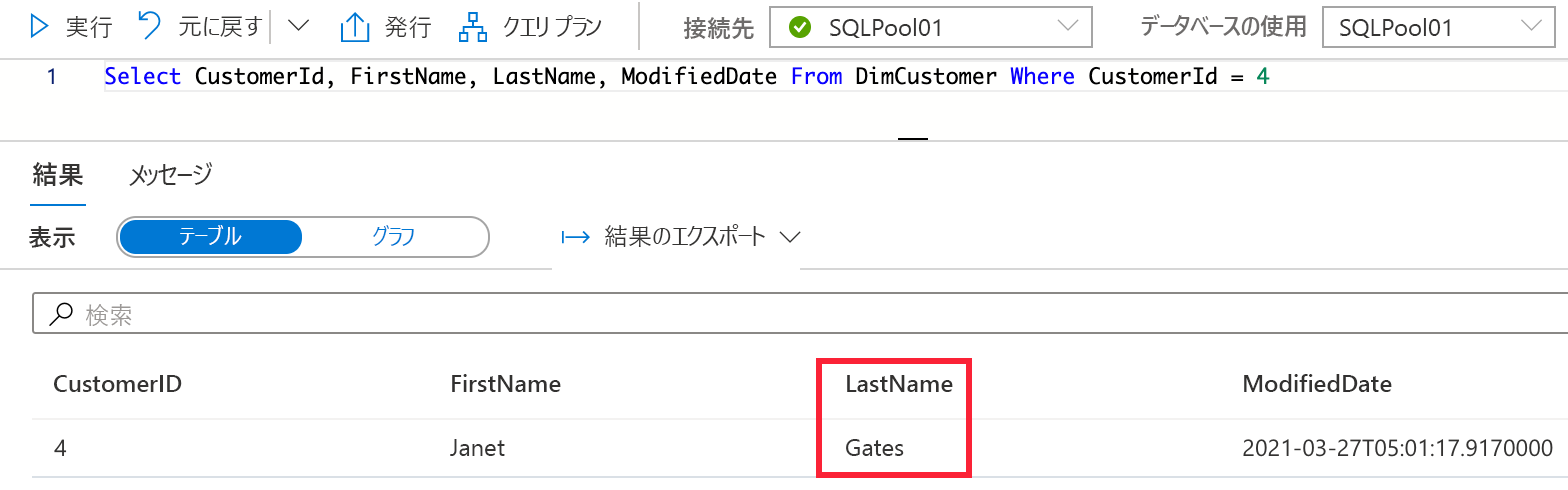

顧客の Janet Gates を例にとります。 初期読み込みで、LastName が Gates、CustomerId が 4 であることが示されます。

次に、ソース テーブル内の顧客の姓を更新するステートメントの例を示します。

UPDATE [dbo].[CustomerSource]

SET LastName = 'Lopez'

WHERE [CustomerId] = 4

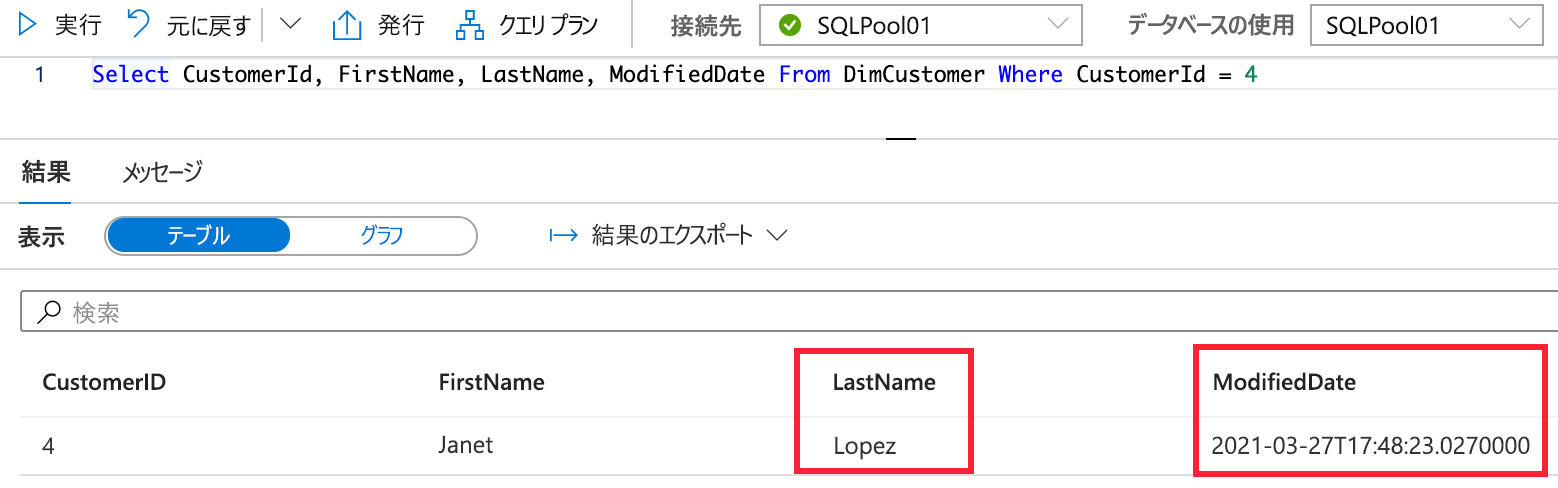

レコードを更新し、パイプラインを再度実行すると、DimCustomer で、この更新されたデータが表示されます。

顧客レコードの LastName 値がソース レコードと一致するように正常に更新され、ModifiedDate も古い LastName 値を追跡せずに更新されました。 これは、タイプ 1 の SCD の予想される動作です。 LastName フィールドに履歴が必要な場合は、テーブルとデータ フローを、これまでに説明した他の SCD タイプのいずれかに変更します。