演習 - データ ファクトリのコピー アクティビティを使う

Data Factory インスタンスの作成が完了したら、リソースに移動し、[作成と監視] ボタンをクリックしてデータ パイプラインの作成を開始できます。 これにより、次の画面が表示されます。

パイプラインの最初の手順では、次の手順を使用して、コピー元とコピー先の間でデータをコピーするコピー アクティビティを作成します。

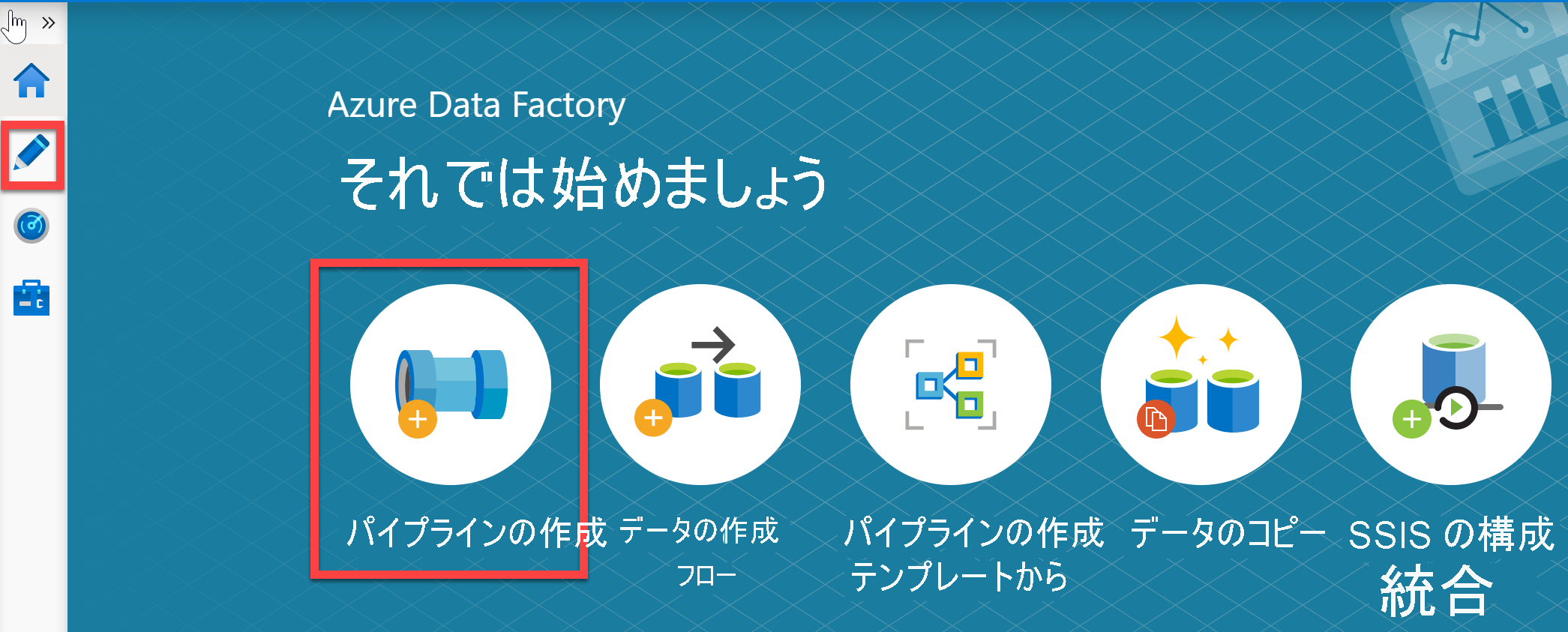

左側のサイド バーの鉛筆アイコン、または [パイプラインの作成] ボタンをクリックして、作成キャンバスを開きます。

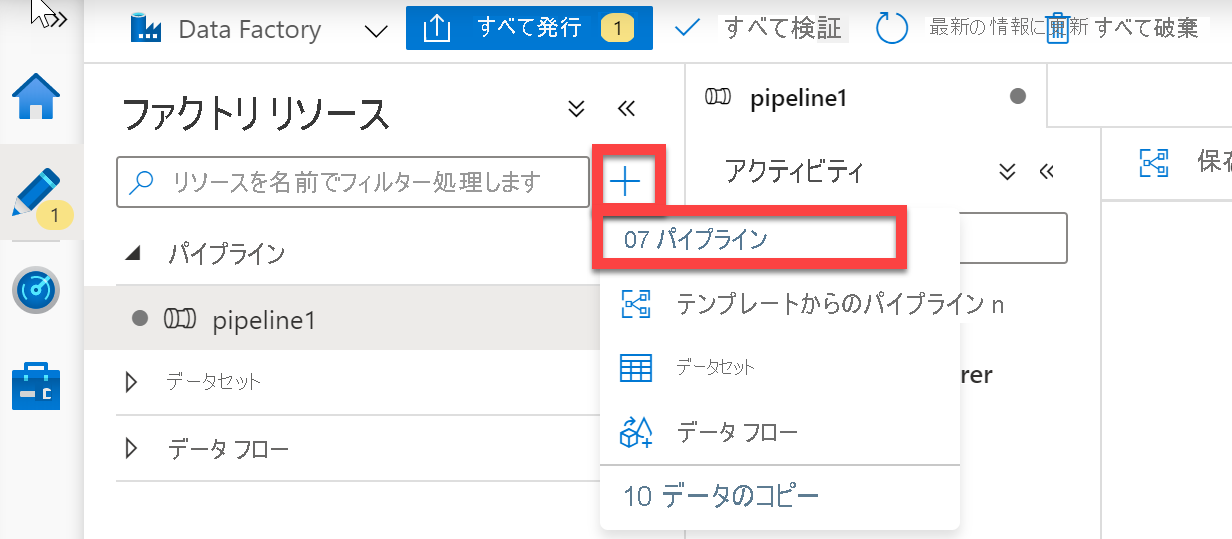

パイプラインを作成します。 [ファクトリ リソース] ペインの + ボタンをクリックして、[パイプライン] を選択します。

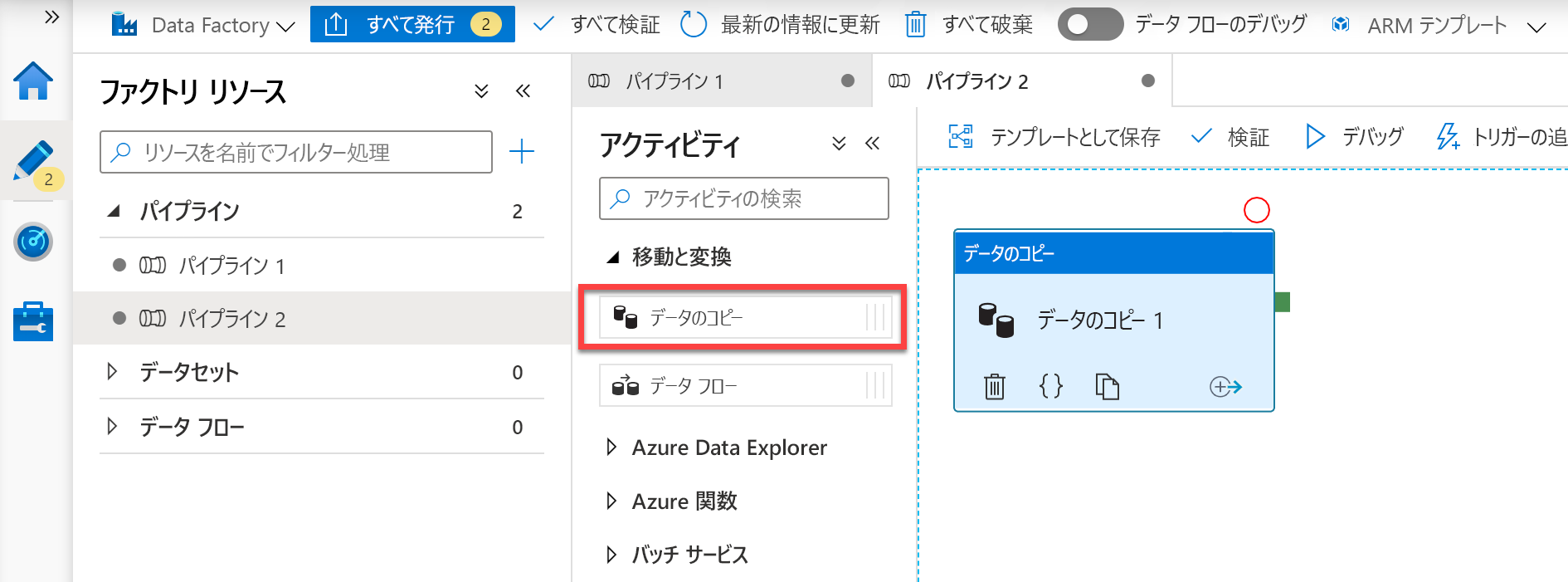

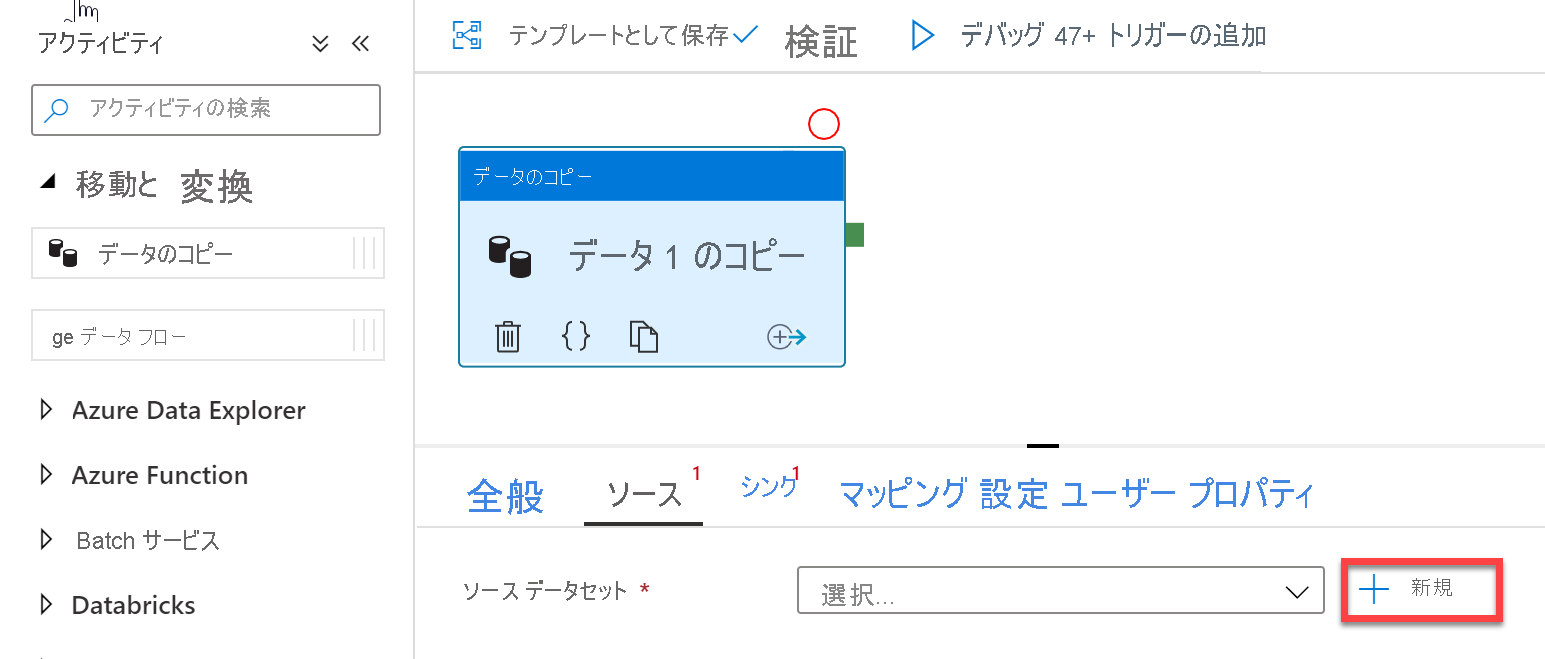

コピー アクティビティを追加します。 [アクティビティ] ペインで [移動と変換] アコーディオンを開き、[データ コピー] アクティビティをパイプライン キャンバスにドラッグします。

コピー アクティビティが追加されたので、ソース データの定義を開始します

コピー アクティビティの設定の [ソース] タブで、[新規] をクリックしてデータ ソースを選択します。

たとえば、データ ストアの一覧で [Amazon S3] タイルを選択して、[続行] をクリックします

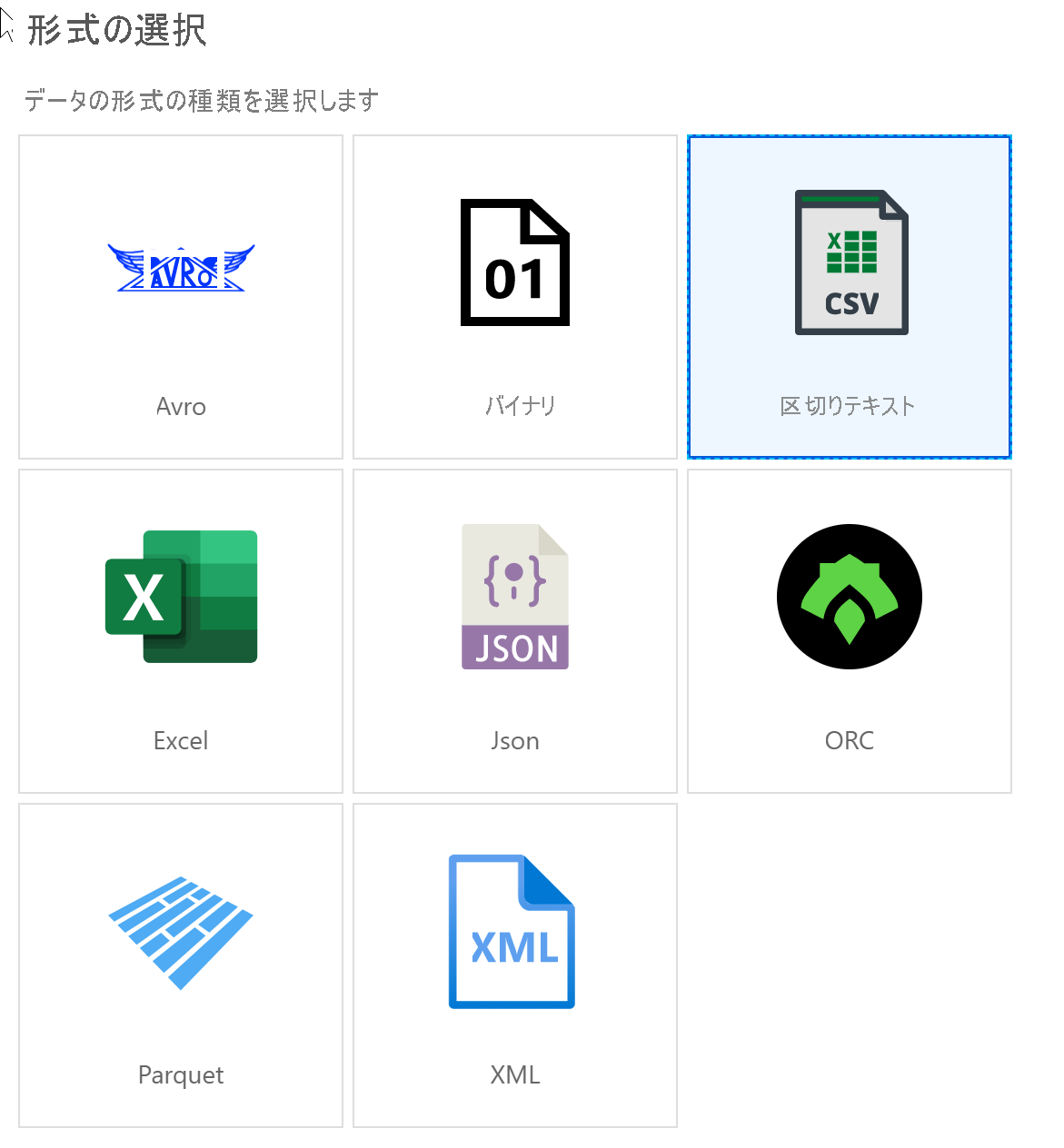

ファイル形式の一覧で [区切り文字付きテキスト] 形式タイルを選択して、[続行] をクリックします

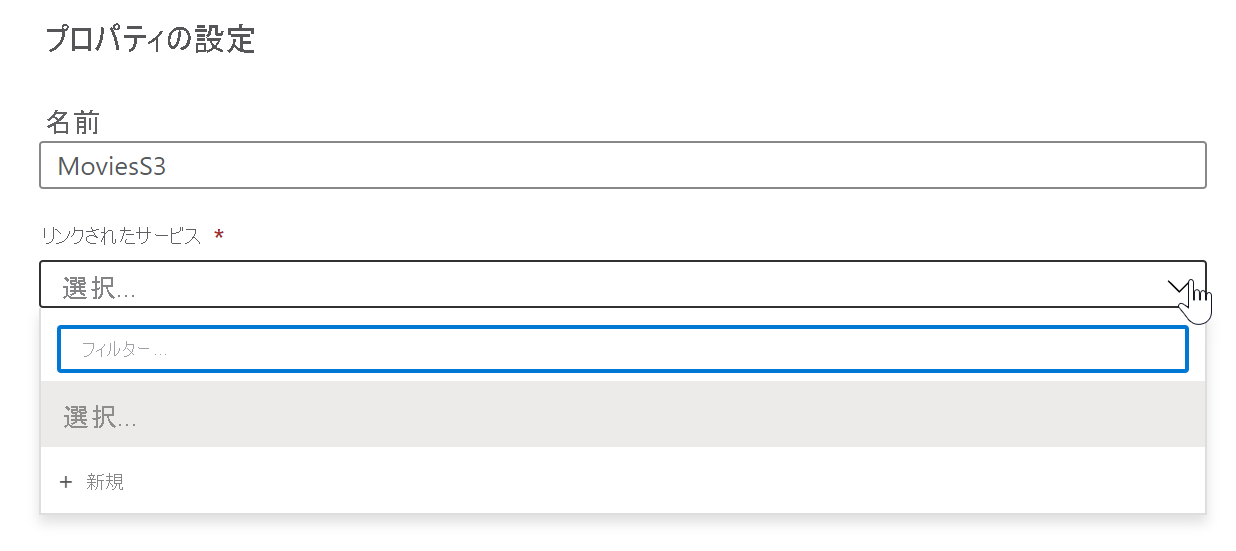

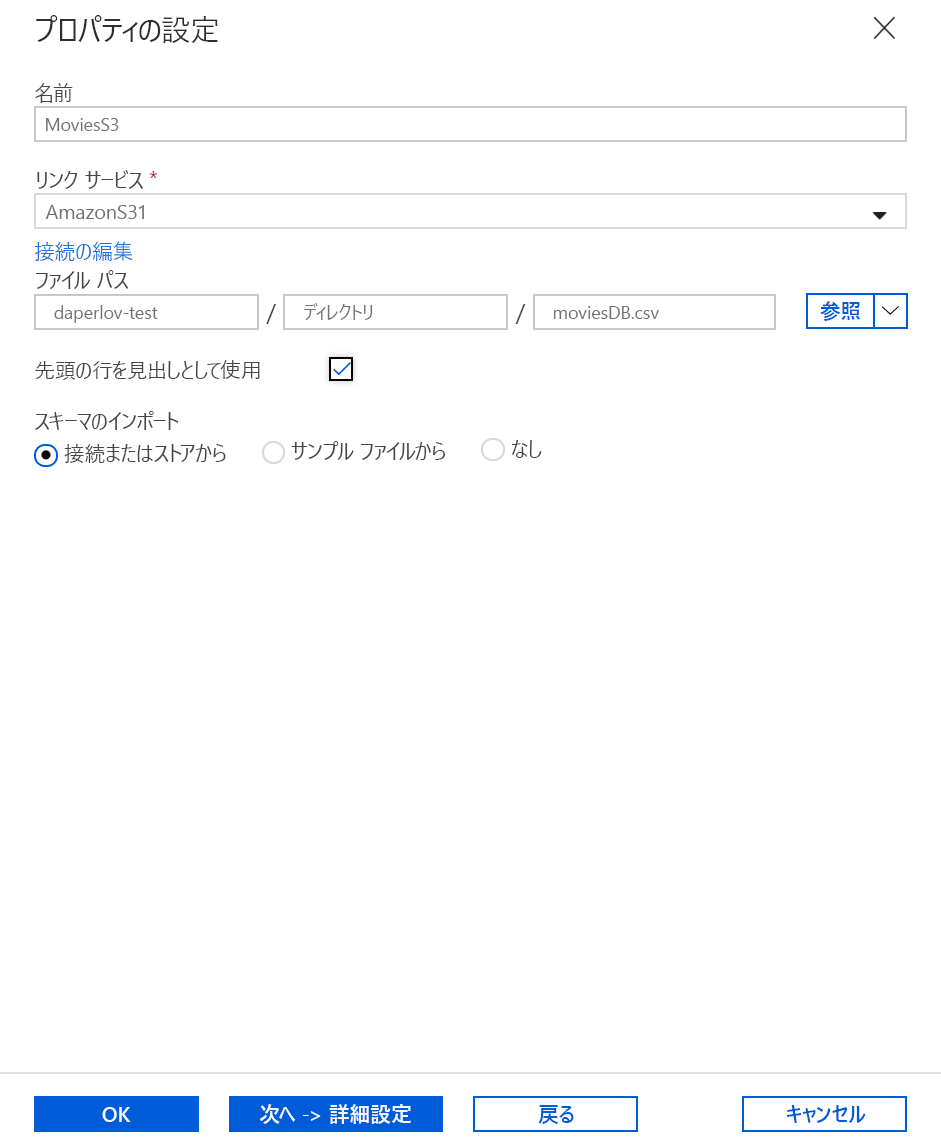

[プロパティの設定] ウィンドウで、データセットにわかりやすい名前を付け、[リンク サービス] ドロップダウンをクリックします。 S3 のリンク サービスを作成していない場合は、[新規] を選択します。

S3 のリンク サービスの構成ペインでは、S3 のアクセス キーと秘密キーを指定します。 Data Factory サービスでは、Microsoft によって管理される証明書を使用して資格情報を暗号化します。 詳細については、データ移動でのセキュリティの考慮事項に関するページを参照してください。 資格情報が有効であることを確認するには、[テスト接続] をクリックします。 完了したら [作成] をクリックします。

リンク サービスを作成して選択したら、残りのデータセット設定を指定します。 これらの設定では、接続でデータをプルする方法と場所を指定します。 完了したら [完了] をクリックします。

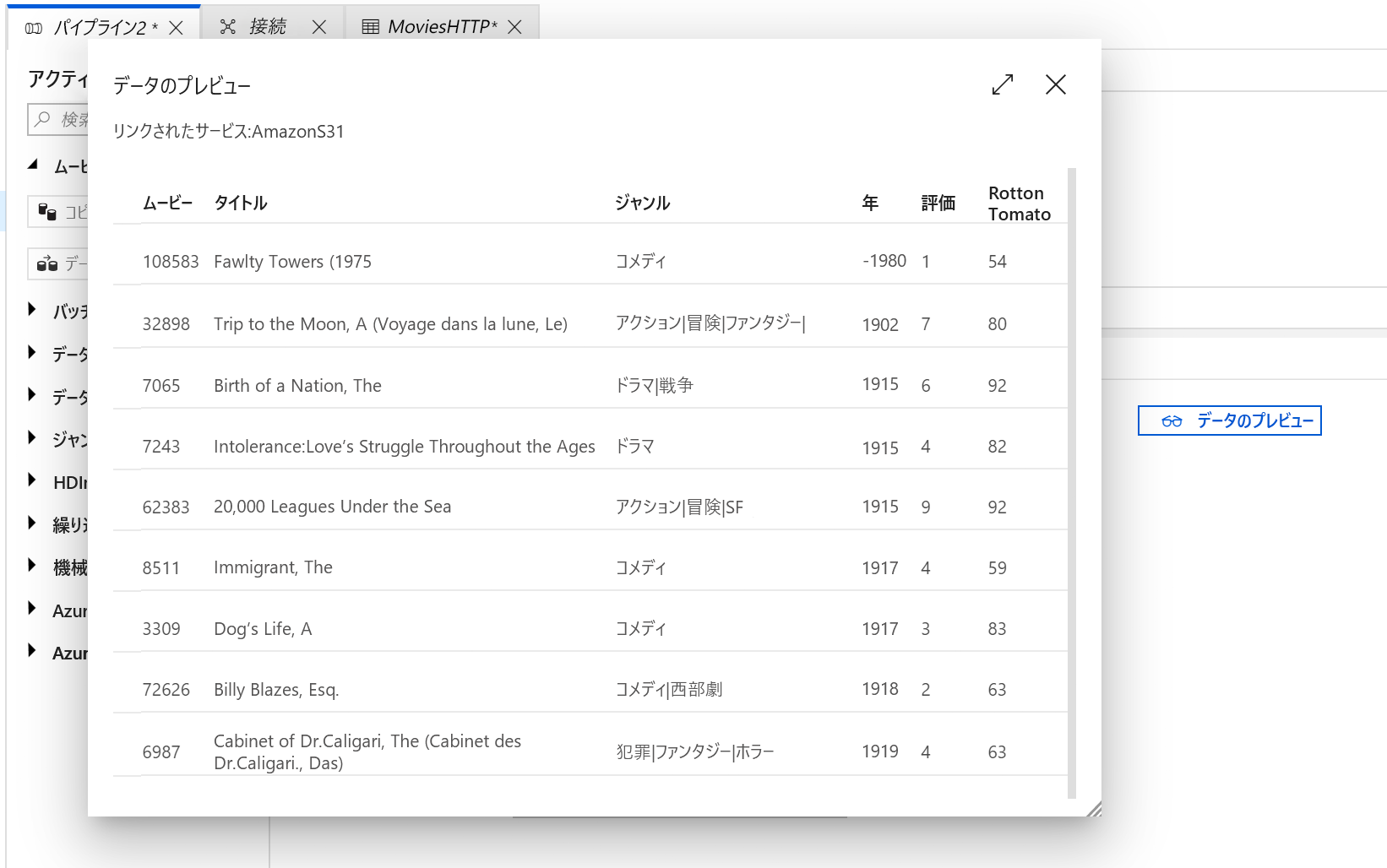

データセットが正しく構成されたことを確認するには、コピー アクティビティの [ソース] タブにある [データのプレビュー] をクリックして、データの小さいスナップショットを取得します。

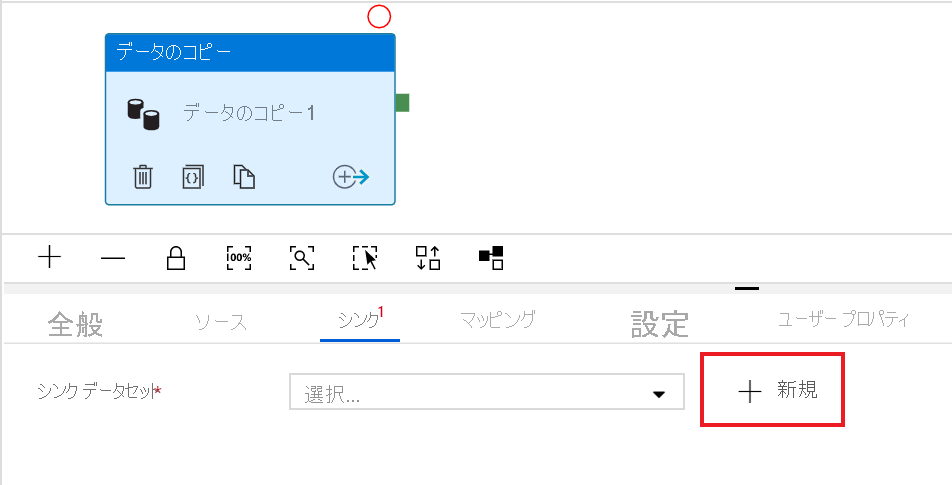

ソース データを定義したので、データの読み込み先のシンクを定義します。 この例では、次の手順を実行して、シンクを Azure Data Lake Storage Gen2 にしています。

[シンク] タブで、[新規] をクリックします

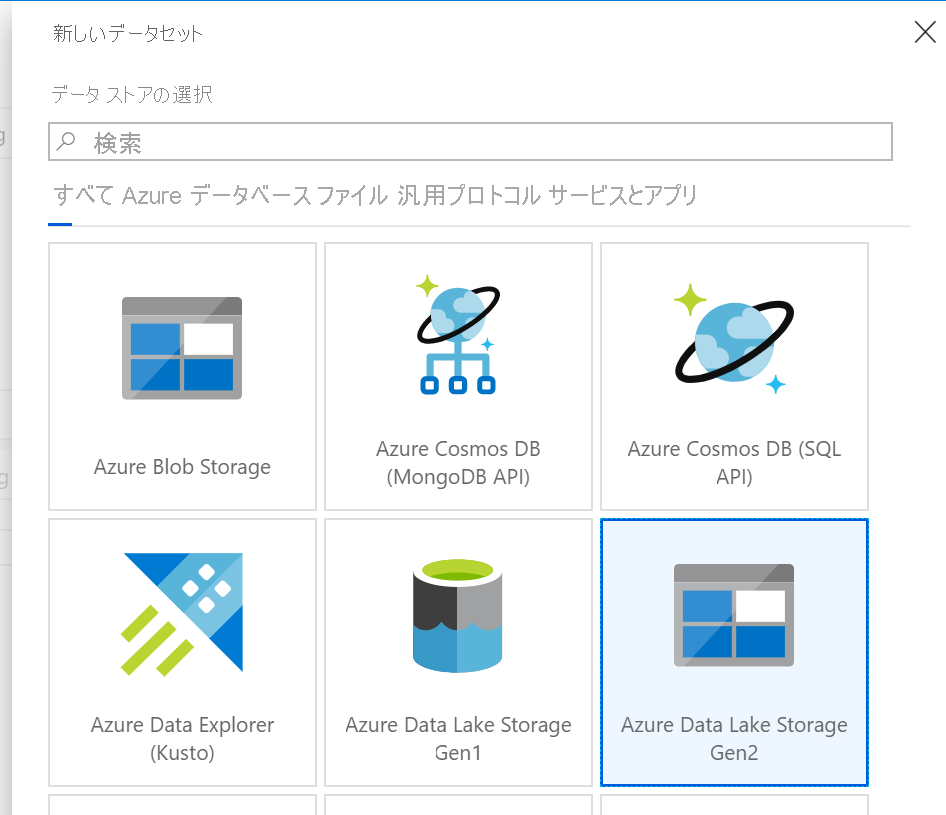

[Azure Data Lake Storage Gen2] タイルを選択し、[続行] をクリックします

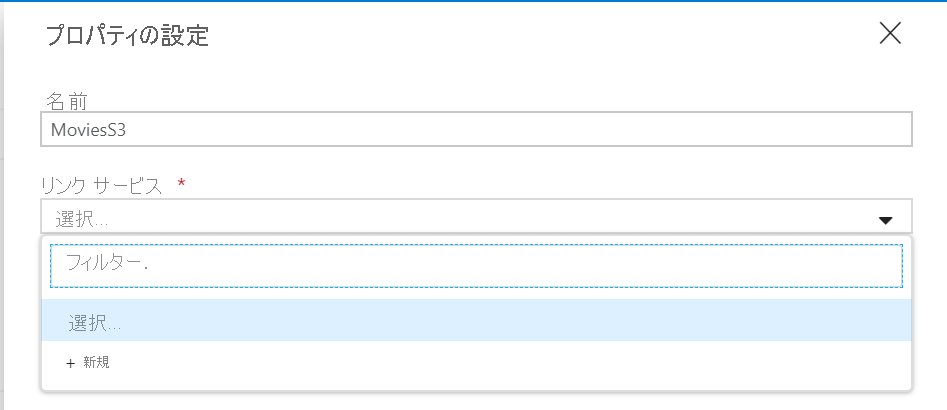

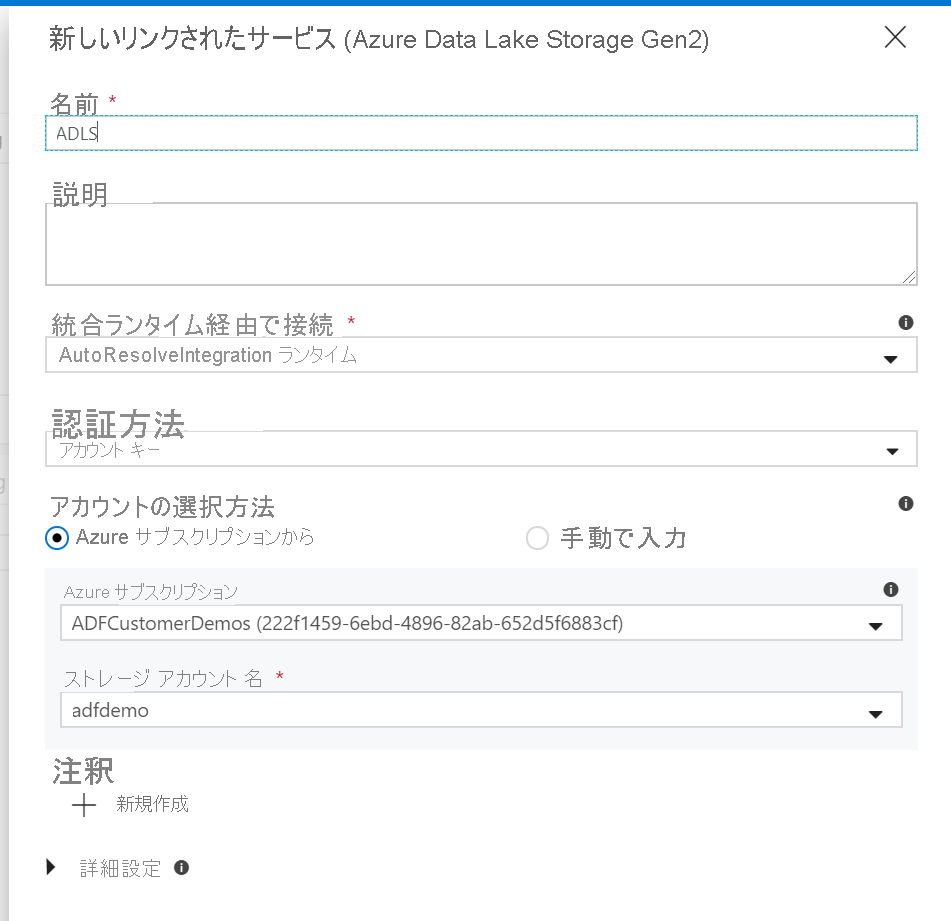

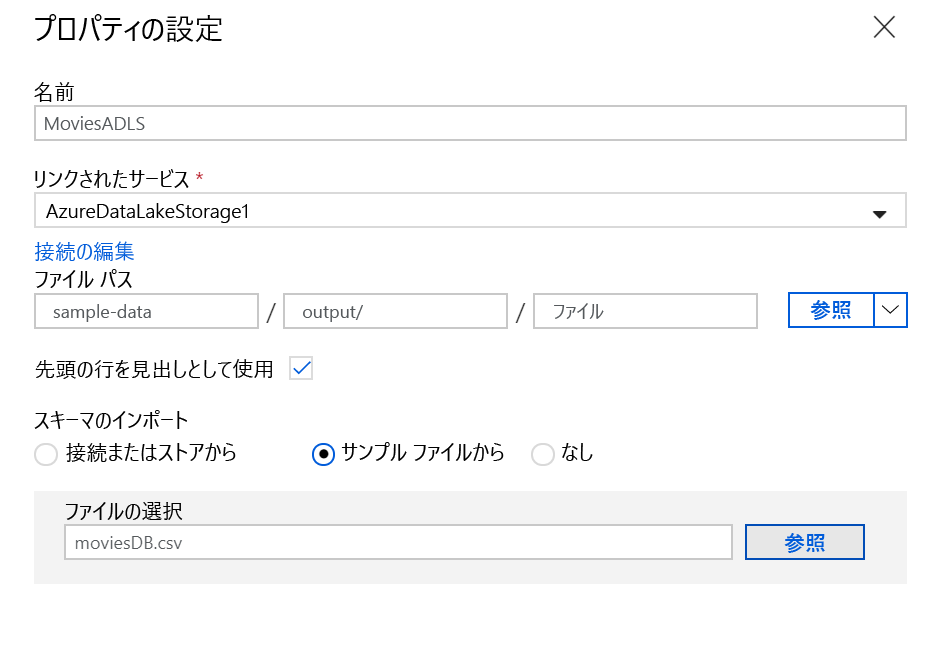

[プロパティの設定] サイド ナビゲーションで、データセットにわかりやすい名前を付け、[リンク サービス] ドロップダウンをクリックします。 ADLS のリンク サービスを作成していない場合は、[新規] を選択します。

ADLS のリンク サービス構成ペインで、[認証方法]を選択して、資格情報を入力します。 次の例では、アカウント キーと、ドロップダウンから選択した自分のストレージ アカウントです。

リンク サービスを構成したら、ADLS データセット構成を入力します。 完了したら [完了] をクリックします。

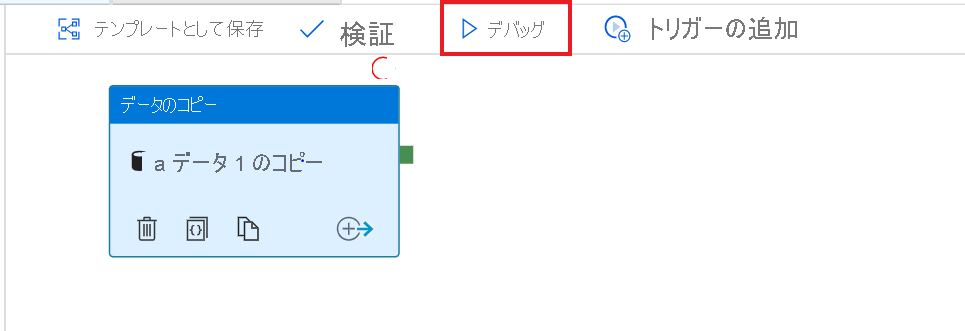

この時点で、コピー アクティビティが完全に構成されました。

それをテストするには、パイプライン キャンバスの上部にある [デバッグ] ボタンをクリックします。 これにより、パイプラインのデバッグの実行が開始されます。

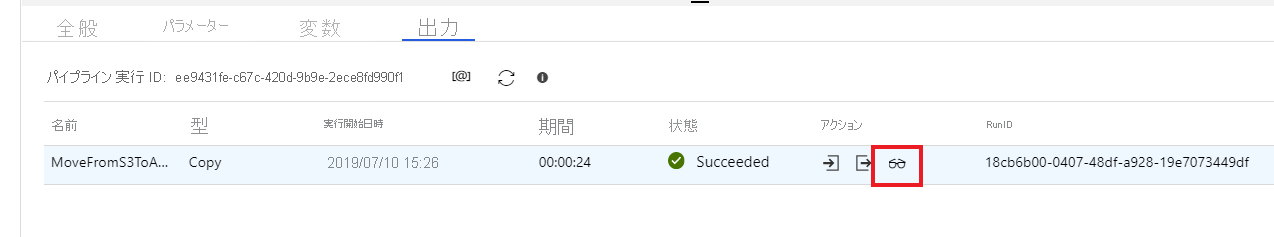

パイプラインのデバッグ実行の進行状況を監視するには、パイプラインの [出力] タブをクリックします

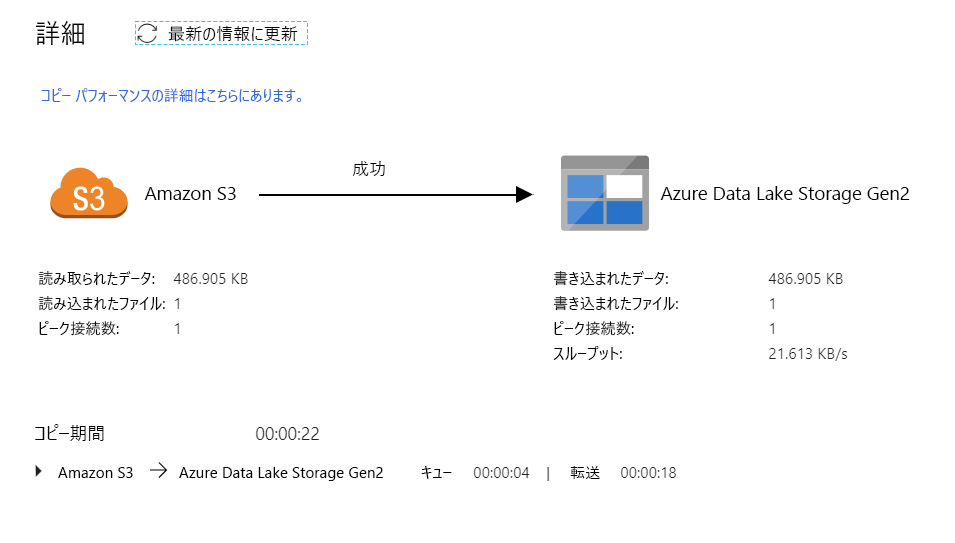

アクティビティの出力の詳細な説明を表示するには、眼鏡アイコンをクリックします。 これにより、データの読み取り/書き込み、スループット、詳細な期間統計などの有用なメトリックが表示されるコピー監視画面が開きます。

コピーが想定どおりに動作したことを確認するには、ADLS gen2 ストレージ アカウントを開いて、ファイルが想定どおりに書き込まれたことを確認します