LLM について理解する

大規模言語モデル (LLM) は、自然言語テキストを処理して生成できる AI の一種です。 書籍、記事、Web ページ、画像などのソースから収集された大量のデータから学習し、言語のパターンやルールを検出します。

LLM の規模

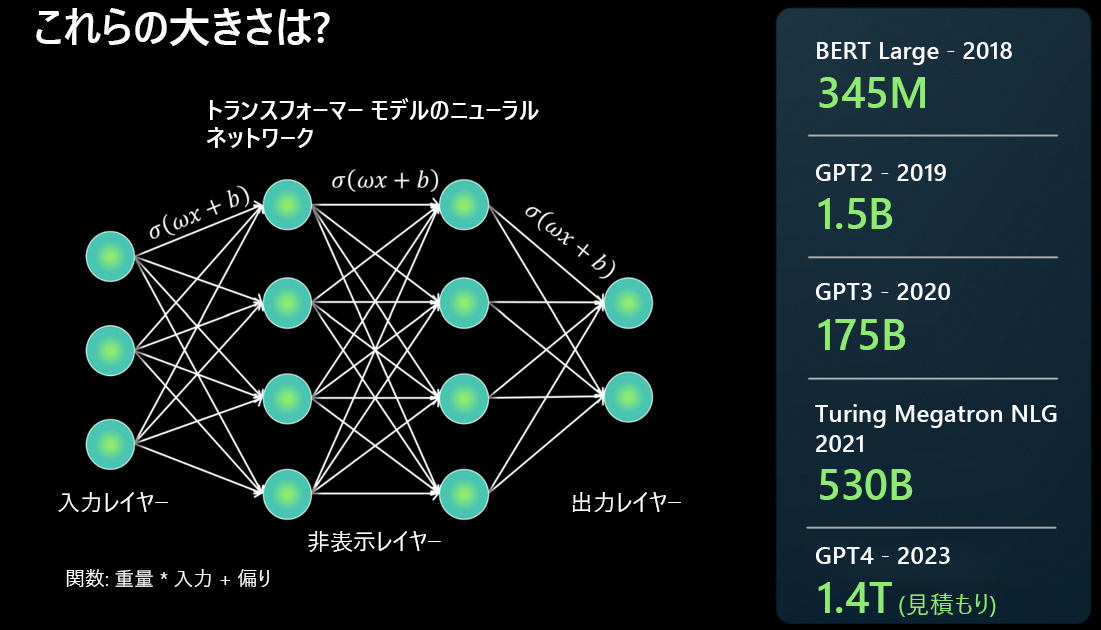

LLM は、ニューラル ネットワーク アーキテクチャを使用して構築されます。 入力を受け取り、いくつかの隠れ層で言語のさまざまな側面を分解し、出力層で生成します。

最新の基本モデルは前回のモデルよりどの程度大きいかという内容がよく報告されますが、これはどういう意味でしょうか。 簡単に言うと、モデルに含まれる "パラメータ" が多いほど、処理、学習、生成できるデータが多くなります。

ニューラル ネットワーク アーキテクチャの 2 つのニューロン間の接続ごとに、重み * 入力 + バイアスという関数があります。 このネットワークは、モデルが言語を処理する方法を決定する数値を生成します。

LLM は非常に大規模で、急速に成長しています。 一部のモデルが 2018 年に計算したパラメータは数百万個に上ります。 しかし現在、GPT-4 では "数兆個" のパラメータを計算することが可能です。

基本モデルは LLM のどこに位置するのか

"基本モデル" は、LLM の特定のインスタンスまたはバージョンです。 たとえば、GPT-3、GPT-4、Codex などです。

基本モデルは、テキストの大規模なコーパス (Codex モデル インスタンスの場合はコード) でトレーニングされ、微調整されます。

基本モデルはさまざまな形式のトレーニング データを取り込み、トランスフォーマー アーキテクチャを使用して一般的なモデルを構築します。 適応と特殊化を作成すると、プロンプトまたは微調整を使用して特定のタスクを実行できます。

LLM と従来の自然言語処理 (NLP) の違い

従来の NLP と LLM には相違点がいくつかあります。

| 従来の NLP | 大規模言語モデル |

|---|---|

| 機能ごとに 1 つのモデルが必要。 | 1 つのモデルが多くの自然言語ユース ケースで使用される。 |

| ML モデルをトレーニングするためのラベル付きデータのセットを提供。 | 基本モデルでは、何テラバイトものラベルなしデータを使用。 |

| モデルで実行する内容を自然言語で記述。 | 特定のユース ケース向けに高度に最適化されている。 |

LLM にできないこと

LLM にできないことを理解することは、LLM にできることを理解するのと同じくらい重要です。これを理解することで、ジョブに適したツールを選択できるようになります。

言語を理解する: LLM は、既存のテキストに基づいてパターンをまとめて抽出し、より多くのテキストを生成する予測エンジンです。 LLM は、言語や数式を理解しません。

事実を理解する: LLM には、情報の取得やクリエイティブな文書作成のための個別モードはありません。次に最も可能性の高いトークンを予測するだけです。

マナー、感情、倫理を理解する: LLM は、擬人化を示したり、倫理を理解したりすることはできません。 基本モデルの出力は、トレーニング データとプロンプトを組み合わせたものです。