データ インジェスト パイプラインを調べる

大規模なデータ ウェアハウス ソリューションのアーキテクチャと、大量のデータを処理するために使用できる分散処理テクノロジについて少し理解できたので、次に、1 つ以上のソースから分析データ ストアにデータが取り込まれる方法を調べます。

Azure で、大規模なデータ インジェストに最適な実装は、ETL プロセスを調整する "パイプライン" を作成することです。 Azure Data Factory を使用して、パイプラインを作成して実行できます。または、統合ワークスペースでデータ ウェアハウス ソリューションのすべてのコンポーネントを管理する場合は、Microsoft Fabric でパイプライン エンジンを使用できます。

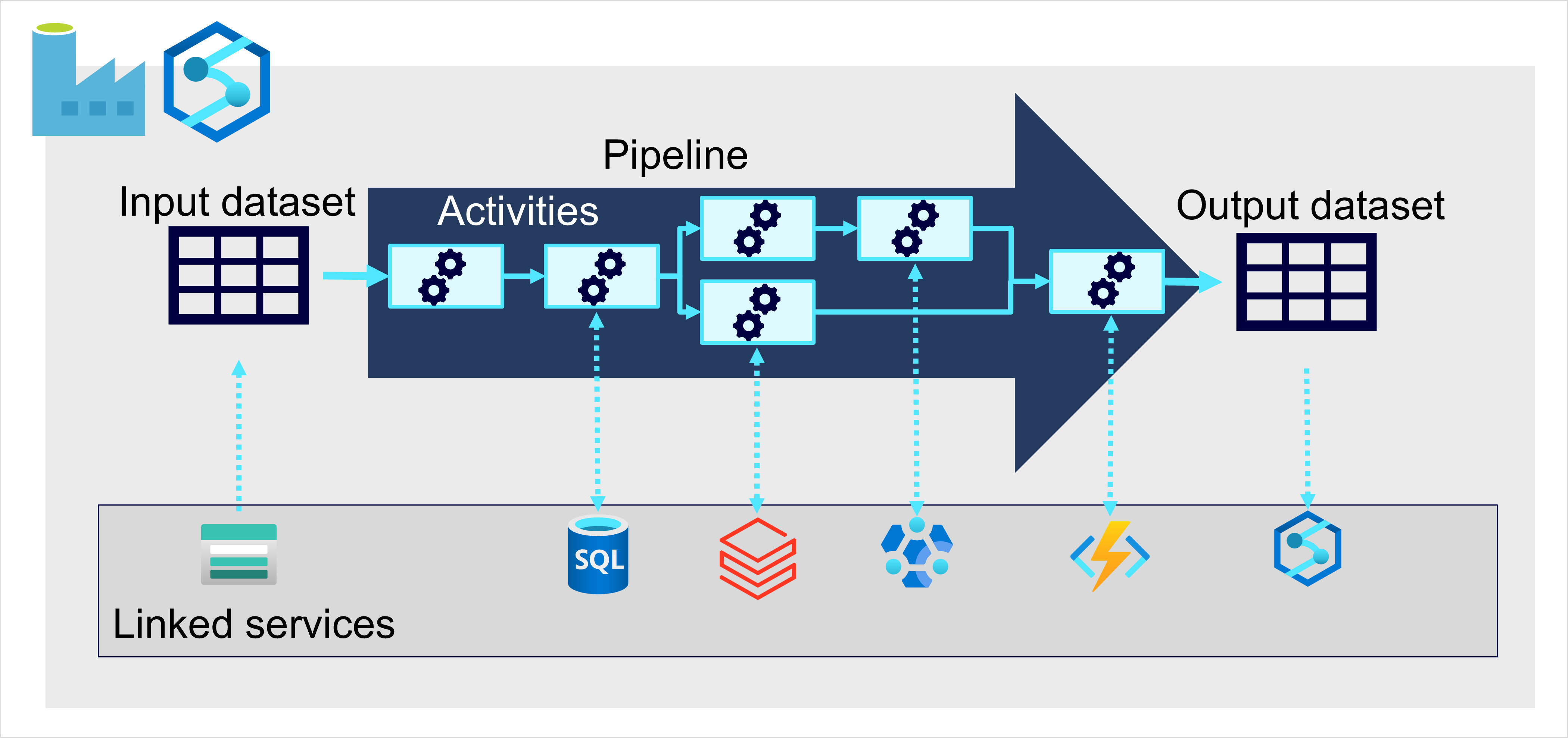

どちらの場合も、パイプラインはデータを操作する 1 つ以上の "アクティビティ" で構成されます。 入力データセットはソース データを提供し、アクティビティは、出力データセットが生成されるまでデータを増分的に操作するデータ フローとして定義できます。 パイプラインは "リンク サービス" を使用してデータを読み込んで処理するので、ワークフローの各ステップに適切なテクノロジを使用できます。 たとえば、Azure Blob Store リンク サービスを使用して入力データセットを取り込んでから、Azure SQL Database などのサービスを使用して関連するデータ値を検索するストアド プロシージャを実行した後、Azure Databricks でデータ処理タスクを実行したり、Azure 関数を使用してカスタム ロジックを適用したりします。 最後に、Microsoft Fabric などのリンク サービスに出力データセットを保存できます。 パイプラインは、リンク サービスを必要としない組み込みアクティビティを含むこともできます。