モデルのパフォーマンスを手動で評価する

生成 AI アプリ開発の初期フェーズでは、実験と反復をすばやく行う必要があります。 選択した言語モデルと、プロンプト フローで作成されたアプリが要件を満たしているかどうかを簡単に評価するために、Azure AI Studio ではモデルとフローを手動で評価できます。

モデルとアプリが既に運用環境にある場合でも、手動評価はパフォーマンスを評価するうえで非常に重要です。 手動評価は人間によって行われるため、自動化されたメトリックで見逃される可能性のある分析情報を提供できます。

Azure AI Foundry ポータルで、選択したモデルとアプリをどのように手動で評価するかを見てみましょう。

テスト プロンプトを準備する

手動評価プロセスを開始するには、アプリで処理する必要があるクエリとタスクの範囲が反映された、さまざまなテスト プロンプト セットを準備することが不可欠です。 これらのプロンプトは、一般的なユーザーの質問、エッジ ケース、潜在的な障害ポイントなど、さまざまなシナリオに対応する必要があります。 これにより、アプリのパフォーマンスを総合的に評価し、改善の余地がある領域を特定できます。

チャット プレイグラウンドで選択したモデルをテストする

チャット アプリケーションを開発する場合、言語モデルを使用して応答を生成します。 チャット アプリケーションのロジックをカプセル化するプロンプト フローを開発することで、カスタム コパイロットを作成し、複数の言語モデルを使用して、最終的にユーザーの質問に対する応答を生成することができます。

アプリの応答をテストする前に、選択した言語モデルの応答をテストして、個々のモデルが想定どおりに動作することを確認できます。 Azure AI Foundry ポータルでデプロイしたモデルをテストするには、チャット プレイグラウンドでそのモデルを操作します。

チャット プレイグラウンドは初期開発に最適です。 プロンプトを入力し、モデルがどのように応答するかを確認して、プロンプトまたはシステム メッセージを調整しながら改善していきます。 変更を適用した後、プロンプトをもう一度テストすると、モデルのパフォーマンスが実際に改善されたかどうかを評価できます。

手動評価を使用して複数のプロンプトを評価する

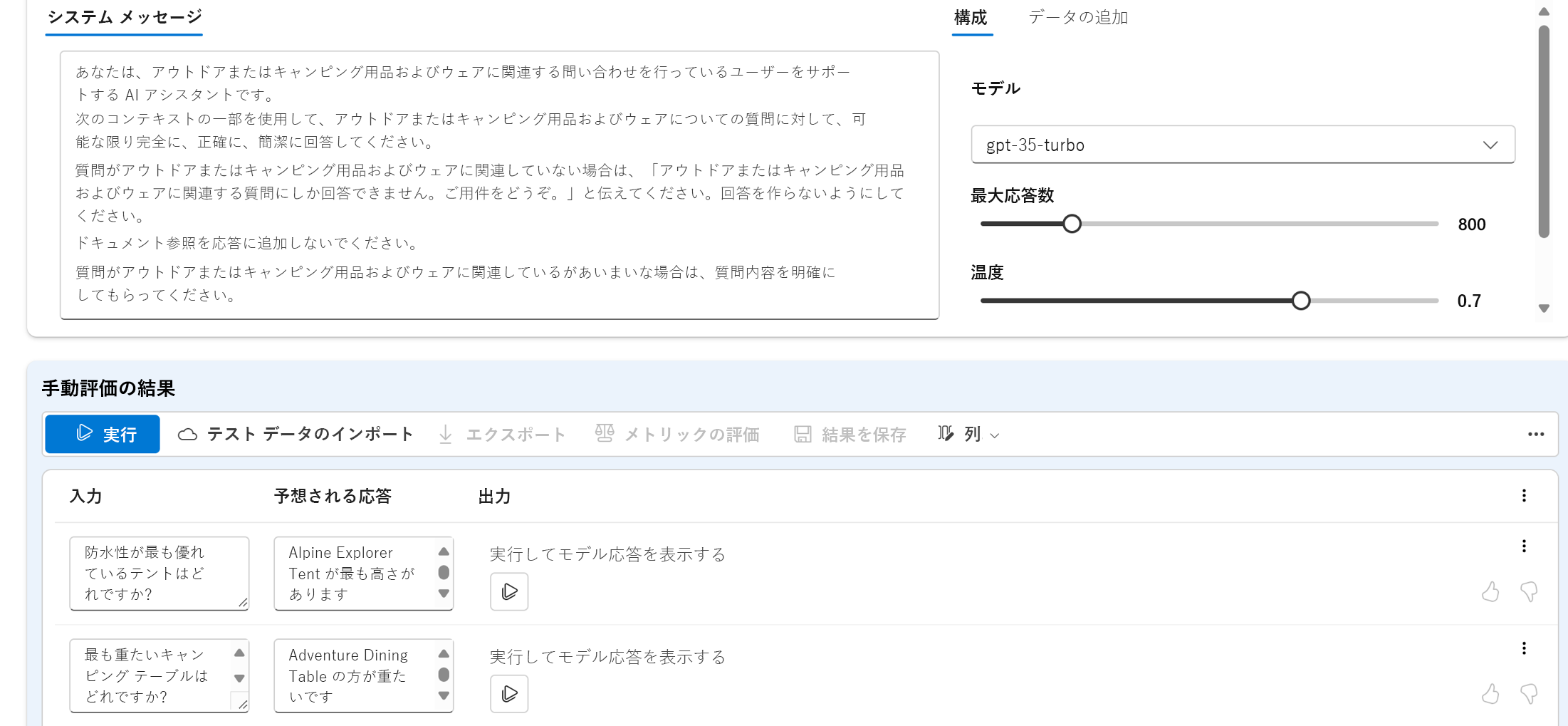

チャット プレイグラウンドは、簡単に始めることができます。 複数のプロンプトをより手動ですばやく評価したいときに、手動評価機能を使用できます。 この機能を使用すると、複数の質問を含むデータセットをアップロードし、想定される応答を必要に応じて追加して、大規模なテスト データセットでモデルのパフォーマンスを評価できます。

モデルの応答は、賛成と不賛成の機能を使用して評価できます。 全体的な評価に基づいて、モデルの改善を試みるには、入力プロンプト、システム メッセージ、モデル、またはモデルのパラメーターを変更します。

手動評価を使用すると、多様なテスト データセットに基づいてモデルのパフォーマンスをより迅速に評価し、テスト結果に基づいてモデルを改善できます。

個々のモデルを手動で評価した後、プロンプト フローを使用して、モデルをチャット アプリケーションに統合できます。 プロンプト フローを使用して作成したどのフローも、手動または自動で評価できます。 次は、フローの評価について見ていきましょう。