ADLS に接続して、Azure Databricks でデータを変換する

このガイドで行うこと:

Azure Databricks を使用して Azure Data Lake Storage (ADLS) Gen2 アカウントに Delta テーブルを作成します。

ADLS の Delta テーブルへの OneLake ショートカットを作成します。

Power BI を使用して ADLS ショートカットを使用したデータを分析します。

前提条件

開始する前に、以下が必要になります:

Lakehouse 項目を含むワークスペース

Azure Databricks ワークスペース

Delta テーブルを格納する ADLS Gen2 アカウント

Delta テーブルの作成、ショートカットの作成、データの分析

Azure Databricks ノートブック を使用して、ADLS Gen2 アカウントに Delta テーブルを作成します。

# Replace the path below to refer to your sample parquet data with this syntax "abfss://<storage name>@<container name>.dfs.core.windows.net/<filepath>" # Read Parquet files from an ADLS account df = spark.read.format('Parquet').load("abfss://datasetsv1@olsdemo.dfs.core.windows.net/demo/full/dimension_city/") # Write Delta tables to ADLS account df.write.mode("overwrite").format("delta").save("abfss://datasetsv1@olsdemo.dfs.core.windows.net/demo/adb_dim_city_delta/")レイクハウスで、[テーブル] の横にある省略記号 (...) をクリックし、[新しいショートカット] を選択します。

![テーブルの [新しいショートカット] の位置を示すスクリーンショット。](media/onelake-shortcuts-adb-quickstart/new-table-shortcut.png)

[新しいショートカット] 画面で、[Azure Data Lake Storage Gen2] タイルを選択します。

このショートカットの接続の詳細を指定し、[次へ] を選択します。

ショートカットの詳細を指定します。 [ショートカット名] と [サブ パス] を指定し、[作成] を選択します。 サブ パスは、Delta テーブルが存在するディレクトリを指している必要があります。

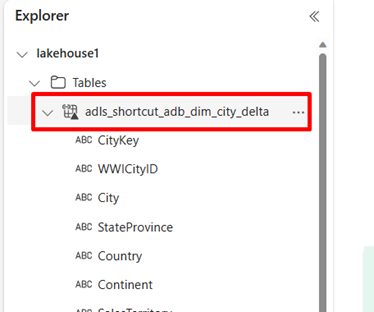

ショートカットは、[テーブル] の下に Delta テーブルとして表示されます。

これで、ノートブックから直接このデータに対してクエリを実行できるようになりました。

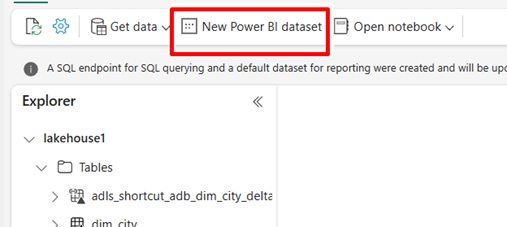

df = spark.sql("SELECT * FROM lakehouse1.adls_shortcut_adb_dim_city_delta LIMIT 1000") display(df)Power BI 経由でこの差分テーブルにアクセスして分析するには、[新しい Power BI セマンティック モデル] を選択します。

ショートカットを選択し、[確認する] を選択します。

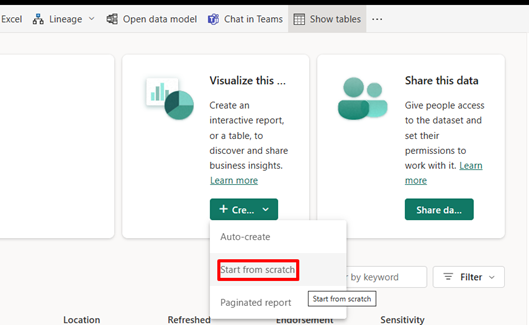

データが発行されたら、[最初から始める] を選択します。

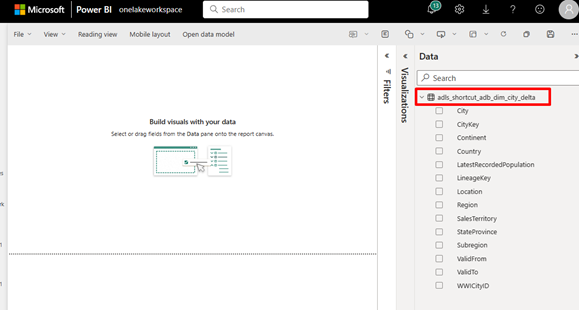

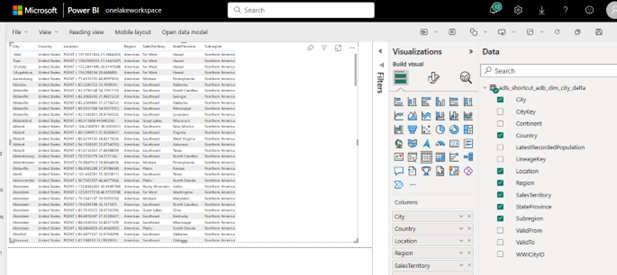

レポート作成エクスペリエンスでは、ショートカット データはテーブルとして、すべての属性と共に表示されます。

Power BI レポートを作成するには、左側のペインに属性をドラッグします。

![[新しいショートカット] スクリーン内のタイル オプションのスクリーンショット。](media/onelake-shortcuts-adb-quickstart/new-shortcut-tile-options-v2.png)