Microsoft Fabric で Pandas を使用してデータを読み書きする方法

Microsoft Fabric ノートブックは、データの探索と処理に最も人気のある Python ライブラリである Pandas を使用したレイクハウス データのシームレスな操作をサポートします。 ノートブックでは、レイクハウスからのデータの読み取りとレイクハウスへのデータの書き戻しをすばやく、さまざまなファイル形式で実行できます。 このガイドでは、ユーザー自身のノートブックの使用を開始するのに役立つコード サンプルを提供します。

前提条件

Microsoft Fabric サブスクリプションを取得します。 または、無料の Microsoft Fabric 試用版にサインアップします。

Microsoft Fabric にサインインします。

ホーム ページの左側の下にあるエクスペリエンス スイッチャーを使用して、Fabric に切り替えます。

![[エクスペリエンス スイッチャー メニュー] で Data Science を選択するところを示すスクリーンショット。](media/tutorial-data-science-prepare-system/switch-to-data-science.png)

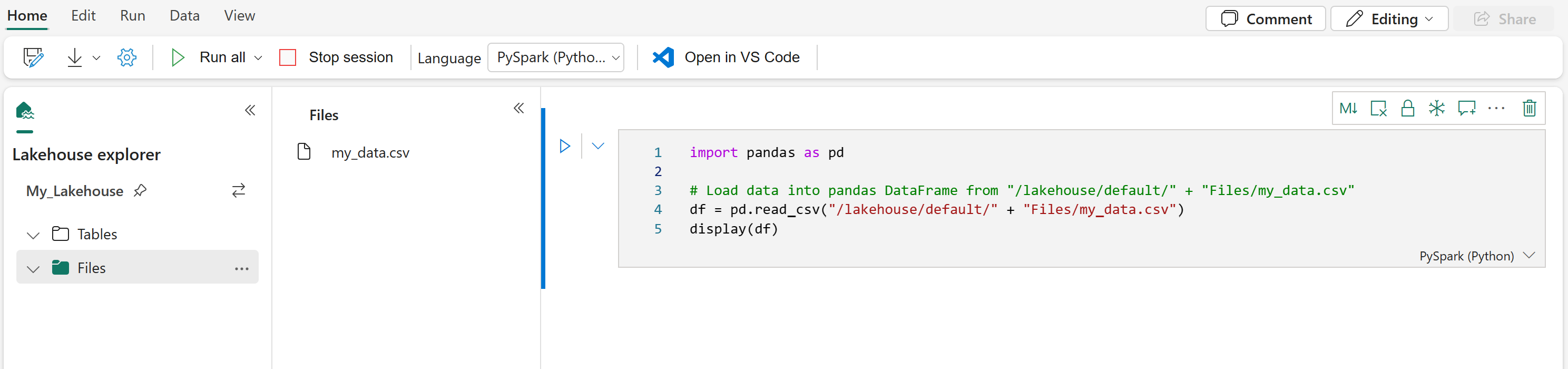

レイクハウス データをノートブックに読み込む

Microsoft Fabric ノートブックにレイクハウスをアタッチすると、表示中のページを離れることなく保存されたデータを探索でき、それを簡単な手順でノートブックに読み込めます。 レイクハウスのファイルを選択すると、Spark または Pandas の DataFrame に "データを読み込む" オプションが表示されます。 そのファイルの完全な ABFS パスまたは記述の短い相対パスをコピーすることもできます。

"データを読み込む" プロンプトのいずれか 1 つを選択すると、そのファイルをノートブックの DataFrame に読み込むためのコード セルが生成されます。

Spark DataFrame を Pandas DataFrame に変換する

参考までに、以下のコマンドを使用すれば、Spark DataFrame を Pandas DataFrame に変換できます。

# Replace "spark_df" with the name of your own Spark DataFrame

pandas_df = spark_df.toPandas()

さまざまなファイル形式の読み取りと書き込み

Note

特定のパッケージのバージョンを変更すると、それに依存する他のパッケージが破損する可能性があります。 たとえば、azure-storage-blob をダウングレードすると、Pandas や、Pandas、mssparkutils、fsspec_wrapper など、notebookutils に依存するさまざまな他のライブラリで問題が発生する可能性があります。

各ランタイムにプレインストールされているパッケージとそのバージョンの一覧は、こちらで確認できます。

以下のコード サンプルを使用すれば、Pandas でさまざまなファイル形式の読み取りと書き込みができます。

Note

コード サンプルのファイル パスは置き換える必要があります。 Pandas では、次に示すように相対パスと完全な ABFS パスの両方がサポートされています。 どちらのパスも、前の手順に従ってインターフェイスから取得およびコピーできます。

CSV ファイルからデータを読み取る

import pandas as pd

# Read a CSV file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

display(df)

CSV ファイルとしてデータを書き込む

import pandas as pd

# Write a Pandas DataFrame into a CSV file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

Parquet ファイルからデータを読み取る

import pandas as pd

# Read a Parquet file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

display(df)

データを Parquet ファイルに書き込む

import pandas as pd

# Write a Pandas DataFrame into a Parquet file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

Excel ファイルからデータを読み取る

import pandas as pd

# Read an Excel file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values. Also need to add correct filepath after Files/ if file is placed in different folders

# if using default lakehouse that attached to the notebook use the code to replace below: df = pandas.read_excel("/lakehouse/default/Files/FILENAME.xlsx")

df = pandas.read_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

display(df)

Excel ファイルとしてデータを書き込む

import pandas as pd

# Write a Pandas DataFrame into an Excel file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

JSON ファイルからデータを読み取る

import pandas as pd

# Read a JSON file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

display(df)

JSON ファイルとしてデータを書き込む

import pandas as pd

# Write a Pandas DataFrame into a JSON file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

関連するコンテンツ

- Data Wrangler を使用してデータをクリーンして準備する

- ML モデルのトレーニングを開始する