Dataflow Gen2 を使用して 2 GB の Parquet データをレイクハウス テーブルに読み込む価格シナリオ

このシナリオでは、Dataflow Gen2 を使用して、Azure Data Lake Storage (ADLS) Gen2 に保存されている 2 GB の Parquet データを Microsoft Fabric のレイクハウス テーブルに読み込みました。 Parquet データには、NYC タクシー - グリーン サンプル データを使用しました。

以下の例で使用されている価格は架空のものであり、正確な実際の価格を暗示するものではありません。 これらは、Microsoft Fabric の Data Factory プロジェクトのコストを見積もり、計画、管理を行う方法を示すためのものにすぎません。 また、Fabric 容量はリージョン間で一意な価格が設定されているため、米国西部 2 (一般的な Azure リージョン) のファブリック容量の従量課金制の価格 (CU あたり 1 時間あたり 0.18 ドル) を使用します。 その他の Fabric 容量の価格オプションについては、Microsoft Fabric の価格を参照してください。

構成

このシナリオを実現するには、次の手順でデータフローを作成する必要があります。

- データフローの初期化: ADLS Gen2 ストレージ アカウントから 2 GB の Parquet ファイル データを取得します。

- Power Query を構成する:

- Power Query に移動します。

- クエリをステージングするためのオプションが有効になっていることを確認します。

- Parquet ファイルの結合に進みます。

- データの変換:

- わかりやすくするためにヘッダーを昇格します。

- 不要な列を削除します。

- 必要に応じて列のデータ型を調整します。

- 出力データ変換先を定義する:

- データ出力先としてレイクハウスを構成します。

- この例では、Fabric 内のレイクハウスが作成され、使用されています。

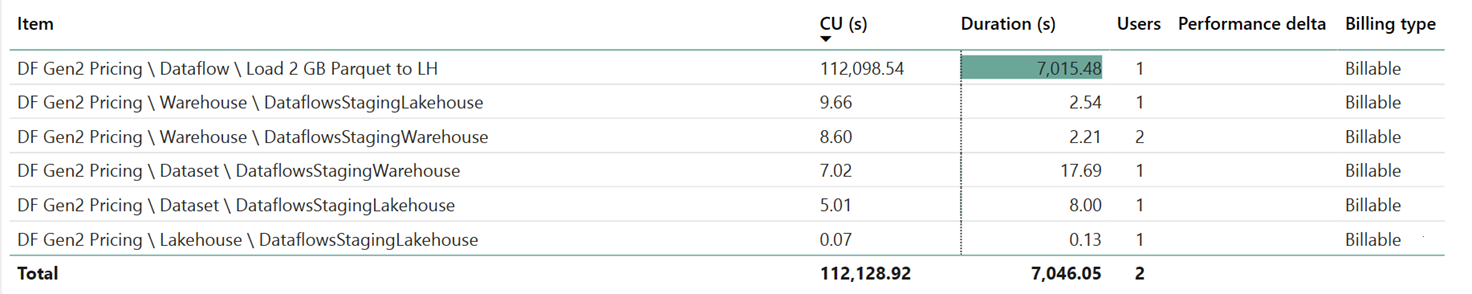

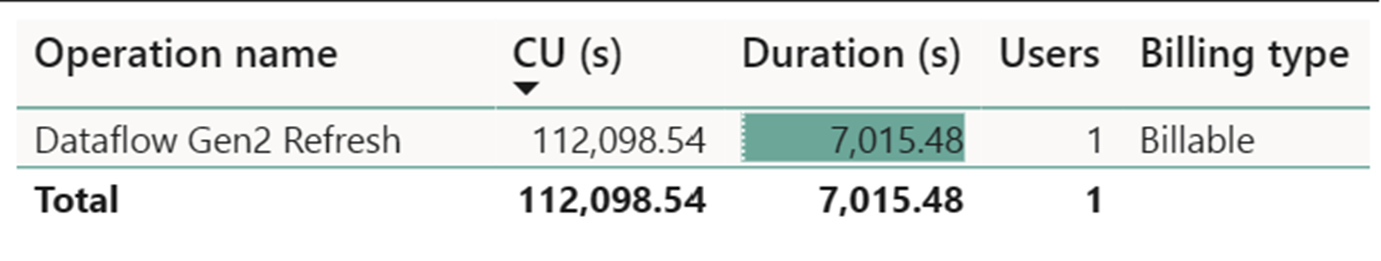

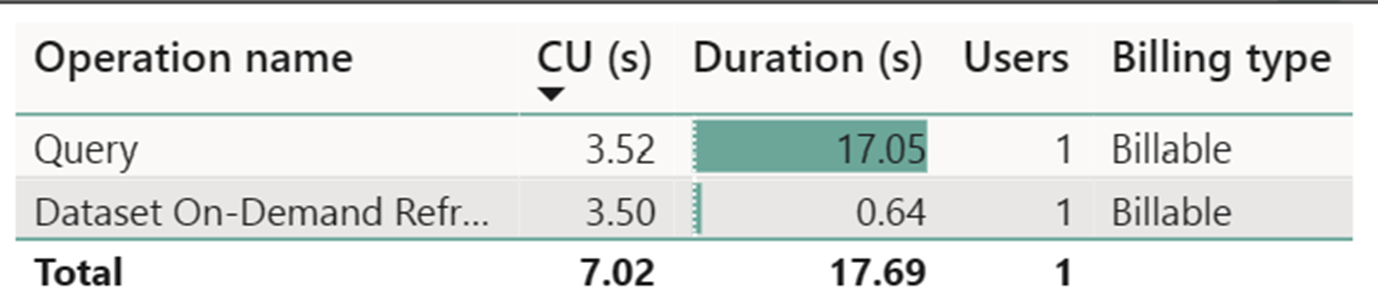

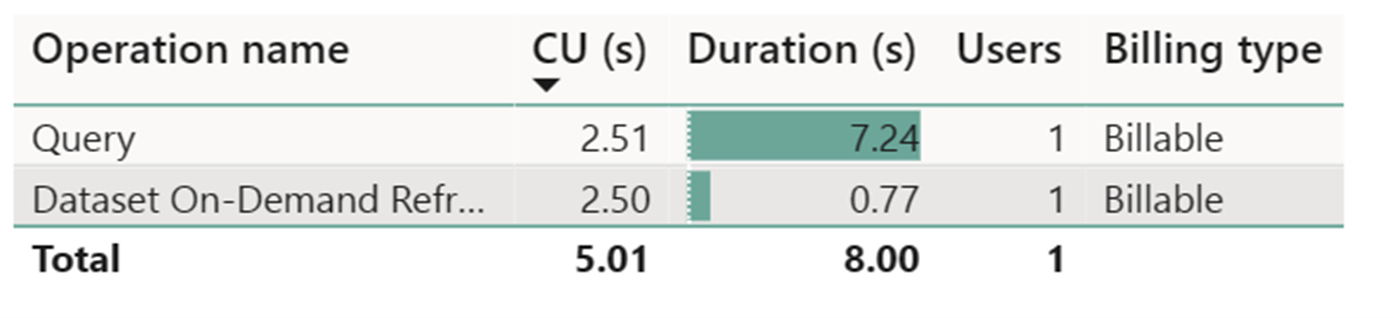

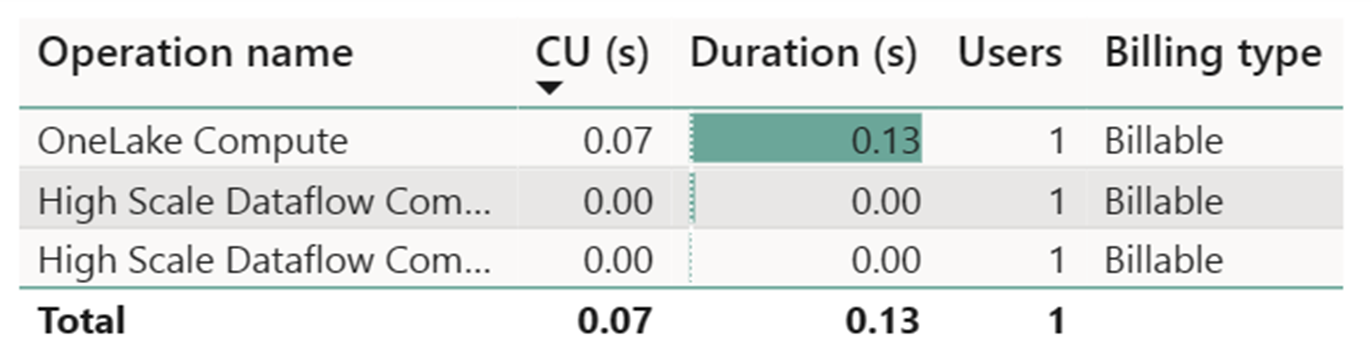

Fabric メトリック アプリを使用したコスト見積もり

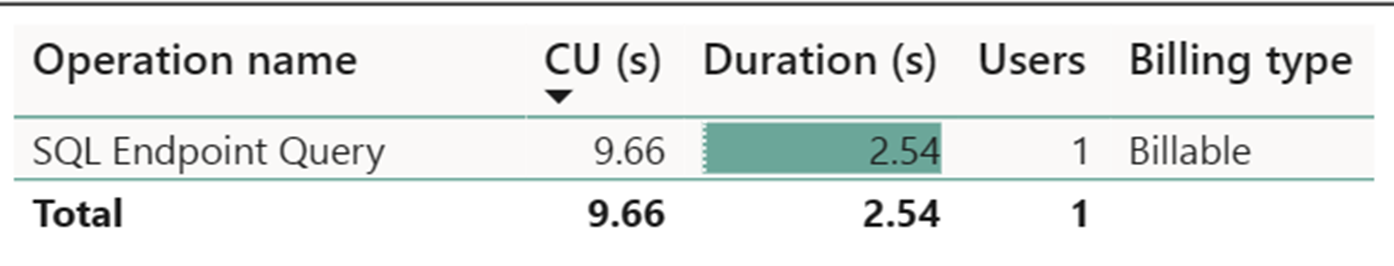

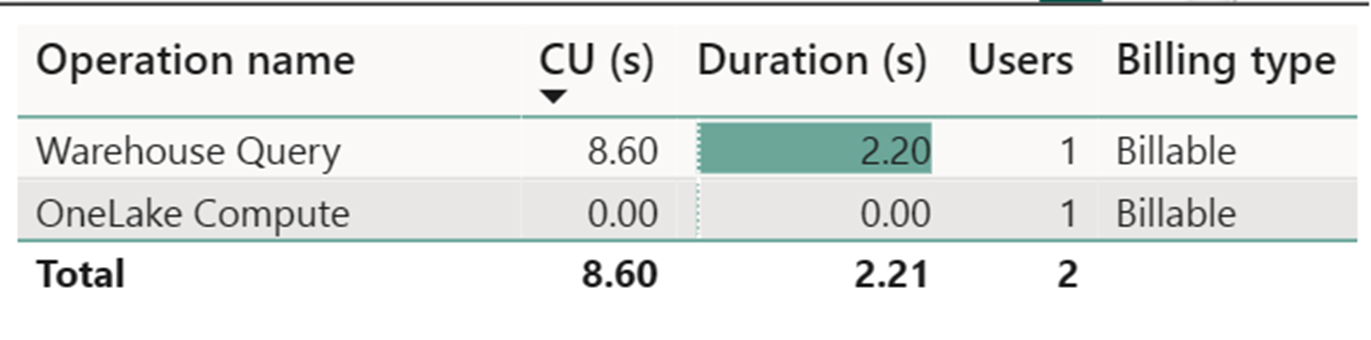

ハイ スケール データフロー コンピューティング メーターでは、ごくわずかのアクティビティが記録されました。 Dataflow Gen2 更新操作の Standard コンピューティング メーターでは、112,098.540 コンピューティング ユニット (CU) が消費されます。 ウェアハウス クエリ、SQL エンドポイント クエリ、データセット オンデマンド更新などの他の操作は、(現在透過的でそれぞれの操作に必要とされる) Dataflow Gen2 実装の詳細な側面を構成していることを考慮するのは重要です。 ただし、これらの操作は今後の更新で隠されるため、Dataflow Gen2 のコストを見積もる場合は無視する必要があります。

Note

メトリックとして報告されますが、実際の実行時間は、Fabric Metrics アプリで有効な CU 時間を計算する場合には関係ありません。これは、同じく報告される CU 秒のメトリックが実行時間についても既に説明しているためです。

| メトリック | Standard のコンピューティング | ハイスケール コンピューティング |

|---|---|---|

| 合計 CU 秒 | 112,098.54 CU 秒 | 0 CU 秒 |

| 請求対象の有効 CU 時間 | 112,098.54 / (60*60) = 31.14 CU 時間 | 0 / (60*60) = 0 CU 時間 |

合計実行コストは $0.18/CU 時間 = (31.14 CU 時間) * ($0.18/CU 時間) ~= $5.60