Dataflow Gen2 のデータのコピー先に関するオンプレミス データ ゲートウェイの考慮事項

この記事では、Dataflow Gen2 のデータ変換先シナリオでデータ ゲートウェイを使用する場合の制限事項と考慮事項のリストを示してみます。

評価のタイムアウト

ゲートウェイとデータ変換先機能を使用するデータフローは、評価時間または更新時間が 1 時間に制限されます。

この制限の詳細については、 「オンプレミス データ ゲートウェイのトラブルシューティングに関する記事」を参照してください。

ポート 1433 に関するネットワークの問題

オンプレミス データ ゲートウェイで Microsoft Fabric Dataflow Gen2 を使用すると、データフローの更新プロセスで問題が発生する可能性があります。 基になる問題は、データを目的のデータのコピー先にコピーする前にデータを読み取るために、ゲートウェイがデータフロー ステージング Lakehouse に接続できない場合に発生します。 この問題は、使用されているデータのコピー先の種類に関係なく発生する可能性があります。

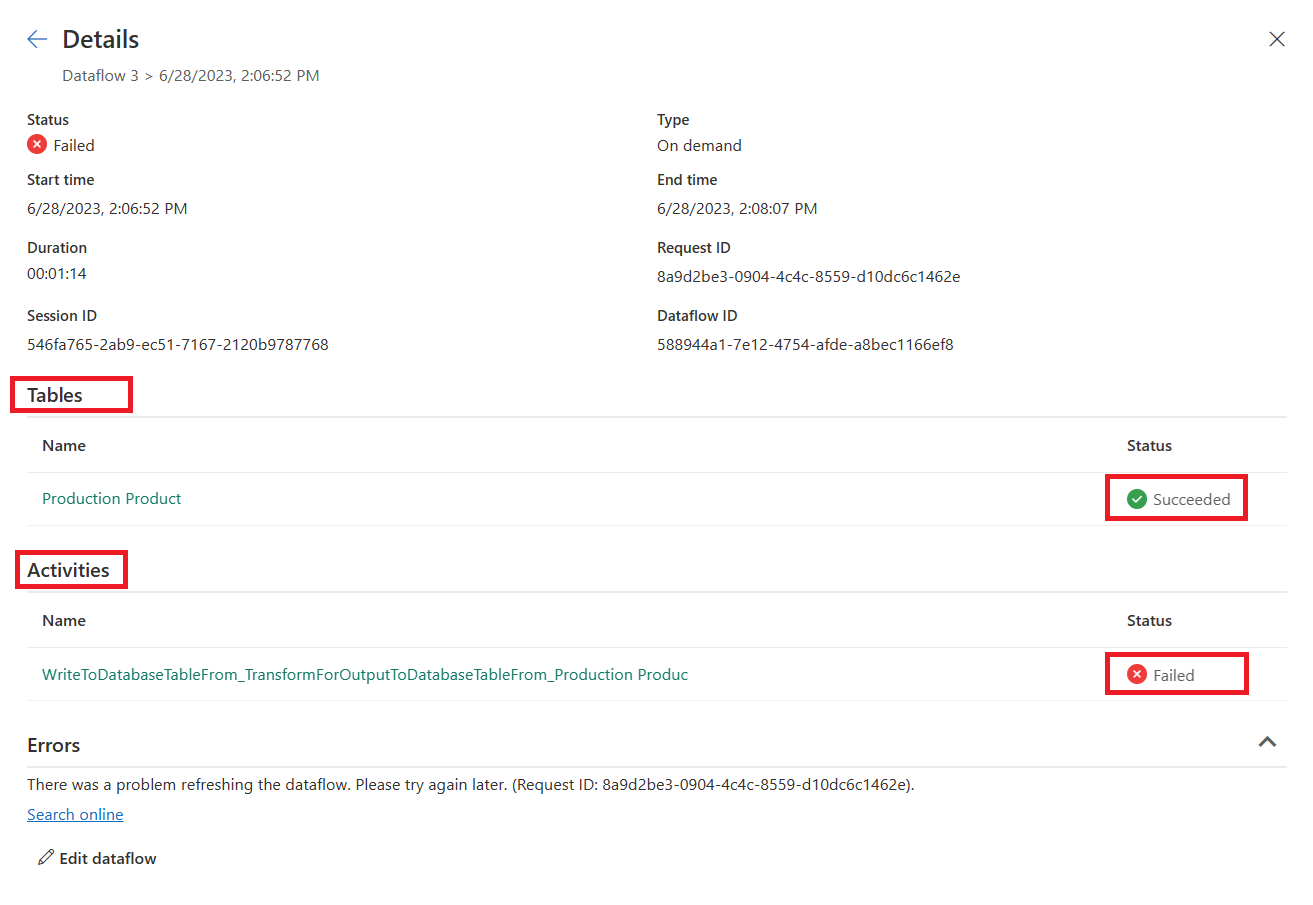

データフロー全体の更新中、テーブルの更新は "成功" と表示されますが、アクティビティ セクションには "失敗" と表示されます。 アクティビティ WriteToDatabaseTableFrom_... のエラーの詳細は、次のエラーを示しています:

Mashup Exception Error: Couldn't refresh the entity because of an issue with the mashup document MashupException.Error: Microsoft SQL: A network-related or instance-specific error occurred while establishing a connection to SQL Server. The server was not found or was not accessible. Verify that the instance name is correct and that SQL Server is configured to allow remote connections. (provider: TCP Provider, error: 0 - An attempt was made to access a socket in a way forbidden by its access permissions.) Details: DataSourceKind = Lakehouse;DataSourcePath = Lakehouse;Message = A network-related or instance-specific error occurred while establishing a connection to SQL Server. The server was not found or was not accessible. Verify that the instance name is correct and that SQL Server is configured to allow remote connections. (provider: TCP Provider, error: 0 - An attempt was made to access a socket in a way forbidden by its access permissions.);ErrorCode = -2146232060;Number = 10013

Note

アーキテクチャの観点から見ると、データフロー エンジンは アウトバウンドの HTTPS (ポート 443) エンドポイントを使用して Lakehouse にデータを書き込みます。 ただし、Lakehouse からデータを読み取る場合は、TDS プロトコル (TCP 1433 番ポート) を使用する必要があります。 このプロトコルは、ステージング Lakehouse からデータのコピー先にデータをコピーするために使用されます。 これは、両方のレイクハウスが同じ OneLake インスタンスにある場合でも、データのコピー先アクティビティが失敗する間にテーブルの読み込みステップが成功する理由について説明します。

トラブルシューティング

この問題のトラブルシューティングを行うには、これらの手順に従います。

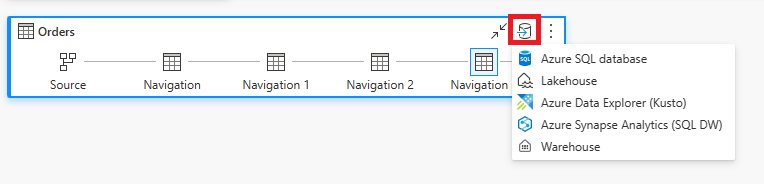

データフローがデータのコピー先で構成されていることを確認します。

データフローの更新が失敗し、テーブルの更新が "成功" と表示され、アクティビティが "失敗" と表示されていることを確認します。

発生したエラーに関する情報を提供するアクティビティ

WriteToDatabaseTableFrom_...のエラーの詳細を確認します。

解決策: ゲートウェイを実行しているサーバーに新しいファイアウォール規則を設定する

ゲートウェイ サーバーまたは顧客のプロキシ サーバー上のファイアウォール規則は、ゲートウェイ サーバーから以下のエンドポイントへの送信トラフィックを許可するように更新する必要があります。 ファイアウォールでワイルドカードがサポートされていない場合は、Azure IP 範囲とサービス タグからの IP アドレスを使用します。 毎月同期を維持する必要があります。

- プロトコル: TCP

- エンドポイント: *.datawarehouse.pbidedicated.windows.net, *.datawarehouse.fabric.microsoft.com, *.dfs.fabric.microsoft.com

- ポート: 1433

Note

特定のシナリオでは、特にゲートウェイに最も近いリージョンではないリージョンにキャパシティーが配置されている場合、複数のエンドポイント(*cloudapp.azure.com へのアクセスを許可するようにファイアウォールを構成する必要があります。 この調整は、これらの条件下で発生する可能性があるリダイレクトに対応するために必要です。 *.cloudapp.azure.com 宛てのトラフィックが規則によって傍受されない場合は、ファイアウォールでデータリージョンの IP アドレス を許可することもできます。

エンドポイントのスコープをワークスペース内の実際の OneLake インスタンス (ワイルドカード *.datawarehouse.pbidedicated.windows.net ではなく) に絞り込む場合は、Fabric ワークスペースに移動し、DataflowsStagingLakehouse を見つけて [詳細の表示] を選択すると、その URL を見つけることができます。 次に、SQL 接続文字列をコピーして貼り付けます。

エンドポイント名の全体は、次の例のようになります:

x6eps4xrq2xudenlfv6naeo3i4-l27nd6wdk4oephe4gz4j7mdzka.datawarehouse.pbidedicated.windows.net

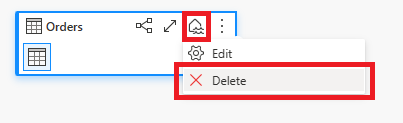

回避策: データフローの取り込みと読み取りのデータフローに分割する

ファイアウォール規則を更新できない場合は、データフローを 2 つの個別のデータフローに分割できます。 最初のデータフローは、ステージング レイクハウスにデータを取り込む役割を担います。 2 番目のデータフローは、ステージング レイクハウスからデータ変換先にデータを読み込む役割を担います。 この回避策は、2 つの個別のデータフローを使用する必要があるため理想的ではありませんが、ファイアウォール規則を更新できるようになるまでの一時的な解決策として使用できます。

この回避策を実装するには、次の手順に従います。

![省略記号が選択され、[詳細の表示] オプションが強調された DataflowsStagingLakehouse のある Fabric ワークスペースのスクリーンショット。](media/gateway-considerations-output-destination/staging.png)

![[データの取得] オプションが選択され、[データフロー コネクタ] オプションが強調されている Power Query エディターのスクリーンショット。](media/gateway-considerations-output-destination/get-data-dataflow-connector.png)

![[データフロー コネクタ] オプションが選択されている [データの取得] ダイアログのスクリーンショット。](media/gateway-considerations-output-destination/dataflow-connector-get-data.png)