データフロー第1世代から第2世代への移行

データフロー Gen2 は、新しい世代のデータフローです。 新しい世代のデータフローは、Power BI データフロー (Gen1) と共に存在し、新機能とエクスペリエンスの向上をもたらします。 次のセクションでは、Dataflow Gen1 と Dataflow Gen2 の比較を示します。

機能の概要

| 特徴 | Dataflow Gen2 | データフロー Gen1 |

|---|---|---|

| Power Query を使用してデータフローを作成する | ✓ | ✓ |

| 作成フローの短縮 | ✓ | |

| 自動保存とバックグラウンド発行 | ✓ | |

| データの宛先 | ✓ | |

| 監視と更新の履歴の改善 | ✓ | |

| データ パイプラインとの統合 | ✓ | |

| 高スケール コンピューティング | ✓ | |

| Dataflows コネクタを使用してデータを取得する | ✓ | ✓ |

| データフロー コネクタを使用した直接クエリ | ✓ | |

| 増分更新 | ✓ | |

| AI Insights のサポート | ✓ |

作成エクスペリエンスの短縮

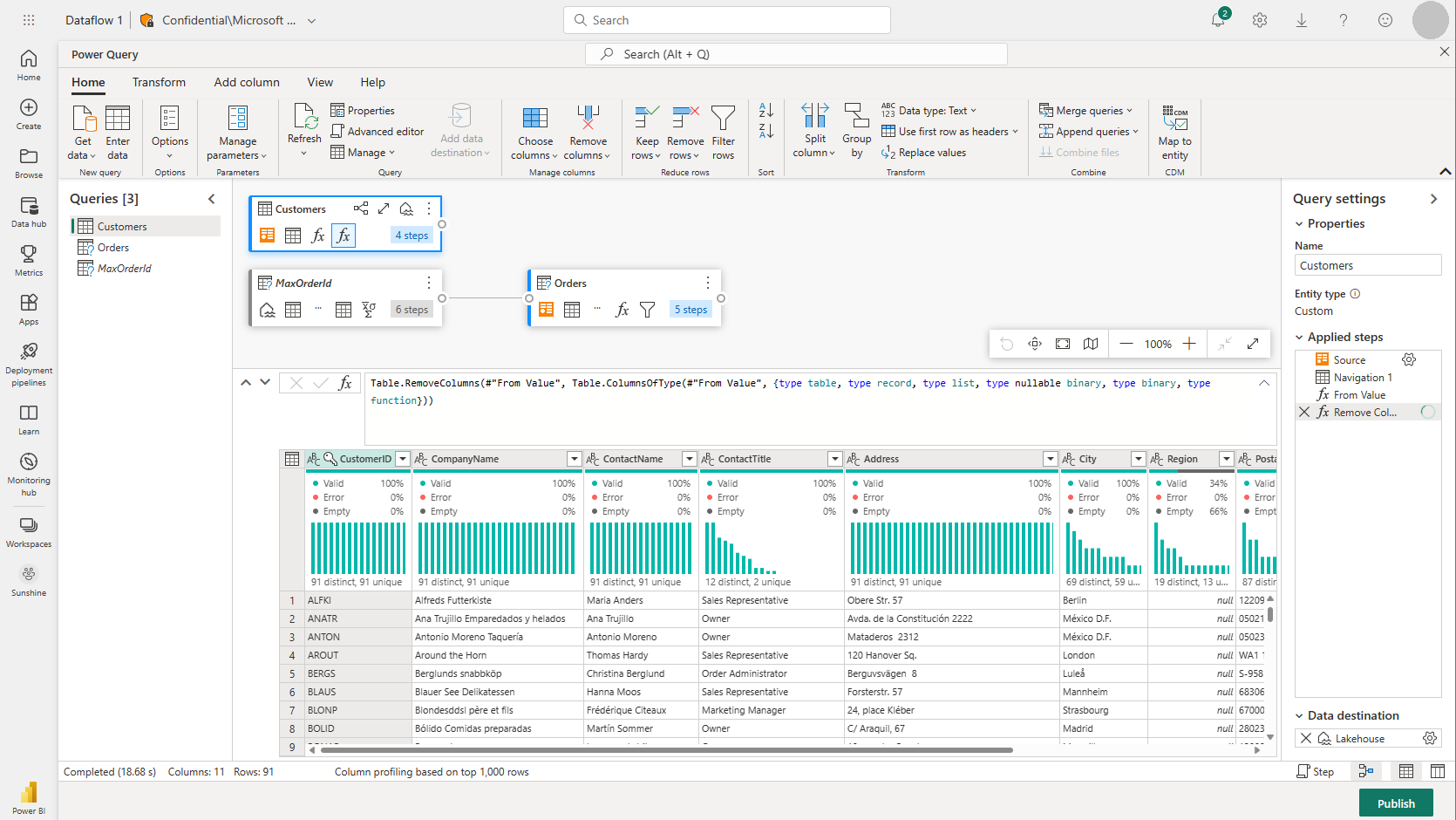

Dataflow Gen2 を使用すると、家に帰るような気がします。 Power BI データフローで使い慣れた完全な Power Query エクスペリエンスを保持しました。 エクスペリエンスを入力すると、データフローにデータを取り込むための手順がガイドされます。 また、データフローの作成に必要な手順の数を減らすために作成エクスペリエンスを短縮し、エクスペリエンスをさらに向上させるためにいくつかの新機能を追加しました。

新しいデータフローの保存エクスペリエンス

Dataflow Gen2 では、データフローの保存のしくみを変更しました。 データフローに加えられた変更はすべて、クラウドに自動保存されます。 そのため、任意の時点で作成エクスペリエンスを終了し、後で中断した場所から続行できます。 データフローの作成が完了したら、変更を発行し、それらの変更はデータフローの更新時に使用されます。 さらに、データフローを発行すると、変更が保存され、バックグラウンドで実行する必要がある検証が実行されます。 この機能を使用すると、検証が完了するのを待たずにデータフローを保存できます。

新しい保存エクスペリエンスの詳細については、「データフローの下書きを保存する」を参照してください。

データの宛先

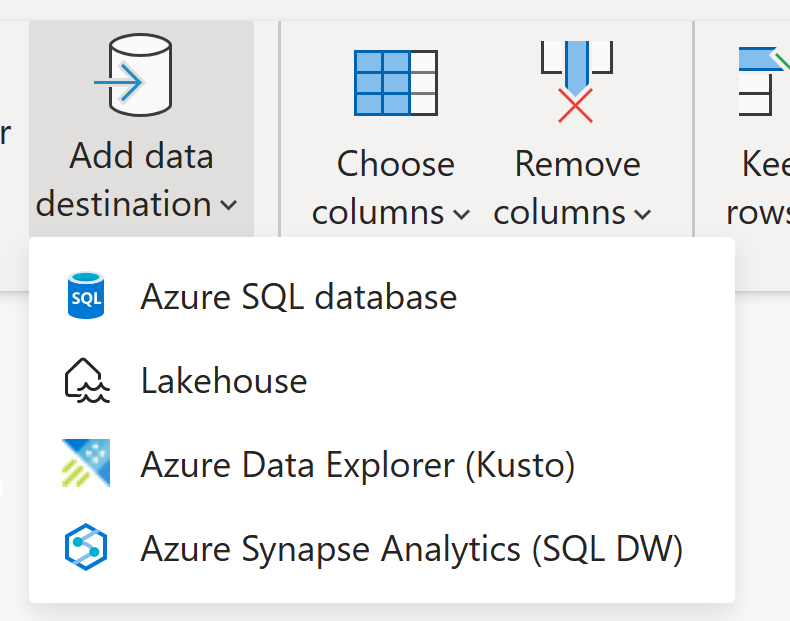

Dataflow Gen1 と同様に、Dataflow Gen2 では、データフロー コネクタを使用してアクセスできるデータフローの内部/ステージング ストレージにデータを変換できます。 Dataflow Gen2 では、データのデータ変換先を指定することもできます。 この機能を使用して、ETL ロジックと宛先ストレージを分離できるようになりました。 この機能は、さまざまな点でメリットがあります。 たとえば、データフローを使用してデータをレイクハウスに読み込み、ノートブックを使用してデータを分析できるようになりました。 または、データフローを使用して Azure SQL データベースにデータを読み込み、データ パイプラインを使用してデータ ウェアハウスにデータを読み込むことができます。

Dataflow Gen2 では、次の宛先のサポートが追加され、さらに多くのターゲットが近日中に提供されます。

- Fabric Lakehouse

- Azure Data Explorer (Kusto)

- Azure Synapse Analytics (SQL DW)

- Azure SQL Database

手記

Fabric Warehouse にデータを読み込むには、SQL 接続文字列を取得して Azure Synapse Analytics (SQL DW) コネクタを使用できます。 詳細: Microsoft Fabric でのデータ ウェアハウスへの接続

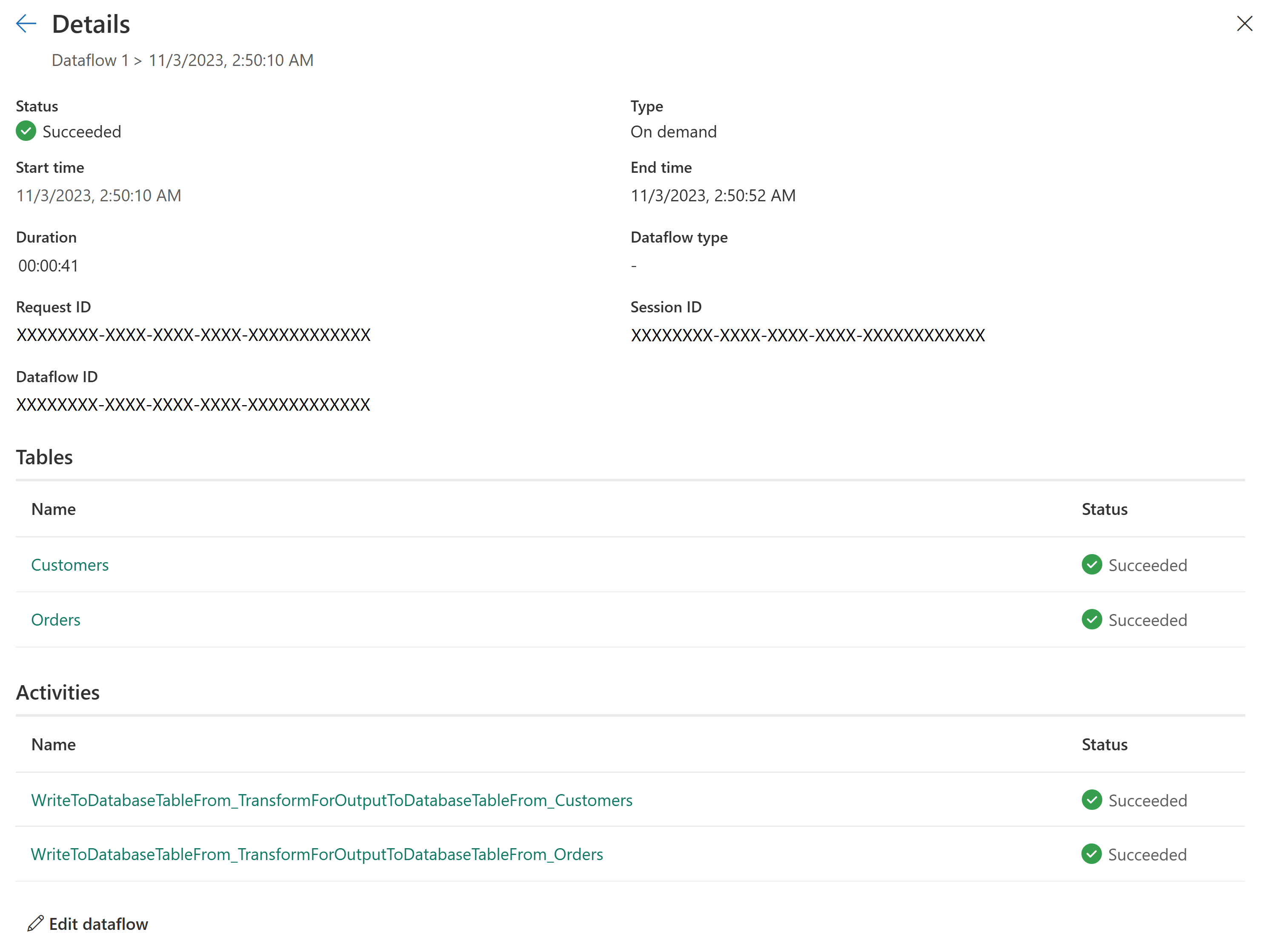

新しい更新履歴と監視

Dataflow Gen2 では、データフローの更新を監視するための新しい方法が導入されています。 監視ハブ のサポートを統合し、更新履歴 の体験を大幅に向上させます。

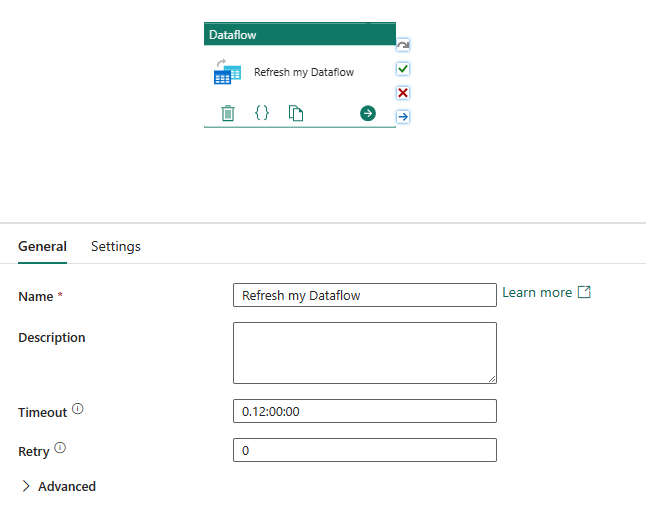

データ パイプラインとの統合

データ パイプラインを使用すると、一緒にタスクを実行するアクティビティをグループ化できます。 アクティビティは、実行できる作業単位です。 たとえば、アクティビティでは、ある場所から別の場所にデータをコピーしたり、SQL クエリを実行したり、ストアド プロシージャを実行したり、Python ノートブックを実行したりできます。

パイプラインには、依存関係によって接続されている 1 つ以上のアクティビティを含めることができます。 たとえば、パイプラインを使用して Azure BLOB からデータを取り込んでクリーンアップし、Dataflow Gen2 を開始してログ データを分析できます。 パイプラインを使用して、Azure BLOB から Azure SQL データベースにデータをコピーし、データベースでストアド プロシージャを実行することもできます。

下書きとして保存

Dataflow Gen2 では、変更を保存するために発行する必要がなくなるため、心配のないエクスペリエンスが導入されています。 下書きとして保存機能を使用すると、変更を加えるたびに、データフローの下書きバージョンが保存されます。 インターネット接続が失われましたか? 誤ってブラウザーを閉じたのですか? ご心配なく;私たちはあなたの背中を手に入れました。 データフローに戻ると、最近の変更は引き続き存在し、中断したところから続行できます。 これはシームレスなエクスペリエンスであり、ユーザーからの入力は必要ありません。 これにより、変更を保存する前に、変更の損失やすべてのクエリ エラーの修正を心配することなく、データフローに取り組むことができます。 この機能の詳細については、「データフローの下書きを保存する」を参照してください。

高スケール コンピューティング

Dataflow Gen1 と同様に、Dataflow Gen2 には、参照されるクエリの両方の変換のパフォーマンスを向上させ、データ シナリオを取得するための強化されたコンピューティング エンジンも備えています。 これを実現するために、Dataflow Gen2 はワークスペースに Lakehouse と Warehouse の両方の項目を作成し、それらを使用してデータを格納およびアクセスし、すべてのデータフローのパフォーマンスを向上させます。

ライセンス データフロー Gen1 と Gen2

Dataflow Gen2 は、Power BI データフロー (Gen1) と共に存在する新しい世代のデータフローであり、新機能とエクスペリエンスの向上をもたらします。 これには、Fabric 容量または Fabric 試用版の容量が必要です。 データフローのライセンスの仕組みをよりよく理解するためには、以下の記事を読むことができます: Microsoft Fabric の概念とライセンス

Dataflow Gen1 からクエリを再利用して、Dataflow Gen2 を試す

多くの Dataflow Gen1 クエリがあり、Dataflow Gen2 でどのように試すことができるのか疑問に思っています。 Gen1 データフローを Dataflow Gen2 として再作成するためのオプションがいくつかあります。

Dataflow Gen1 クエリをエクスポートして Dataflow Gen2 にインポートする

これで、Dataflow Gen1 と Gen2 の両方の作成エクスペリエンスでクエリをエクスポートし、PQT ファイルに保存して、Dataflow Gen2 にインポートできるようになりました。 詳細については、「エクスポート テンプレート機能を使用する」を参照してください。

Power Query でコピーして貼り付ける

Power BI または Power Apps にデータフローがある場合は、クエリをコピーして、Dataflow Gen2 のエディターに貼り付けることができます。 この機能を使用すると、クエリを書き直すことなく、データフローを Gen2 に移行できます。 詳細については、「既存の Dataflow Gen1 クエリをコピーして貼り付ける」を参照してください。