ワークスペース パッケージ

ワークスペース パッケージには、カスタムまたはプライベートの wheel (Python)、jar (Scala/Java)、または tar.gz (R) ファイルを使用できます。 これらのパッケージをワークスペースにアップロードし、後で特定の Spark プールに割り当てることができます。

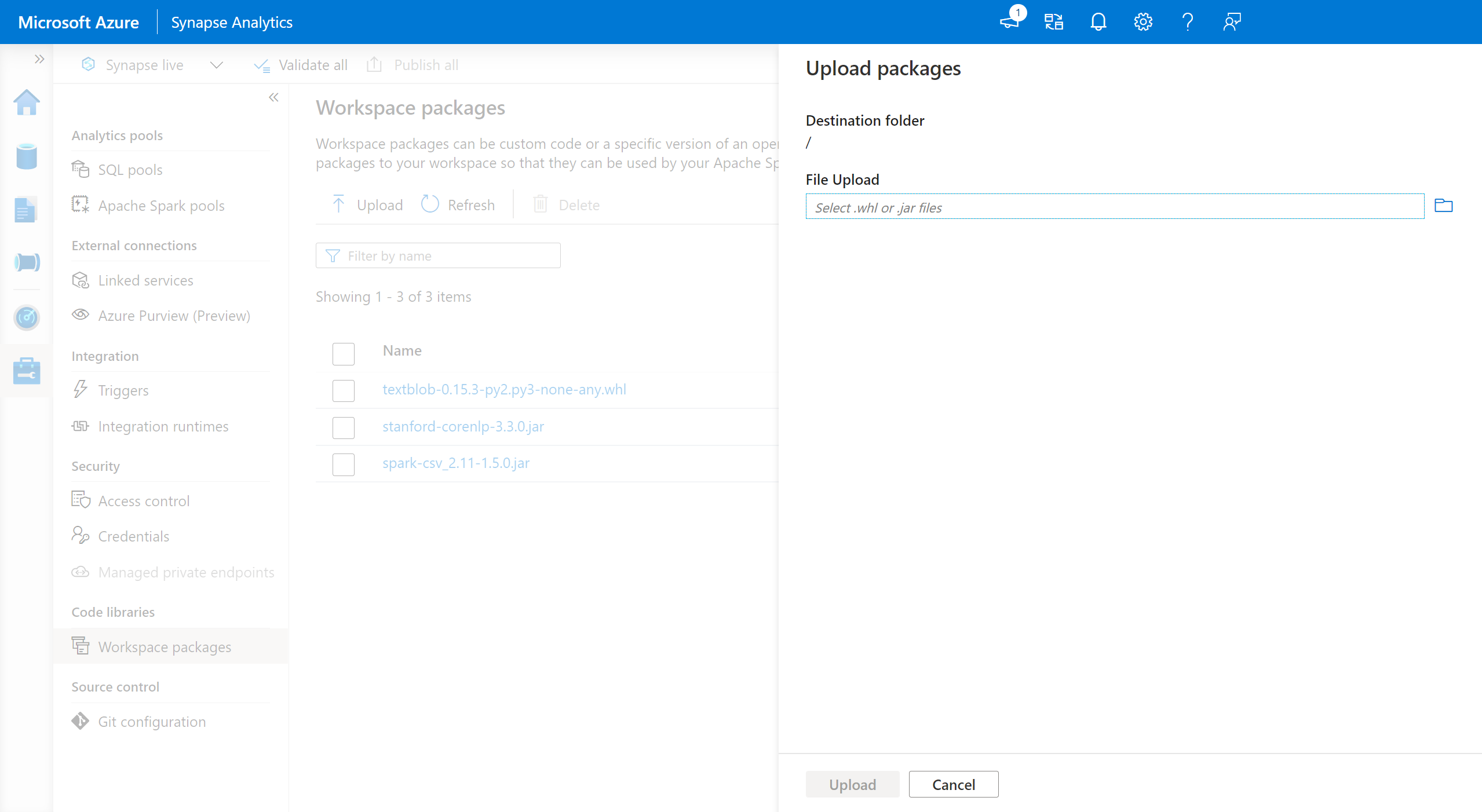

ワークスペース パッケージを追加するには:

- [管理]>[ワークスペース パッケージ] タブに移動します。

- ファイル セレクターを使用してファイルをアップロードします。

- ファイルが Azure Synapse ワークスペースにアップロードされたら、これらのパッケージを Apache Spark プールに追加できます。

警告

Azure Synapse 内では、Apache Spark プールは、ワークスペース パッケージとしてアップロードされたカスタム ライブラリ、または既知の Azure Data Lake Storage パス内にアップロードされたカスタム ライブラリのいずれかを利用できます。 ただし、これらのオプションの両方を、同じ Apache Spark プール内で同時に使用することはできません。 両方の方法を使用してパッケージが提供されている場合は、ワークスペース パッケージの一覧で指定した wheel ファイルのみがインストールされます。

ワークスペース パッケージを使用して特定の Apache Spark プールにパッケージをインストールした後は、同じプールにストレージ アカウント パスを使用してパッケージを指定できなくなるという制限があります。

Note

ワークスペース内に同じ名前のパッケージが複数存在しないようにすることをお勧めします。 同じパッケージの別のバージョンを使用する場合は、既存のバージョンを削除し、新しいバージョンをアップロードする必要があります。

ストレージ アカウント

Synapse ワークスペースにリンクされている Azure Data Lake Storage (Gen2) アカウントにすべてのファイルをアップロードすることで、カスタム ビルドのパッケージを Apache Spark プールにインストールできます。

ストレージ アカウントの既定のコンテナーの次のパスに、ファイルをアップロードする必要があります。

abfss://<file_system>@<account_name>.dfs.core.windows.net/synapse/workspaces/<workspace_name>/sparkpools/<pool_name>/libraries/python/

警告

- ファイル パスがない場合、上記の構造に基づいてこれを作成する必要が生じることがあります。 たとえば、

librariesフォルダー内にpythonフォルダーがまだ存在しない場合は、これを追加する必要があります。 - カスタム ファイルを管理するこの方法は、Azure Synapse Runtime for Apache Spark 3.0 ではサポートされません。 カスタム ファイルを管理するには、ワークスペース パッケージ機能を参照してください。

重要

Azure DataLake Storage メソッドを使用してカスタム ライブラリをインストールするには、Azure Synapse Analytics ワークスペースにリンクされているプライマリ Gen2 ストレージ アカウントに対して、ストレージ BLOB データ共同作成者またはストレージ BLOB データ所有者のアクセス許可を持っている必要があります。

次のステップ

- 既定のライブラリを確認します: Apache Spark バージョンのサポート

- ライブラリのインストール エラーのトラブルシューティング: ライブラリのエラーのトラブルシューティング

- Azure Data Lake Storage アカウントを使用してプライベート Conda チャネルを作成する: Conda プライベート チャネル