HDInsight on AKS の Apache Flink® に Apache Kafka® テーブルを作成する

Note

Azure HDInsight on AKS は 2025 年 1 月 31 日に廃止されます。 2025 年 1 月 31 日より前に、ワークロードを Microsoft Fabric または同等の Azure 製品に移行することで、ワークロードの突然の終了を回避する必要があります。 サブスクリプション上に残っているクラスターは停止され、ホストから削除されることになります。

提供終了日までは基本サポートのみが利用できます。

重要

現在、この機能はプレビュー段階にあります。 ベータ版、プレビュー版、または一般提供としてまだリリースされていない Azure の機能に適用されるその他の法律条項については、「Microsoft Azure プレビューの追加の使用条件」に記載されています。 この特定のプレビューについては、「Microsoft HDInsight on AKS のプレビュー情報」を参照してください。 質問や機能の提案については、詳細を記載した要求を AskHDInsight で送信してください。また、その他の更新情報については、Azure HDInsight コミュニティのフォローをお願いいたします。

この例を使用して、Apache FlinkSQL で Kafka テーブルを作成する方法について学習します。

前提条件

Apache Flink 上の Kafka SQL コネクタ

Kafka コネクタを使用すると、Kafka トピックからデータを読み取ったり、Kafka トピックにデータを書き込んだりできるようになります。 詳しくは、Apache Kafka SQL コネクタに関する記事を参照してください。

Flink SQL 上に Kafka テーブルを作成する

HDInsight Kafka でトピックとデータを準備する

weblog.py を使用してメッセージを準備する

import random

import json

import time

from datetime import datetime

user_set = [

'John',

'XiaoMing',

'Mike',

'Tom',

'Machael',

'Zheng Hu',

'Zark',

'Tim',

'Andrew',

'Pick',

'Sean',

'Luke',

'Chunck'

]

web_set = [

'https://google.com',

'https://facebook.com?id=1',

'https://tmall.com',

'https://baidu.com',

'https://taobao.com',

'https://aliyun.com',

'https://apache.com',

'https://flink.apache.com',

'https://hbase.apache.com',

'https://github.com',

'https://gmail.com',

'https://stackoverflow.com',

'https://python.org'

]

def main():

while True:

if random.randrange(10) < 4:

url = random.choice(web_set[:3])

else:

url = random.choice(web_set)

log_entry = {

'userName': random.choice(user_set),

'visitURL': url,

'ts': datetime.now().strftime("%m/%d/%Y %H:%M:%S")

}

print(json.dumps(log_entry))

time.sleep(0.05)

if __name__ == "__main__":

main()

Kafka トピックへのパイプライン

sshuser@hn0-contsk:~$ python weblog.py | /usr/hdp/current/kafka-broker/bin/kafka-console-producer.sh --bootstrap-server wn0-contsk:9092 --topic click_events

その他のコマンド:

-- create topic

/usr/hdp/current/kafka-broker/bin/kafka-topics.sh --create --replication-factor 2 --partitions 3 --topic click_events --bootstrap-server wn0-contsk:9092

-- delete topic

/usr/hdp/current/kafka-broker/bin/kafka-topics.sh --delete --topic click_events --bootstrap-server wn0-contsk:9092

-- consume topic

sshuser@hn0-contsk:~$ /usr/hdp/current/kafka-broker/bin/kafka-console-consumer.sh --bootstrap-server wn0-contsk:9092 --topic click_events --from-beginning

{"userName": "Luke", "visitURL": "https://flink.apache.com", "ts": "06/26/2023 14:33:43"}

{"userName": "Tom", "visitURL": "https://stackoverflow.com", "ts": "06/26/2023 14:33:43"}

{"userName": "Chunck", "visitURL": "https://google.com", "ts": "06/26/2023 14:33:44"}

{"userName": "Chunck", "visitURL": "https://facebook.com?id=1", "ts": "06/26/2023 14:33:44"}

{"userName": "John", "visitURL": "https://tmall.com", "ts": "06/26/2023 14:33:44"}

{"userName": "Andrew", "visitURL": "https://facebook.com?id=1", "ts": "06/26/2023 14:33:44"}

{"userName": "John", "visitURL": "https://tmall.com", "ts": "06/26/2023 14:33:44"}

{"userName": "Pick", "visitURL": "https://google.com", "ts": "06/26/2023 14:33:44"}

{"userName": "Mike", "visitURL": "https://tmall.com", "ts": "06/26/2023 14:33:44"}

{"userName": "Zheng Hu", "visitURL": "https://tmall.com", "ts": "06/26/2023 14:33:44"}

{"userName": "Luke", "visitURL": "https://facebook.com?id=1", "ts": "06/26/2023 14:33:44"}

{"userName": "John", "visitURL": "https://flink.apache.com", "ts": "06/26/2023 14:33:44"}

Apache Flink SQL クライアント

Flink SQL クライアントに対して Secure Shell を使用する方法についての詳しい説明があります。

Kafka SQL コネクタと依存関係を SSH にダウンロードする

以下のステップでは、Kafka 3.2.0 の依存関係を使用しています。HDInsight クラスターの Kafka バージョンに基づいてコマンドを更新する必要があります。

wget https://repo1.maven.org/maven2/org/apache/kafka/kafka-clients/3.2.0/kafka-clients-3.2.0.jar

wget https://repo1.maven.org/maven2/org/apache/flink/flink-connector-kafka/1.17.0/flink-connector-kafka-1.17.0.jar

Apache Flink SQL クライアントに接続する

ここで、Kafka SQL クライアント jar を使用して Flink SQL クライアントに接続してみましょう。

msdata@pod-0 [ /opt/flink-webssh ]$ bin/sql-client.sh -j flink-connector-kafka-1.17.0.jar -j kafka-clients-3.2.0.jar

Apache FlinkSQL で Kafka テーブルを作成する

Flink SQL で Kafka テーブルを作成し、Flink SQL の Kafka テーブルを選択してみましょう。

以下のスニペットで Kafka ブートストラップ サーバー IP を更新する必要があります。

CREATE TABLE KafkaTable (

`userName` STRING,

`visitURL` STRING,

`ts` TIMESTAMP(3) METADATA FROM 'timestamp'

) WITH (

'connector' = 'kafka',

'topic' = 'click_events',

'properties.bootstrap.servers' = '<update-kafka-bootstrapserver-ip>:9092,<update-kafka-bootstrapserver-ip>:9092,<update-kafka-bootstrapserver-ip>:9092',

'properties.group.id' = 'my_group',

'scan.startup.mode' = 'earliest-offset',

'format' = 'json'

);

select * from KafkaTable;

Kafka メッセージを生成する

HDInsight Kafka を使用して、同じトピックに対して Kafka メッセージを生成してみましょう。

python weblog.py | /usr/hdp/current/kafka-broker/bin/kafka-console-producer.sh --bootstrap-server wn0-contsk:9092 --topic click_events

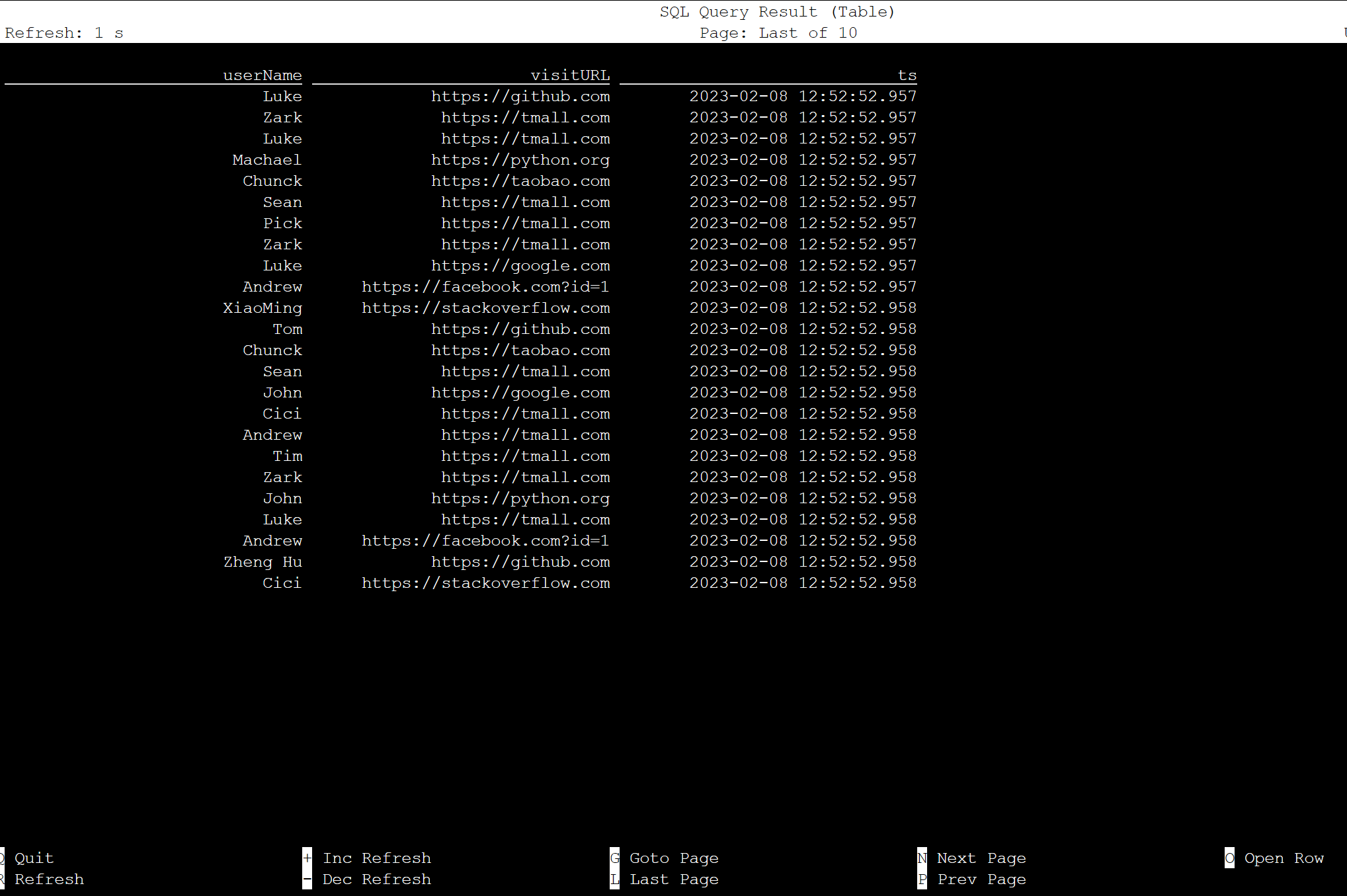

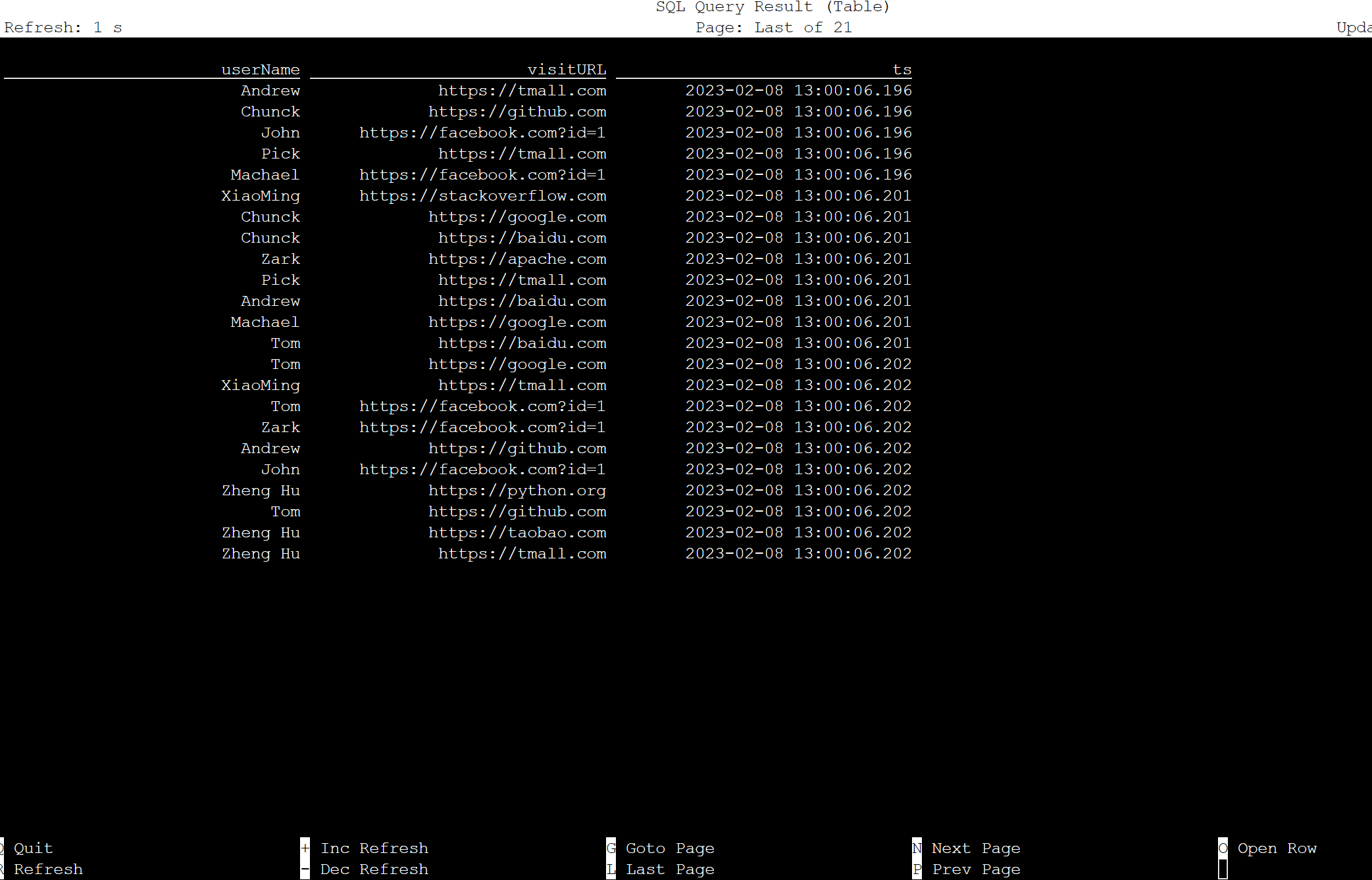

Apache Flink SQL 上のテーブル

Flink SQL 上のテーブルを監視できます。

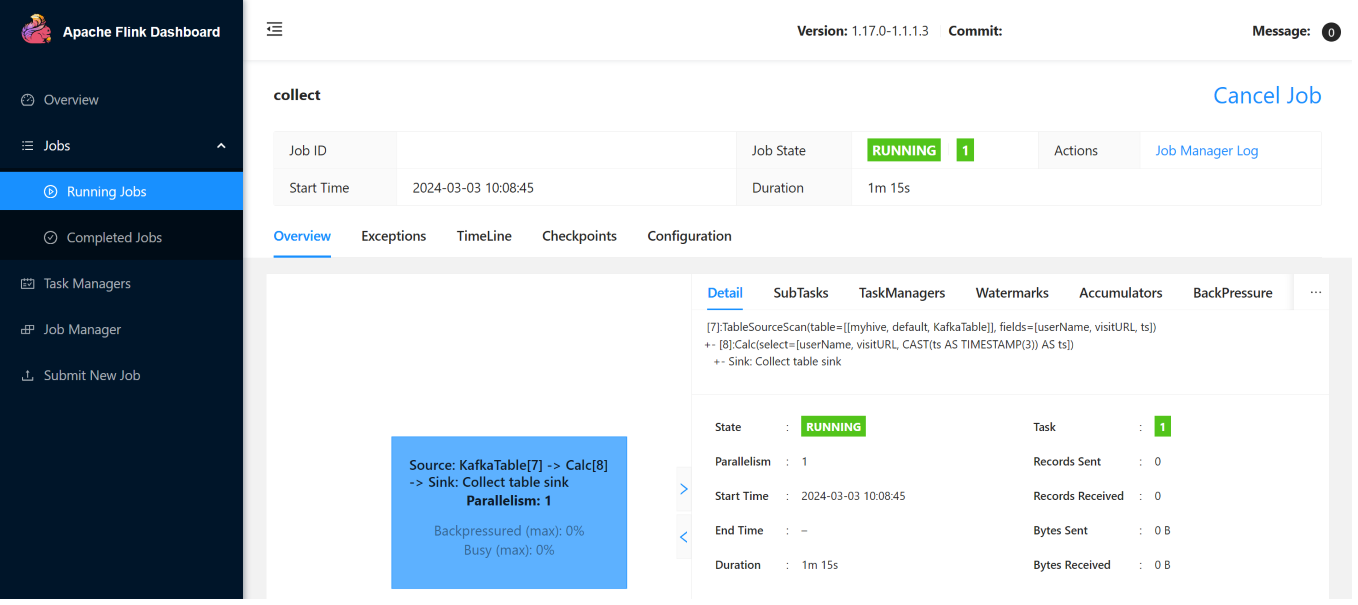

Flink Web UI のストリーミング ジョブを次に示します。

リファレンス

- Apache Kafka SQL コネクタ

- Apache、Apache Kafka、Kafka、Apache Flink、Flink、関連するオープン ソース プロジェクト名は、Apache Software Foundation (ASF) の商標です。