エンタープライズ レベルの負荷分散をアプリケーションに追加して、Azure OpenAI Service トークンとモデル クォータの制限を超えてチャット アプリを拡張する方法について説明します。 このアプローチでは、Azure API Management を使用して、3 つの Azure OpenAI リソース間でトラフィックをインテリジェントに転送します。

この記事では、次の 2 つの個別のサンプルをデプロイする必要があります。

- チャット アプリ:

- チャット アプリをまだデプロイしていない場合は、ロード バランサーのサンプルがデプロイされるまで待ちます。

- チャット アプリを既に 1 回デプロイした場合は、ロード バランサーのカスタム エンドポイントをサポートするように環境変数を変更し、再デプロイします。

- Azure API Management を使用したロード バランサー。

手記

この記事では、記事の例とガイダンスの基礎として 1 つ以上の

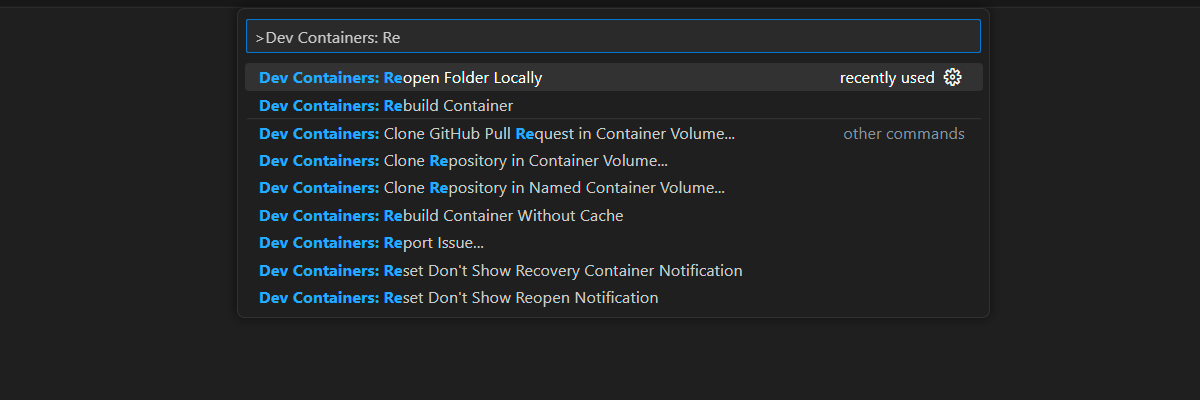

Azure API Management を使用して Azure OpenAI を負荷分散するためのアーキテクチャ

Azure OpenAI リソースには特定のトークンとモデルのクォータ制限があるため、1 つの Azure OpenAI リソースを使用するチャット アプリでは、これらの制限のために会話エラーが発生する傾向があります。

これらの制限に達せずにチャット アプリを使用するには、API Management で負荷分散ソリューションを使用します。 このソリューションは、API Management からチャット アプリ サーバーに単一のエンドポイントをシームレスに公開します。

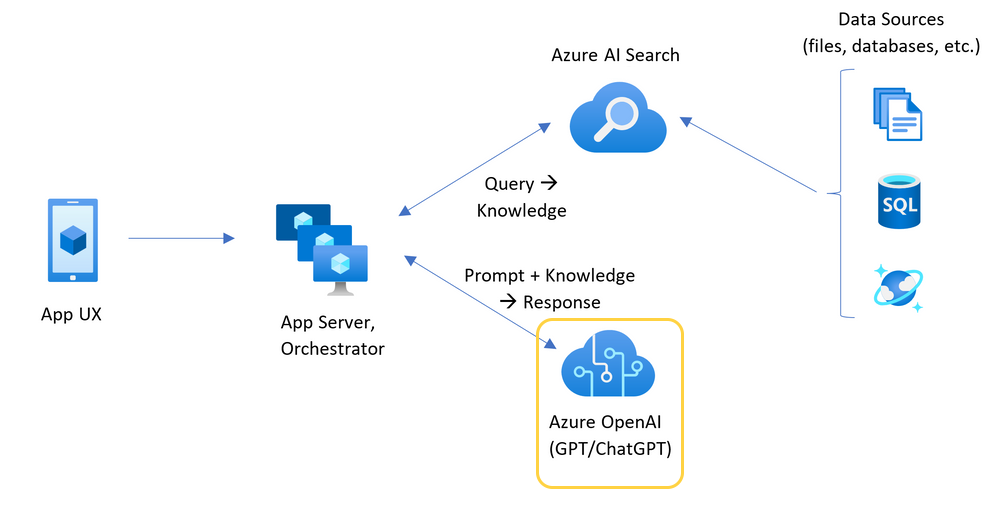

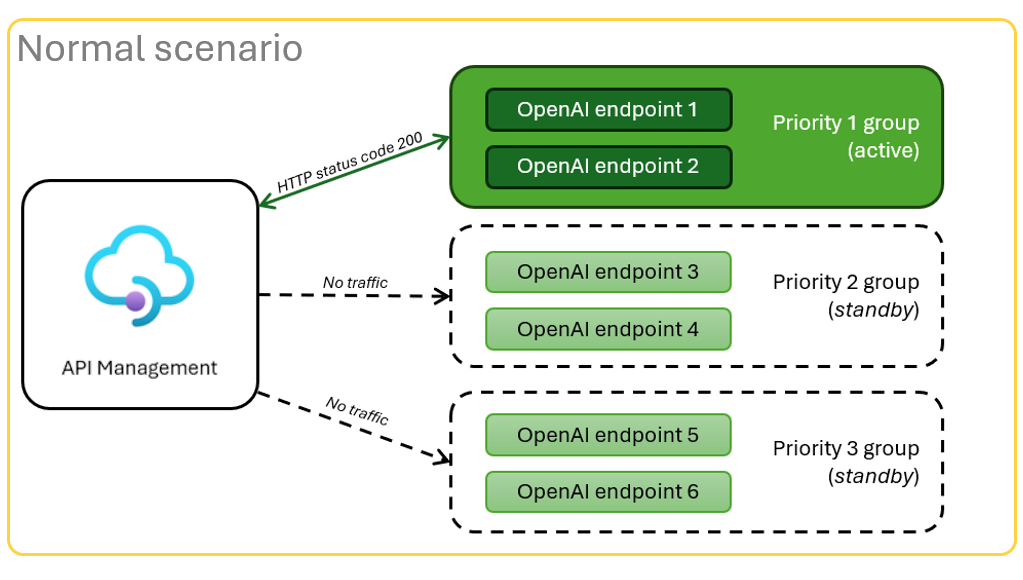

API Management リソースは、API レイヤーとして、一連の Azure OpenAI リソースの前に配置されます。 API レイヤーは、通常時とスロットル制限の 2 つのシナリオに適用されます。 トークンとモデルのクォータを使用できる

リソースがクォータ制限のために 制限 されている場合、API レイヤーは元のチャット アプリ要求を満たすために、直ちに別の Azure OpenAI リソースを再試行できます。

前提 条件

Azure サブスクリプション。 無料で1つ作成してください。

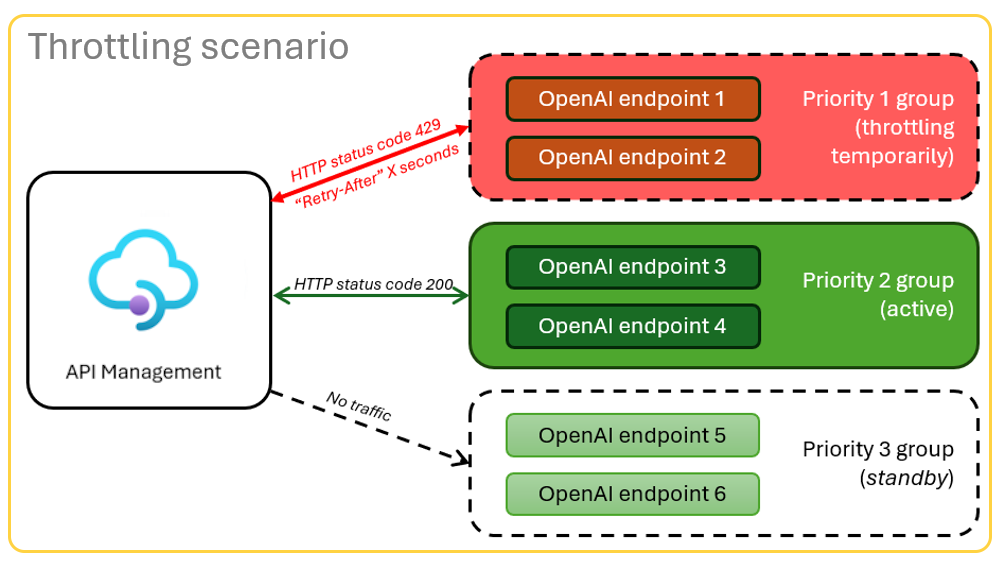

Dev コンテナー は両方のサンプルで使用でき、この記事を完了するために必要なすべての依存関係があります。 開発コンテナーは、GitHub Codespaces (ブラウザー) で実行することも、Visual Studio Code を使用してローカルで実行することもできます。

- GitHub Codespaces を使用するには、GitHub アカウント のみが必要です。

Azure API Management ローカル バランサーのサンプル アプリを開く

重要

すべての GitHub アカウントでは、2 つのコア インスタンスで毎月最大 60 時間無料で GitHub Codespaces を使用できます。 詳細については、

Azure API Management ロード バランサーをデプロイする

ロード バランサーを Azure にデプロイするには、Azure Developer CLI (

AZD) にサインインします。azd auth loginサインイン手順を完了します。

ロード バランサー アプリをデプロイします。

azd upデプロイのサブスクリプションとリージョンを選択します。 チャット アプリと同じサブスクリプションとリージョンである必要はありません。

デプロイが完了するまで待ってから続行します。 このプロセスには最大 30 分かかる場合があります。

ロード バランサー エンドポイントを取得する

次の Bash コマンドを実行して、デプロイの環境変数を確認します。 この情報は後で必要になります。

azd env get-values | grep APIM_GATEWAY_URL

ロード バランサー エンドポイントを使用してチャット アプリを再デプロイする

これらの例は、チャット アプリのサンプルで完了しています。

次のいずれかの選択肢を使用して、チャット アプリ サンプルの開発コンテナーを開きます。

言語 GitHub Codespaces Visual Studio Code .NET で開く

JavaScript で開く

パイソン で開く

Azure Developer CLI (

AZD) にサインインします。azd auth loginサインイン手順を完了します。

chat-appなどの名前を持つAZD環境を作成します。azd env new <name>次の環境変数を追加します。これは、チャット アプリのバックエンドに、Azure OpenAI 要求にカスタム URL を使用するように指示します。

azd env set OPENAI_HOST azure_custom次の環境変数を追加します。これは、チャット アプリのバックエンドに、Azure OpenAI 要求のカスタム URL の値を示します。

azd env set AZURE_OPENAI_CUSTOM_URL <APIM_GATEWAY_URL>チャット アプリを展開します。

azd up

TPM クォータを構成する

既定では、ロード バランサー内の各 Azure OpenAI インスタンスは、1 分あたり 30,000 トークン (TPM) の容量でデプロイされます。 チャット アプリは、クォータを使い切ることなく、多くのユーザー間でスケーリングできるように構築されているという確信を持って使用できます。 この値は、次の場合に変更します。

- デプロイ容量エラーが発生する: 値を小さくします。

- より高い容量が必要ですので、値を上げてください。

次のコマンドを使用して値を変更します。

azd env set OPENAI_CAPACITY 50ロード バランサーを再デプロイします。

azd up

リソースのクリーンアップ

チャット アプリとロード バランサーの使用が完了したら、リソースをクリーンアップします。 この記事で作成した Azure リソースは、Azure サブスクリプションに課金されます。 今後これらのリソースが必要になるとは思わない場合は、削除して、より多くの料金が発生しないようにします。

チャット アプリリソースをクリーンアップする

これらのリソースをクリーンアップするには、チャット アプリの記事に戻ります。

ロード バランサーリソースをクリーンアップする

次の Azure Developer CLI コマンドを実行して、Azure リソースを削除し、ソース コードを削除します。

azd down --purge --force

スイッチは次の機能を提供します。

purge: 削除されたリソースは直ちに消去されます。 1 分あたりに Azure OpenAI トークンを再利用できます。force: 削除は、ユーザーの同意を必要とせずに、自動的に行われます。

リソースのクリーンアップ

GitHub Codespaces 環境を削除すると、アカウントに対して取得するコア時間単位の無料エンタイトルメントの量を最大化できます。

重要

GitHub アカウントの利用資格の詳細については、「GitHub Codespaces の月々に含まれるストレージとコア時間」を参照してください。

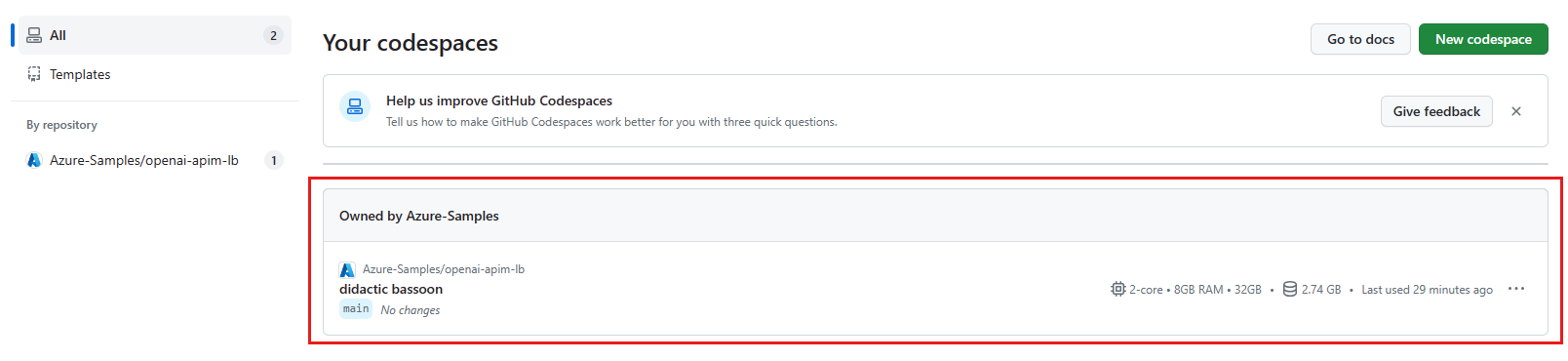

GitHub Codespaces ダッシュボードにサインインします。

azure-samples/openai-apim-lbGitHub リポジトリをソースとして現在実行中の codespace を見つけます。

GitHub Codespaces 項目のコンテキスト メニューを開き、[ 削除]を選択します。

![[削除] オプションが強調表示されている 1 つのコードスペースのコンテキスト メニューを示すスクリーンショット。](../ai/media/get-started-scaling-load-balancer-azure-api-management/codespace-clean-up-repository-delete.png)

ヘルプを受ける

Azure API Management ロード バランサーのデプロイで問題が発生した場合は、リポジトリの Issues Web ページに問題を追加します。

サンプル コード

この記事で使用されるサンプルは次のとおりです。

関連コンテンツ

- Azure Monitorで Azure API Management 診断データ

表示します。 - Azure Load Testing を使用して、チャット アプリをロード テストします。