このチュートリアルでは、ローカル Web UI を使用して、オンボード GPU 搭載の Azure Stack Edge Pro デバイス用のネットワークを構成する方法について説明します。

この接続プロセスの所要時間は約 20 分です。

このチュートリアルでは、ローカル Web UI を使用してご利用の 2 ノード Azure Stack Edge Pro GPU デバイスのネットワークを構成する方法について説明します。

この手順の所要時間は約 45 分です。

このチュートリアルで学習する内容は次のとおりです。

- 前提条件

- ネットワークを構成する

- [高度] ネットワークを構成する

- Web プロキシを構成する

- ネットワークの設定を検証する

- 前提条件

- デバイスのセットアップの種類を選択する

- 両方のノードでネットワークとネットワーク トポロジを構成する

- 準備されたノードの認証トークンを取得する

- クラスター監視を構成し、準備されたノードを追加する

- Azure 整合サービスと NFS の仮想 IP 設定を構成する

- [高度] ネットワークを構成する

- Web プロキシを構成する

- ネットワークの設定を検証する

前提条件

GPU 搭載の Azure Stack Edge Pro デバイスの構成と設定を行う前に、次のことを確認してください。

- Azure Stack Edge Pro の設置に関する記事の詳細に従って、物理デバイスを設置していること。

- GPU 搭載の Azure Stack Edge Pro への接続に関する記事の詳細に従って、デバイスのローカル Web UI に接続していること。

セットアップの種類を構成する

ネットワークを構成する

[開始] ページには、Azure Stack Edge サービスを使用して物理デバイスを構成してアクティブにするために必要なさまざまな設定が表示されます。

デバイスのネットワークを構成するには、次の手順を実行します。

デバイスのローカル Web UI で、 [開始] ページに移動します。

[ネットワーク] タイルで [セットアップが必要] を選択します。

物理デバイスには 6 つのネットワーク インターフェイスがあります。 ポート 1 とポート 2 は、1 Gbps のネットワーク インターフェイスです。 ポート 3、ポート 4、ポート 5、ポート 6 は、すべて 25 Gbps ネットワーク インターフェイスで、10 Gbps ネットワーク インターフェイスとしても機能できます。 ポート 1 は管理専用ポートとして自動的に構成されており、ポート 2 からポート 6 はすべてデータ ポートです。 新しいデバイスの場合、[ネットワーク] ページの表示は次のようになります。

ネットワーク設定を変更するには、ポートを選択し、表示される右側のペインで IP アドレス、サブネット、ゲートウェイ、プライマリ DNS、およびセカンダリ DNS を変更します。

ポート 1 を選ぶと、静的として事前に構成されていることがわかります。

![1 つのノードのローカル Web UI のポート 1 の [ネットワーク設定] のスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/network-3.png)

[ポート 2]、[ポート 3]、[ポート 4]、または [ポート 5] を選択した場合、これらのポートはすべて既定で DHCP として構成されます。

![1 つのノードのローカル Web UI のポート 3 の [ネットワーク設定] のスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/network-4.png)

既定では、すべてのポートに対して IP を設定する必要があります。 デバイス上のネットワーク インターフェイスに対して IP を設定しない場合は、IP を [いいえ] に設定してから、設定を [変更] できます。

![1 つのノードのローカル Web UI のポート 2 の [ネットワーク設定] のスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/set-ip-no.png)

ネットワーク設定を構成するときは、次のことに注意してください。

- ネットワーク機能マネージャーのデプロイ用に、ポート 5 とポート 6 が接続されていることを確認します。 詳細については、チュートリアル: Azure Stack Edge にネットワーク機能をデプロイする (プレビュー) に関するページを参照してください。

- ご利用の環境内で DHCP が有効になっている場合は、ネットワーク インターフェイスが自動的に構成されます。 IP アドレス、サブネット、ゲートウェイ、DNS は自動的に割り当てられます。

- DHCP が有効になっていない場合は、必要に応じて、静的 IP アドレスを割り当てることができます。

- 使用するネットワーク インターフェイスは、IPv4 として構成できます。

- ポートのシリアル番号は、ノードのシリアル番号に対応しています。

注意

外部ネットワークからデバイスに接続する必要がある場合は、「外部ネットワークからのデバイス アクセスを有効にする」を参照して、追加のネットワーク設定を確認してください。

デバイス ネットワークが構成されると、ページは次のように更新されます。

![完全に構成された 1 つのノードのローカル Web UI [ネットワーク] ページのスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/network-2.png)

Note

デバイスに接続する別の IP アドレスがない限り、ネットワーク インターフェイスのローカル IP アドレスを静的から DHCP に切り替えないことをお勧めします。 あるネットワーク インターフェイスを使用していて、DHCP に切り替えた場合、DHCP アドレスを判別する方法がありません。 DHCP アドレスに変更する場合は、デバイスがサービスでアクティブになるまで待機してから変更してください。 その後、サービスについて Azure portal の [デバイスのプロパティ] にすべてのアダプターの IP が表示されます。

ネットワーク設定を構成して適用したら、[次へ: 高度なネットワーク] を選択してコンピューティング ネットワークを構成します。

仮想スイッチを構成する

仮想スイッチを追加または削除するには、次の手順に従います。

Note

デバイスに作成できる仮想スイッチの数に制限はありません。 ただし、コンピューティングを有効にできる仮想スイッチは一度に 1 つのみです。

自分のデバイスのローカル Web UI で、[高度なネットワーク] ページに移動します。

[仮想スイッチ] セクションでは、仮想スイッチを追加または削除します。 [Add virtual switch](仮想スイッチの追加) を選択して、新しいスイッチを作成します。

![ローカル UI の [高度なネットワーク] ページにおける仮想スイッチ オプションの追加のスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/azure-stack-edge-advanced-networking-add-virtual-switch.png)

[ネットワーク設定] ブレードで、新しい仮想スイッチを使用する場合は、次の項目を指定します。

- 仮想スイッチの [名前] を指定します。

- 仮想スイッチを作成するネットワーク インターフェイスを選択します。

- 仮想スイッチの MTU (最大伝送単位) パラメーターを設定します (省略可能)。

- [変更] と [適用] を選択して変更を保存します。

MTU 値は、ネットワーク経由で送信できる最大パケット サイズを決定します。 Azure Stack Edge では、次の表の MTU 値がサポートされています。 ネットワーク パス上のデバイスの MTU 設定が 1500 未満の場合、パケット サイズ 1500 の "フラグメントしない" フラグ (DF) を持つ IP パケットは破棄されます。

Azure Stack Edge SKU ネットワーク インターフェイス サポートされている MTU 値 Pro-GPU ポート 1、2、3、および 4 1400 - 1500 Pro-GPU ポート 5 および 6 構成できません。既定値に設定します。 Pro 2 ポート 1 および 2 1400 - 1500 Pro 2 ポート 3 および 4 構成できません。既定値に設定します。 ホスト仮想スイッチでは、指定された MTU 設定が使用されます。

仮想ネットワーク インターフェイスが仮想スイッチに作成された場合、インターフェイスで指定された MTU 設定が使用されます。 この仮想スイッチがコンピューティングに対して有効になっている場合、Azure Kubernetes Service VM とコンテナー ネットワーク インターフェイス (CIS) でも指定された MTU が使用されます。

![ローカル UI の [高度なネットワーク] ページにおける仮想スイッチ設定の追加のスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/azure-stack-edge-advanced-networking-add-virtual-switch-settings.png)

仮想スイッチを作成すると、MTU 列に MTU 値が設定されます。

![ローカル UI の [高度なネットワーク] での MTU 設定のスクリーンショット](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/azure-stack-edge-maximum-transmission-unit.png)

構成の適用には数分かかり、仮想スイッチが作成されると、仮想スイッチの一覧が更新され、新たに作成されたスイッチが反映されます。 指定した仮想スイッチが作成され、コンピューティング用に有効になっていることを確認できます。

![ローカル UI 3 の [高度なネットワーク] でのコンピューティング ページのスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/configure-compute-network-3.png)

前に説明した手順に従って複数のスイッチを作成できます。

仮想スイッチを削除するには、[仮想スイッチ] セクションで、[Delete virtual switch](仮想スイッチの削除) を選択します。 仮想スイッチが削除されると、関連付けられている仮想ネットワークも削除されます。

次に、仮想ネットワークを作成して仮想スイッチに関連付けることができます。

仮想ネットワークを構成する

仮想スイッチに関連付けられた仮想ネットワークを追加または削除できます。 仮想スイッチを追加するには、次の手順を実行します。

[高度なネットワーク] ページのローカル UI の [仮想ネットワーク] セクションで、[仮想ネットワークの追加] を選択します。

[仮想ネットワークの追加] ブレードで、次の情報を入力します。

- 仮想ネットワークを作成する仮想スイッチを選択します。

- 仮想ネットワークの [名前] を入力します。 指定する名前は、Azure リソースの名前付け規則と制限事項に準拠している必要があります。

- 1 ~ 4094 の範囲の一意の番号として、[VLAN ID] を入力します。 指定する VLAN ID は、トランク構成に含まれている必要があります。 スイッチのトランク構成の詳細については、物理スイッチの製造元の手順を参照してください。

- 物理ネットワークの構成に従って、仮想 LAN ネットワークの [サブネット マスク] と [ゲートウェイ] を指定します。

- [適用] を選択します。 指定した仮想スイッチに仮想ネットワークが作成されます。

![1 つのノードのローカル UI における [高度なネットワーク] ページで仮想ネットワークを追加する方法を示すスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/add-virtual-network-one-node-1.png)

仮想ネットワークを削除するには、[仮想ネットワーク] セクションで、[仮想ネットワークの削除] を選択し、削除したい仮想ネットワークを選択します。

[次へ: Kubernetes > ] を選択して、次に Kubernetes のコンピューティング IP を構成します。

コンピューティング IP を構成する

仮想スイッチが作成されたら、Kubernetes コンピューティング トラフィックに対してスイッチを有効にすることができます。

ローカル UI で、Kubernetes ページに移動します。

指定されたオプションからワークロードを指定します。

- Azure のプライベート MEC ソリューションを使用している場合は、オプションで [環境内の Azure プライベート MEC ソリューション] を選択します。

- SAP Digital Manufacturing ソリューションまたは別の Microsoft パートナー ソリューションで作業している場合は、オプションで [環境内のSAP Digital Manufacturing for Edge Computing または別の Microsoft パートナー ソリューション] を選択します。

- 他のワークロードの場合は、[環境内の他のワークロード] のオプションを選択します。

要求された場合は指定したオプションを確認した上で、[適用] を選択します。

PowerShell を使用してワークロードを指定するには、詳細な手順を「Kubernetes ワークロード プロファイルの変更」で参照してください。

![2 つのノードに対するローカル UI の Kubernetes ページでの [ワークロード] 選択オプションのスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/azure-stack-edge-kubernetes-workload-selection.png)

ドロップダウン リストから、Kubernetes コンピューティング トラフィックに対して有効にしたい仮想スイッチを選択します。

Kubernetes ノードの IP を割り当てます。 これらの静的 IP アドレスは、Kubernetes VM 用です。

環境に対して、[Azure プライベート MEC ソリューション] か、[SAP Digital Manufacturing for Edge Computing または別の Microsoft パートナー] のワークロード オプションを選択する場合、1 ノード構成に対しては少なくとも 6 つの IPv4 アドレス (またはそれ以上) の連続した範囲を指定し、2 ノード構成に対しては 7 つの IPv4 アドレス (またはそれ以上) を指定する必要があります。

n ノード デバイスで他のワークロード オプションを選択している場合、開始 IP アドレスと終了 IP アドレスを使用して、少なくとも n+1 個 (またはそれ以上) の IPv4 アドレスの連続した範囲が、コンピューティング VM に提供されます。 1 ノード デバイスの場合は、少なくとも 2 つの無料の連続する IPv4 アドレスを指定します。 2 ノード クラスターの場合は、少なくとも 3 つの無料の連続する IPv4 アドレスを指定します。

重要

- 環境内で他のワークロードを実行 している場合、Azure Stack Edge 上の Kubernetes は、ポッド用として 172.27.0.0/16 サブネットを、サービス用として 172.28.0.0/16 サブネットをそれぞれ使用します。 これらがご利用のネットワークで使用されていないことを確認してください。 詳細については、「Kubernetes ポッドとサービス サブネットの変更」を参照してください。

- DHCP モードは、Kubernetes ノード IP ではサポートされていません。

Kubernetes 外部サービス IP を割り当てます。 これらは、負荷分散 IP アドレスでもあります。 これらの連続した IP アドレスは、Kubernetes クラスターの外部に公開するサービス用であり、公開するサービスの数に応じて静的 IP 範囲を指定します。

重要

Azure Stack Edge Hub サービスからコンピューティング モジュールにアクセスするには、最低 1 つの IP アドレスを指定することを強くお勧めします。 サービス IP アドレスは後で更新できます。

適用を選択します。

![ローカル UI 2 の [高度なネットワーク] の [コンピューティングの構成] ページのスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/configure-compute-network-2.png)

構成の適用には数分かかり、ブラウザーを最新の情報に更新することが必要になる場合があります。

[次へ: Web プロキシ] を選択して、Web プロキシを構成します。

セットアップの種類を構成する

いずれかのデバイスのローカル UI で、[開始] ページに移動します。

[Set up a 2-node cluster](2 ノード クラスターのセットアップ) タイルで、[開始] を選択します。

![[開始] ページのローカル Web UI の [Set up a 2-node cluster] (2 ノード クラスターのセットアップ)](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/setup-type-two-node-1m.png)

2 つ目のデバイスのローカル UI で、[開始] ページに移動します。

[Prepare a node](ノードの準備) タイルで、[開始] を選択します。

![[開始] ページのローカル Web UI の [Prepare a node](ノードの準備)](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/setup-type-prepare-node-1m.png)

ネットワーク、トポロジを構成する

両方のノードでネットワークとネットワーク トポロジを構成します。 これらの手順は並行して実行できます。 両方のノードのケーブル配線は同じにする必要があり、選択したネットワーク トポロジに準拠している必要があります。

ネットワーク トポロジの選択の詳細情報については、「サポートされているネットワーク トポロジ」を参照してください。

1 つ目のノードでネットワークを構成する

2 ノード デバイス用にネットワークを構成するには、デバイスの 1 つ目のノードで次の手順を実行します。

1 つ目のノードのローカル UI の [ネットワーク] タイルで、[Needs setup](セットアップが必要) を選択します。

![ローカル Web UI の [ネットワーク] タイル](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/select-network-1m.png)

[ネットワーク] ページで、ネットワーク インターフェイスの IP アドレスを構成します。 物理デバイスには 6 つのネットワーク インターフェイスがあります。 ポート 1 とポート 2 は、1 Gbps のネットワーク インターフェイスです。 ポート 3、ポート 4、ポート 5、ポート 6 は、すべて 25 Gbps ネットワーク インターフェイスで、10 Gbps ネットワーク インターフェイスとしても機能できます。 ポート 1 は管理専用ポートとして自動的に構成されており、ポート 2 からポート 6 はすべてデータ ポートです。

新しいデバイスの場合、[ネットワーク設定] ページは次のようになります。

![新しいデバイス 1 のローカル Web UI の [高度なネットワーク] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/configure-network-interface-1.png)

ネットワーク設定を変更するには、ポートを選択し、表示される右側のペインで IP アドレス、サブネット、ゲートウェイ、プライマリ DNS、およびセカンダリ DNS を変更します。 使用するネットワーク インターフェイスは、IPv4 として構成できます。

![新しいデバイス 2 のローカル Web UI の [高度なネットワーク] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/configure-network-settings-1m.png)

既定では、すべてのポートに対して IP を設定する必要があります。 デバイス上のネットワーク インターフェイスに対して IP を設定しない場合は、IP を [いいえ] に設定してから、設定を [変更] できます。

![1 つのノードのローカル Web UI のポート 2 の [ネットワーク設定] のスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/set-ip-no.png)

ネットワーク設定を構成するときは、次のことに注意してください。

ネットワーク機能マネージャーのデプロイ用に、ポート 5 とポート 6 が接続されていることを確認します。 詳細については、チュートリアル: Azure Stack Edge にネットワーク機能をデプロイする (プレビュー) に関するページを参照してください。

ご利用の環境内で DHCP が有効になっている場合は、ネットワーク インターフェイスが自動的に構成されます。 IP アドレス、サブネット、ゲートウェイ、DNS は自動的に割り当てられます。 DHCP が有効になっていない場合は、必要に応じて、静的 IP アドレスを割り当てることができます。

25 Gbps インターフェイスでは、RDMA (Remote Direct Access Memory) モードを iWarp または RoCE (RDMA over Converged Ethernet) に設定できます。 待機時間が短いことが主な要件であり、スケーラビリティが問題ではない場合は、RoCE を使用します。 待機時間が重要な要件であり、使いやすさとスケーラビリティも優先度が高い場合は、iWARP が最適な候補です。

ポートのシリアル番号は、ノードのシリアル番号に対応しています。

重要

2 つのノード クラスターの場合、ネットワーク トポロジでは、IP アドレスが設定されたネットワーク インターフェイスのみがサポートされます。

ネットワーク設定を適用したら、[次へ: 高度なネットワーク >] を選択してネットワーク トポロジを構成します。

1 つ目のノードでネットワーク トポロジを構成する

[高度なネットワーク] ページで、次のオプションから、クラスターのトポロジとノード間のストレージ トラフィックを選択します。

[スイッチレス]。 このオプションは、高速スイッチがストレージ トラフィックとクラスタリング トラフィックに使用できない場合に使用します。

[Use switches and NIC teaming](スイッチと NIC チーミングを使用する)。 このオプションは、チーミングを通したポート レベルの冗長性が必要な場合に使用します。 NIC チーミングを使用すると、このケースのデバイス ノード、ポート 3、およびポート 4 の 2 つの物理ポートを、2 つのソフトウェアベースの仮想ネットワーク インターフェイスにグループ化することができます。 これらのチーミングされたネットワーク インターフェイスは、ネットワーク インターフェイスで障害が発生した場合に、高速なパフォーマンスとフォールト トレランスを提供します。 詳細については、「Windows Server 上の NIC チーミング」を参照してください。

[NIC チーミングなしでスイッチを使用する]。 ワークロード トラフィック用に追加のポートが必要で、ポート レベルの冗長性が不要な場合は、このオプションを使用します。

![[スイッチと NIC チーミングを使用する] オプションが選択されているローカル Web UI の [ネットワーク] ページのスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/select-network-topology-1m.png)

選択したトポロジに従ってノードがケーブル配線されていることを確認してください。

適用を選択します。

[ネットワーク設定を確認する] ダイアログでは、選択したネットワーク トポロジに従ってノードがケーブル配線されていることを確認するように要求されます。 ネットワーク クラスター トポロジを選択したら、デバイスをリセットしないとこのトポロジを変更できなくなります。 ネットワークトポロジを確認するには、[はい] を選択します。

![ローカル Web UI の [Confirm network setting] (ネットワーク設定の確認) ダイアログ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/confirm-network-setting-1.png)

ネットワーク トポロジの設定が適用されるまでに数分かかります。設定が正常に適用されると、通知が表示されます。

ネットワークトポロジが適用されると、[ネットワーク] ページが更新されます。 たとえば、スイッチと NIC チーミングを使用するネットワーク トポロジを選択した場合は、デバイス ノードで、仮想スイッチ vSwitch1 がポート 2 と別の仮想スイッチで作成され、vSwitch2 がポート 3 とポート 4 で作成されることがわかります。 ポート 3 とポート 4 がチーミングされてから、チームミングされたネットワーク インターフェイスで、vPort3 と vPort4 という 2 つの仮想ネットワーク インターフェイスが作成されます。 2 つ目のデバイス ノードも同様です。 チーミングされたネットワーク インターフェイスは、スイッチを介して接続されます。

![更新されたローカル Web UI の [ネットワーク] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/network-settings-updated-1.png)

次に、2 つ目のノードのネットワークとネットワーク トポロジを構成します。

2 つ目のノードでネットワークを構成する

クラスタリング用の 2 つ目のノードを準備します。 まず、ネットワークを構成します。 2 つ目のノードのローカル UI で、次の手順を実行します。

[クラスタリングのためにノードを準備] ページの [ネットワーク] タイルで、[Needs setup](セットアップが必要) を選択します。

![2 つ目のノード上のローカル Web UI の [ネットワーク] タイル](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/select-network-2.png)

最初のノードを構成したのと同様の方法で、2 番目のノードにネットワークを構成します。

2 つ目のノードでネットワーク トポロジを構成する

1 つ目のノード用に選択したトポロジに従って 2 つ目のノードがケーブル配線されていることを確認してください。 [ネットワーク] ページで、1 つ目のノード用に選択したものと同じトポロジを選択して [適用] します。

オプションが選択されたローカル Web UI の [ネットワーク] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/select-network-topology-2.png)

[[開始] に戻る] を選択します。

認証トークンを取得する

クラスターを形成するために、認証トークンを取得してこのノードを追加するには、2 つ目のノードのローカル UI で次の手順に従います。

[クラスタリングのためにノードを準備] ページの [認証トークンを取得する] タイルで、[ノードの準備] を選択します。

![2 つ目のノードで [ノードの準備] オプションが選択されたローカル Web UI の [認証トークンを取得する] タイル](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/select-get-authentication-token-1m.png)

[Get Token](トークンの取得) を選択します。

ノードのシリアル番号と認証トークンをコピーします。 この情報は、最初のノードのクラスターにこのノードを追加するときに使います。

![2 つ目のノード上のローカル Web UI の [認証トークンを取得する]](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/get-authentication-token-1m.png)

クラスターの構成

クラスターを構成するには、クラスター監視を設置してから、準備されたノードを追加する必要があります。 特定のノードではなくクラスターに接続できるように、仮想 IP 設定を構成する必要があります。

クラスター監視を構成する

ここでは、クラスター監視を作成します。 クラスター監視は、ノードがダウンした場合に 2 ノード デバイスのクォーラムを設置するのに役立ちます。 クォーラムの詳細については、「クォーラムについて」を参照してください。

クラスター監視で可能なことは次のとおりです。

Azure Storage アカウントを使用してクラスター クォーラムに関する投票を行う場合のクラウド監視。 クラウド監視は、Azure Blob Storage を使用して BLOB ファイルを読み取ったり書き込んだりしてから、それを使用してスプリットブレインの解決で判別します。

インターネットにアクセスできる場合は、クラウド監視を使用します。 クラウド監視の詳細については、「フェールオーバー クラスターのクラウド監視を展開する」を参照してください。

ローカルの SMB ファイル共有を使用してクラスター クォーラムで投票を提供する場合のファイル共有監視。 ファイル共有監視は、クラスター内のすべてのサーバーのインターネット接続に一貫性がない場合や共有ドライブがないためにディスク監視を使用できない場合に使用します。

ファイル共有監視は、他のマシンやファイル共有が存在する IT 環境で作業している場合に使用します。 ファイル共有監視の詳細については、「フェールオーバー クラスターのファイル共有監視を展開する」を参照してください。

クラスター監視を作成する前に、クラスター監視の要件を確認してください。

次の手順に従って、クラスター監視を構成します。

クラウド監視を構成する

1 つ目のノードのローカル UI で、[クラスター (プレビュー)] ページに移動します。 [Cluster witness type](クラスター監視の種類) で、[変更] を選択します。

で [変更] オプションが選択されたローカル Web UI の [クラスター] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/add-cluster-witness-1m.png)

[Modify cluster witness](クラスター監視の変更) ブレードで、次の値を入力します。

- [監視の種類] として [クラウド] を選択します。

- [Azure Storage アカウント名] を入力します。

- アクセス キーまたは SAS トークンからストレージ アカウント認証を指定します。

- 認証メカニズムとしてアクセス キーを選択した場合は、ストレージ アカウントのアクセス キー、監視が稼働中の Azure Storage コンテナー、およびサービス エンドポイントを入力します。

- [適用] を選択します。

ブレードでクラウドの監視の種類が選択されたローカル Web UI の [クラスター] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/add-cluster-witness-cloud-1m.png)

ローカル監視を構成する

1 つ目のノードのローカル UI で、[クラスター] ページに移動します。 [Cluster witness type](クラスター監視の種類) で、[変更] を選択します。

で [変更] オプションが選択されたローカル Web UI の [クラスター] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/add-cluster-witness-1m.png)

[Modify cluster witness](クラスター監視の変更) ブレードで、次の値を入力します。

- [監視の種類] として [ローカル] を選択します。

- ファイル共有パスを //server/fileshare の形式で入力します。

- [適用] を選択します。

ブレードでローカルの監視の種類が選択されたローカル Web UI の [クラスター] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/add-cluster-witness-local-1m.png)

準備されたノードをクラスターに追加する

準備されたノードを 1 つ目のノードに追加し、クラスターを形成します。 準備されたノードを追加する前に、受信ノード上のネットワークが、クラスターの作成が開始された時点のこのノードと同様に構成されていることを確認してください。

1 つ目のノードのローカル UI で、[クラスター] ページに移動します。 [Existing nodes](既存のノード) で、[ノードの追加] を選択します。

![1 つ目のノード上の [Existing] (既存) で [ノードの追加] オプションが選択されたローカル Web UI の [クラスター] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/add-node-1m.png)

[ノードの追加] ブレードで、受信ノードに関する次の情報を入力します。

- 受信ノードのシリアル番号を指定します。

- 受信ノードの認証トークンを入力します。

[検証と追加] を選択します。 この手順には数分かかります。

![1 つ目のノード上の [Existing] (既存) で [ノードの追加] オプションが選択されたローカル Web UI の [ノードの追加] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/add-node-2m.png)

ノードが正常に検証されると、通知が表示されます。

ノードをクラスターに参加させる準備ができました。 [適用] を選択します。 クラスターの作成には数分かかります。 クラスターが作成されると、ページが更新され、両方のノードが追加されたことが示されます。

仮想 IP を構成する

Azure 整合サービスと NFS の場合は、特定のノードではなく、クラスター化されたデバイスに接続可能な仮想 IP を定義する必要もあります。 仮想 IP はクラスター ネットワークで使用可能な IP であり、2 ノード デバイス上のクラスター ネットワークに接続しているすべてのクライアントがこの IP にアクセスできる必要があります。 Azure 整合性サービスと NFS は、同じネットワーク上に置かれている必要があります。

Azure 整合サービスの場合

Azure 整合サービスの場合は、次の手順に従って仮想 IP を構成します。

[クラスター] ページのローカル UI の [Virtual IP settings](仮想 IP 設定) セクションで、[Azure 整合サービス] を選択します。

で [Azure 整合サービス] が選択されたローカル Web UI の [クラスター] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/configure-azure-consistent-services-1m.png)

[Virtual IP settings](仮想 IP 設定) ブレードで、次の値を入力します。

- ドロップダウン リストから、[Azure 整合サービスのネットワーク] を選択します。

- [DHCP] または [静的] から [IP 設定] を選択します。

- [IP 設定] を [静的] として選択した場合は、仮想 IP を入力します。 これは、指定した Azure 整合サービス ネットワーク内からの無料 IP である必要があります。 [DHCP] を選択した場合は、選択した Azure 整合サービス ネットワークから仮想 IP が自動的に選択されます。

[適用] を選択します。

![1 つ目のノード上の Azure 整合サービスに対して [Virtual IP settings] (仮想 IP 設定) ブレードが構成されているローカル Web UI の [クラスター] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/configure-azure-consistent-services-2m.png)

ネットワーク ファイル システムの場合

NFS プロトコルを介して 2 ノード デバイスに接続しているクライアントの場合は、次の手順に従って仮想 IP を構成します。

[クラスター] ページのローカル UI の [Virtual IP settings](仮想 IP 設定) セクションで、[ネットワーク ファイル システム] を選択します。

で [ネットワーク ファイル システム] が選択されたローカル Web UI の [クラスター] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/configure-network-file-system-1m.png)

[Virtual IP settings](仮想 IP 設定) ブレードで、次の値を入力します。

- ドロップダウン リストから、[NFS ネットワーク] を選択します。

- [DHCP] または [静的] から [IP 設定] を選択します。

- [IP 設定] を [静的] として選択した場合は、仮想 IP を入力します。 これは、指定した NFS ネットワーク内からの無料 IP である必要があります。 [DHCP] を選択した場合は、選択した NFS ネットワークから仮想 IP が自動的に選択されます。

[適用] を選択します。

ブレードが構成されたローカル Web UI の [クラスター] ページ](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/configure-network-file-system-2m.png)

Note

[Virtual IP settings](仮想 IP 設定) は必須です。 この IP を構成しない場合は、次の手順で [デバイス設定] を構成するときにブロックされます。

仮想スイッチを構成する

クラスターの形成と構成が完了したら、新しい仮想スイッチを作成できます。

重要

2 ノード クラスターでは、コンピューティングを仮想スイッチでのみ構成する必要があります。

ローカル UI で、[高度なネットワーク] ページに移動します。

[仮想スイッチ] セクションでは、仮想スイッチを追加または削除します。 [Add virtual switch](仮想スイッチの追加) を選択して、新しいスイッチを作成します。

![ローカル UI の [高度なネットワーク] ページにおける仮想スイッチ オプションの追加のスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/azure-stack-edge-advanced-networking-add-virtual-switch.png)

[ネットワーク設定] ブレードで、新しい仮想スイッチを使用する場合は、次の項目を指定します。

- 仮想スイッチの [名前] を指定します。

- 仮想スイッチを作成するネットワーク インターフェイスを選択します。

- 仮想スイッチの MTU (最大伝送単位) パラメーターを設定します (省略可能)。

- [変更] と [適用] を選択して変更を保存します。

MTU 値は、ネットワーク経由で送信できる最大パケット サイズを決定します。 Azure Stack Edge では、次の表の MTU 値がサポートされています。 ネットワーク パス上のデバイスの MTU 設定が 1500 未満の場合、パケット サイズ 1500 の "フラグメントしない" フラグ (DF) を持つ IP パケットは破棄されます。

Azure Stack Edge SKU ネットワーク インターフェイス サポートされている MTU 値 Pro-GPU ポート 1、2、3、および 4 1400 - 1500 Pro-GPU ポート 5 および 6 構成できません。既定値に設定します。 Pro 2 ポート 1 および 2 1400 - 1500 Pro 2 ポート 3 および 4 構成できません。既定値に設定します。 ホスト仮想スイッチでは、指定された MTU 設定が使用されます。

仮想ネットワーク インターフェイスが仮想スイッチに作成された場合、インターフェイスで指定された MTU 設定が使用されます。 この仮想スイッチがコンピューティングに対して有効になっている場合、Azure Kubernetes Service VM とコンテナー ネットワーク インターフェイス (CIS) でも指定された MTU が使用されます。

![ローカル UI の [高度なネットワーク] ページの [仮想スイッチの追加] 設定のスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/azure-stack-edge-advanced-networking-add-virtual-switch-settings.png)

仮想スイッチを作成すると、MTU 列に MTU 値が設定されます。

![ローカル UI の [高度なネットワーク] の MTU 設定のスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/azure-stack-edge-maximum-transmission-unit.png)

構成の適用には数分かかり、仮想スイッチが作成されると、仮想スイッチの一覧が更新され、新たに作成されたスイッチが反映されます。 指定した仮想スイッチが作成され、コンピューティング用に有効になっていることを確認できます。

![ローカル UI 3 の [高度なネットワーク] の [コンピューティングの構成] ページのスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/configure-compute-network-3.png)

前に説明した手順に従って複数のスイッチを作成できます。

仮想スイッチを削除するには、[仮想スイッチ] セクションで、[Delete virtual switch](仮想スイッチの削除) を選択します。 仮想スイッチを削除すると、関連する仮想ネットワークも削除されます。

次に、仮想ネットワークを作成して仮想スイッチに関連付けることができます。

仮想ネットワークを構成する

仮想スイッチに関連付けられた仮想ネットワークを追加または削除できます。 仮想ネットワークを追加するには、以下の手順のようにします。

[高度なネットワーク] ページのローカル UI の [仮想ネットワーク] セクションで、[仮想ネットワークの追加] を選択します。

[仮想ネットワークの追加] ブレードで、次の情報を入力します。

- 仮想ネットワークを作成する仮想スイッチを選択します。

- 仮想ネットワークの [名前] を入力します。 指定する名前は、Azure リソースの名前付け規則と制限事項に準拠している必要があります。

- 1 ~ 4094 の範囲の一意の番号として、[VLAN ID] を入力します。 指定する VLAN ID は、トランク構成に含まれている必要があります。 スイッチのトランク構成の詳細については、物理スイッチの製造元の手順を参照してください。

- 物理ネットワークの構成に従って、仮想 LAN ネットワークの [サブネット マスク] と [ゲートウェイ] を指定します。

- 適用を選択します。

![2 つのノードのローカル UI における [高度なネットワーク] ページで仮想ネットワークを追加する方法を示すスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/add-virtual-network-one-node-1.png)

仮想ネットワークを削除するには、[仮想ネットワーク] セクションで、[仮想ネットワークの削除] を選択し、削除したい仮想ネットワークを選択します。

[次へ: Kubernetes > ] を選択して、次に Kubernetes のコンピューティング IP を構成します。

コンピューティング IP を構成する

仮想スイッチが作成されたら、Kubernetes コンピューティング トラフィックに対してスイッチを有効にすることができます。

ローカル UI で、Kubernetes ページに移動します。

指定されたオプションからワークロードを指定します。

- Azure のプライベート MEC ソリューションを使用している場合は、オプションで [環境内の Azure プライベート MEC ソリューション] を選択します。

- SAP Digital Manufacturing ソリューションまたは別の Microsoft パートナー ソリューションで作業している場合は、オプションで [環境内のSAP Digital Manufacturing for Edge Computing または別の Microsoft パートナー ソリューション] を選択します。

- 他のワークロードの場合は、[環境内の他のワークロード] のオプションを選択します。

要求された場合は指定したオプションを確認した上で、[適用] を選択します。

PowerShell を使用してワークロードを指定するには、詳細な手順を「Kubernetes ワークロード プロファイルの変更」で参照してください。

![2 つのノードに対するローカル UI の Kubernetes ページでの [ワークロード] 選択オプションのスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/azure-stack-edge-kubernetes-workload-selection.png)

ドロップダウン リストから、Kubernetes コンピューティング トラフィックに対して有効にしたい仮想スイッチを選択します。

Kubernetes ノードの IP を割り当てます。 これらの静的 IP アドレスは、Kubernetes VM 用です。

環境に対して、[Azure プライベート MEC ソリューション] か、[SAP Digital Manufacturing for Edge Computing または別の Microsoft パートナー] のワークロード オプションを選択する場合、1 ノード構成に対しては少なくとも 6 つの IPv4 アドレス (またはそれ以上) の連続した範囲を指定し、2 ノード構成に対しては 7 つの IPv4 アドレス (またはそれ以上) を指定する必要があります。

n ノード デバイスで他のワークロード オプションを選択している場合、開始 IP アドレスと終了 IP アドレスを使用して、少なくとも n+1 個 (またはそれ以上) の IPv4 アドレスの連続した範囲が、コンピューティング VM に提供されます。 1 ノード デバイスの場合は、少なくとも 2 つの無料の連続する IPv4 アドレスを指定します。 2 ノード クラスターの場合は、少なくとも 3 つの無料の連続する IPv4 アドレスを指定します。

重要

- 環境内で他のワークロードを実行 している場合、Azure Stack Edge 上の Kubernetes は、ポッド用として 172.27.0.0/16 サブネットを、サービス用として 172.28.0.0/16 サブネットをそれぞれ使用します。 これらがご利用のネットワークで使用されていないことを確認してください。 詳細については、「Kubernetes ポッドとサービス サブネットの変更」を参照してください。

- DHCP モードは、Kubernetes ノード IP ではサポートされていません。

Kubernetes 外部サービス IP を割り当てます。 これらは、負荷分散 IP アドレスでもあります。 これらの連続した IP アドレスは、Kubernetes クラスターの外部に公開するサービス用であり、公開するサービスの数に応じて静的 IP 範囲を指定します。

重要

Azure Stack Edge Hub サービスからコンピューティング モジュールにアクセスするには、最低 1 つの IP アドレスを指定することを強くお勧めします。 サービス IP アドレスは後で更新できます。

[適用] を選択します。

![ローカル UI 2 の [高度なネットワーク] でコンピューティング ページを構成する](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/configure-compute-network-2.png)

構成の適用には数分かかり、ブラウザーを最新の情報に更新することが必要になる場合があります。

[次へ: Web プロキシ] を選択して、Web プロキシを構成します。

Web プロキシを構成する

これはオプション構成です。 Web プロキシの構成は省略可能ですが、Web プロキシを使用する場合は、このページでのみ構成できます。

重要

- プロキシ自動構成 (PAC) ファイルはサポートされていません。 PAC ファイルは、Web ブラウザーやその他のユーザー エージェントが、特定の URL をフェッチするための適切なプロキシ サーバー (アクセス方法) を自動的に選択する方法を定義します。

- 透過プロキシは、Azure Stack Edge Pro で適切に動作します。 プロキシ サーバーにインストールされている独自の証明書を通じて、すべてのトラフィックをインターセプトして読み取る非透過的プロキシの場合は、プロキシの証明書の公開キーを Azure Stack Edge Pro デバイスの署名チェーンとしてアップロードします。 その後、Azure Stack Edge デバイスのプロキシ サーバー設定を構成できます。 詳細については、独自の証明書の持ち込みとローカル UI によるアップロードに関するセクションを参照してください。

[Web プロキシの設定] ページで、次の手順を実行します。

[Web プロキシ URL] ボックスに、

http://host-IP address or FQDN:Port numberという形式の URL を入力します。 HTTPS の URL はサポートされていません。構成された Web プロキシ設定を検証して適用するには、 [適用] を選択します。

![ローカル Web UI の [Web プロキシの設定] ページ 2 のスクリーンショット](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/configure-web-proxy-1.png)

ネットワークの設定を検証する

ネットワーク設定を検証するには、こちらの手順に従います。

[Diagnostic tests] (診断テスト) ページに移動して、下に示すようにテストを選択します。

[テストの実行] を選択します。

![Azure Stack Edge デバイスのローカル Web UI の [Diagnostic tests] (診断テスト) ページのスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/validate-network-settings-with-diagnostic-test.png)

テスト結果を確認して、実行された各テストの状態が [正常] と示されていることを確認します。

![Azure Stack Edge デバイスのローカル Web UI の [Diagnostic tests results] (診断テスト結果) ページのスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/validate-network-settings-with-diagnostic-test-results.png)

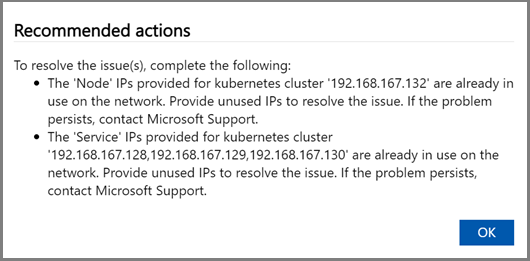

テストが失敗した場合は、テスト結果ページで [推奨アクション] を選択し、推奨される変更を実装してから、テストを再実行します。 たとえば、下のダイアログには、Azure Edge コンピューティング ランタイムのテストが失敗した場合の推奨アクションが示されています。

ネットワーク設定が検証され、すべてのテストで [正常] 状態が返されたら、デバイス設定ページに進みます。

2 ノード デバイスの 2 つ目のノードに対して、上記の手順を繰り返します。 必ず、両方のデバイス ノードで同じ Web プロキシ設定を使用してください。

次のステップ

このチュートリアルで学習した内容は次のとおりです。

- 前提条件

- ネットワークを構成する

- コンピューティング ネットワークを有効にする

- Web プロキシを構成する

- ネットワークの設定を検証する

- 前提条件

- デバイスのセットアップの種類を選択する

- 両方のノードでネットワークを構成する

- 準備されたノードの認証トークンを取得する

- クラスター監視を構成し、準備されたノードを追加する

- Azure 整合サービスと NFS の仮想 IP 設定を構成する

- [高度] ネットワークを構成する

- Web プロキシを構成する

- ネットワークの設定を検証する

ご利用の Azure Stack Edge Pro GPU デバイスを設定する方法については、以下を参照してください。

![1 つのノードのローカル Web UI の [作業の開始] ページのスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/setup-type-single-node-1.png)

![1 つのノードのローカル Web UI の [ネットワーク] タイルのスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/network-1.png)

![1 つのノードのローカル Web UI の [ネットワーク] ページのスクリーンショット。](media/azure-stack-edge-gpu-deploy-configure-network-compute-web-proxy/network-2a.png)