Personalizer の学習動作を構成する

重要

2023 年 9 月 20 日以降は、新しい Personalizer リソースを作成できなくなります。 Personalizer サービスは、2026 年 10 月 1 日に廃止されます。

見習いモードを使用すると、Personalizer サービスとその機械学習機能が信頼できるようになり、オンライン トラフィックを危険にすることなく、学習可能な情報がサービスに送信されることの保証が提供されます。

見習いモードを構成する

Azure portal にサインインし、Personalizer リソースに移動します。

[設定] ページの [モデルの設定] タブで、[徒弟モード] を選択し、[保存] を選択します。

既存のアプリケーションを変更する

既存のアプリケーションでは、表示するアクションの現在の選択方法、またはアプリケーションで値 (そのアクションの報酬) を決定する方法を変更することはできません。 アプリケーションで変更できるのは、Personalizer の Rank API に送信されるアクションの順序だけです。 アプリケーションで現在表示されているアクションは、アクション リストの "最初のアクション" として送信されます。 Rank API では、この最初のアクションを使用して、Personalizer モデルがトレーニングされます。

Rank API を呼び出すようにアプリケーションを構成する

アプリケーションに Personalizer を追加するには、Rank API と Reward API を呼び出す必要があります。

既存のアプリケーションのロジックで、アクションとその特徴のリストを決定する場所の後に、Rank API の呼び出しを追加します。 アクション リストの最初のアクションは、既存のロジックによって選択されたアクションである必要があります。

Rank API の応答の報酬アクション ID に関連付けられているアクションを表示するように、コードを構成しします。

Reward API を呼び出すようにアプリケーションを構成する

注意

Reward API の呼び出しは、徒弟モードの間のトレーニングには影響しません。 サービスは、アプリケーションの現在のロジックまたは既定のアクションを一致させることによって学習します。 ただし、この段階で Reward の呼び出しを実装すると、後のオンライン モードへの切り替えが、Azure portal の簡単なスイッチでスムーズに行われるようになります。 さらに、報酬がログに記録され、現在のロジックのパフォーマンスと受け取る報酬の量を分析できます。

既存のビジネス ロジックを使用して、表示されたアクションの報酬を計算します。 値は、0 から 1 の範囲になる必要があります。 Reward API を使用して、この報酬を Personalizer に送ります。 ビジネス ロジックによっては、報酬の値はすぐに必要ではなく、遅くなってもかまわない場合があります。

構成された報酬待機時間内に報酬を返さないと、代わりに既定の報酬が記録されます。

見習いモードを評価する

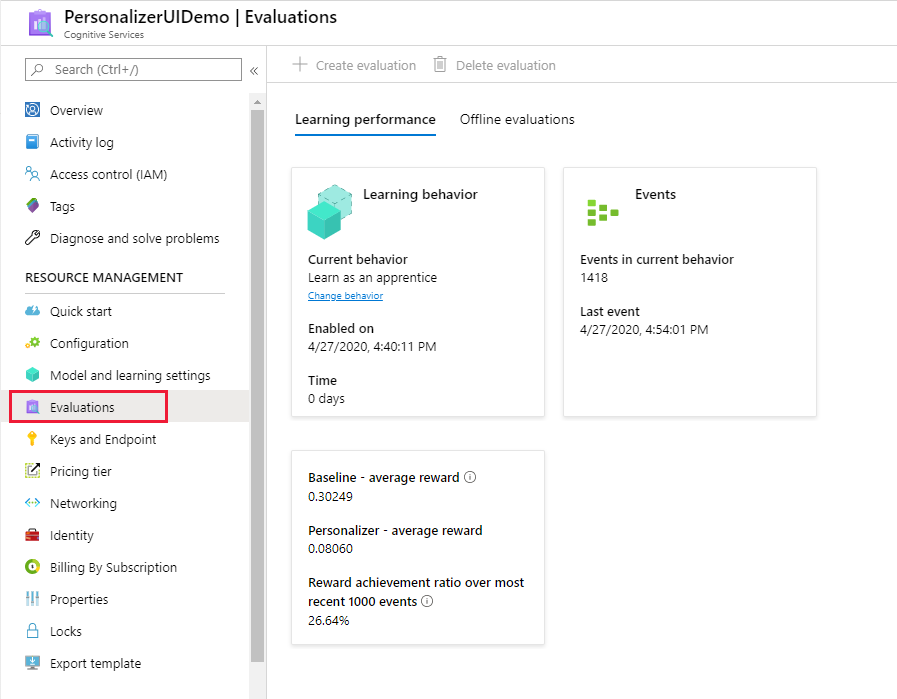

Azure portal の Personalizer リソースに対する [モニター] ページで、[照合パフォーマンス] を確認します。

見習いモードでは、次の評価メトリックが提供されます。

- ベースライン – 平均報酬: アプリケーションの既定値 (ベースライン) の平均報酬。

- Personalizer - 平均報酬: Personalizer で達成している可能性がある報酬合計の平均。

- 最新 1000 イベントでの報酬達成率: ベースライン報酬と Personalizer 報酬の比率 – 最新の 1000 件のイベントで正規化されます。

動作をオンライン モードに切り替える

75-85% のローリング平均で Personalizer がトレーニングされたと判断したら、モデルはオンライン モードに切り替えることができる状態です。

Azure portal で、Personalizer リソースの [設定] ページの [モデルの設定] タブで、[オンライン モード] を選択して、[保存] を選択します。

Rank API と Reward API の呼び出しを変更する必要はありません。