クイック スタート: Azure AI Content Safety Studio

この記事では、Web ブラウザーで Content Safety Studio を使用して、Azure AI Content Safety サービスの利用を開始する方法を説明します。

注意事項

Content Safety Studio で提供されるサンプル コンテンツには、不快なものが含まれているものもあります。 サンプル画像は既定でぼかされています。 ユーザーの裁量が推奨されます。

前提条件

- Azure アカウント。 持っていない場合は、無料で作成できます。

- Content Safety Azure リソース。

- Cognitive Services ユーザー ロールを使用するアカウントに割り当てます。 Azure portal にアクセスして、Content Safety リソースまたは Azure AI サービス リソースに移動し、左側のナビゲーション バーで [アクセス制御] を選んで、[+ ロールの割り当ての追加] を選択して Cognitive Services ユーザー ロールを選び、このロールを割り当てる必要があるアカウントのメンバーを選んだら、確認して割り当てます。 割り当てが有効となるまで、数分かかる場合があります。

- Azure サブスクリプションと Content Safety リソースを使って Content Safety Studio にサインインします。

重要

Studio エクスペリエンスの利用には、Cognitive Services ユーザー ロールを Azure アカウントに割り当てる必要があります。 Azure portal にアクセスして、Content Safety リソースまたは Azure AI サービス リソースに移動し、左側のナビゲーション バーで [アクセス制御] を選んで、[+ ロールの割り当ての追加] を選択して Cognitive Services ユーザー ロールを選び、このロールを割り当てる必要があるアカウントのメンバーを選んだら、確認して割り当てます。 割り当てが有効になるまで、数分かかる場合があります。

テキスト コンテンツの分析

[Moderate text content] (テキスト コンテンツのモデレート) ページでは、テキスト モデレーションをすぐに試すことができます。

![[Analyze Text] (テキストの分析) パネルのスクリーンショット。](media/analyze-text.png)

- [Moderate text content] (テキスト コンテンツのモデレート) パネルを選びます。

- 入力フィールドにテキストを追加するか、ページ上のパネルからサンプル テキストを選びます。

ヒント

テキストのサイズと細分性: 最大テキスト長の制限については、「入力要件」を参照してください。

- [テストの実行] を選択します。

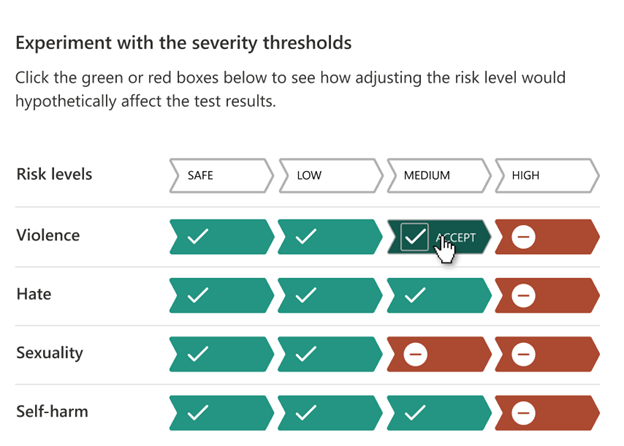

このサービスでは、検出されたすべてのカテゴリと、それぞれの重大度レベル (0 - 安全、2 - 低、4 - 中、6 - 高) が返されます。 また、構成したフィルターに基づいて、バイナリ Accepted/Rejected の結果も返されます。 [フィルターの構成] タブのマトリックスを使って、各カテゴリごとに許容される、または禁止される重大度レベルを設定します。 次に、テキストをもう一度実行すると、フィルターの効果を確認できます。

[Use blocklist] (ブロックリストの使用) タブでは、ブロックリストの作成、編集、モデレーション ワークフローへの追加を行うことができます。 テストの実行時にブロックリストを有効にしている場合、[結果] の下に [Blocklist detection] (ブロックリストの検出) パネルが表示されます。 ブロックリストと一致するものがあれば報告されます。

ユーザー入力攻撃を検出する

[プロンプト シールド] パネルでは、ユーザー入力のリスク検出を試すことができます。 システム メッセージに設定されたルールを回避または破るようにトレーニングされた動作を生成 AI モデルに示させる目的で設計されたユーザー プロンプトを検出します。 こうした攻撃は、複雑なロールプレイから安全目標の巧妙な裏切りまで、さまざまです。

![[プロンプト シールド] パネルが選択されている Content Safety Studio のスクリーンショット。](media/prompt-shields.png)

- [プロンプト シールド] パネルを選択します。

- ページ上のサンプル テキストを選択するか、テスト用に独自のコンテンツを入力します。 CSV ファイルをアップロードしてバッチ テストを実行することもできます。

- テストの実行を選択します。

サービスによって各サンプルのリスク フラグと種類が返されます。

詳細については、『Prompt Shields conceptual guide (プロンプト シールドの概念ガイド)』を参照してください。

イメージ コンテンツの分析

[Moderate image content] (画像コンテンツのモデレート) ページでは、画像モデレーションをすぐに試すことができます。

![[画像の分析] パネルのスクリーンショット。](media/analyze-image.png)

- [Moderate image content] (画像コンテンツのモデレート) パネルを選びます。

- ページ上のパネルからサンプル画像を選ぶか、独自の画像をアップロードします。 画像送信の最大サイズは 4 MB で、画像の寸法は 50 x 50 ピクセルから 2,048 x 2,048 ピクセルの間である必要があります。 画像は、JPEG、PNG、GIF、BMP、TIFF、または WEBP 形式を使用できます。

- [テストの実行] を選択します。

このサービスでは、検出されたすべてのカテゴリと、それぞれの重大度レベル (0 - 安全、2 - 低、4 - 中、6 - 高) が返されます。 また、構成したフィルターに基づいて、バイナリ Accepted/Rejected の結果も返されます。 右側の [フィルターの構成] タブのマトリックスを使って、各カテゴリの許容または禁止される重大度レベルを設定します。 次に、テキストをもう一度実行すると、フィルターの効果を確認できます。

コードの表示とエクスポート

[Analyze text content] (テキスト コンテンツの分析) または [Analyze image content] (画像コンテンツの分析) ページのいずれかで [コードの表示] 機能を使うと、サンプル コードを表示しコピーすることができます。サンプル コードには重大度フィルター、ブロックリスト、モデレーション機能の構成などが含まれます。 次に、このコードを自分側に展開できます。

![[コードの表示] ウィンドウのスクリーンショット。](media/view-code.png)

オンライン アクティビティを監視する

[Monitor online activity] (オンライン アクティビティの監視) パネルでは、API の使用状況や傾向が表示されます。

![[監視] パネルのスクリーンショット。](media/monitor.png)

監視する [メディアの種類] を選ぶことができます。 また、[次に指定する直近の期間のデータを表示する: __] を選ぶことで、確認する時間の範囲を指定できます。

[Reject rate per category] (カテゴリごとの拒否率) グラフでは、カテゴリごとの重大度のしきい値を調整することもできます。

また、一部の用語を変更する場合は、[Top 10 blocked terms] (上位 10 個のブロック済み用語) グラフに基づいてブロックリストを編集できます。

リソースを管理する

名前や価格レベルなどのリソースの詳細を表示するには、Content Safety Studio ホーム ページの右上にある [設定] アイコンを選び、[リソース] タブを選びます。他のリソースがある場合は、ここでリソースを切り替えることもできます。

![[リソースの管理] のスクリーンショット。](media/manage-resource.png)

リソースをクリーンアップする

Azure AI サービス リソースをクリーンアップして削除したい場合は、リソースまたはリソース グループを削除することができます。 リソース グループを削除すると、それに関連付けられている他のリソースも削除されます。

次のステップ

次に、REST API またはクライアント SDK を介して Azure AI Content Safety を使用し、サービスをアプリケーションにシームレスに統合できるようにします。