Apache Flink® DataStream API で Hive メタストアを使用する

Note

Azure HDInsight on AKS は 2025 年 1 月 31 日に廃止されます。 2025 年 1 月 31 日より前に、ワークロードを Microsoft Fabric または同等の Azure 製品に移行することで、ワークロードの突然の終了を回避する必要があります。 サブスクリプション上に残っているクラスターは停止され、ホストから削除されることになります。

提供終了日までは基本サポートのみが利用できます。

重要

現在、この機能はプレビュー段階にあります。 ベータ版、プレビュー版、または一般提供としてまだリリースされていない Azure の機能に適用されるその他の法律条項については、「Microsoft Azure プレビューの追加の使用条件」に記載されています。 この特定のプレビューについては、「Microsoft HDInsight on AKS のプレビュー情報」を参照してください。 質問や機能の提案については、詳細を記載した要求を AskHDInsight で送信してください。また、その他の更新については、Azure HDInsight コミュニティのフォローをお願いいたします。

長年にわたり、Hive メタストアは Hadoop エコシステムの事実上のメタデータ センターに進化してきました。 多くの企業は、すべてのメタデータ (Hive または Hive 以外のメタデータ) を管理するために、運用環境に個別の Hive メタストア サービス インスタンスを保有しています。 Hive と Flink の両方のデプロイを持つユーザーの場合は、HiveCatalog により Hive メタストアを使用して Flink のメタデータを管理できます。

HDInsight on AKS 上の Apache Flink クラスターでサポートされている Hive バージョン

サポートされている Hive バージョン:

- 3.1

- 3.1.0

- 3.1.1

- 3.1.2

- 3.1.3

独自のプログラムをビルドしている場合は、mvn ファイルに次の依存関係が必要です。 結果の jar ファイルにこれらの依存関係を含めることは推奨されません。 実行時に依存関係を追加する必要があります。

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-table-api-java-bridge -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-api-java-bridge</artifactId>

<version>${flink.version}</version>

<scope>provided</scope>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-connector-hive -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-hive_2.12</artifactId>

<version>${flink.version}</version>

<scope>provided</scope>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-table-planner -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table-planner_2.12</artifactId>

<version>${flink.version}</version>

<scope>provided</scope>

</dependency>

Hive に接続する

この例では、HDInsight on AKS 上の Apache Flink を使用して、ハイブに接続するさまざまなスニペットを示しています。Hive メタストアに接続するには、ハイブ構成ディレクトリとして /opt/hive-conf を使用する必要があります

package contoso.example;

import org.apache.flink.streaming.api.TimeCharacteristic;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

import org.apache.flink.table.catalog.hive.HiveCatalog;

public class hiveDemo {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// start Table Environment

StreamTableEnvironment tableEnv =

StreamTableEnvironment.create(env);

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime);

String catalogName = "myhive";

String defaultDatabase = HiveCatalog.DEFAULT_DB;

String hiveConfDir = "/opt/hive-conf";

HiveCatalog hive = new HiveCatalog(catalogName, defaultDatabase, hiveConfDir);

// register HiveCatalog in the tableEnv

tableEnv.registerCatalog("myhive", hive);

// set the HiveCatalog as the current catalog of the session

tableEnv.useCatalog("myhive");

// Create a table in hive catalog

tableEnv.executeSql("create table MyTable (name varchar(32), age int) with ('connector' = 'filesystem', 'path' = 'abfs://flink@contosogen2.dfs.core.windows.net/data/', 'format' = 'csv','csv.field-delimiter' = ',')");

// Create a view in hive catalog

tableEnv.executeSql("create view MyView as select * from MyTable");

// Read from the table and print the results

tableEnv.from("MyTable").execute().print();

// 4. run stream

env.execute("Hive Demo on Flink");

}

}

Webssh ポッドで、planner jar を移動します

webssh ポッドの /opt to /lib にある jar flink-table-planner-loader-1.17.0-*.*.*.jar を移動し、jar flink-table-planner-loader-1.17.0-*.*.*.jar を lib から移動します。 詳細については、問題に関するページを参照してください。 planner jar を移動するには、次の手順を実行します。

mv /opt/flink-webssh/lib/flink-table-planner-loader-1.17.0-1.1.8.jar /opt/flink-webssh/opt/

mv /opt/flink-webssh/opt/flink-table-planner_2.12-1.17.0-1.1.8.jar /opt/flink-webssh/lib/

Note

追加の planner jar の移動は、Hive 言語または HiveServer2 エンドポイントを使用する場合にのみ必要です。 ただし、これは Hive 統合のための推奨セットアップです。

詳細については、「HDInsight on AKS の Apache Flink® で Hive カタログを使用する方法」を参照してください。

jar をパッケージ化して Webssh にアップロードして実行する

user@sshnode-0 [ ~ ]$ bin/flink run -c contoso.example.hiveDemo -j FlinkSQLServerCDCDemo-1.0-SNAPSHOT.jar

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/opt/flink-webssh/lib/log4j-slf4j-impl-2.17.1.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/opt/hadoop/flink-hadoop-dep-1.17.0-1.1.8.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

Job has been submitted with JobID 5c887e1f8e1bfac501168c439a83788f

+----+--------------------------------+-------------+

| op | name | age |

+----+--------------------------------+-------------+

| +I | Jack | 18 |

| +I | mike | 24 |

+----+--------------------------------+-------------+

2 rows in set

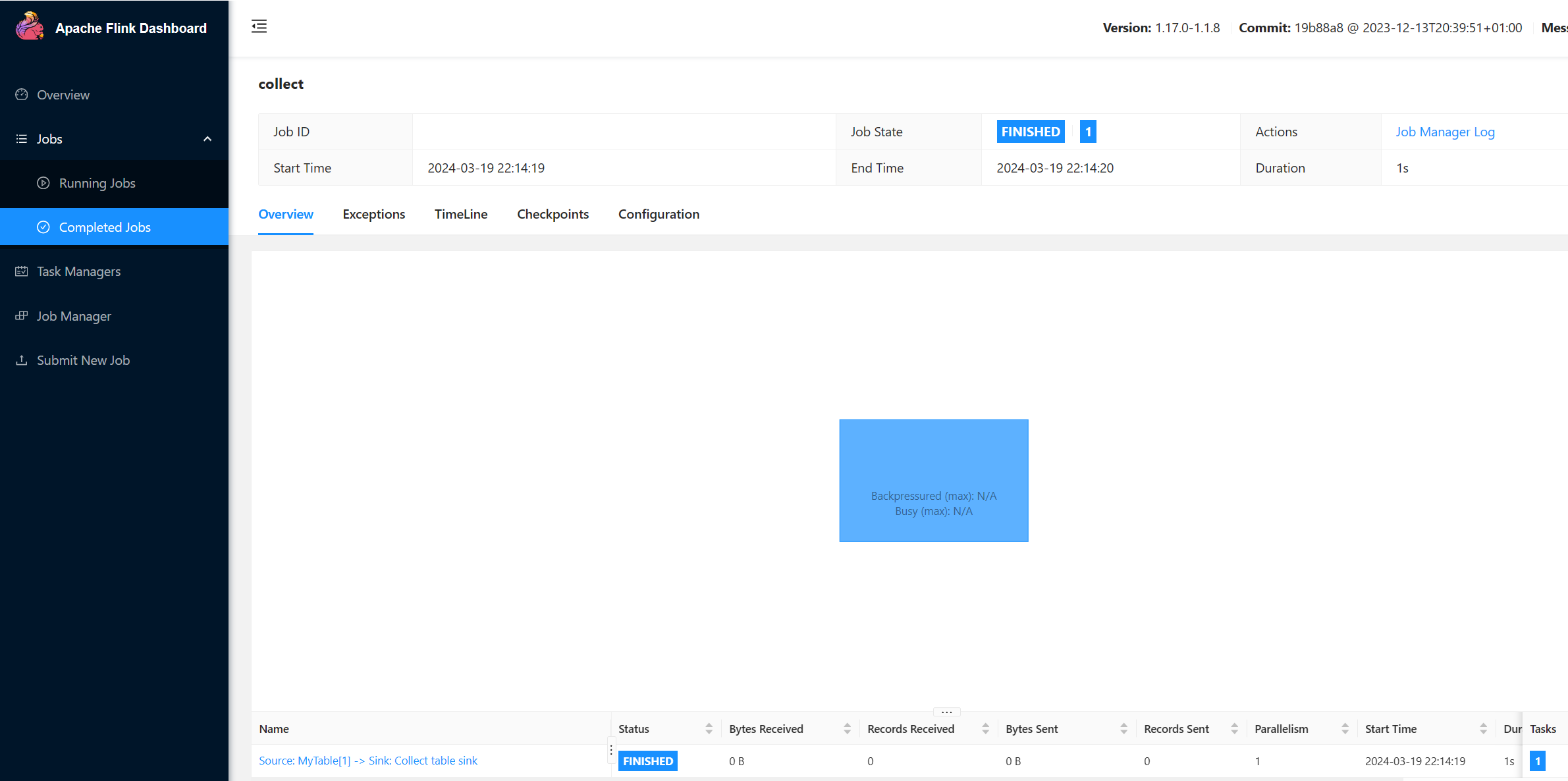

Flink UI で実行されている JOB を確認する

sql-client.sh を使用して Webssh UI のテーブルを確認する

user@sshnode-0 [ ~ ]$ bin/sql-client.sh

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/opt/flink-webssh/lib/log4j-slf4j-impl-2.17.1.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/opt/hadoop/flink-hadoop-dep-1.17.0-1.1.8.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

????????

????????????????

??????? ??????? ?

???? ????????? ?????

??? ??????? ?????

??? ??? ?????

?? ???????????????

?? ? ??? ?????? ?????

????? ???? ????? ?????

??????? ??? ??????? ???

????????? ?? ?? ??????????

???????? ?? ? ?? ???????

???? ??? ? ?? ???????? ?????

???? ? ?? ? ?? ???????? ???? ??

???? ???? ?????????? ??? ?? ????

???? ?? ??? ??????????? ???? ? ? ???

??? ?? ??? ????????? ???? ???

?? ? ??????? ???????? ??? ??

??? ??? ???????????????????? ???? ?

????? ??? ?????? ???????? ???? ??

???????? ??????????????? ??

?? ???? ??????? ??? ?????? ?? ???

??? ??? ??? ??????? ???? ?????????????

??? ????? ???? ?? ?? ???? ???

?? ??? ? ?? ?? ??

?? ?? ?? ?? ????????

?? ????? ?? ??????????? ??

?? ???? ? ??????? ??

??? ????? ?? ???????????

???? ???? ??????? ????????

????? ?? ???? ?????

????????????????????????????????? ?????

______ _ _ _ _____ ____ _ _____ _ _ _ BETA

| ____| (_) | | / ____|/ __ \| | / ____| (_) | |

| |__ | |_ _ __ | | __ | (___ | | | | | | | | |_ ___ _ __ | |_

| __| | | | '_ \| |/ / \___ \| | | | | | | | | |/ _ \ '_ \| __|

| | | | | | | | < ____) | |__| | |____ | |____| | | __/ | | | |_

|_| |_|_|_| |_|_|\_\ |_____/ \___\_\______| \_____|_|_|\___|_| |_|\__|

Welcome! Enter 'HELP;' to list all available commands. 'QUIT;' to exit.

Command history file path: /home/xcao/.flink-sql-history

Flink SQL> CREATE CATALOG myhive WITH (

> 'type' = 'hive'

> );

[INFO] Execute statement succeed.

Flink SQL> USE CATALOG myhive;

[INFO] Execute statement succeed.

Flink SQL> show tables

> ;

+------------+

| table name |

+------------+

| mytable |

| myview |

+------------+

2 rows in set

Flink SQL> SET 'sql-client.execution.result-mode' = 'tableau';

[INFO] Execute statement succeed.

Flink SQL> select * from mytable;

+----+--------------------------------+-------------+

| op | name | age |

+----+--------------------------------+-------------+

| +I | Jack | 18 |

| +I | mike | 24 |

+----+--------------------------------+-------------+

Received a total of 2 rows

関連情報

- Hive の読み取りと書き込み

- Apache、Apache Hive、Hive、Apache Flink、Flink、関連するオープン ソース プロジェクト名は、Apache Software Foundation (ASF) の商標です。