Pianificazione della capacità per Active Directory Domain Services

Questo articolo fornisce raccomandazioni per la pianificazione della capacità per Dominio di Active Directory Services (AD DS).

Obiettivi della pianificazione della capacità

La pianificazione della capacità non equivale alla risoluzione degli eventi imprevisti delle prestazioni. Gli obiettivi della pianificazione della capacità sono:

- Implementare e gestire correttamente un ambiente.

- Ridurre al minimo il tempo impiegato per la risoluzione dei problemi di prestazioni.

Nella pianificazione della capacità, un'organizzazione potrebbe avere un obiettivo di base dell'utilizzo del 40% del processore durante i periodi di picco per soddisfare i requisiti di prestazioni del client e fornire tempo sufficiente per aggiornare l'hardware nel data center. Nel frattempo, impostano la soglia di avviso di monitoraggio per i problemi di prestazioni al 90% in un intervallo di cinque minuti.

Quando si supera continuamente la soglia di gestione della capacità, aggiungere processori più o più veloci per aumentare la capacità o ridimensionare il servizio tra più server sarebbe una soluzione. Le soglie di avviso delle prestazioni consentono di sapere quando è necessario intervenire immediatamente quando i problemi di prestazioni influiscono negativamente sull'esperienza client. Al contrario, una soluzione di risoluzione dei problemi sarebbe più preoccupata per affrontare gli eventi monouso.

La gestione della capacità è simile alle misure preventive da adottare per evitare un incidente stradale, ad esempio la guida difensiva, assicurandosi che i freni funzionino correttamente e così via. La risoluzione dei problemi relativi alle prestazioni è più simile a quando la polizia, il reparto antincendio e i professionisti medici di emergenza rispondono a un incidente.

Negli ultimi anni, le indicazioni per la pianificazione della capacità dei sistemi a scalabilità verticale sono cambiate radicalmente. Le modifiche seguenti nelle architetture di sistema sfidano i presupposti fondamentali relativi alla progettazione e alla scalabilità di un servizio:

- Piattaforme server a 64 bit

- Virtualizzazione

- Maggiore attenzione al consumo di energia elettrica

- Archiviazione SSD

- Scenari cloud

L'approccio alla pianificazione della capacità passa anche dagli esercizi di pianificazione basata su server a quelli basati sul servizio. Dominio di Active Directory Services (AD DS), un servizio distribuito maturo che molti prodotti Microsoft e di terze parti usano come back-end, sono ora uno dei prodotti più critici per garantire che le altre applicazioni abbiano la capacità necessaria per l'esecuzione.

Informazioni importanti da considerare prima di iniziare la pianificazione

Per sfruttare al meglio questo articolo, è necessario eseguire le operazioni seguenti:

- Assicurarsi di aver letto e compreso le linee guida per l'ottimizzazione delle prestazioni per Windows Server 2012 R2.

- Comprendere che la piattaforma Windows Server è un'architettura basata su x64. Inoltre, è necessario comprendere che le linee guida di questo articolo si applicano ancora anche se l'ambiente Active Directory è installato in Windows Server 2003 x86 (ora oltre la fine del ciclo di vita del supporto) e ha un albero delle informazioni di directory (DIT) inferiore a 1,5 GB e può essere facilmente archiviato in memoria.

- Comprendere che la pianificazione della capacità è un processo continuo, quindi è consigliabile esaminare regolarmente il livello di compilazione dell'ambiente in base alle proprie aspettative.

- Comprendere che l'ottimizzazione si verifica su più cicli di vita hardware man mano che cambiano i costi hardware. Ad esempio, se la memoria diventa più economica, il costo per core diminuisce o il prezzo delle diverse opzioni di archiviazione cambia.

- Pianificare il periodo di punta occupato di ogni giorno. È consigliabile impostare i piani in base a intervalli di 30 minuti o ore. Gli intervalli maggiori di un'ora possono nascondere quando il servizio raggiunge effettivamente la capacità massima e gli intervalli inferiori a 30 minuti possono fornire informazioni imprecise che rendono gli aumenti temporanei più importanti di quanto siano effettivamente.

- Pianificare la crescita nel corso del ciclo di vita dell'hardware per l'azienda. Questa pianificazione può includere strategie per l'aggiornamento o l'aggiunta di hardware in modo sfalsato o un aggiornamento completo ogni tre o cinque anni. Ogni piano di crescita richiede una stima della quantità di carico in Active Directory. I dati cronologici consentono di eseguire una valutazione più accurata.

- Pianificare la tolleranza di errore. Dopo aver derivato la stima N, pianificare gli scenari che includono N - 1, N - 2 e N - x.

In base al piano di crescita, aggiungere server aggiuntivi in base alla necessità dell'organizzazione di assicurarsi che la perdita di uno o più server non causi il superamento delle stime massime della capacità massima del sistema.

Tenere presente anche che è necessario integrare i piani di crescita e tolleranza di errore. Ad esempio, se si sa che la distribuzione richiede attualmente un controller di dominio (DC) per supportare il carico, ma la stima indica che il carico raddoppierà nel prossimo anno e richiede il trasporto di due controller di dominio, il sistema non ha capacità sufficiente per supportare la tolleranza di errore. Per evitare questa mancanza di capacità, è consigliabile invece pianificare l'avvio con tre controller di dominio. Se il budget non consente tre controller di dominio, è anche possibile iniziare con due controller di dominio, quindi pianificare l'aggiunta di un terzo dopo tre o sei mesi.

Nota

L'aggiunta di applicazioni compatibili con Active Directory potrebbe avere un impatto notevole sul carico del controller di dominio, indipendentemente dal fatto che il carico provenga dai server dell'applicazione o dai client.

Ciclo di pianificazione della capacità in tre parti

Prima di iniziare il ciclo di pianificazione, è necessario decidere la qualità del servizio richiesta dall'organizzazione. Tutte le indicazioni e le indicazioni contenute in questo articolo sono per ambienti di prestazioni ottimali. Tuttavia, è possibile rilassarli in modo selettivo nei casi in cui non è necessaria l'ottimizzazione. Ad esempio, se l'organizzazione richiede un livello di concorrenza superiore e un'esperienza utente più coerente, è consigliabile esaminare la configurazione di un data center. I data center consentono di prestare maggiore attenzione alla ridondanza e ridurre al minimo i colli di bottiglia del sistema e dell'infrastruttura. Al contrario, se si pianifica una distribuzione per un ufficio satellite con solo pochi utenti, non è necessario preoccuparsi tanto dell'ottimizzazione hardware e dell'infrastruttura, che consente di scegliere opzioni a basso costo.

Successivamente, è necessario decidere se usare macchine virtuali o fisiche. Dal punto di vista della pianificazione della capacità, non c'è risposta corretta o sbagliata. È tuttavia necessario tenere presente che ogni scenario offre un set diverso di variabili da usare.

Gli scenari di virtualizzazione offrono due opzioni:

- Mapping diretto, in cui è disponibile un solo guest per host.

- Scenari di host condivisi, in cui sono presenti più guest per host.

È possibile gestire scenari di mapping diretto in modo identico agli host fisici. Se si sceglie uno scenario host condiviso, vengono introdotte altre variabili da prendere in considerazione nelle sezioni successive. Gli host condivisi competono anche per le risorse con servizi di Dominio di Active Directory (AD DS), che possono influire sulle prestazioni del sistema e sull'esperienza utente.

Ora che abbiamo risposto a queste domande, esaminiamo il ciclo di pianificazione della capacità stesso. Ogni ciclo di pianificazione della capacità prevede un processo in tre passaggi:

- Misurare l'ambiente esistente, determinare dove sono attualmente presenti i colli di bottiglia del sistema e ottenere le nozioni di base ambientali necessarie per pianificare la quantità di capacità necessaria per la distribuzione.

- Determinare l'hardware necessario in base ai requisiti di capacità.

- Monitorare e verificare che l'infrastruttura configurata funzioni entro le specifiche. I dati raccolti in questo passaggio diventano la baseline per il ciclo successivo di pianificazione della capacità.

Applicazione del processo

Per ottimizzare le prestazioni, assicurarsi che i componenti principali seguenti siano selezionati correttamente e ottimizzati per il caricamento dell'applicazione:

- Memoria

- Network

- Archiviazione

- Processore

- Accesso rete

I requisiti di archiviazione di base per Servizi di dominio Active Directory e il comportamento generale del software client compatibile consentono agli ambienti con un massimo di 10.000-20.000 utenti di ignorare la pianificazione della capacità per l'hardware fisico, perché la maggior parte dei sistemi moderni di classe server può già gestire un carico di tale dimensione. Tuttavia, le tabelle nelle tabelle di riepilogo raccolta dati illustrano come valutare l'ambiente esistente per selezionare l'hardware corretto. Le sezioni successive illustrano in dettaglio le raccomandazioni di base e i principi specifici dell'ambiente per l'hardware per aiutare gli amministratori di Active Directory Domain Services a valutare l'infrastruttura.

Altre informazioni da tenere presenti durante la pianificazione:

- Qualsiasi dimensionamento basato sui dati correnti è accurato solo per l'ambiente corrente.

- Quando si effettuano stime, si prevede che la domanda cresce nel ciclo di vita dell'hardware.

- Supportare la crescita futura determinando se è necessario sovradimensionare l'ambiente oggi o aggiungere gradualmente capacità nel corso del ciclo di vita.

- Tutti i principi e le metodologie di pianificazione della capacità che si applicano a una distribuzione fisica si applicano anche a una distribuzione virtualizzata. Tuttavia, quando si pianifica un ambiente virtualizzato, è necessario ricordare di aggiungere il sovraccarico di virtualizzazione a qualsiasi pianificazione o stima correlata al dominio.

- La pianificazione della capacità è una stima, non un valore perfettamente corretto, quindi non aspettarsi che sia perfettamente accurata. Ricordarsi sempre di regolare la capacità in base alle esigenze e verificare costantemente che l'ambiente funzioni come previsto.

Tabelle di riepilogo della raccolta dati

Le tabelle seguenti elencano e illustrano i criteri per determinare le stime hardware.

Ambiente di lavoro

| Componente | Stime |

|---|---|

| Dimensioni dello spazio di archiviazione/database | Da 40 kB a 60 kB per ogni utente |

| RAM | Dimensioni del database Indicazioni relative al sistema operativo di base Applicazioni di terze parti |

| Network | 1 GB |

| CPU | 1.000 utenti simultanei per ogni core |

Criteri di valutazione di alto livello

| Componente | Criteri di valutazione | Considerazioni sulla pianificazione |

|---|---|---|

| Dimensioni di archiviazione/database | Deframmentazione offline | |

| Prestazioni di archiviazione/database |

|

|

| RAM |

|

|

| Network |

|

|

| CPU |

|

|

| Accesso rete |

|

|

Pianificazione

Per molto tempo, il solito consiglio per il dimensionamento di Servizi di dominio Active Directory era quello di inserire la RAM come le dimensioni del database. Ora che gli ambienti di Active Directory Domain Services e l'ecosistema che li utilizza sono cresciuti molto più grandi, le cose sono cambiate. Anche se l'aumento della potenza di calcolo e il passaggio dall'architettura x86 alla x64 hanno reso aspetti più sottili del dimensionamento per le prestazioni irrilevanti per i clienti che eseguono Servizi di dominio Active Directory nei computer fisici, la virtualizzazione ha reso un problema molto più grande.

Per risolvere tali problemi, le sezioni seguenti descrivono come determinare e pianificare le richieste di Active Directory as a Service. È possibile applicare queste linee guida a qualsiasi ambiente indipendentemente dal fatto che l'ambiente sia fisico, virtualizzato o misto. Per ottimizzare le prestazioni, l'obiettivo deve essere quello di ottenere l'ambiente di Active Directory Domain Services il più vicino possibile al processore.

RAM

Maggiore è la quantità di spazio di archiviazione che è possibile memorizzare nella cache nella RAM, minore è la necessità di passare al disco. Per ottimizzare la scalabilità del server, la quantità minima di RAM usata deve essere uguale alla somma delle dimensioni correnti del database, del valore totale del sistema, della quantità consigliata per il sistema operativo e dei consigli del fornitore per gli agenti (programmi antivirus, monitoraggio, backup e così via). È anche necessario includere ram aggiuntive per supportare la crescita futura nel corso della durata del server. Questa stima cambierà in base alla crescita del database e ai cambiamenti ambientali.

Per gli ambienti in cui l'ottimizzazione della RAM non è conveniente o non verificabile, ad esempio posizioni satellite o quando l'albero delle informazioni directory (DIT) è troppo grande, passare a Archiviazione per assicurarsi che l'archiviazione sia configurata correttamente.

Un'altra cosa importante da considerare per il dimensionamento della memoria è il ridimensionamento del file di pagina. Nel dimensionamento dei dischi, come tutto il resto correlato alla memoria, l'obiettivo è ridurre al minimo l'utilizzo del disco. In particolare, quanto RAM è necessario ridurre al minimo il paging? Le sezioni successive dovrebbero fornire le informazioni necessarie per rispondere a questa domanda. Altre considerazioni relative alle dimensioni delle pagine che non influiscono necessariamente sulle prestazioni di Servizi di dominio Active Directory sono le raccomandazioni del sistema operativo e la configurazione del sistema per i dump della memoria.

Determinare la quantità di RAM necessaria per un controller di dominio può essere difficile a causa di molti fattori complessi:

- I sistemi esistenti non sono sempre indicatori affidabili dei requisiti di RAM perché il servizio LSSAS (Local Security Authority Subsystem Service) taglia la RAM in condizioni di pressione della memoria, gonfiando artificialmente i requisiti.

- I singoli controller di dominio devono memorizzare nella cache solo i dati a cui sono interessati i client. Ciò significa che i dati memorizzati nella cache in ambienti diversi cambieranno a seconda dei tipi di client in esso contenuti. Ad esempio, un controller di dominio in un ambiente con Exchange Server raccoglierà dati diversi rispetto a un controller di dominio che autentica solo gli utenti.

- La quantità di lavoro necessaria per valutare la RAM per ogni controller di dominio caso per caso è spesso eccessiva e cambia man mano che l'ambiente cambia.

I criteri alla base delle raccomandazioni consentono di prendere decisioni più informate:

- Più si memorizza nella cache nella RAM, meno è necessario passare al disco.

- L'archiviazione è il componente più lento di un computer. L'accesso ai dati su supporti di archiviazione basati su spindle e SSD è un milione volte più lento rispetto all'accesso ai dati nella RAM.

Considerazioni sulla virtualizzazione della RAM

L'obiettivo dell'ottimizzazione della RAM è ridurre al minimo la quantità di tempo impiegato per passare al disco. È anche consigliabile evitare il over-commit della memoria nell'host. Negli scenari di virtualizzazione, il over-commit della memoria è quando il sistema alloca più RAM ai guest rispetto a quelli esistenti nel computer fisico stesso. Anche se il commit eccessivo non è un problema da solo, quando la memoria totale usata da tutti i guest supera la funzionalità della RAM dell'host, fa sì che l'host venga visualizzato nella pagina. Il paging rende il disco associato alle prestazioni nei casi in cui il controller di dominio passa al file NTDS.nit o di pagina per ottenere dati o l'host passa al disco per provare ad accedere ai dati della RAM. Di conseguenza, questo processo riduce notevolmente le prestazioni e l'esperienza utente complessiva.

Esempio di riepilogo del calcolo

| Componente | Memoria stimata (esempio) |

|---|---|

| RAM consigliata per il sistema operativo di base (Windows Server 2008) | 2 GB |

| Attività interne LSASS | 200 MB |

| Agente di monitoraggio | 100 MB |

| Antivirus | 100 MB |

| Database (Catalogo globale) | 8,5 GB |

| Cuscino per l'esecuzione del backup, accesso degli amministratori senza impatto | 1 GB |

| Totali | 12 GB |

Consigliata: 16 GB

Nel corso del tempo vengono aggiunti più dati al database e la durata media del server è di circa tre o cinque anni. In base a una stima di crescita del 333%, 16 GB è una quantità ragionevole di RAM da inserire in un server fisico.

Rete

Questa sezione descrive la valutazione della larghezza di banda totale e della capacità di rete necessarie per la distribuzione, incluse le query client, le impostazioni di Criteri di gruppo e così via. È possibile raccogliere dati per eseguire la stima usando i Network Interface(*)\Bytes Received/sec contatori delle prestazioni e Network Interface(*)\Bytes Sent/sec . Gli intervalli di esempio per i contatori dell'interfaccia di rete devono essere 15, 30 o 60 minuti. Qualsiasi cosa meno sarà troppo volatile per le misurazioni buone, e qualsiasi cosa più grande sarà eccessivamente smussare i picchi giornalieri.

Nota

In genere, la maggior parte del traffico di rete su un controller di dominio è in uscita, poiché il controller di dominio risponde alle richieste client. Di conseguenza, questa sezione si concentra principalmente sul traffico in uscita. Tuttavia, è anche consigliabile valutare ogni ambiente per il traffico in ingresso. È possibile usare le linee guida in questo articolo per valutare anche i requisiti del traffico di rete in ingresso. Per altre informazioni, vedere 929851: L'intervallo di porte dinamiche predefinito per TCP/IP è cambiato in Windows Vista e in Windows Server 2008.

Esigenze di larghezza di banda

La pianificazione della scalabilità della rete riguarda due categorie distinte: la quantità di traffico e il carico della CPU dovuto al traffico di rete.

Quando si pianifica la capacità per il supporto del traffico, è necessario tenere conto di due aspetti. Prima di tutto, è necessario conoscere la quantità di traffico di replica di Active Directory tra i controller di dominio. In secondo luogo, è necessario valutare il traffico tra client e server all'interno del sito. Il traffico intrasito riceve principalmente richieste di piccole dimensioni dai client relativamente alle grandi quantità di dati che invia ai client. 100 MB è in genere sufficiente per gli ambienti con un massimo di 5.000 utenti per server. Per gli ambienti di oltre 5.000 utenti, è consigliabile usare invece una scheda di rete da 1 GB e il supporto rss (Receive Side Scaling).

Per valutare la capacità del traffico intrasito, in particolare negli scenari di consolidamento dei server, è necessario esaminare il Network Interface(*)\Bytes/sec contatore delle prestazioni in tutti i controller di dominio di un sito, aggiungerli insieme, quindi dividere la somma per il numero di controller di dominio di destinazione. Un modo semplice per calcolare questo numero consiste nell'aprire l'affidabilità di Windows e Monitor prestazioni ed esaminare la visualizzazione Area in pila. Assicurarsi che tutti i contatori siano ridimensionati allo stesso modo.

Di seguito viene illustrato un esempio di modo più complesso per verificare che questa regola generale si applichi a un ambiente specifico. In questo esempio vengono assunti i presupposti seguenti:

- L'obiettivo è ridurre l'ingombro al minor numero possibile di server. Idealmente, un server trasporta il carico, quindi si distribuisce un server aggiuntivo per la ridondanza (n + 1 scenario).

- In questo scenario, la scheda di rete corrente supporta solo 100 MB ed è in un ambiente commutato.

- L'utilizzo massimo della larghezza di banda di rete di destinazione è il 60% in uno scenario n (perdita di un controller di dominio).

- Ogni server è collegato a circa 10.000 client.

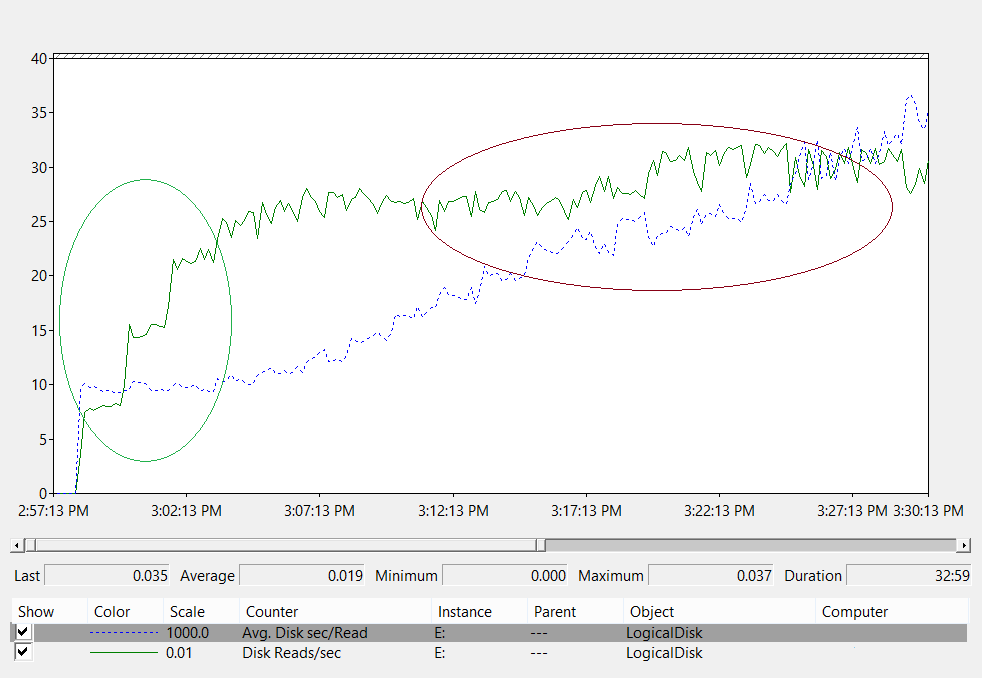

A questo punto, diamo un'occhiata a ciò che il grafico nel Network Interface(*)\Bytes Sent/sec contatore indica questo scenario di esempio:

- Il giorno lavorativo inizia a salire intorno alle 5:30 e si snoda alle 17:00.

- Il periodo più trafficato è compreso tra le 8:00 e le 8:15, con più di 25 byte inviati al secondo nel controller di dominio più trafficato.

Nota

Tutti i dati sulle prestazioni sono cronologici, quindi il punto dati di picco alle 8:15 indica il carico dalle 8:00 alle 8:15.

- Ci sono picchi prima delle 4:00, con più di 20 byte inviati al secondo nel controller di dominio più trafficato, che potrebbe indicare il carico da fusi orari diversi o attività dell'infrastruttura in background, ad esempio i backup. Poiché il picco alle 8:00 supera questa attività, non è rilevante.

- Nel sito sono presenti cinque controller di dominio.

- Il carico massimo è di circa 5,5 MBps per controller di dominio, che rappresenta il 44% della connessione di 100 MB. Usando questi dati, è possibile stimare che la larghezza di banda totale necessaria tra le 8:00 e le 8:15 è di 28 MBps.

Nota

I contatori di invio/ricezione dell'interfaccia di rete sono in byte, ma la larghezza di banda di rete viene misurata in bit. Pertanto, per calcolare la larghezza di banda totale, è necessario eseguire 100 MB ÷ 8 = 12,5 MB e 1 GB ÷ 8 = 128 MB.

Ora che abbiamo esaminato i dati, quali conclusioni possiamo trarre da esso?

- L'ambiente corrente soddisfa il livello n + 1 di tolleranza di errore a un utilizzo di destinazione del 60%. L'uso offline di un sistema sposta la larghezza di banda per server da circa 5,5 MBps (44%) a circa 7 MBps (56%).

- In base all'obiettivo dichiarato in precedenza di consolidare in un server, questa modifica supera l'utilizzo massimo della destinazione e il possibile utilizzo di una connessione di 100 MB.

- Con una connessione da 1 GB, questo valore rappresenta il 22% della capacità totale.

- In condizioni operative normali nello scenario n + 1, il carico client viene distribuito in modo relativamente uniforme a circa 14 MBps per server o al 11% della capacità totale.

- Per assicurarsi di avere una capacità sufficiente mentre un controller di dominio non è disponibile, le normali destinazioni operative per server sarebbero circa il 30% di utilizzo della rete o 38 MBps per server. Le destinazioni di failover sono il 60% dell'utilizzo della rete o 72 MBps per server.

La distribuzione finale del sistema deve avere una scheda di rete da 1 GB e una connessione a un'infrastruttura di rete che supporterà tale carico. A causa della quantità di traffico di rete, il carico della CPU dalle comunicazioni di rete può potenzialmente limitare la scalabilità massima di Servizi di dominio Active Directory. È possibile usare questo stesso processo per stimare la comunicazione in ingresso al controller di dominio. Nella maggior parte degli scenari, tuttavia, non è necessario calcolare il traffico in ingresso perché è più piccolo del traffico in uscita.

È importante assicurarsi che l'hardware supporti RSS in ambienti con oltre 5.000 utenti per server. Per scenari di traffico di rete elevato, il bilanciamento del carico di interrupt può essere un collo di bottiglia. È possibile rilevare potenziali colli di bottiglia controllando il contatore per verificare se il Processor(*)\% Interrupt Time tempo di interruzione è distribuito in modo non uniforme tra LE CPU. I controller di interfaccia di rete abilitati per RSS possono attenuare queste limitazioni e aumentare la scalabilità.

Nota

È possibile adottare un approccio simile per stimare se è necessaria una maggiore capacità quando si consolidano i data center o si ritira un controller di dominio in una posizione satellite. Per stimare la capacità necessaria, è sufficiente esaminare i dati per il traffico in uscita e in ingresso verso i client. Il risultato è la quantità di traffico presente nei collegamenti WAN (Wide Area Network).

In alcuni casi, il traffico potrebbe essere superiore a quello previsto perché il traffico è più lento, ad esempio quando la verifica dei certificati non riesce a rispettare i timeout ripetuti sulla WAN. Per questo motivo, il dimensionamento e l'utilizzo della WAN devono essere effettuati in modo iterativo e continuo.

Considerazioni sulla virtualizzazione per la larghezza di banda della rete

Le raccomandazioni tipiche per un server fisico sono 1 GB per i server che supportano oltre 5.000 utenti. Quando più guest iniziano a condividere un'infrastruttura del commutatore virtuale sottostante, è necessario prestare particolare attenzione a se l'host ha una larghezza di banda di rete adeguata per supportare tutti gli utenti guest nel sistema. È necessario prendere in considerazione la larghezza di banda indipendentemente dal fatto che la rete includa il controller di dominio in esecuzione come macchina virtuale in un host con traffico di rete che passa attraverso un commutatore virtuale o direttamente connesso a un commutatore fisico. I commutatori virtuali sono componenti in cui l'uplink deve supportare la quantità di dati trasmessi dalla connessione, il che significa che la scheda di rete host fisica collegata al commutatore deve essere in grado di supportare il carico del controller di dominio più tutti gli altri guest che condividono il commutatore virtuale connesso alla scheda di rete fisica.

Esempio di riepilogo del calcolo di rete

La tabella seguente contiene valori di uno scenario di esempio che è possibile usare per calcolare la capacità di rete:

| Sistema | Larghezza di banda di picco |

|---|---|

| Controller di dominio 1 | 6,5 MBps |

| Controller di dominio 2 | 6,25 MBps |

| Controller di dominio 3 | 6,25 MBps |

| Controller di dominio 4 | 5,75 MBps |

| Controller di dominio 5 | 4,75 MBps |

| Totale | 28,5 MBps |

In base a questa tabella, la larghezza di banda consigliata sarebbe 72 MBps (28,5 MBps ÷ 40%).

| Numero di sistemi di destinazione | Larghezza di banda totale (dall'alto) |

|---|---|

| 2 | 28,5 MBps |

| Risultato di un comportamento normale | 28,5 ÷ 2 = 14,25 MBps |

Come sempre, è consigliabile presupporre che il carico client aumenterà nel tempo, quindi è consigliabile pianificare questa crescita il prima possibile. È consigliabile pianificare almeno il 50% della crescita stimata del traffico di rete.

Storage

Quando si pianifica la capacità per l'archiviazione, è necessario considerare due aspetti:

- Capacità o dimensioni di archiviazione

- Prestazioni

Anche se la capacità è importante, è importante non trascurare le prestazioni. Con i costi hardware correnti, la maggior parte degli ambienti non è sufficientemente grande perché entrambi i fattori siano un problema importante. Pertanto, il solito consiglio è quello di inserire solo la RAM quanto le dimensioni del database. Tuttavia, questa raccomandazione potrebbe essere eccessiva per le posizioni satellite in ambienti più grandi.

Dimensionamento

Valutazione dell’archiviazione

Rispetto a quando Active Directory è arrivato per la prima volta quando 4 GB e 9 GB di unità erano le dimensioni più comuni delle unità, ora il dimensionamento per Active Directory non è nemmeno una considerazione per tutti gli ambienti, ma per gli ambienti più grandi. Con dischi rigidi di dimensioni ridotte, nell'ordine dei 180 GB, l'intero sistema operativo, SYSVOL e NTDS.dit possono stare facilmente su una singola unità. Di conseguenza, ti consigliamo di evitare di investire troppo pesantemente in quest'area.

È consigliabile assicurarsi che il 110% delle dimensioni NTS.dit sia disponibile in modo da poter deframmentare lo spazio di archiviazione. Oltre a questo, dovresti prendere le normali considerazioni per accogliere la crescita futura.

Se si intende valutare lo spazio di archiviazione, è prima necessario valutare le dimensioni di NTDS.dit e SYSVOL. Queste misurazioni consentono di ridimensionare sia le allocazioni del disco fisso che della RAM. Poiché i componenti sono relativamente bassi, non è necessario essere molto precisi quando si esegue la matematica. Per altre informazioni sulla valutazione dell'archiviazione, vedere Limiti di archiviazione e stime della crescita per utenti e unità organizzative di Active Directory.

Nota

Gli articoli collegati nel paragrafo precedente sono basati sulle stime delle dimensioni dei dati effettuate durante il rilascio di Active Directory in Windows 2000. Quando si effettua una stima personalizzata, usare le dimensioni degli oggetti che riflettono le dimensioni effettive degli oggetti nell'ambiente.

Quando si esaminano gli ambienti esistenti con più domini, è possibile notare variazioni nelle dimensioni del database. Quando si individuano queste varianti, usare le dimensioni del catalogo globale (GC) e non GC più piccole.

Le dimensioni del database possono variare tra le versioni del sistema operativo. I controller di dominio che eseguono versioni precedenti del sistema operativo come Windows Server 2003 hanno dimensioni di database inferiori rispetto a una versione successiva, ad esempio Windows Server 2008 R2. Il controller di dominio con funzionalità come Active Directory REcycle Bin o Credential Roaming abilitato può influire anche sulle dimensioni del database.

Nota

- Per i nuovi ambienti, tenere presente che 100.000 utenti nello stesso dominio utilizzano circa 450 MB di spazio. Gli attributi popolati possono avere un impatto enorme sulla quantità totale di spazio utilizzata. Gli attributi vengono popolati da molti oggetti di prodotti microsoft e di terze parti, tra cui Microsoft Exchange Server e Lync. Di conseguenza, è consigliabile valutare in base al portfolio di prodotti dell'ambiente. Tuttavia, è necessario tenere presente anche che eseguire calcoli matematici e test per stime precise per tutti, ma gli ambienti più grandi potrebbero non valere tempo o sforzo significativi.

- Assicurarsi che lo spazio disponibile sia pari al 110% delle dimensioni NTDS.dit per abilitare la deframmentazione offline. Questo spazio disponibile consente anche di pianificare la crescita nel corso della durata hardware da tre a cinque anni del server. Se si dispone dello spazio di archiviazione per esso, allocare spazio libero sufficiente a uguale al 300% del DIT per l'archiviazione è un modo sicuro per supportare la crescita e la defragging.

Considerazioni sulla virtualizzazione per l’archiviazione

Negli scenari in cui si allocano più file VHD (Virtual Hard Disk) a un singolo volume, è consigliabile usare un disco a stato fisso di almeno il 210% delle dimensioni del DIT (100% dello spazio libero DIT + 110% ) per assicurarsi di disporre di spazio sufficiente riservato per le proprie esigenze.

Esempio di riepilogo del calcolo dell'archiviazione

Nella tabella seguente sono elencati i valori usati per stimare i requisiti di spazio per uno scenario di archiviazione ipotetico.

| Dati raccolti in fase di valutazione | Dimensione |

|---|---|

| Dimensione NTDS.dit | 35 GB |

| Modificatore per consentire la deframmentazione offline | 2,1 GB |

| Archiviazione totale necessaria | 73,5 GB |

Nota

La stima dell'archiviazione deve includere anche la quantità di spazio di archiviazione necessaria per SYSVOL, il sistema operativo, il file di pagina, i file temporanei, i dati memorizzati nella cache locale, ad esempio i file del programma di installazione e le applicazioni.

Prestazioni dell'archiviazione

Essendo il componente più lento di qualsiasi computer, l’archiviazione può avere il maggiore impatto negativo sull'esperienza client. Per gli ambienti sufficientemente grandi che le raccomandazioni di dimensionamento della RAM in questo articolo non sono fattibili, le conseguenze dell'ignorare la pianificazione della capacità per l'archiviazione possono essere devastanti per le prestazioni del sistema. Le complessità e le varietà della tecnologia di archiviazione disponibile aumentano ulteriormente il rischio, in quanto la raccomandazione tipica di inserire il sistema operativo, i log e il database in dischi fisici separati non si applica universalmente in tutti gli scenari.

Le raccomandazioni precedenti sui dischi presupponevano che un disco fosse uno spindle dedicato che consentiva l'I/O isolato. Questo presupposto non è più vero a causa dell'introduzione dei tipi di archiviazione seguenti:

- RAID

- Nuovi tipi di risorse di archiviazione e scenari di archiviazione virtualizzata e condivisa

- Spindle condivisi su una Rete di archiviazione (SAN)

- File VHD su una SAN o su un’archiviazione collegata alla rete

- Unità ssd (SSD)

- Architetture di archiviazione a livelli, ad esempio il livello di archiviazione SSD, la memorizzazione nella cache di archiviazione basata su spindle più grande

L'archiviazione condivisa, ad esempio RAID, SAN, NAS, JBOD, Spazi di archiviazione e VHD, è in grado di essere sovraccaricata da altri carichi di lavoro inseriti nell'archiviazione back-end. Questi tipi di archiviazione presentano anche una sfida aggiuntiva: problemi relativi a SAN, rete o driver tra il disco fisico e l'applicazione AD possono causare limitazioni e ritardi. Per chiarire, queste non sono configurazioni non negative, ma sono più complesse, il che significa che è necessario prestare particolare attenzione per assicurarsi che ogni componente funzioni come previsto. Per spiegazioni più dettagliate, vedere Appendice C e Appendice D più avanti in questo articolo. Inoltre, anche se le unità SSD non sono limitate dai dischi rigidi che possono elaborare un solo I/O alla volta, hanno ancora limitazioni di I/O che possono essere sovraccaricate.

In sintesi, l'obiettivo di tutta la pianificazione delle prestazioni di archiviazione, indipendentemente dall'architettura di archiviazione, consiste nel garantire che il numero di I/O necessario sia sempre disponibile e che si verifichino entro un intervallo di tempo accettabile. Per gli scenari con archiviazione collegata in locale, vedere Appendice C per altre informazioni sulla progettazione e la pianificazione. È possibile applicare i principi nell'appendice a scenari di archiviazione più complessi, nonché conversazioni con i fornitori che supportano le soluzioni di archiviazione back-end.

A causa del numero di opzioni di archiviazione attualmente disponibili, è consigliabile consultare i team di supporto hardware o i fornitori durante la pianificazione per garantire che la soluzione soddisfi le esigenze della distribuzione di Servizi di dominio Active Directory. Durante queste conversazioni, è possibile trovare i contatori delle prestazioni seguenti utili, soprattutto quando il database è troppo grande per la RAM:

LogicalDisk(*)\Avg Disk sec/Read(ad esempio, se NTDS.dit è archiviato nell'unità D, il percorso completo saràLogicalDisk(D:)\Avg Disk sec/Read)LogicalDisk(*)\Avg Disk sec/WriteLogicalDisk(*)\Avg Disk sec/TransferLogicalDisk(*)\Reads/secLogicalDisk(*)\Writes/secLogicalDisk(*)\Transfers/sec

Quando si specificano i dati, assicurarsi che vengano campionati in intervalli di 15, 30 o 60 minuti per offrire l'immagine più accurata dell'ambiente corrente possibile.

Valutazione dei risultati

Questa sezione è incentrata sulle letture dal database, perché il database è in genere il componente più impegnativo. È possibile applicare la stessa logica alle scritture nel file di log sostituendo <NTDS Log>)\Avg Disk sec/Write e LogicalDisk(<NTDS Log>)\Writes/sec).

Il LogicalDisk(<NTDS>)\Avg Disk sec/Read contatore indica se lo spazio di archiviazione corrente è di dimensioni adeguate. Se il valore è approssimativamente uguale al tempo di accesso al disco previsto per il tipo di disco, il LogicalDisk(<NTDS>)\Reads/sec contatore è una misura valida. Se i risultati sono approssimativamente uguali al tempo di accesso al disco per il tipo di disco, il LogicalDisk(<NTDS>)\Reads/sec contatore è una misura valida. Anche se questo può cambiare a seconda delle specifiche del produttore dello spazio di archiviazione back-end, ma gli intervalli validi per LogicalDisk(<NTDS>)\Avg Disk sec/Read sarebbero approssimativamente:

- 7200 rpm: da 9 a 12,5 millisecondi (ms)

- 10.000 rpm: da 6 a 10 ms

- 15.000 rpm: da 4 a 6 ms

- SSD - da 1 a 3 ms

Si potrebbe sentire da altre origini che le prestazioni di archiviazione sono ridotte da 15 ms a 20 ms. La differenza tra questi valori e i valori nell'elenco precedente è che i valori dell'elenco mostrano l'intervallo operativo normale. Gli altri valori sono a scopo di risoluzione dei problemi, che consentono di identificare quando l'esperienza client è danneggiata abbastanza che diventa evidente. Per altre informazioni, vedere Appendice C.

LogicalDisk(<NTDS>)\Reads/secè la quantità di operazioni di I/O attualmente eseguite dal sistema.- Se

LogicalDisk(<NTDS>)\Avg Disk sec/Readè compreso nell'intervallo ottimale per l'archiviazione back-end, è possibile usareLogicalDisk(<NTDS>)\Reads/secdirettamente per ridimensionare l'archiviazione. - Se

LogicalDisk(<NTDS>)\Avg Disk sec/Readnon rientra nell'intervallo ottimale per l'archiviazione back-end, sono necessarie operazioni di I/O aggiuntive in base alla formula seguente:LogicalDisk(<NTDS>)\Avg Disk sec/Read÷ tempo di accesso al disco multimediale fisico ×LogicalDisk(<NTDS>)\Avg Disk sec/Read

- Se

Quando si eseguono questi calcoli, ecco alcuni aspetti da considerare:

- Se il server ha una quantità di RAM non ottimale, i valori risultanti saranno troppo alti e non saranno sufficientemente accurati da essere utili per la pianificazione. Tuttavia, è comunque possibile usarli per prevedere scenari peggiori.

- Se si aggiunge o si ottimizza la RAM, si riduce anche la quantità di operazioni di I/O

LogicalDisk(<NTDS>)\Reads/Secdi lettura. Questa riduzione può causare che la soluzione di archiviazione non sia affidabile come i calcoli originali indovinati. Sfortunatamente, non è possibile fornire informazioni più specifiche su ciò che significa questa istruzione, poiché i calcoli variano notevolmente a seconda dei singoli ambienti, in particolare del carico client. Tuttavia, è consigliabile regolare il ridimensionamento dello spazio di archiviazione dopo aver ottimizzato la RAM.

Considerazioni sulla virtualizzazione per le prestazioni

Analogamente alle sezioni precedenti, l'obiettivo è assicurarsi che l'infrastruttura condivisa possa supportare il carico totale di tutti i consumer. È necessario tenere presente questo obiettivo quando si pianificano gli scenari seguenti:

- Una condivisione CD fisica dello stesso supporto in un'infrastruttura SAN, NAS o iSCSI come altri server o applicazioni.

- Un utente che usa l'accesso pass-through a un'infrastruttura SAN, NAS o iSCSI che condivide il supporto.

- Un utente che usa un file VHD su supporti condivisi localmente o un'infrastruttura SAN, NAS o iSCSI.

Dal punto di vista di un utente guest, è necessario passare attraverso un host per accedere a qualsiasi impatto sulle prestazioni dell'archiviazione, perché l'utente deve percorrere percorsi di codice aggiuntivi per ottenere l'accesso. Il test delle prestazioni indica che la virtualizzazione influisce sulla velocità effettiva in base alla quantità di processore usano il sistema host. L'utilizzo del processore è influenzato anche dal numero di risorse richieste dall'utente guest dell'host. Questa richiesta contribuisce alle considerazioni di virtualizzazione per l'elaborazione da prendere per le esigenze di elaborazione in scenari virtualizzati. Per altre informazioni, vedere Appendice A.

Un'ulteriore complicazione è il numero di opzioni di archiviazione attualmente disponibili, ognuna con un impatto sulle prestazioni molto diverso. Queste opzioni includono l'archiviazione pass-through, le schede SCSI e l'IDE. Quando si esegue la migrazione da un ambiente fisico a un ambiente virtuale, è necessario modificare le diverse opzioni di archiviazione per gli utenti guest virtualizzati usando un moltiplicatore di 1,10. Tuttavia, non è necessario prendere in considerazione le modifiche durante il trasferimento tra diversi scenari di archiviazione, come se l'archiviazione sia locale, SAN, NAS o iSCSI è più importante.

Esempio di calcolo della virtualizzazione

Determinazione della quantità di I/O necessaria per un sistema efficiente in condizioni operative normali:

- LogicalDisk(

<NTDS Database Drive>) ÷ Trasferimenti al secondo durante il periodo di picco di 15 minuti - Per determinare la quantità di I/O necessaria per l'archiviazione quando la capacità dell'archiviazione sottostante viene superata:

Operazioni di I/ O al secondo necessarie = (LogicalDisk(

<NTDS Database Drive>)) ÷ media lettura disco/sec ÷<Target Avg Disk Read/sec>) × LogicalDisk(<NTDS Database Drive>)\Lettura/sec

| Contatore | Valore |

|---|---|

Actual LogicalDisk(<NTDS Database Drive>)\Avg Disk sec/Transfer |

.02 secondi (20 millisecondi) |

Target LogicalDisk(<NTDS Database Drive>)\Avg Disk sec/Transfer |

.01 secondi |

| Moltiplicatore per la modifica nell'I/O disponibile | 0,02 ÷ 0,01 = 2 |

| Nome valore | Valore |

|---|---|

LogicalDisk(<NTDS Database Drive>)\Transfers/sec |

400 |

| Moltiplicatore per la modifica nell'I/O disponibile | 2 |

| IOPS totali necessari durante il periodo di picco | 800 |

Per determinare la frequenza con cui è necessario riscaldare la cache:

- Determinare il tempo massimo che si trova accettabile per passare al riscaldamento della cache. Negli scenari tipici, una quantità di tempo accettabile sarebbe il tempo necessario per caricare l'intero database da un disco. Negli scenari in cui la RAM non può caricare l'intero database, usare il tempo necessario per riempire l'intera RAM.

- Determinare le dimensioni del database, escluso lo spazio che non si prevede di usare. Per ulteriori informazioni, vedere Valutazione dell'archiviazione.

- Dividere le dimensioni del database per 8 KB per ottenere il numero totale di operazioni di I/O necessarie per caricare il database.

- Dividere il totale di operazioni di I/O per il numero di secondi nell'intervallo di tempo definito.

Il numero calcolato è per lo più accurato, ma potrebbe non essere esatto perché non è stato configurato (Extensible Storage Engine) ESE per avere una dimensione della cache fissa, Quindi Servizi di dominio Active Directory rimuoverà le pagine caricate in precedenza perché usa dimensioni della cache variabili per impostazione predefinita.

| Punti dati da raccogliere | Valori |

|---|---|

| Tempo massimo accettabile per il riscaldamento | 10 minuti (600 secondi) |

| Dimensione database | 2 GB |

| Fase di calcolo | Formula | Risultato |

|---|---|---|

| Calcolo della dimensione del database in pagine | (2 GB × 1.024 × 1024) = Dimensione del database in KB | 2.097.152 kB |

| Calcolo del numero di pagine nel database | 2.097.152 kB ÷ 8 kB = Numero di pagine | 262.144 pagine |

| Calcolo degli IOPS necessari per riscaldare completamente la cache | 262.144 pagine ÷ 600 secondi = IOPS necessari | 437 IOPS |

Elaborazione

Valutazione dell'uso del processore di Active Directory

Per la maggior parte degli ambienti, la gestione della capacità di elaborazione è il componente che merita più attenzione. Quando si valuta la capacità della CPU necessaria per la distribuzione, è consigliabile considerare i due aspetti seguenti:

- Le applicazioni nell'ambiente si comportano come previsto all'interno di un'infrastruttura di servizi condivisi in base ai criteri descritti in Rilevamento delle ricerche costose e inefficienti? In ambienti di dimensioni maggiori, le applicazioni con codice non adeguato possono rendere il carico della CPU volatile, richiedere una quantità eccessiva di tempo di CPU a scapito di altre applicazioni, aumentare le esigenze di capacità e distribuire in modo non uniforme il carico nei controller di dominio.

- Servizi di dominio Active Directory è un ambiente distribuito con molti potenziali client le cui esigenze di elaborazione variano notevolmente. I costi stimati per ogni client possono variare a causa dei modelli di utilizzo e del numero di applicazioni che usano Servizi di dominio Active Directory. Come in Rete, è consigliabile valutare come valutazione della capacità totale necessaria nell'ambiente invece di esaminare ogni client uno alla volta.

È consigliabile eseguire questa stima solo dopo aver completato la stima dell'archiviazione , in quanto non sarà possibile eseguire un'ipotesi accurata senza dati validi sul carico del processore. È anche importante assicurarsi che eventuali colli di bottiglia non siano causati dall'archiviazione prima di risolvere i problemi del processore. Quando si rimuovono gli stati di attesa del processore, l'utilizzo della CPU aumenta perché non deve più attendere i dati. Pertanto, i contatori delle prestazioni da prestare la maggior attenzione a sono Logical Disk(<NTDS Database Drive>)\Avg Disk sec/Read e Process(lsass)\ Processor Time. Se il Logical Disk(<NTDS Database Drive>)\Avg Disk sec/Read contatore è superiore a 10 o 15 millisecondi, i dati in Process(lsass)\ Processor Time sono artificialmente bassi e il problema è correlato alle prestazioni di archiviazione. È consigliabile impostare intervalli di campionamento su 15, 30 o 60 minuti per i dati più accurati possibili.

Panoramica dell'elaborazione

Per pianificare la capacità dei controller di dominio, la potenza di elaborazione richiede la massima attenzione e comprensione. Quando si ridimensionano i sistemi per garantire prestazioni massime, c'è sempre un componente che rappresenta il collo di bottiglia e in un controller di dominio di dimensioni appropriate questo componente è il processore.

Come per la sezione dedicata alla rete, dove la richiesta dell'ambiente viene esaminata sito per sito, lo stesso deve essere fatto per la capacità di calcolo richiesta. A differenza della sezione dedicata alla rete, dove le tecnologie di rete disponibili superano di gran lunga la normale richiesta, si presti maggiore attenzione al dimensionamento della capacità della CPU. Come in ogni ambiente di dimensioni anche solo moderate, qualsiasi cosa che superi le poche migliaia di utenti simultanei può comportare un carico notevole sulla CPU.

Purtroppo, a causa dell'enorme variabilità delle applicazioni client che sfruttano AD, una stima generale degli utenti per CPU non è purtroppo applicabile a tutti gli ambienti. In particolare, le richieste di calcolo sono soggette al comportamento degli utenti e al profilo delle applicazioni. Pertanto, ogni ambiente deve essere dimensionato individualmente.

Profilo comportamentale del sito di destinazione

Quando si pianifica la capacità per un intero sito, l'obiettivo deve essere una progettazione di capacità N + 1. In questa progettazione, anche se un sistema non riesce durante il periodo di picco, il servizio può continuare a livelli accettabili di qualità. In uno scenario N , il carico tra tutte le caselle deve essere inferiore all'80%-100% durante i periodi di picco.

Inoltre, le applicazioni e i client del sito usano il metodo di funzione DsGetDcName consigliato per l'individuazione dei controller di dominio, devono essere già distribuiti in modo uniforme con solo picchi temporanei secondari.

Verranno ora esaminati due esempi di ambienti su destinazione e fuori destinazione. In primo luogo, si esaminerà un esempio di ambiente che funziona come previsto e non supera l'obiettivo di pianificazione della capacità.

Per il primo esempio, si stanno facendo i presupposti seguenti:

- Ognuno dei cinque controller di dominio nel sito ha quattro CPU.

- L'utilizzo totale della CPU di destinazione durante l'orario di ufficio è del 40% in condizioni operative normali (N + 1) e 60% in caso contrario (N). Durante gli orari non lavorativi, l'utilizzo della CPU di destinazione è l'80% perché si prevede che il software di backup e altri processi di manutenzione usino tutte le risorse disponibili.

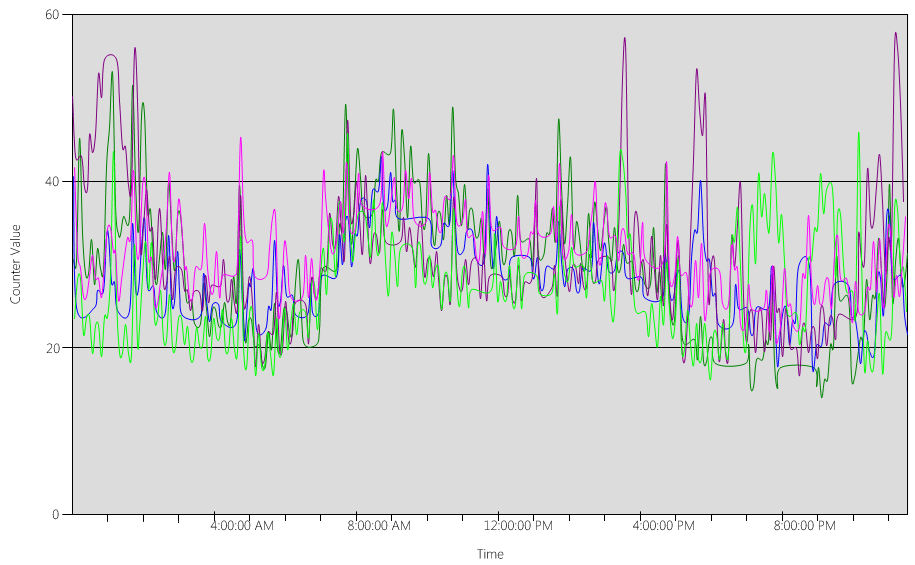

A questo punto, esaminiamo il (Processor Information(_Total)\% Processor Utility) grafico, per ognuno dei controller di dominio, come illustrato nell'immagine seguente.

Il carico è relativamente uniformemente distribuito, ovvero ciò che ci si aspetterebbe quando i client usano il localizzatore dc e le ricerche ben scritte.

In diversi intervalli di cinque minuti, ci sono picchi al 10%, a volte anche al 20%. Tuttavia, a meno che questi picchi non superino la destinazione del piano di capacità, non è necessario esaminarli.

Il periodo di picco per tutti i sistemi è compreso tra le 8:00 e le 9:15. Il giorno lavorativo medio dura dalle 5:00 alle 17:00. Di conseguenza, eventuali picchi casuali di utilizzo della CPU che si verificano tra le 17:00 e le 14:00 sono al di fuori dell'orario di ufficio e pertanto non è necessario includerli nei problemi di pianificazione della capacità.

Nota

In un sistema ben gestito, i picchi che si verificano durante il periodo di minore attività sono in genere causati da software di backup, analisi antivirus di sistema complete, inventario hardware o software, distribuzione di software o patch e così via. Poiché questi picchi si verificano al di fuori dell'orario di ufficio, non vengono conteggiati per superare gli obiettivi di pianificazione della capacità.

Poiché ogni sistema è circa il 40% e tutti hanno lo stesso numero di CPU, se uno di essi passa offline, i sistemi rimanenti vengono eseguiti con una stima del 53%. Il sistema D ha un carico del 40% che viene suddiviso in modo uniforme e aggiunto al carico esistente del 40% del sistema A e C. Questo presupposto lineare non è perfettamente accurato, ma fornisce una precisione sufficiente per misurare.

Si esaminerà quindi un esempio di ambiente che non ha un utilizzo corretto della CPU e supera la destinazione di pianificazione della capacità.

In questo esempio sono presenti due controller di dominio in esecuzione al 40%. Un controller di dominio passa offline, causando il raggiungimento dell'80% dell'utilizzo stimato della CPU nel controller di dominio rimanente. Questo livello di utilizzo della CPU supera notevolmente la soglia per il piano di capacità e inizia a limitare la quantità di headroom per il 10% al 20% del profilo di carico. Di conseguenza, ogni picco potrebbe potenzialmente guidare il controller di dominio al 90% o anche al 100% durante lo scenario N, riducendone la velocità di risposta.

Calcolo delle richieste della CPU

Il Process\% Processor Time contatore delle prestazioni tiene traccia della quantità totale di tempo trascorso da tutti i thread dell'applicazione nella CPU, quindi divide tale somma per la quantità totale di tempo di sistema passato. Un'applicazione con threadingmutato in un sistema con più CPU può superare il 100% del tempo di CPU e interpretare i dati in modo molto diverso rispetto al Processor Information\% Processor Utility contatore. In pratica, il Process(lsass)\% Processor Time contatore tiene traccia del numero di CPU in esecuzione al 100% del sistema per supportare le richieste di un processo. Ad esempio, se il contatore ha un valore pari al 200%, significa che il sistema richiede due CPU in esecuzione al 100% per supportare il carico completo di Active Directory Domain Services. Anche se una CPU in esecuzione al 100% di capacità è la più conveniente in termini di consumo energetico e energia, per motivi descritti nell'Appendice A, un sistema multithreading è più reattivo quando il sistema non è in esecuzione sul 100%.

Per supportare picchi temporanei nel carico del client, è consigliabile impostare come destinazione un periodo di picco della CPU tra il 40% e il 60% della capacità di sistema. Ad esempio, nel primo esempio nel profilo di comportamento del sito di destinazione, è necessario tra 3,33 CPU (60% di destinazione) e 5 CPU (40% di destinazione) per supportare il carico di Active Directory Domain Services. È consigliabile aggiungere capacità aggiuntiva in base alle esigenze del sistema operativo e a qualsiasi altro agente richiesto, ad esempio antivirus, backup, monitoraggio e così via. Anche se è consigliabile valutare l'impatto degli agenti sugli agenti CPU in base all'ambiente, in genere è possibile allocare tra il 5% e il 10% per i processi dell'agente su una singola CPU. Per rivedere l'esempio, è necessario tra il 3,43 (60% di destinazione) e il 5,1 (40% di destinazione) per supportare il carico durante i periodi di picco.

Si esaminerà ora un esempio di calcolo per un processo specifico. In questo caso, verrà esaminato il processo LSASS.

Calcolo dell'utilizzo della CPU per il processo LSASS

In questo esempio, il sistema è uno scenario N + 1 in cui un server trasporta il carico di Servizi di dominio Active Directory mentre è presente un server aggiuntivo per la ridondanza.

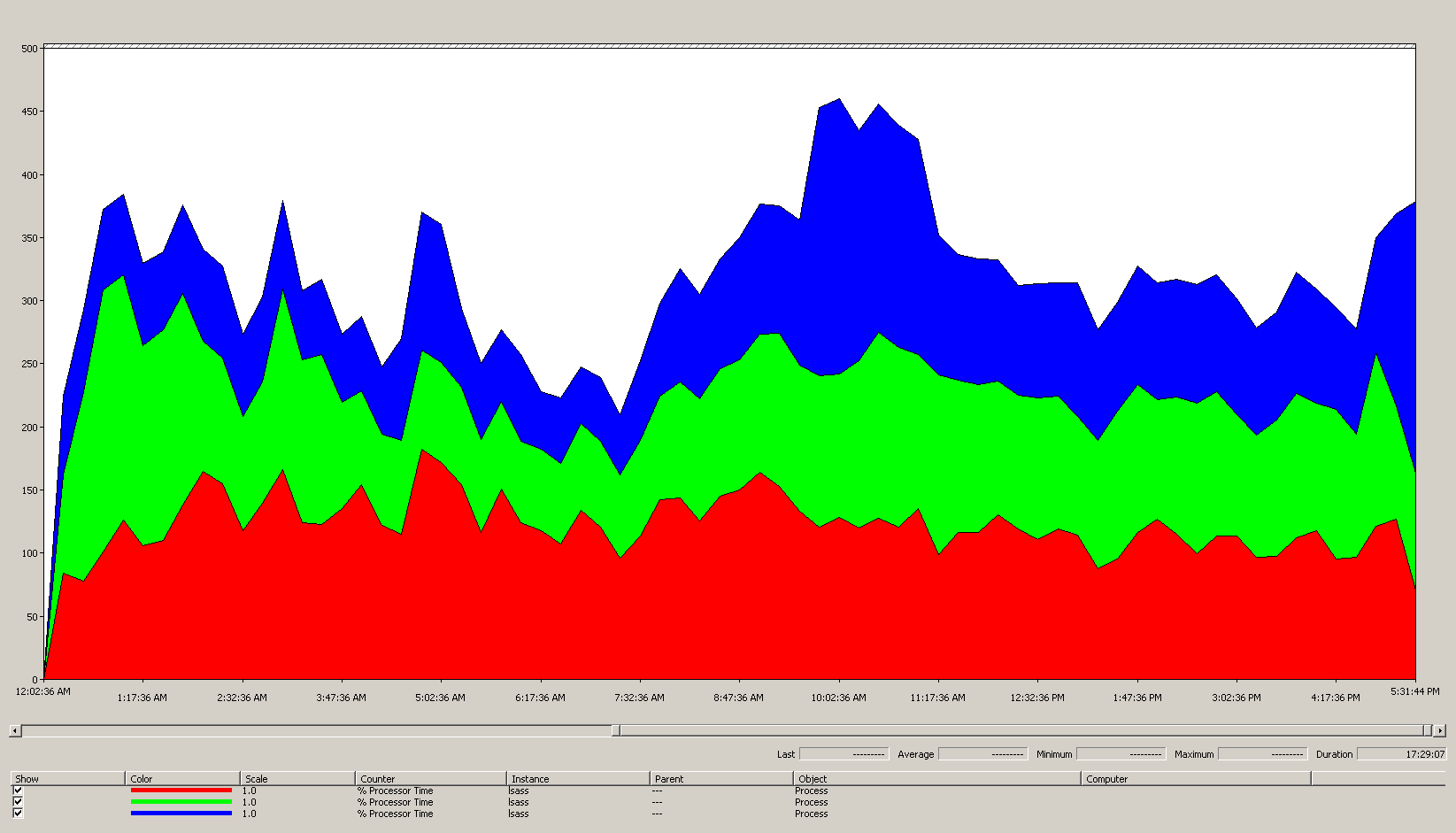

Il grafico seguente mostra il tempo del processore per il processo LSASS su tutti i processori per questo scenario di esempio. Questi dati sono stati raccolti dal contatore delle Process(lsass)\% Processor Time prestazioni.

Ecco cosa illustra questo grafico sull'ambiente dello scenario:

- Nel sito sono presenti tre controller di dominio.

- Il giorno lavorativo inizia a salire intorno alle 7:00 e poi scende alle 17:00.

- Il periodo più affollato del giorno è dalle 9:30 alle 11:00.

Nota

Tutti i dati relativi alle prestazioni sono di tipo cronologico. Il punto dati di picco alle 9:15 indica il carico dalle 9:00 alle 9:15.

- I picchi prima delle 7:00 potrebbero indicare un carico aggiuntivo da fusi orari diversi o attività dell'infrastruttura in background, ad esempio i backup. Tuttavia, poiché questo picco è inferiore al picco di attività alle 9:30, non è una causa di preoccupazione.

Al carico massimo, il processo lsass utilizza circa 4,85 CPU in esecuzione al 100%, che sarebbe il 485% su una singola CPU. Questi risultati suggeriscono che il sito dello scenario necessita di circa 12/25 CPU per gestire Active Directory Domain Services. Quando si porta il 5% consigliato al 10% di capacità aggiuntiva per i processi in background, il server necessita da 12,30 a 12,25 CPU per supportare il carico corrente. Le stime che prevedono una crescita futura rendono questo numero ancora più elevato.

Quando ottimizzare LDAP Weights

Esistono alcuni scenari in cui è consigliabile prendere in considerazione l'ottimizzazione di LdapSrvWeight. Nel contesto della pianificazione della capacità, è consigliabile ottimizzarlo quando le applicazioni, i caricamenti degli utenti o le funzionalità di sistema sottostanti non sono bilanciate in modo uniforme.

Le sezioni seguenti descrivono due scenari di esempio in cui è necessario ottimizzare i pesi LDAP (Lightweight Directory Access Protocol).

Esempio 1: ambiente dell'emulatore PDC

Se si usa un emulatore PDC (Primary Domain Controller), il comportamento dell'utente o dell'applicazione distribuito in modo non uniforme può influire su più ambienti contemporaneamente. Le risorse della CPU nell'emulatore PDC sono spesso più richieste rispetto a altre posizioni della distribuzione, perché diversi strumenti e azioni lo hanno come destinazione, ad esempio gli strumenti di gestione di Criteri di gruppo, i secondi tentativi di autenticazione, l'istituzione di attendibilità e così via.

- È consigliabile ottimizzare l'emulatore PDC solo se esiste una differenza notevole nell'utilizzo della CPU. L'ottimizzazione deve ridurre il carico nell'emulatore PDC e aumentare il carico su altri controller di dominio, consentendo una distribuzione del carico più uniforme.

- In questi casi, impostare il valore per

LDAPSrvWeighttra 50 e 75 per l'emulatore PDC.

| Sistema | Utilizzo della CPU con impostazioni predefinite | Nuovo LdapSrvWeight | Nuovo utilizzo stimato della CPU |

|---|---|---|---|

| Controller di dominio 1 (emulatore PDC) | 53% | 57 | 40 % |

| Controller di dominio 2 | 33% | 100 | 40 % |

| Controller di dominio 3 | 33% | 100 | 40 % |

Il catch è che se il ruolo dell'emulatore PDC viene trasferito o sequestrato, in particolare a un altro controller di dominio nel sito, l'utilizzo della CPU aumenta notevolmente sul nuovo emulatore PDC.

In questo scenario di esempio si presuppone che in base al profilo di comportamento del sito di destinazione che tutti e tre i controller di dominio in questo sito abbiano quattro CPU. In condizioni normali, cosa accadrebbe se uno di questi controller di dominio avesse otto CPU? Ci sarebbero due controller di dominio con un utilizzo del 40% e uno con un utilizzo del 20%. Anche se questa configurazione non è necessariamente negativa, è possibile usare l'ottimizzazione del peso LDAP per bilanciare meglio il carico.

Esempio 2: ambiente con conteggi cpu diversi

Quando si dispone di server con numero di CPU e velocità diversi nello stesso sito, è necessario assicurarsi che siano distribuiti in modo uniforme. Ad esempio, se il sito ha due server a otto core e un server a quattro core, il server a quattro core ha solo la metà della potenza di elaborazione degli altri due server. Se il carico del client viene distribuito uniformemente, significa che il server a quattro core deve funzionare due volte più difficile come i due server a otto core per gestire il carico della CPU. Oltre a questo, se uno dei server a otto core diventa offline, il server a quattro core viene sovraccaricato.

| Sistema | Informazioni sul processore % Utilità processore (_Totale) Utilizzo della CPU con impostazioni predefinite |

Nuovo LdapSrvWeight | Nuovo utilizzo stimato della CPU |

|---|---|---|---|

| 4-CPU, Controller di dominio 1 | 40 | 100 | 30% |

| 4-CPU, Controller di dominio 2 | 40 | 100 | 30% |

| 8-CPU, Controller di dominio 3 | 20 | 200 | 30% |

La pianificazione di uno scenario "N + 1" è di fondamentale importanza. L'impatto di un controller di dominio che va offline deve essere calcolato per ogni scenario. Nello scenario immediatamente precedente in cui la distribuzione del carico è pari, per garantire un carico del 60% durante uno scenario "N", con il carico bilanciato in modo uniforme in tutti i server, la distribuzione è ottimale perché i rapporti rimangono coerenti. Quando si esamina lo scenario di ottimizzazione dell'emulatore PDC o qualsiasi scenario generale in cui il carico dell'utente o dell'applicazione è sbilanciato, l'effetto è molto diverso:

| Sistema | Uso ottimizzato | Nuovo LdapSrvWeight | Stima del nuovo uso |

|---|---|---|---|

| Controller di dominio 1 (emulatore PDC) | 40 % | 85 | 47% |

| Controller di dominio 2 | 40 % | 100 | 53% |

| Controller di dominio 3 | 40 % | 100 | 53% |

Considerazioni sulla virtualizzazione per l'elaborazione

Quando si pianifica la capacità per un ambiente virtualizzato, è necessario considerare due livelli: il livello host e il livello guest. A livello di host, è necessario identificare i periodi di picco del ciclo aziendale. Poiché la pianificazione dei thread guest nella CPU per una macchina virtuale è simile al recupero di thread di Active Directory Domain Services sulla CPU per un computer fisico, è comunque consigliabile usare il 40% al 60% dell'host sottostante. A livello di guest, poiché i principi di pianificazione dei thread sottostanti sono invariati, è comunque consigliabile mantenere l'utilizzo della CPU entro l'intervallo compreso tra il 40% e il 60%.

In uno scenario con mapping diretto con un guest per host, è necessario inserire tutte le stime della pianificazione della capacità eseguite nelle sezioni precedenti per eseguire la stima. Per uno scenario host condiviso, l'efficienza dei processori sottostanti è circa il 10%, il che significa che se un sito necessita di 10 CPU a un obiettivo del 40%, il numero consigliato di CPU virtuali da allocare in tutti i guest N sarà 11. Nei siti con distribuzioni miste di server fisici e virtuali questo modificatore si applica solo alle macchine virtuali . Ad esempio, in uno scenario N + 1, un server fisico o con mapping diretto con 10 CPU è quasi uguale a un guest con 11 CPU in un host con 11 CPU riservate per il controller di dominio.

Durante l'analisi e il calcolo del numero di CPU necessarie per supportare il carico di Servizi di dominio Active Directory, tenere presente che se si prevede di acquistare hardware fisico, i tipi di hardware disponibili sul mercato potrebbero non essere mappati esattamente alle stime. Tuttavia, non si verifica alcun problema quando si usa la virtualizzazione. L'uso delle macchine virtuali riduce il lavoro necessario per aggiungere capacità di calcolo a un sito, perché è possibile aggiungere il numero di CPU con le specifiche esatte desiderate per una macchina virtuale. Tuttavia, la virtualizzazione non elimina la responsabilità di valutare accuratamente la potenza di calcolo necessaria per garantire che l'hardware sottostante sia disponibile quando i guest necessitano di più CPU. Come sempre, ricordarsi di pianificare in anticipo la crescita.

Esempio di riepilogo del calcolo della virtualizzazione

| Sistema | Picco CPU |

|---|---|

| Controller di dominio 1 | 120% |

| Controller di dominio 2 | 147% |

| Controller di dominio 3 | 218% |

| Utilizzo totale della CPU | 485% |

| Conteggio dei sistemi di destinazione | Larghezza di banda totale (dall'alto) |

|---|---|

| CPU necessarie al 40% della destinazione | 4,85 ÷ .4 = 12,25 |

Quando si pianifica in anticipo la crescita in questo scenario, se si presuppone che la domanda crescerà del 50% nei prossimi tre anni, è necessario assicurarsi che abbia 18,375 CPU (12,25 × 1,5) entro quel tempo. In alternativa, è possibile esaminare la domanda dopo il primo anno, quindi aggiungere capacità aggiuntiva in base ai risultati.

Carico di autenticazione client cross-trust per NTLM

Valutazione del carico di autenticazione client cross-trust

Molti ambienti possono disporre di uno o più domini collegati da un trust. Le richieste di autenticazione per le identità in altri domini che non usano Kerberos devono attraversare un trust usando un canale sicuro tra due controller di dominio. Il controller di dominio a cui l'utente sta tentando di accedere nel sito si connette a un altro controller di dominio che si trova nel dominio di destinazione o in un altro punto verso l'alto verso il dominio di destinazione. Il numero di chiamate che il controller di dominio può effettuare all'altro controller di dominio nel dominio attendibile è controllato dall'impostazione *MaxConcurrentAPI . Per garantire che il canale sicuro possa gestire la quantità di carico necessaria per comunicare tra i controller di dominio, è possibile ottimizzare MaxConcurrentAPI o, se ci si trova in una foresta, creare trust di collegamento. Per altre informazioni su come determinare il volume di traffico tra trust, vedere Come eseguire l'ottimizzazione delle prestazioni per l'autenticazione NTLM usando l'impostazione MaxConcurrentApi.

Come per gli scenari precedenti, è necessario raccogliere dati durante i periodi di picco occupati del giorno per renderli utili.

Nota

Gli scenari intraforestali e interforesti possono causare l'attraversamento di più trust, il che significa che è necessario ottimizzare durante ogni fase del processo.

Pianificazione della virtualizzazione

Quando si pianifica la capacità per la virtualizzazione, tenere presente alcuni aspetti:

- Molte applicazioni usano l'autenticazione NTLM (Network Level Trust Manager) per impostazione predefinita o in determinate configurazioni.

- Con l'aumentare del numero di client attivi, è quindi necessario che i server applicazioni abbiano una maggiore capacità.

- I client a volte mantengono le sessioni aperte per un periodo di tempo limitato e si riconnettono regolarmente per servizi come la sincronizzazione pull della posta elettronica.

- I server proxy Web che richiedono l'autenticazione per l'accesso a Internet possono causare un carico NTLM elevato.

Queste applicazioni possono creare un carico elevato per l'autenticazione NTLM, che pone uno stress significativo sui controller di dominio, soprattutto quando gli utenti e le risorse si trovano in domini diversi.

Esistono molti approcci che è possibile adottare per gestire il carico tra trust, che spesso è possibile e usare insieme contemporaneamente:

- Ridurre l'autenticazione client tra trust individuando i servizi utilizzati da un utente nel dominio in cui si trovano.

- Aumentare il numero di canali sicuri disponibili. Questi canali sono denominati trust di collegamento e sono rilevanti per il traffico intraforestale e tra foreste.

- Ottimizzare le impostazioni predefinite di MaxConcurrentAPI.

Per ottimizzare MaxConcurrentAPI in un server esistente, usare l'equazione seguente:

New_MaxConcurrentApi_setting ≥ (semaphore_acquires + semaphore_time-outs) × average_semaphore_hold_time ÷ time_collection_length

Per ulteriori informazioni, consultare l'articolo KB 2688798: Come eseguire la regolazione delle prestazioni per l'autenticazione NTLM utilizzando l'impostazione MaxConcurrentApi.

Considerazioni sulla virtualizzazione

Non sono necessarie considerazioni particolari, perché la virtualizzazione è un'impostazione di ottimizzazione del sistema operativo.

Esempio di calcolo dell'ottimizzazione della virtualizzazione

| Tipo di dati | Valore |

|---|---|

| Acquisizioni di Semaphore (minimo) | 6,161 |

| Acquisizioni di Semaphore (massimo) | 6,762 |

| Timeout di Semaphore | 0 |

| Tempo medio di attesa di Semaphore | 0,012 |

| Durata della raccolta (secondi) | 1:11 minuti (71 secondi) |

| Formula (da KB 2688798) | ((6762 - 6161) + 0) × 0,012 / |

| Valore minimo per MaxConcurrentAPI | ((6762 - 6161) + 0) × 0,012 ÷ 71 = .101 |

Per questo sistema e per questo lasso di tempo, i valori predefiniti sono accettabili.

Monitoraggio della conformità agli obiettivi di pianificazione della capacità

In questo articolo è stato illustrato come la pianificazione e il ridimensionamento vadano verso gli obiettivi di utilizzo. La tabella seguente riepiloga le soglie consigliate da monitorare per garantire che i sistemi funzionino come previsto. Tenere presente che queste non sono soglie di prestazioni, ma solo soglie di pianificazione della capacità. Un server che opera in eccesso a queste soglie funzionerà ancora, ma è necessario verificare che le applicazioni funzionino come previsto prima di iniziare a visualizzare problemi di prestazioni man mano che la domanda degli utenti aumenta. Se le applicazioni hanno esito positivo, è consigliabile iniziare a valutare gli aggiornamenti hardware o altre modifiche alla configurazione.

| Categoria | Contatore delle prestazioni | Intervallo/campionamento | Destinazione | Avviso |

|---|---|---|---|---|

| Processore | Processor Information(_Total)\% Processor Utility |

60 min | 40 % | 60% |

| RAM (Windows Server 2008 R2 o versioni precedenti) | Memoria disponibile MB | < 100 MB | N/D | < 100 MB |

| RAM (Windows Server 2012) | Memoria\Durata media cache standby a lungo termine | 30 min | Deve essere testato | Deve essere testato |

| Network | Interfaccia di rete(*)\Byte inviati/sec Interfaccia di rete(*)\Byte ricevuti/sec |

30 min | 40 % | 60% |

| Archiviazione | LogicalDisk((<NTDS Database Drive>))\Avg Disk sec/ReadLogicalDisk(( |

60 min | 10 ms | 15 ms |

| Servizi AD | Netlogon(*)\Tempo medio di attesa di Semaphore | 60 min | 0 | 1 secondo |

Appendice A: criteri di dimensionamento della CPU

Questa appendice illustra i termini e i concetti utili che consentono di stimare le esigenze di dimensionamento della CPU dell'ambiente.

Definizioni: ridimensionamento della CPU

Un processore (microprocessore) è un componente che legge ed esegue le istruzioni del programma.

Un processore multi-core ha più CPU nello stesso circuito integrato.

Un sistema multi-CPU ha più CPU che non si trova nello stesso circuito integrato.

Un processore logico è un processore che ha un solo motore di elaborazione logico dal punto di vista del sistema operativo.

Queste definizioni includono hyperthreading, un core nel processore multi-core o un singolo processore core.

Poiché i sistemi server di oggi hanno più processori, più processori multi-core e hyper-threading, queste definizioni sono generalizzate per coprire entrambi gli scenari. Il termine processore logico viene usato perché rappresenta la prospettiva del sistema operativo e dell'applicazione dei motori di elaborazione disponibili.

Parallelismo a livello di thread

Ogni thread è un'attività indipendente, poiché ogni thread dispone di proprio stack e di istruzioni proprie. Servizi di dominio Active Directory è multithreading ed è possibile ottimizzare il numero di thread disponibili seguendo le istruzioni riportate in Come visualizzare e impostare i criteri LDAP in Active Directory usando Ntdsutil.exe, viene ridimensionato correttamente in più processori logici.

Parallelismo a livello di dati

Il parallelismo a livello di dati è quando un servizio condivide i dati tra più thread per lo stesso processo e la condivisione di molti thread tra più processi. Il processo di Active Directory Domain Services viene conteggiato da solo come servizio che condivide i dati tra più thread per un singolo processo. Tutte le modifiche apportate ai dati vengono riflesse in tutti i thread in esecuzione in tutti i livelli della cache, ogni core e qualsiasi aggiornamento alla memoria condivisa. Le prestazioni possono peggiorare durante le operazioni di scrittura perché tutte le posizioni di memoria si adattano alle modifiche prima che l'elaborazione delle istruzioni possa continuare.

Considerazioni sulla velocità della CPU e su più core

In genere, processori logici più veloci riducono il tempo necessario per elaborare una serie di istruzioni. Più processori logici significano che è possibile eseguire più attività contemporaneamente. Tuttavia, queste regole non si applicano in scenari più complessi, ad esempio il recupero di dati dalla memoria condivisa, l'attesa sul parallelismo a livello di dati e l'overhead di gestione di più thread contemporaneamente. Di conseguenza, la scalabilità nei sistemi multi-core non è lineare.

Per capire perché questo cambiamento si verifica, è utile pensare a questi scenari come un'autostrada. Ogni filo è una singola auto, ogni corsia è un core e il limite di velocità è la velocità del clock.

Se c'è una sola auto sull'autostrada, non importa se ci sono due o 12 corsie. Quella vettura va solo veloce quanto il limite di velocità consente.

Se i dati necessari per il thread non sono immediatamente disponibili, il thread non può elaborare le istruzioni finché non recupera i dati pertinenti dalla memoria. È come se un segmento dell'autostrada sia chiuso. Anche se c'è una sola auto sull'autostrada, il limite di velocità non influirà sulla sua capacità di viaggiare, perché non può andare da nessuna parte finché la strada non viene riaperta.

Con l'aumentare del numero di automobili, aumenta anche il sovraccarico necessario per gestire il numero di automobili. I conducenti devono concentrarsi più duramente quando si guida sull'autostrada durante il traffico dell'ora di punta anziché la sera tardi quando la strada è per lo più vuota. Inoltre, guidare su un'autostrada a due corsie dove è sufficiente preoccuparsi di un'altra corsia richiede meno attenzione rispetto alla guida su un'autostrada a sei corsie dove si hanno cinque altre corsie di traffico per prestare attenzione.

In sintesi, le domande su se aggiungere più o più processori diventano altamente soggettivi e devono essere considerate caso per caso. Per Servizi di dominio Active Directory in particolare, le esigenze di elaborazione dipendono da fattori ambientali e possono variare da server a server all'interno di un singolo ambiente. Di conseguenza, le sezioni precedenti di questo articolo non hanno investito molto per eseguire calcoli super precisi. Quando si effettuano decisioni di acquisto basate sul budget, è consigliabile ottimizzare prima l'utilizzo del processore al 40% o a qualsiasi numero richiesto dall'ambiente specifico. Se il sistema non è ottimizzato, non puoi trarre vantaggio dall'acquisto di processori aggiuntivi.

Tempo di risposta e impatto dei livelli di attività del sistema

La teoria di accodamento è lo studio matematico delle linee di attesa o delle code. Nell'accodamento della teoria del calcolo, la legge sull'utilizzo è rappresentata dall'equazione t:

U k = B ÷ T

Dove U k è la percentuale di utilizzo, B è la quantità di tempo impiegato per essere occupato e T è il tempo totale trascorso osservando il sistema. In un contesto Microsoft, questo significa il numero di thread a intervalli di 100 nanosecondi (ns) in uno stato In esecuzione diviso per il numero di intervalli di 100-n disponibili nell'intervallo di tempo specificato. Questa è la stessa formula che calcola la percentuale di utilizzo del processore visualizzata in Oggetto processore e PERF_100NSEC_TIMER_INV.

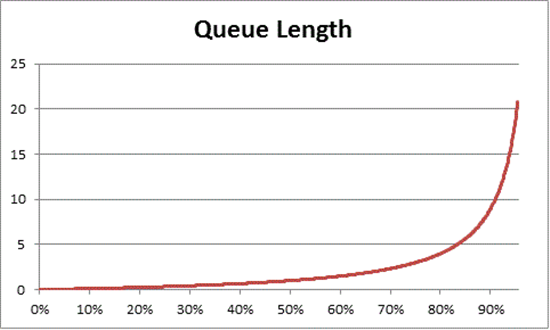

La teoria di accodamento fornisce anche la formula: N = U K ÷ (1 - K K ) per stimare il numero di elementi in attesa in base all'utilizzo, dove N è la lunghezza della coda. Il grafico di questa equazione in tutti gli intervalli di utilizzo fornisce le stime seguenti della durata della coda per il caricamento del processore in un determinato carico della CPU.

In base a questa stima, è possibile osservare che dopo il 50% del carico della CPU, l'attesa media include in genere un altro elemento nella coda e aumenta rapidamente fino al 70% dell'utilizzo della CPU.

Per comprendere come la teoria dell'accodamento si applica alla distribuzione di Servizi di dominio Active Directory, torniamo alla metafora dell'autostrada usata nella velocità della CPU rispetto alle considerazioni su più core.

I tempi più affollati nel pomeriggio di metà pomeriggio cadrebbero da qualche parte nell'intervallo di capacità del 40% al 70%. C'è abbastanza traffico che la possibilità di scegliere una corsia in cui guidare non è gravemente limitata. Mentre la possibilità di un altro conducente che arriva nel tuo modo è alta, non richiede lo stesso livello di sforzo che avresti bisogno di trovare un divario sicuro tra le altre auto nella corsia come durante l'ora di punta.

Con l'avvicinarsi dell'ora di punta, il sistema stradale si avvicina al 100% di capacità. Cambiare corsie durante l'ora di punta diventa molto impegnativo perché le auto sono così vicine che non hai tanto spazio per manovrare quando cambi corsie.

Questo è il motivo per cui stimare le medie a lungo termine per la capacità al 40% consente un maggior numero di headroom per picchi di carico anomali, indipendentemente dal fatto che tali picchi siano transitori, ad esempio con query poco codificate che richiedono un po' di tempo o picchi anomali nel carico generale, come il picco di attività al mattino dopo un fine settimana di vacanza.

L'istruzione precedente considera la percentuale di calcolo del tempo processore come uguale all'equazione della legge sull'utilizzo. Questa versione semplificata è destinata a introdurre il concetto ai nuovi utenti. Tuttavia, per la matematica più avanzata, è possibile usare i riferimenti seguenti come guida:

- Traduzione di PERF_100NSEC_TIMER_INV

- B = Numero di intervalli di 100-ns che il thread inattiva spende per il processore logico. Modifica nella variabile X nel calcolo PERF_100NSEC_TIMER_INV

- T = il numero totale di intervalli di 100 ns in un determinato intervallo di tempo. Modifica nella variabile Y nel calcolo PERF_100NSEC_TIMER_INV .

- U k = Percentuale di utilizzo del processore logico in base al thread inattiva o % tempo di inattività.

- Elaborazione dei calcoli:

- U k = 1 – % tempo processore

- % tempo processore = 1 – U k

- % tempo processore = 1 – B / T

- %Tempo processore = 1 – X1 – X0 / Y1 – Y0

Applicazione di questi concetti alla pianificazione della capacità

La matematica nella sezione precedente probabilmente determina il numero di processori logici necessari in un sistema sembra molto complesso. Di conseguenza, l'approccio al dimensionamento del sistema deve concentrarsi sulla determinazione del massimo utilizzo di destinazione in base al carico corrente, quindi calcolare il numero di processori logici necessari per raggiungere tale destinazione. Inoltre, la stima non deve essere perfettamente esatta. Anche se le velocità del processore logico hanno un impatto significativo sulla sincronizzazione, le prestazioni possono essere influenzate anche da altre aree:

- Efficienza della cache

- Requisiti di coerenza della memoria

- Pianificazione e sincronizzazione dei thread

- Caricamenti client con bilanciamento imperfetto

Poiché la potenza di calcolo è relativamente a basso costo, non vale la pena investire troppo tempo nel calcolo del numero esatto di CPU necessarie.

È anche importante ricordare che la raccomandazione del 40%, in questo caso, non è un requisito obbligatorio. Lo usiamo come un inizio ragionevole per eseguire calcoli. Diversi tipi di utenti di Active Directory richiedono livelli diversi di velocità di risposta. Possono verificarsi scenari in cui gli ambienti possono essere eseguiti al 80% o persino al 90% in una media sostenuta senza i tempi di attesa maggiori per l'accesso al processore che influiscono notevolmente sulle prestazioni del client.

Ci sono anche altre aree nel sistema che sono molto più lente rispetto al processore logico che è necessario ottimizzare, tra cui l'accesso alla RAM, l'accesso al disco e la trasmissione di risposte in rete. Ad esempio:

Se si aggiungono processori a un sistema in esecuzione con un utilizzo del 90% associato al disco, probabilmente non migliorerà significativamente le prestazioni. Se si esamina in modo più approfondito il sistema, ci sono molti thread che non stanno nemmeno entrare nel processore perché sono in attesa del completamento delle operazioni di I/O.