Usare un'attività Notebook in una pipeline

Dopo aver creato un servizio collegato in Azure Data Factory per l'area di lavoro di Azure Databricks, è possibile usarlo per definire la connessione per un'attività Notebook in una pipeline.

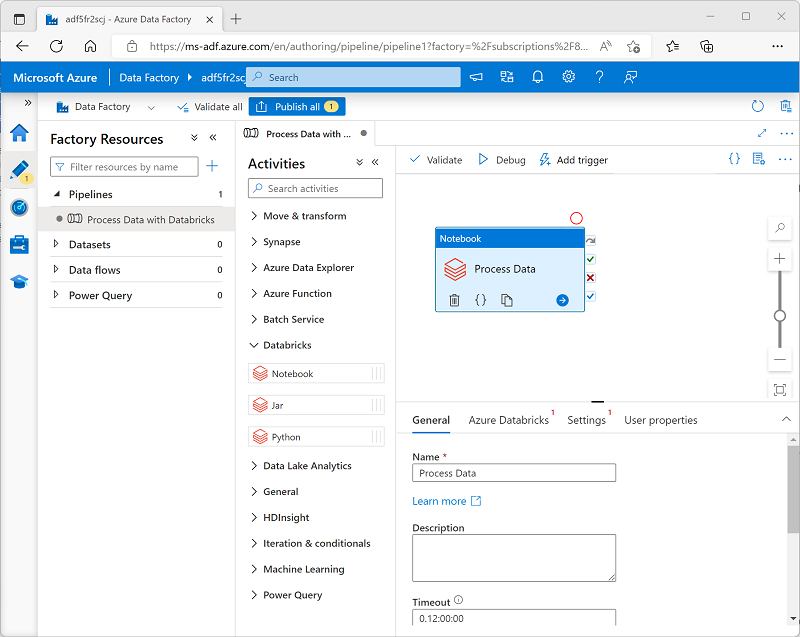

Per usare un'attività Notebook, creare una pipeline e dalla categoria Databricks aggiungere un'attività Notebook all'area di progettazione della pipeline.

Usare le proprietà seguenti dell'attività Notebook per configurarla:

| Categoria | Impostazione | Descrizione |

|---|---|---|

| Generali | Nome | Un nome univoco per l'attività. |

| Descrizione | Una descrizione significativa. | |

| Timeout | Il tempo di esecuzione dell'attività prima dell'annullamento automatico. | |

| Nuovi tentativi | Il numero di tentativi che deve effettuare Azure Data Factory prima che restituisca un esito negativo. | |

| Intervallo tentativi | Il tempo di attesa prima di effettuare un nuovo tentativo. | |

| Input e output sicuri | Determina se i valori di input e output vengono registrati. | |

| Azure Databricks | Servizio collegato Azure Databricks | Il servizio collegato per l'area di lavoro di Azure Databricks contenente il notebook. |

| Impostazioni | Percorso del notebook | Il percorso del file del notebook nell'area di lavoro. |

| Parametri di base | Consente di passare parametri al notebook. | |

| Accoda librerie | Consente di aggiungere le librerie di codice necessarie che non vengono installate per impostazione predefinita. | |

| Proprietà utente | Le proprietà personalizzate definite dall'utente. |

Esecuzione di una pipeline

Quando la pipeline contenente l'attività Notebook viene pubblicata, è possibile eseguirla definendo un trigger. È quindi possibile monitorare le esecuzioni della pipeline nella sezione Monitoraggio di Azure Data Factory Studio.