Informazioni sui notebook e sulle pipeline di Azure Databricks

In Azure Databricks è possibile usare i notebook per eseguire codice scritto in Python, Scala, SQL e altri linguaggi per inserire ed elaborare i dati. I notebook offrono un'interfaccia interattiva in cui è possibile eseguire singole celle di codice e usare la sintassi di markdown per includere note e annotazioni.

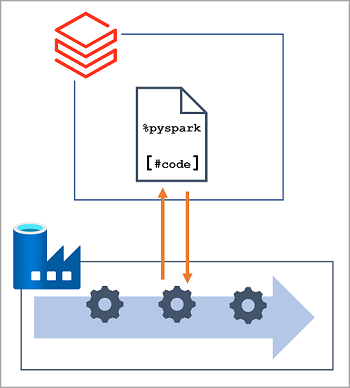

In molte soluzioni di ingegneria dei dati, il codice scritto e testato in modo interattivo può essere successivamente incorporato in un carico di lavoro di elaborazione dei dati automatizzato. In Azure, tali carichi di lavoro vengono spesso implementati come pipeline in Azure Data Factory, in cui una o più attività vengono usate per orchestrare una serie di attività eseguibili su richiesta, a intervalli pianificati o in risposta a un evento, ad esempio i nuovi dati caricati in una cartella in un data lake. Azure Data Factory supporta un'attività Notebook che può essere usata per automatizzare l'esecuzione automatica di un notebook in un'area di lavoro di Azure Databricks.

Nota

La stessa attività Notebook è disponibile nelle pipeline create in Azure Synapse Analytics.