Mitigare i potenziali danni

Dopo aver determinato una baseline e un modo per misurare l'output dannoso generato da una soluzione, è possibile adottare misure per attenuare i potenziali danni e, se appropriato, ritestare il sistema modificato e confrontare i livelli di danno rispetto alla baseline.

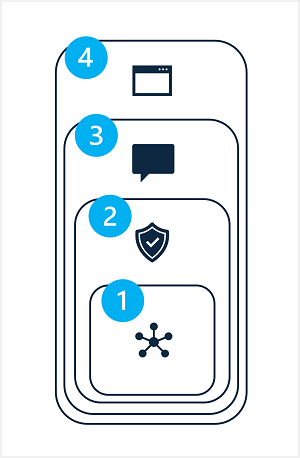

La mitigazione dei potenziali danni in una soluzione di intelligenza artificiale generativa prevede un approccio a livelli, in cui le tecniche di mitigazione possono essere applicate a ognuno dei quattro livelli, come illustrato di seguito:

- Modello

- Sistema di sicurezza

- Metaprompt e grounding

- Esperienza utente

1: Livello modello

Il livello del modello è costituito da uno o più modelli di intelligenza artificiale generativa al centro della soluzione. Ad esempio, la soluzione può essere compilata attorno a un modello, come GPT-4.

Le mitigazioni che è possibile applicare al livello del modello includono:

- Selezione di un modello appropriato per l'uso della soluzione prevista. Ad esempio, mentre GPT-4 può essere un modello potente e versatile, in una soluzione che deve solo classificare input di testo piccoli e specifici, un modello più semplice potrebbe fornire la funzionalità necessaria con un rischio inferiore di generazione di contenuto dannoso.

- Ottimizzazione di un modello di base con i propri dati di training in modo che le risposte generate siano più probabilmente rilevanti e facciano riferimento all'ambito per lo scenario della soluzione.

2: Livello del sistema di sicurezza

Il livello di sicurezza include configurazioni e funzionalità a livello di piattaforma che consentono di ridurre i danni. Ad esempio, Studio AI della piattaforma Azure include il supporto per i filtri di contenuto che applicano criteri per eliminare le richieste e le risposte in base alla classificazione del contenuto in quattro livelli di gravità (sicuro, basso, medio e alto) per quattro categorie di potenziali danni (odio, contenuti sessuali, violenza e autolesionismo).

Altre mitigazioni del livello di sicurezza possono includere algoritmi di rilevamento degli abusi per determinare se la soluzione viene sistematicamente abusata (ad esempio tramite volumi elevati di richieste automatizzate da un bot) e notifiche di avviso che consentono una risposta rapida a potenziali abusi di sistema o comportamenti dannosi.

3: il livello metaprompt e grounding

Il livello metaprompt e grounding si concentra sulla costruzione di richieste inviate al modello. Le tecniche di mitigazione dei danni che è possibile applicare a questo livello includono:

- Specifica di metaprompt o input di sistema che definiscono i parametri comportamentali per il modello.

- Applicazione della progettazione dei prompt per aggiungere dati di base ai prompt di input, ottimizzando la probabilità di un output rilevante e non dannoso.

- Uso di un approccio di generazione aumentata di recupero (RAG) per recuperare i dati contestuali da origini dati attendibili e includerli nelle richieste.

4: il livello di esperienza utente

Il livello esperienza utente include l'applicazione software tramite cui gli utenti interagiscono con il modello di intelligenza artificiale generativa e la documentazione o altri materiali collaterali dell'utente che descrivono l'uso della soluzione agli utenti e agli stakeholder.

La progettazione dell'interfaccia utente dell'applicazione per limitare gli input a soggetti o tipi specifici oppure l'applicazione della convalida dell'input e dell'output può ridurre il rischio di risposte potenzialmente dannose.

La documentazione e altre descrizioni di una soluzione di intelligenza artificiale generativa devono essere adeguatamente trasparenti sulle funzionalità e sulle limitazioni del sistema, sui modelli su cui si basa e su eventuali potenziali danni che potrebbero non essere sempre risolti dalle misure di mitigazione che sono state inserite.