Eseguire esperimenti con MLflow

Gli esperimenti in MLflow consentono ai data scientist di tenere traccia delle esecuzioni di training in una raccolta denominata esperimento. Le esecuzioni di esperimenti sono utili per confrontare le modifiche nel tempo o per confrontare le prestazioni relative dei modelli con valori iperparametrici diversi.

Esecuzione di un esperimento

La creazione di un esperimento in Azure Databricks avviene automaticamente all'avvio di un'esecuzione. Di seguito è riportato un esempio relativo all'avvio di un'esecuzione in MLflow, alla registrazione di due parametri e alla registrazione di una metrica:

with mlflow.start_run():

mlflow.log_param("input1", input1)

mlflow.log_param("input2", input2)

# Perform operations here like model training.

mlflow.log_metric("rmse", rmse)

In questo caso il nome dell'esperimento è il nome del notebook. È possibile esportare una variabile denominata MLFLOW_EXPERIMENT_NAME per modificare il nome dell'esperimento, se si vuole.

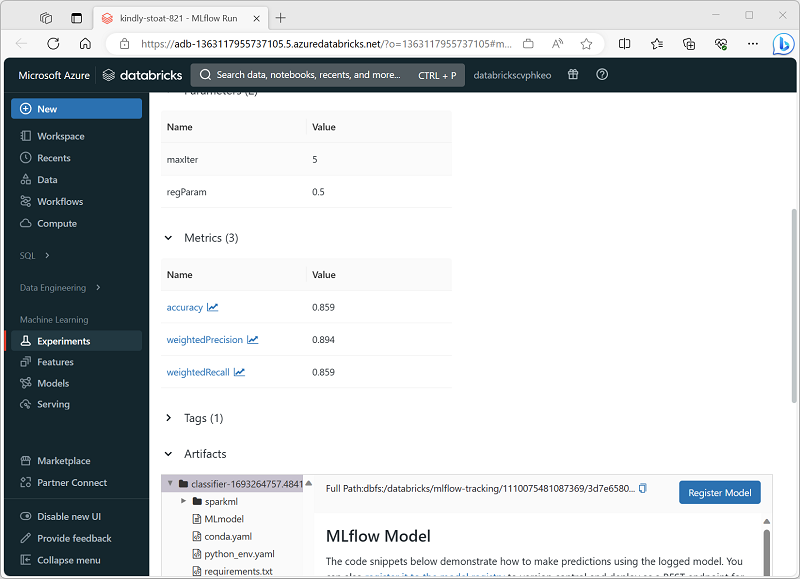

Revisione di un'esecuzione di un esperimento

Nella pagina Esperimenti del portale di Azure Databricks è possibile visualizzare i dettagli di ogni esecuzione di esperimento, inclusi i valori registrati per parametri, metriche e altri artefatti.