Comprendere il processo di data science

Un modo comune per estrarre informazioni dettagliate dai dati consiste nel visualizzare i dati. Ogni volta che si hanno set di dati complessi, è possibile approfondire e provare a trovare modelli complessi in tali dati.

Come scienziato dei dati, è possibile eseguire il training dei modelli di Machine Learning per trovare modelli nei dati. È possibile usare questi modelli per generare nuove informazioni dettagliate o stime. Ad esempio, è possibile prevedere il numero di prodotti che si prevede di vendere nella prossima settimana.

Anche se il training del modello è importante, non è l'unica attività in un progetto di data science. Prima di esplorare un processo tipico di data science, è possibile esplorare i modelli comuni di Machine Learning che è possibile sottoporre a training.

Esplorare i modelli comuni di Machine Learning

Lo scopo dell'apprendimento automatico è eseguire il training dei modelli al fine di identificare altri modelli in grandi quantità di dati. È quindi possibile usare i modelli per effettuare stime che forniscono nuove informazioni dettagliate da prendere come base per eseguire azioni.

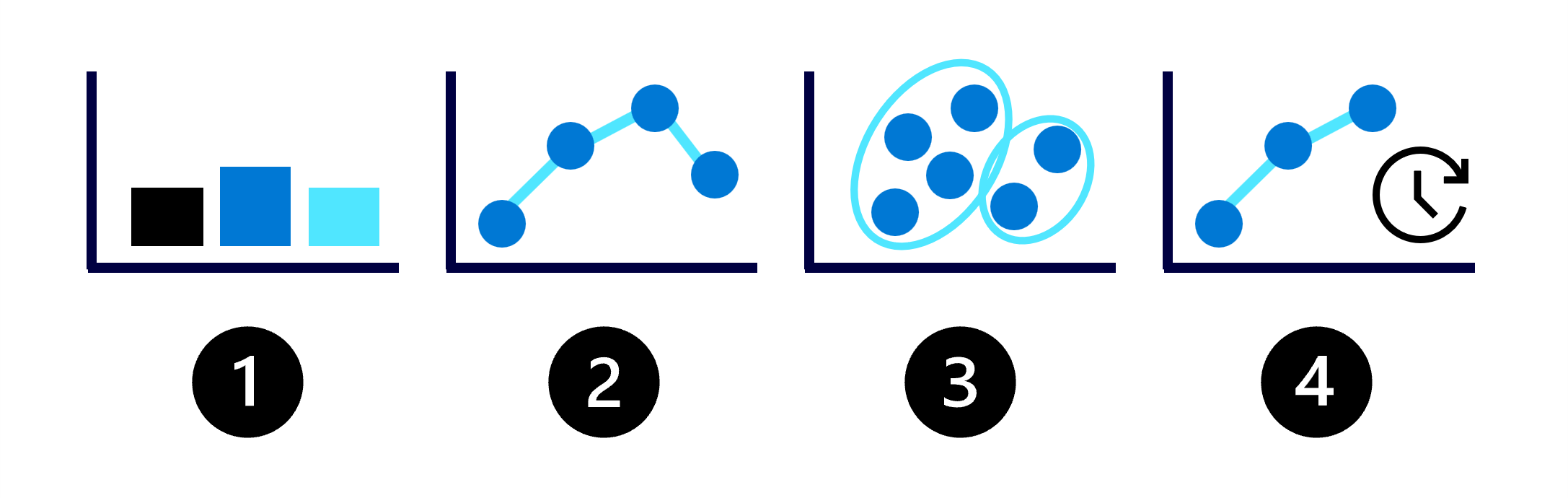

Le possibilità di Machine Learning possono apparire infinite, quindi è possibile iniziare comprendendo i quattro tipi comuni di modelli di Machine Learning:

- Classificazione: stimare un valore categorico, ad esempio se un cliente potrebbe non esserlo più in futuro.

- Regressione: stimare un valore numerico come il prezzo di un prodotto.

- Clustering: raggruppare punti dati simili in cluster o gruppi.

- Previsione: stimare i valori numerici futuri in base ai dati delle serie temporali come le vendite previste per il prossimo mese.

Per decidere di quale tipo di modello di Machine Learning è necessario eseguire il training, è prima necessario comprendere il problema aziendale e i dati disponibili.

Comprendere il processo di data science

Per eseguire il training di un modello di Machine Learning, il processo prevede in genere i passaggi seguenti:

- Definire il problema: insieme agli utenti aziendali e agli analisti, decidere cosa deve prevedere il modello e quando ha esito positivo.

- Ottenere i dati: trovare le origini dati e ottenere l'accesso archiviando i dati in un lakehouse.

- Preparare i dati: esplorare i dati leggendo i dati da una lakehouse in un notebook. Pulire e trasformare i dati in base ai requisiti del modello.

- Eseguire il training del modello: scegliere un algoritmo e valori di iperparametri in base alla valutazione e all'errore monitorando gli esperimenti con MLflow.

- Generare informazioni dettagliate: usare l'assegnazione dei punteggi batch del modello per generare le stime richieste.

Come scienziato dei dati, la maggior parte del tempo viene impiegato per preparare i dati e il training del modello. Come preparare i dati e l'algoritmo scelto per eseguire il training di un modello possono influire sul successo del modello.

È possibile preparare ed eseguire il training di un modello usando librerie open source disponibili per la lingua desiderata. Ad esempio, se si usa Python, è possibile preparare i dati con Pandas e Numpy ed eseguire il training di un modello con librerie come Scikit-Learn, PyTorch o SynapseML.

Quando si esegue l'esperimento, si vuole mantenere una panoramica di tutti i diversi modelli sottoposti a training. Si vuole comprendere come le scelte influiscono sul successo del modello. Tenendo traccia degli esperimenti con MLflow in Microsoft Fabric, è possibile gestire e distribuire facilmente i modelli sottoposti a training.