Identificare i carichi di lavoro di Azure Databricks

Azure Databricks offre capacità per vari carichi di lavoro, tra cui Apprendimento automatico e Modelli linguistici di grandi dimensioni (LLM), Data science, Ingegneria dei dati, BI e Data Warehousing, e elaborazione dello streaming.

Data Science and Engineering

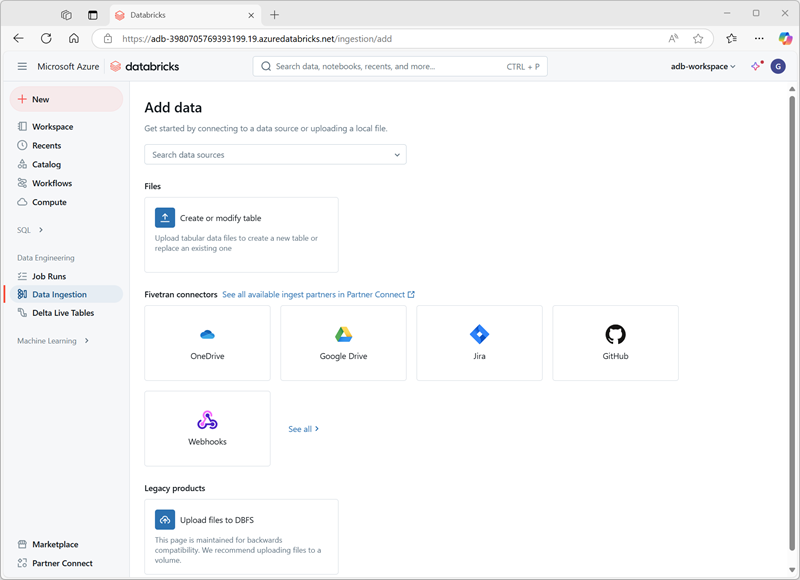

Tale carico di lavoro è progettato per data scientist e ingegneri dei dati che hanno bisogno di collaborare ad attività di elaborazione dati complesse. Offre un ambiente integrato con Apache Spark per l'elaborazione di Big Data in un data lakehouse e supporta diversi linguaggi, tra cui Python, R, Scala e SQL. La piattaforma facilita l'esplorazione, la visualizzazione e lo sviluppo di pipeline di dati.

Machine Learning

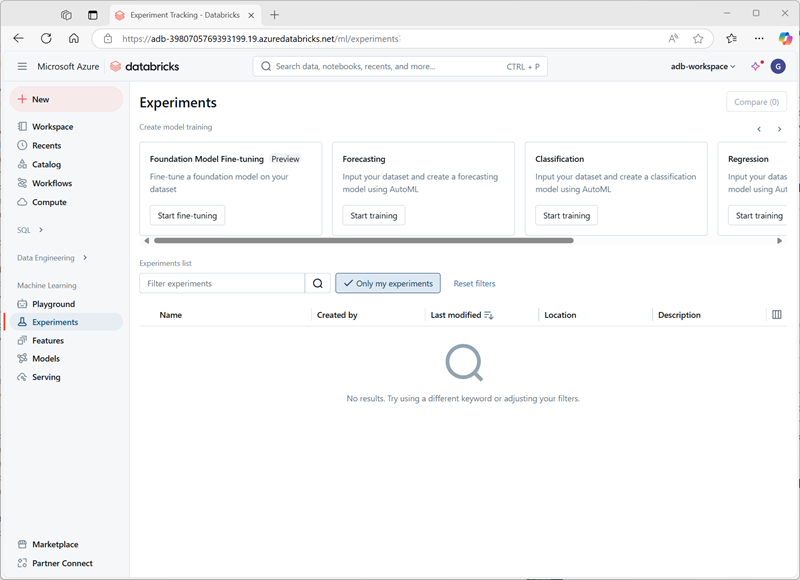

Il carico di lavoro di Apprendimento automatico in Azure Databricks è ottimizzato per la creazione, il training e la distribuzione di modelli di apprendimento automatico su larga scala. Include MLflow, una piattaforma open source per gestire il ciclo di vita di ML, tra cui sperimentazione, riproducibilità e distribuzione. Supporta inoltre vari framework ML, come TensorFlow, PyTorch e Scikit-learn, e rappresenta quindi una scelta versatile per varie attività ML.

SQL

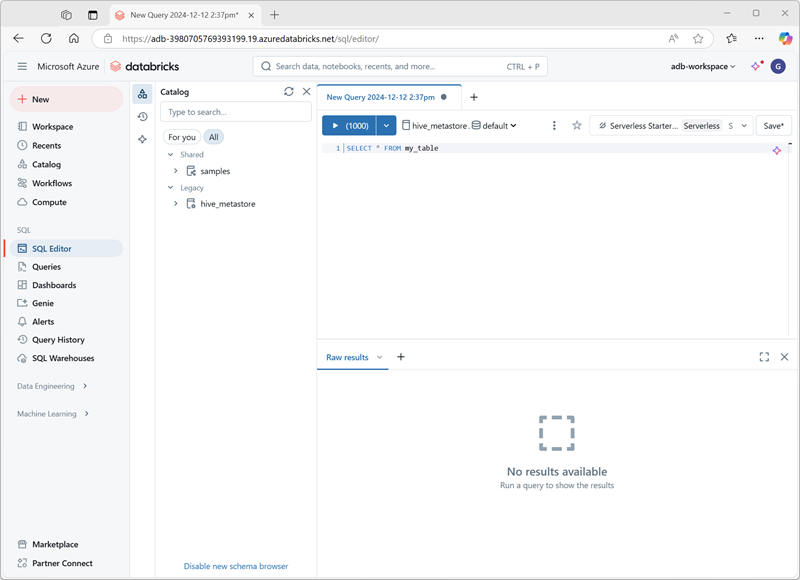

Il carico di lavoro SQL è destinato agli analisti dei dati che interagiscono principalmente con i dati tramite SQL. Offre un editor SQL familiare, dashboard e strumenti di visualizzazione automatica per analizzare e visualizzare i dati direttamente in Azure Databricks. Tale carico di lavoro è ideale per l'esecuzione di query ad-hoc rapide e la creazione di report da set di dati di grandi dimensioni.