Esercitazione: Usare un notebook con Apache Spark per eseguire query su un database KQL

I notebook sono sia documenti leggibili contenenti descrizioni e risultati dell'analisi dei dati che documenti eseguibili per effettuare l'analisi dei dati. Questo articolo illustra come usare un notebook di Microsoft Fabric per leggere e scrivere dati in un database KQL usando Apache Spark. In questa esercitazione vengono usati set di dati e notebook creati in precedenza sia nell’Intelligence in tempo reale che negli ambienti di ingegneria dei dati in Microsoft Fabric. Per altre informazioni sui notebook, vedere Come usare i notebook di Microsoft Fabric.

In particolare, si apprenderà come:

- Creare un database KQL

- Importare un notebook

- Scrivere dati in un database KQL usando Apache Spark

- Eseguire query sui dati da un database KQL

Prerequisiti

- Un'area di lavoro con una capacità abilitata per Microsoft Fabric

1- Creare un database KQL

Seleziona la tua area di lavoro dalla barra di navigazione a sinistra.

Seguire uno di questi passaggi per iniziare a creare un flusso di eventi:

- Selezionare Nuovo Elemento e quindi Eventhouse . Nel campo eventhouse nome immettere nycGreenTaxi, quindi selezionare Crea. Viene generato un database KQL con lo stesso nome.

- In una eventhouse esistente, selezionare Database. Nei database KQL selezionare +, nel campo nome del database KQL inserire nycGreenTaxi, quindi selezionare Crea.

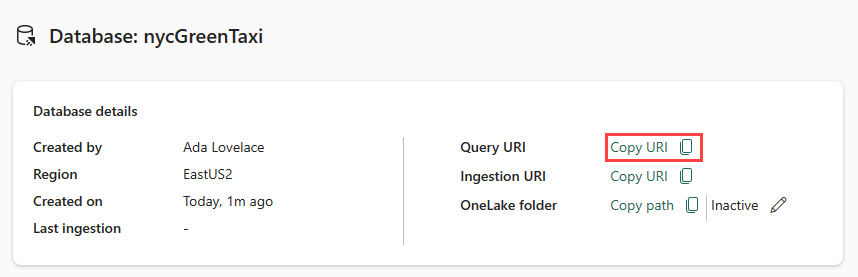

Copiare l'URI della query dalla scheda dei dettagli del database nel dashboard del database e incollarlo in un punto qualsiasi, ad esempio un Blocco note di Windows, da usare in un passaggio successivo.

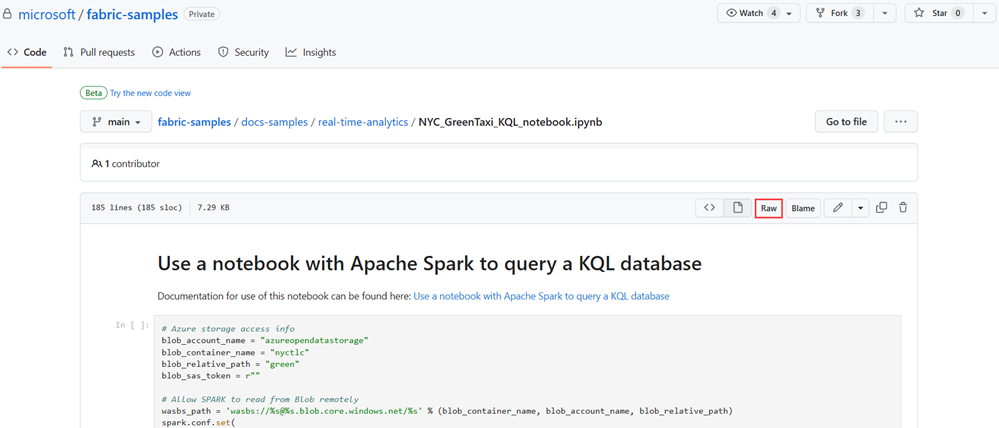

2- Scaricare il notebook di NYC GreenTaxi

È stato creato un notebook di esempio che illustra tutti i passaggi necessari per caricare i dati nel database usando il connettore Spark.

Aprire il repository degli esempi di Fabric in GitHub per scaricare il notebook KQL di NYC GreenTaxi.

Salvare il notebook in locale nel dispositivo.

Nota

Il notebook deve essere salvato nel formato di file

.ipynb.

3- Importare il Notebook

Il resto di questo workflow si verifica nella sezione Ingegneria dei dati del prodotto e usa un notebook Spark per caricare ed eseguire query sui dati nel database KQL.

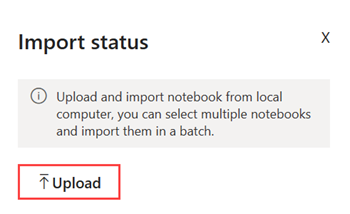

Nell'area di lavoro selezionare Importa>Notebook>Da questo computer>Carica, quindi scegliere il notebook NYC GreenTaxi scaricato in un passaggio precedente.

Al termine dell'importazione, aprire il notebook dall'area di lavoro.

4- Ottenere i dati

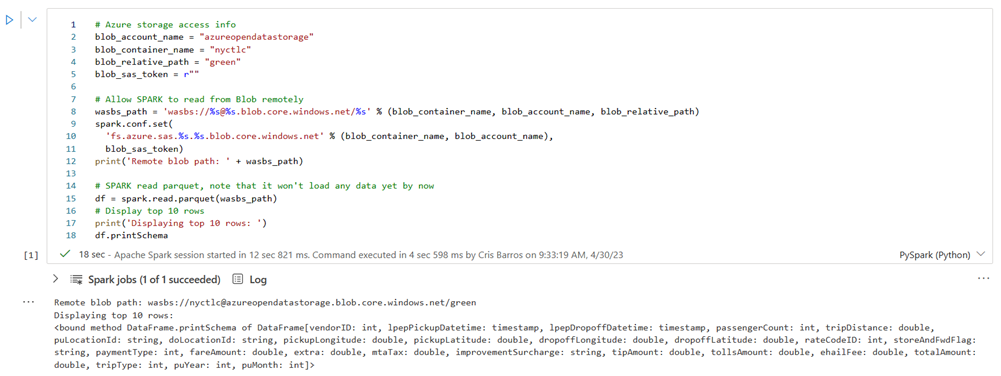

Per eseguire query sul database usando il connettore Spark, è necessario concedere l'accesso in lettura e scrittura al contenitore BLOB NYC GreenTaxi.

Selezionare il pulsante esegui per eseguire le celle seguenti oppure selezionare la cella e premere Maiusc + Invio. Ripetere questo passaggio per ogni cella di codice.

Nota

Attendere che venga visualizzato il segno di spunta di completamento prima di eseguire la cella successiva.

Eseguire la cella seguente per abilitare l'accesso al contenitore BLOB NYC GreenTaxi.

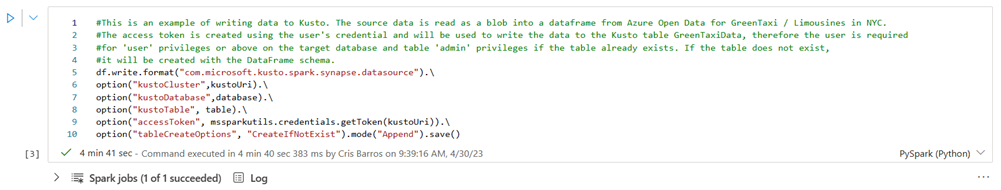

In KustoURI incollare l'URI di querycopiato in precedenza anziché il testo segnaposto.

Modificare il nome del database segnaposto in nycGreenTaxi.

Modificare il nome della tabella segnaposto in GreenTaxiData.

Eseguire la cella.

Eseguire la cella successiva per scrivere dati nel database. Il completamento di questo passaggio può richiedere alcuni minuti.

Il database include ora i dati caricati in una tabella denominata GreenTaxiData.

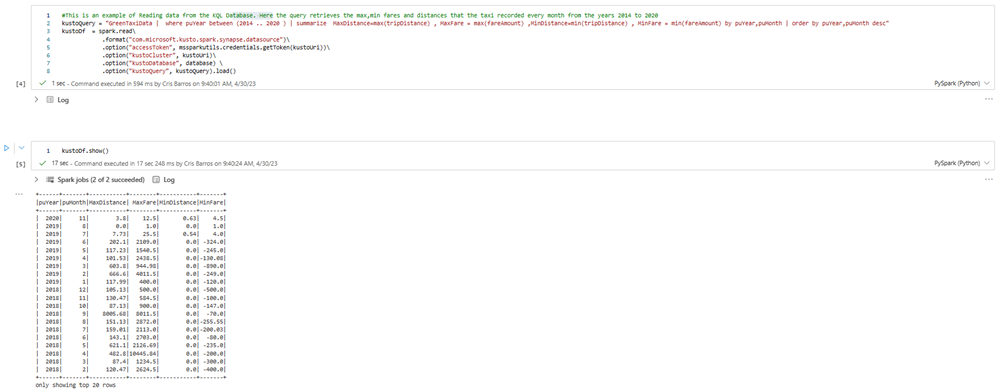

5- Aprire il notebook

Eseguire le due celle rimanenti in sequenza per eseguire query sui dati dalla tabella. I risultati mostrano le 20 tariffe e distanze dei taxi più alte e più basse registrate per anno.

6- Eseguire la pulizia delle risorse

Eseguire la pulizia degli elementi creati passando all'area di lavoro in cui sono stati creati.

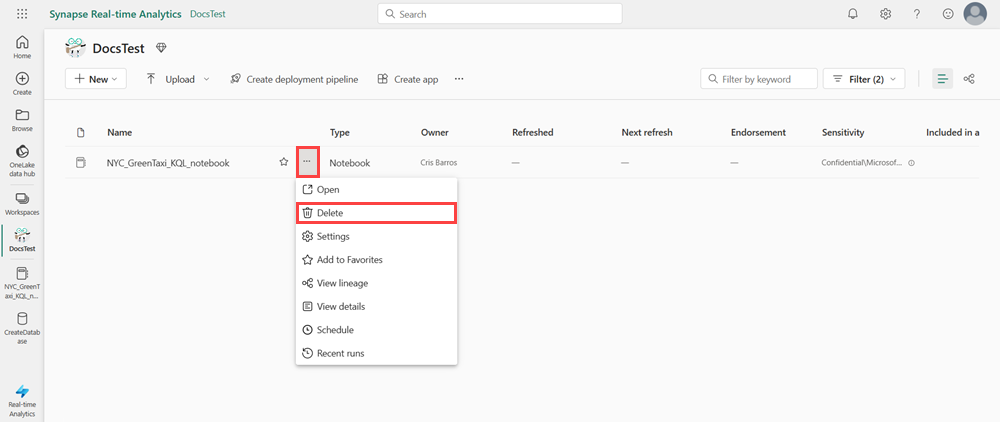

Nell'area di lavoro passare il puntatore del mouse sul notebook che si vuole eliminare, selezionare il menu Altro [...] >Elimina.

Selezionare Elimina. Non è possibile recuperare il notebook dopo averlo eliminato.