Esercitazione: Inserire dati in un warehouse

Si applica a✅: warehouse in Microsoft Fabric

Questa esercitazione illustra come inserire dati da Archiviazione di Microsoft Azure in un warehouse per creare tabelle.

Nota

Questa esercitazione fa parte di uno scenario end-to-end . Per completare questa esercitazione, è prima necessario completare queste esercitazioni:

Inserire i dati

In questa attività viene illustrato come inserire dati nel warehouse per creare tabelle.

Assicurati che il workspace creato nel primo tutorial sia aperto.

Nel riquadro di destinazione dell'area di lavoro, selezionare + Nuovo Elemento per visualizzare l'elenco completo dei tipi di elementi disponibili.

Nell'elenco, nella sezione Recupera dati, selezionare il tipo di elemento pipeline di dati.

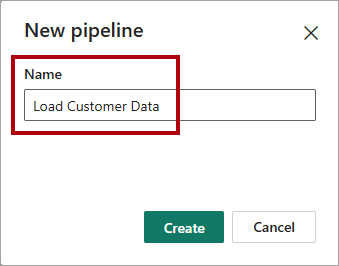

Nella finestra Nuova pipeline, immettere

Load Customer Datanella casella Nome.

Per configurare la pipeline, selezionare Crea. Il provisioning viene completato quando viene visualizzata la pagina di destinazione Creare una pipeline di dati.

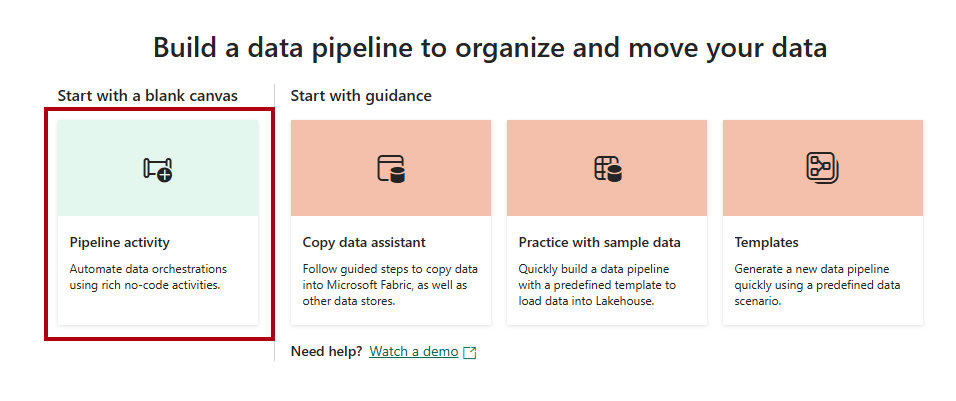

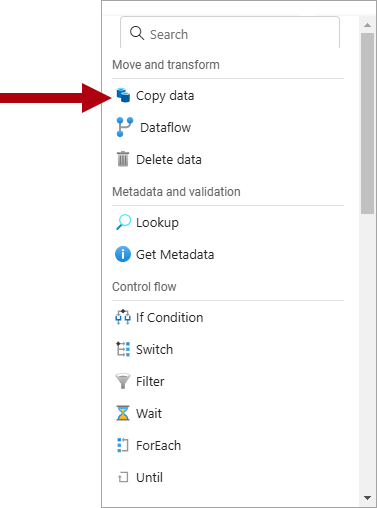

Nella pagina di destinazione della pipeline di dati, selezionare Attività della pipeline .

Nel menu, dall'interno della sezione Sposta e trasforma, seleziona Copia dati.

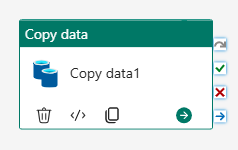

Nell'area di disegno della pipeline selezionare l'attività Copia dati.

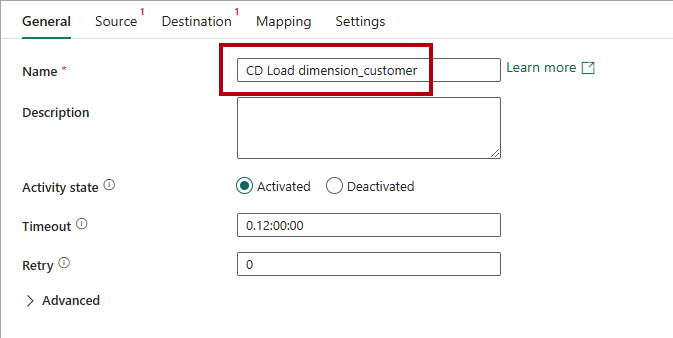

Per configurare l'attività, nella pagina Generale, nella casella Nome, sostituire il testo predefinito con

CD Load dimension_customer.

Nella pagina origine, nell'elenco a discesa Connessione, selezionare Più per visualizzare tutte le origini dati tra cui scegliere, incluse le origini dati nel catalogo OneLake.

Selezionare + Nuovo per creare una nuova origine dati.

Cerca e poi seleziona BLOB di Azure.

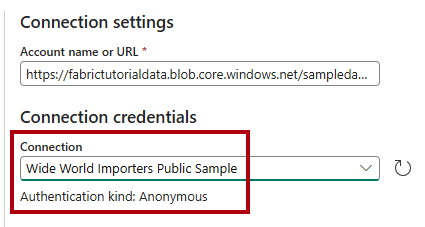

Nella pagina Connect data source (Connetti origine dati), nella casella Nome account o URL, immettete

https://fabrictutorialdata.blob.core.windows.net/sampledata/.Si noti che l'elenco a discesa nome connessione viene popolato automaticamente e che la modalità di autenticazione è impostata su anonimo.

Selezionare Connetti.

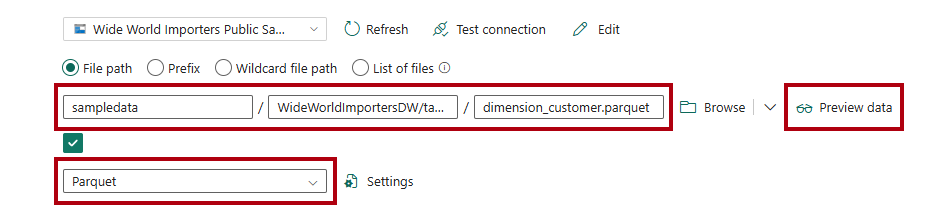

Nella pagina origine, per accedere ai file Parquet nell'origine dati, completare le impostazioni seguenti:

Nelle caselle percorso file immettere:

Percorso file - Contenitore:

sampledataPercorso file - Directory:

WideWorldImportersDW/tablesPercorso file - Nome file:

dimension_customer.parquet

Nell'elenco a discesa del formato file , selezionare Parquet.

Per visualizzare in anteprima i dati e verificare che non siano presenti errori, selezionare Anteprima dati.

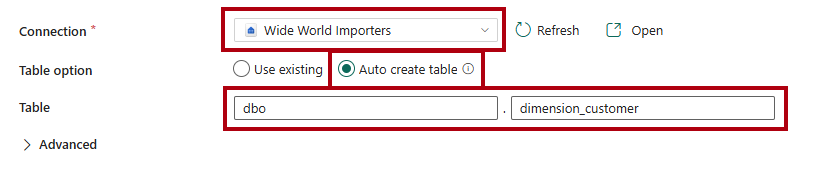

Nella pagina destinazione

selezionare il magazzino nell'elenco a discesa connessione . Per 'opzione Tabella, selezionare l'opzione Creazione automatica tabella.

Nella prima casella Tabella

immettere . Nella seconda casella immettere

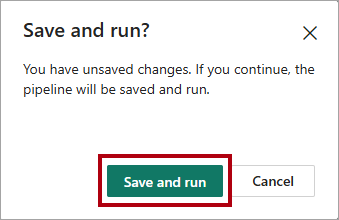

dimension_customer.Nella barra multifunzione Home selezionare Esegui.

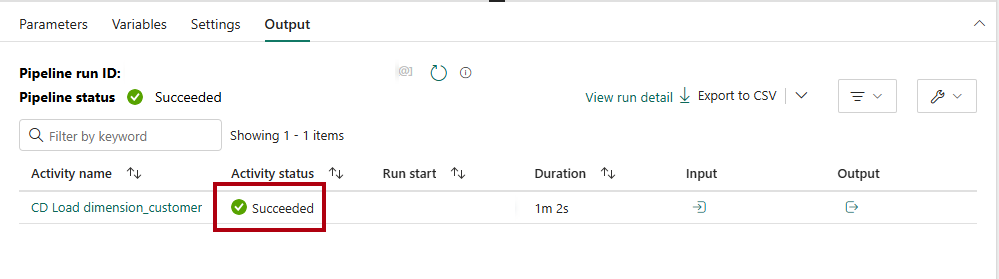

Nella finestra di dialogo Salva ed esegui?, selezionare Salva ed esegui per caricare la tabella

dimension_customerdella pipeline.

Per monitorare lo stato di avanzamento dell'attività di copia, esaminare le attività di esecuzione della pipeline nella pagina Output (attendere il completamento con uno stato Riuscito).