Ammissione di processi in Apache Spark per Microsoft Fabric

Si applica a:✅ ingegneria dei dati e data science in Microsoft Fabric

Apache Spark per Fabric usa la tecnica di ammissione ottimistica dei processi per determinare il requisito minimo di core per i processi Spark. Questo processo è applicabile a processi interattivi o batch da notebook, lakehouse o definizioni processo Spark. Si basa sull'impostazione del numero minimo di nodi del pool di Spark scelto nelle impostazioni dell'area di lavoro o nell'ambiente collegato. Se i core disponibili si trovano nella capacità di Fabric collegata all'area di lavoro, il processo viene accettato e inizia l'esecuzione. I processi iniziano con l'impostazione del numero minimo di nodi e possono aumentare entro i limiti del numero massimo di nodi in base alle fasi del processo. Se i core totali usati dai processi in esecuzione che usano la capacità di Fabric sono inferiori al numero massimo di core burst assegnati, il livello di ammissione e limitazione dei processi in Fabric Spark consente di aumentare il processo.

Per altre informazioni, vedere Limiti di concorrenza e accodamento in Microsoft Fabric Spark.

Come funziona l'ammissione dei processi ottimistica?

In Fabric, i pool di avvio sono dotati di un numero minimo predefinito di nodi, mentre i pool personalizzati consentono di impostare il numero minimo di nodi in base alle esigenze del carico di lavoro. La scalabilità automatica regola i requisiti di calcolo per i processi Spark durante le fasi di esecuzione, entro il numero minimo e massimo di nodi configurati. L'ammissione dei processi ottimistica valuta gli invii dei processi in base ai core disponibili ed esegue i processi con un numero minimo di core. I processi tentano di aumentare in base al numero massimo di nodi allocati durante l'esecuzione. Le richieste di aumento vengono approvate se il numero totale di core Spark usati rientra nei limiti della capacità allocata.

Nota

Se l'utilizzo raggiunge il limite massimo e tutti i core all'interno della capacità totale per Fabric sono in uso, eventuali richieste di aumento verranno rifiutate. I processi attivi devono essere completati o annullati per liberare core.

In che modo questo influisce sulla concorrenza dei processi?

Il requisito minimo di core per ogni processo determina se il processo può essere accettato. Se la capacità è usata completamente e non ha core lasciati per soddisfare i requisiti minimi di core di un processo, il processo viene rifiutato. I processi del notebook interattivo o le operazioni lakehouse verranno bloccati con un messaggio di errore Impossibile inviare questa richiesta perché è in uso tutta la capacità disponibile. Annullare un processo in esecuzione, aumentare la capacità disponibile o riprovare più tardi. I processi batch vengono accodati ed eseguiti dopo che i core diventano disponibili.

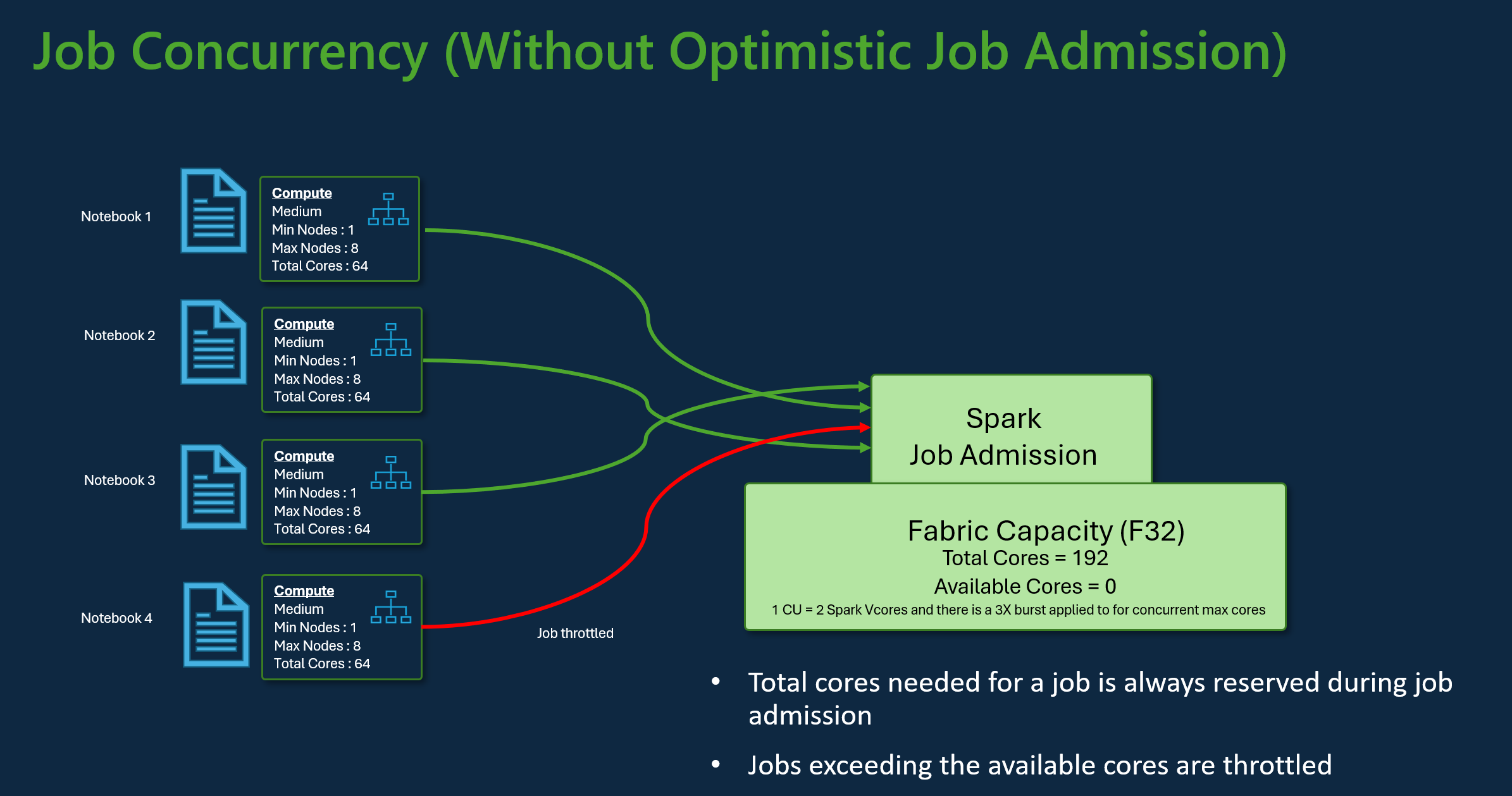

Si consideri, ad esempio, uno scenario con un utente che usa lo SKU di capacità F32 di Fabric. Supponendo che tutti i processi usino la configurazione predefinita del pool di avvio senza l'ammissione ottimistica dei processi, la capacità supporterebbe una concorrenza massima di tre processi. Il numero massimo di core per processo viene allocato in base alla configurazione massima dei nodi.

Con l'ammissione ottimistica dei processi con la stessa capacità precedente, è possibile ammettere ed eseguire 24 processi usando la configurazione minima dei nodi durante lo scenario di concorrenza massima. Ciò perché ogni processo richiede 8 VCore Spark in cui una configurazione minima di nodi è di dimensioni medie.

Ridimensionare i processi con scalabilità automatica di Spark

Quando si abilita la scalabilità automatica per i pool di Spark, i processi vengono eseguiti con la configurazione minima del nodo. Durante il runtime, può verificarsi il ridimensionamento. Queste richieste passano attraverso il controllo di ammissione dei processi. Le richieste approvate aumentano fino ai limiti massimi in base ai core totali disponibili. Le richieste rifiutate non influiscono sui processi attivi, che continuano a essere eseguiti con la configurazione corrente fino a quando non diventano disponibili i core.

Nota

Per garantire l'allocazione massima dei core per un processo in base alla configurazione massima dei nodi, disabilitare la scalabilità automatica e impostare il numero massimo di nodi all'interno dello SKU di capacità di Fabric. In questo caso, poiché il processo non ha requisiti minimi di core, l'esecuzione verrà avviata quando sono disponibili core gratuiti, aumentando fino al totale configurato. Se la capacità è usata completamente, i processi interattivi del notebook potrebbero rallentare o accodarsi. I processi in coda vengono ritentati automaticamente man mano che i core diventano disponibili.

Contenuto correlato

- Introduzione alle impostazioni di amministrazione dell'area di lavoro di Spark in Microsoft Fabric.

- Informazioni sull'ambiente di calcolo per ingegneria dei dati e data science di Fabric.

- Altre informazioni sui limiti di concorrenza e accodamento per Fabric Spark.