Creazione di report di fatturazione e utilizzo per Apache Spark in Microsoft Fabric

Si applica a:✅ ingegneria dei dati e data science in Microsoft Fabric

Questo articolo illustra l'utilizzo e la creazione di report di calcolo per ApacheSpark che supporta i carichi di lavoro fabric Ingegneria dei dati e science in Microsoft Fabric. L'utilizzo del calcolo include operazioni di lakehouse come l'anteprima della tabella, il caricamento su Delta, le esecuzioni dei notebook dall'interfaccia, le esecuzioni pianificate, le esecuzioni attivate dai passaggi dei notebook nelle pipeline e le esecuzioni di definizione del processo Apache Spark.

Analogamente ad altre esperienze in Microsoft Fabric, Ingegneria dei dati usa anche la capacità associata a un'area di lavoro per eseguire questi processi e gli addebiti complessivi per la capacità appaiono nel portale di Azure nella sottoscrizione di Gestione dei costi Microsoft. Per altre informazioni sulla fatturazione di Fabric, vedere Informazioni sulla fattura di Azure per una capacità di Fabric.

Capacità di Fabric

L'utente può acquistare una capacità di Fabric da Azure specificando l'uso di una sottoscrizione di Azure. La dimensione della capacità determina la quantità di potenza di calcolo disponibile. Per Apache Spark per Fabric, ogni CU acquistata si traduce in 2 VCore Apache Spark. Ad esempio, se si acquista una capacità di Fabric F128, questa si traduce in 256 SparkVCores. Una capacità di Fabric viene condivisa in tutte le aree di lavoro aggiunte e in cui il calcolo totale di Apache Spark consentito viene condiviso tra tutti i processi inviati da tutte le aree di lavoro associate a una capacità. Per informazioni sui diversi SKU, sull'allocazione dei core e sulla limitazione in Spark, vedere Limiti di concorrenza e accodamento in Apache Spark per Microsoft Fabric.

Configurazione di calcolo Spark e capacità acquistata

Il calcolo di Apache Spark per Fabric offre due opzioni per la configurazione del calcolo.

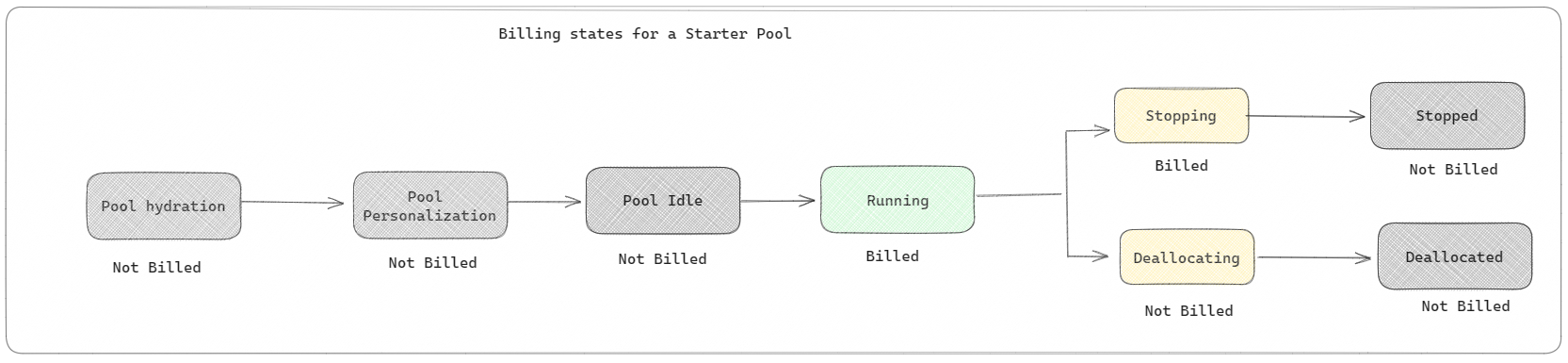

Pool di avvio: questi pool predefiniti sono un modo semplice e veloce per usare Spark nella piattaforma Microsoft Fabric in pochi secondi. È possibile usare immediatamente le sessioni Spark invece di attendere che Spark configuri automaticamente i nodi, per cui è possibile eseguire altre operazioni con i dati e ottenere informazioni dettagliate in maniera più rapida. Riguardo alla fatturazione e al consumo della capacità, viene effettuato l'addebito quando si avvia l'esecuzione del notebook o della definizione del processo Spark, o del funzionamento del lakehouse. Non viene addebitato il tempo in cui i cluster sono inattivi nel pool.

Ad esempio, se si invia un processo del notebook a un pool di avvio, viene fatturato solo il periodo di tempo in cui la sessione del notebook è attiva. Il tempo fatturato non include il tempo di inattività o il tempo impiegato per personalizzare la sessione con il contesto Spark. Per altre informazioni sulla configurazione dei pool di avvio in base allo SKU della capacità di Fabric acquistata, vedere Configurazione dei pool di avvio in base alla capacità di Fabric

Pool di Spark: si tratta di pool su misura, in cui è possibile personalizzare le dimensioni delle risorse necessarie per le attività di analisi dei dati. È possibile assegnare un nome al pool di Spark e scegliere il numero e le dimensioni dei nodi (i computer che eseguono il lavoro). È anche possibile indicare a Spark come modificare il numero di nodi a seconda della quantità di lavoro da eseguire. La creazione di un pool di Spark è gratuita; si paga solo quando si esegue un processo Spark nel pool e quindi Spark configura automaticamente i nodi.

- Le dimensioni e il numero di nodi che è possibile avere in un pool di Spark personalizzato dipendono dalla capacità di Microsoft Fabric. È possibile usare questi VCore Spark per creare nodi di dimensioni diverse per il pool di Spark personalizzato, purché il numero totale di VCore Spark non sia superiore a 128.

- I pool di Spark vengono fatturati come pool di avvio; non si paga per i pool di Spark personalizzati creati, a meno che non sia stata creata una sessione Spark attiva per l'esecuzione di un notebook o una definizione processo Spark. La fatturazione avviene solo per la durata delle esecuzioni del processo. La fatturazione non avviene per le fasi come la creazione e la deallocazione del cluster al termine del processo.

Ad esempio, se si invia un processo del notebook a un pool di Spark personalizzato, verrà effettuato l'addebito solo per il periodo di tempo in cui la sessione è attiva. La fatturazione per tale sessione del notebook si arresta dopo che la sessione Spark è stata arrestata o è scaduta. Non viene addebitato il tempo per l'acquisizione delle istanze del cluster dal cloud o per tempo impiegato per l'inizializzazione del contesto Spark. Per altre informazioni sulla configurazione di pool di Spark in base allo SKU di capacità di Fabric acquistata, vedere Configurazione dei pool in base alla capacità di Fabric

Nota

Il periodo di scadenza della sessione predefinito per i pool di avvio e i pool di Spark creati è impostato su 20 minuti. Se non si usa il pool di Spark per 2 minuti dopo la scadenza della sessione, il pool di Spark verrà deallocato. Per arrestare la sessione e la fatturazione dopo aver completato l'esecuzione del notebook prima del periodo di scadenza della sessione, è possibile fare clic sul pulsante Arresta sessione dal menu Home dei notebook oppure andare alla pagina dell'hub di monitoraggio e arrestare la sessione.

Creazione di report sull'utilizzo delle risorse di calcolo Spark

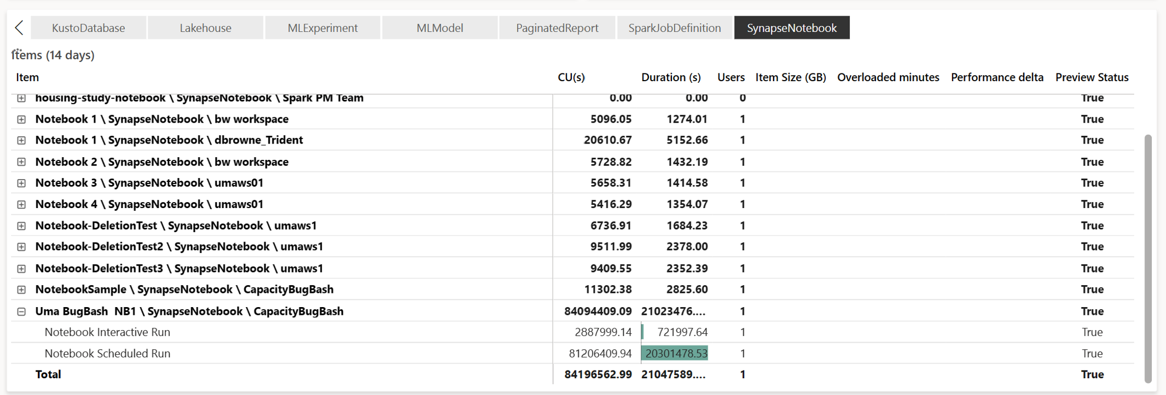

L'app Microsoft Fabric Capacity Metrics offre visibilità sull'utilizzo della capacità per tutti i carichi di lavoro di Fabric in un'unica posizione. Viene usato dagli amministratori della capacità per monitorare le prestazioni dei carichi di lavoro e il relativo utilizzo rispetto alla capacità acquistata.

Dopo aver installato l'app, selezionare il tipo di elemento Notebook, Lakehouse, Definizione del processo Spark nell'elenco a discesa Seleziona tipologia di elemento. Il grafico a nastri Multi metrica può ora essere adattato in base a un intervallo di tempo desiderato per comprendere l'utilizzo da tutti questi elementi selezionati.

Tutte le operazioni correlate a Spark vengono classificate come operazioni in background. Il consumo di capacità da Spark viene visualizzato in un notebook, in una definizione processo Spark o in un lakehouse e viene aggregato in base al nome e all'elemento dell'operazione. Ad esempio: se si esegue un processo del notebook, è possibile visualizzare l'esecuzione del notebook, le CU usate dal notebook (Spark VCores/2 totali come 1 CU fornisce 2 VCore Spark), la durata del processo nel report.

Per altre informazioni sulla creazione di report sull'utilizzo della capacità spark, vedere Monitorare il consumo di capacità di Apache Spark

Per altre informazioni sulla creazione di report sull'utilizzo della capacità spark, vedere Monitorare il consumo di capacità di Apache Spark

Esempio di fatturazione

Prendi in considerazione lo scenario seguente:

È presente una capacità C1 che ospita un'area di lavoro di Fabric W1 e questa area di lavoro contiene un Lakehouse LH1 e un Notebook NB1.

- Qualsiasi operazione Spark eseguita dal notebook(NB1) o dal lakehouse(LH1) viene riportata rispetto alla capacità C1.

Estendiamo questo esempio a uno scenario in cui è presente un'altra capacità C2 che ospita un'area di lavoro di Fabric W2 e diciamo che questa area di lavoro contiene una definizione del processo Spark (SJD1) e un Lakehouse (LH2).

- Se la definizione del processo Spark (SDJ2) dall'area di lavoro (W2) legge i dati dal Lakehouse (LH1), l'utilizzo viene riportato rispetto alla capacità C2 associata all'area di lavoro (W2) che ospita l'elemento.

- Se il notebook (NB1) esegue un'operazione di lettura dal Lakehouse (LH2), il consumo di capacità viene riportato rispetto alla capacità C1 che alimenta l'area di lavoro W1 che ospita l'elemento del notebook.