Parallelizzare l'ottimizzazione di iperparametri con Hyperopt

Nota

La versione open source di Hyperopt non è più gestita.

Hyperopt verrà rimosso nella prossima versione principale di DBR ML. Azure Databricks consiglia di usare Optuna per l'ottimizzazione a nodo singolo oppure RayTune per un'esperienza simile alla funzionalità di ottimizzazione degli iperparametri di Hyperopt distribuita e deprecata. Altre informazioni sull'uso di RayTune in Azure Databricks.

Questo notebook illustra come usare Hyperopt per parallelizzare i calcoli di ottimizzazione degli iperparametri. Usa la SparkTrials classe per distribuire automaticamente i calcoli tra i ruoli di lavoro del cluster. Illustra anche il rilevamento automatizzato di MLflow delle esecuzioni di Hyperopt in modo da poter salvare i risultati per un secondo momento.

Parallelizzare l'ottimizzazione degli iperparametri con il notebook di rilevamento automatizzato di MLflow

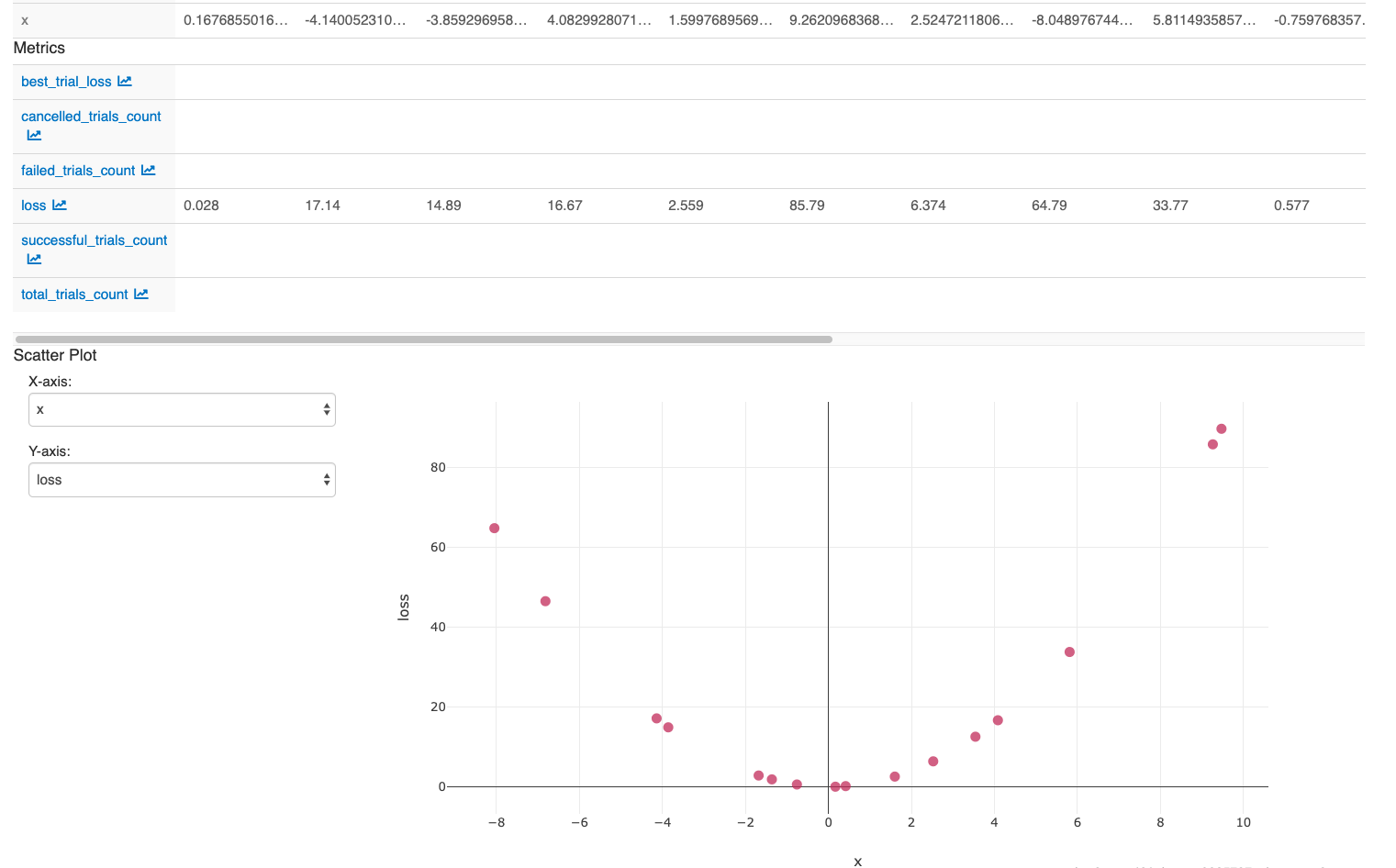

Dopo aver eseguito le azioni nell'ultima cella del notebook, dovrebbe venir visualizzata l'interfaccia utente di MLflow: