Riferimento per la configurazione ambiente di calcolo

Questo articolo illustra le impostazioni di configurazione disponibili nell'interfaccia utente Crea ambiente di calcolo. La maggior parte degli utenti crea risorse di calcolo utilizzando i criteri assegnati, il che limita le impostazioni configurabili. Se non viene visualizzata una particolare impostazione nell'interfaccia utente, il criterio selezionato non consente di configurare quella impostazione.

Le configurazioni e gli strumenti di gestione descritti in questo articolo si applicano sia al calcolo universale che al calcolo di processi. Per altre considerazioni sulla configurazione del calcolo dei processi, si veda Configurare il calcolo per i processi.

Creare una nuova risorsa di calcolo universale

Per creare una nuova risorsa di calcolo universale:

- Nella barra laterale della console dell'account fare clic su Ambiente di calcolo.

- Fare clic sul pulsante Crea ambiente di calcolo.

- Configurare le risorse dell’ambiente di calcolo.

- Fare clic su Crea ambiente di calcolo.

La nuova risorsa di calcolo verrà avviata automaticamente e in breve tempo sarà pronta per essere usata.

Criteri

I criteri sono set di regole usate per limitare le opzioni di configurazione disponibili agli utenti quando creano risorse di calcolo. Se un utente non ha il diritto di creazione di cluster senza restrizioni, può creare solo risorse di calcolo usando i criteri concessi.

Per creare risorse di calcolo in base a un criterio, selezionare un criterio dal menu a discesa Criteri.

Per impostazione predefinita, tutti gli utenti hanno accesso ai criteri di Ambiente di calcolo personale, consentendo loro di creare risorse di calcolo a computer singolo. Se è necessario accedere all’Ambiente di calcolo personale o a eventuali criteri aggiuntivi, contattare l'amministratore dell'area di lavoro.

Si veda Ambiente di calcolo a nodo singolo o a più nodi

A seconda dei criteri, è possibile scegliere tra la creazione di una risorsa di calcolo a nodo singolo o una risorsa di calcolo multinodo.

Il calcolo a nodo singolo è destinato ai processi che utilizzano piccole quantità di dati o carichi di lavoro non distribuiti, ad esempio librerie di Machine Learning a nodo singolo. Il calcolo a più nodi deve essere utilizzato per processi di grandi dimensioni con carichi di lavoro distribuiti.

Proprietà delle risorse di calcolo a nodo singolo

Una risorsa di calcolo a nodo singolo ha le proprietà seguenti:

- Esegue Spark in locale.

- Il driver funge sia da master sia da ruolo di lavoro, senza nodi di lavoro.

- Crea un thread di esecuzione per ogni core logico della risorsa di calcolo, meno 1 core per il driver.

- Salva tutti gli output di log

stderr,stdoutelog4jnel log del driver. - Non è può essere convertita in una risorsa di calcolo multinodo.

Scegliere una risorsa a nodo singolo o multinodo

Quando si decide tra risorsa di calcolo a nodo singolo o multinodo, occorre valutare il caso d'uso:

L'elaborazione di dati su larga scala esaurirà le risorse di calcolo a nodo singolo. Per questi carichi di lavoro, Databricks consiglia di usare risorse di calcolo multinodo.

Le risorse di calcolo a nodo singolo non sono progettate per essere condivise. Per evitare conflitti di risorse, Databricks consiglia di usare una risorsa di calcolo multinodo se il calcolo deve essere condiviso.

Non è possibile ridimensionare una risorsa di calcolo multinodo a 0 ruoli di lavoro. Usare invece una risorsa di calcolo a nodo singolo.

Il calcolo a nodo singolo non è compatibile con l'isolamento del processo.

La pianificazione GPU non è abilitata per le risorse di calcolo a nodo singolo.

Nel calcolo a nodo singolo, Spark non è in grado di leggere i file Parquet con una colonna con tipo definito dall'utente. Come risultato, vengono generati i seguenti messaggi di errore:

The Spark driver has stopped unexpectedly and is restarting. Your notebook will be automatically reattached.Per risolvere questo problema, disabilitare il lettore Parquet nativo:

spark.conf.set("spark.databricks.io.parquet.nativeReader.enabled", False)

Modalità di accesso

La modalità di accesso è una funzionalità di sicurezza che determina chi può utilizzare la risorsa di calcolo e i dati a cui può accedere usando la risorsa di calcolo. Ogni risorsa di calcolo in Azure Databricks ha una modalità di accesso.

Databricks consiglia di usare la modalità di accesso condiviso per tutti i carichi di lavoro. Usare la modalità di accesso utente singolo solo se la funzionalità richiesta non è supportata dalla modalità di accesso condiviso.

| Modalità di accesso | Visibile agli utenti | Supporto UC | Lingue supportate | Note |

|---|---|---|---|---|

| Un solo utente | Sempre | Sì | Python, SQL, Scala, R | Può essere assegnato a e utilizzato da un singolo utente. Definita modalità di accesso assegnato in alcune aree di lavoro. |

| Condiviso | Sempre (piano Premium obbligatorio) | Sì | Python (in Databricks Runtime 11.3 LTS e versioni successive), SQL, Scala (nelle risorse di calcolo abilitate per il catalogo Unity con Databricks Runtime 13.3 LTS e versioni successive) | Può essere usata da più utenti con isolamento dei dati tra loro. |

| Nessun isolamento condiviso | Gli amministratori possono nascondere questa modalità di accesso applicando l'isolamento utente nella pagina delle impostazioni di amministrazione. | No | Python, SQL, Scala, R | È disponibile un'impostazione a livello di account correlata per nessun isolamento per risorse di calcolo condivise. |

| Personalizzazione | Nascosto (per tutte le nuove risorse di calcolo) | No | Python, SQL, Scala, R | Questa opzione viene visualizzata solo se si dispone di una risorsa di calcolo esistente senza una modalità di accesso specificata. |

È possibile aggiornare una risorsa di calcolo esistente per soddisfare i requisiti del catalogo Unity impostandone la modalità di accesso su Utente singolo o Condiviso. Per informazioni dettagliate sulle funzionalità supportate da ognuna di queste modalità di accesso nelle aree di lavoro abilitate per il catalogo Unity , si veda Limitazioni della modalità di accesso alle risorse di calcolo per il catalogo Unity.

Nota

In Databricks Runtime 13.3 LTS e versioni successive gli script e le librerie init sono supportati da tutte le modalità di accesso. I requisiti e i livelli di supporto variano. Si veda Dove è possibile installare gli script init? e le librerie con ambito cluster.

Versioni di Databricks Runtime

Databricks Runtime è il set di componenti di base eseguiti nella risorsa di calcolo. Selezionare il runtime usando il menu a discesa Versione di Databricks Runtime. Per tutte le versioni supportate di Databricks Runtime, si veda Versioni e compatibilità delle note sulla versione di Databricks Runtime. Tutte le versioni includono Apache Spark. Databricks consiglia quanto segue:

- Per il calcolo universale, usare la versione più recente utilizzare la versione più recente per assicurarsi le ultime ottimizzazioni e la compatibilità più aggiornata tra codice e pacchetti precaricati.

- Per il calcolo dei processi che eseguono carichi di lavoro operativi, si consiglia di usare la versione di Databricks Runtime LTS (Long Term Support). L'uso della versione LTS assicura che non si verifichino problemi di compatibilità e che si possa testare a fondo il carico di lavoro prima di effettuare l'aggiornamento.

- Per i casi d'uso di Data Science e Machine Learning, valutare l’utilizzo della versione di Databricks Runtime ML.

Usare l'accelerazione Photon

Photon è abilitato per impostazione predefinita nel calcolo che esegue Databricks Runtime 9.1 LTS e versioni successive.

Per abilitare o disabilitare l'accelerazione Photon, selezionare la casella di controllo Usa accelerazione Photon. Per altre informazioni su Photon, si veda Che cos'è Photon?.

Tipi di nodo del ruolo di lavoro e del driver

Una risorsa di calcolo è costituita da un nodo driver e da zero o più nodi di lavoro. È possibile selezionare tipi di istanza del provider di servizi cloud separati per i nodi driver e di lavoro, anche se per impostazione predefinita il nodo driver utilizza lo stesso tipo di istanza del nodo di lavoro. Diverse famiglie di tipi di istanza si adattano a casi d'uso diversi, ad esempio carichi di lavoro a elevato utilizzo di memoria o a elevato utilizzo di calcolo.

È anche possibile selezionare un pool da usare come nodo di lavoro o driver. Usare solo un pool con istanze spot come tipo di lavoro. Selezionare un tipo di driver on-demand separato per impedire che il driver venga recuperato. Si veda Connettersi ai pool.

Tipo di lavoratore

Nel calcolo a più nodi, i nodi di lavoro eseguono gli executor Spark e altri servizi necessari affinché la risorsa di calcolo funzioni correttamente. Quando si distribuisce il carico di lavoro con Spark, tutte le attività di elaborazione distribuita vengono eseguite nei nodi di lavoro. Azure Databricks esegue un executor per ogni nodo di lavoro. Pertanto, i termini executor e ruolo di lavoro vengono usati in modo intercambiabile nel contesto dell'architettura di Databricks.

Suggerimento

Per eseguire un processo Spark, è necessario almeno un nodo di lavoro. Se una risorsa di calcolo non ha nodi di lavoro, è possibile eseguire comandi non Spark nel nodo driver, ma i comandi di Spark avranno esito negativo.

Indirizzi IP dei nodi di lavoro

Azure Databricks avvia nodi di lavoro con due indirizzi IP privati ciascuno. L'indirizzo IP privato primario del nodo ospita il traffico interno di Azure Databricks. L'indirizzo IP privato secondario viene usato dal contenitore Spark per la comunicazione all'interno del cluster. Questo modello consente ad Azure Databricks di assicurare l'isolamento tra più risorse di calcolo nella stessa area di lavoro.

Tipo di driver

Il nodo driver gestisce le informazioni sullo stato di tutti i notebook collegati alla risorsa di calcolo. Il nodo driver gestisce anche SparkContext e interpreta tutti i comandi eseguiti da un notebook o da una libreria nel cluster ed esegue il master Apache Spark che si coordina con gli executor Spark.

Il valore predefinito del tipo di nodo driver corrisponde a quello del tipo di nodo di lavoro. È possibile scegliere un tipo di nodo driver più grande con maggiore memoria se si prevede di collect() per molti dati dai ruoli di lavoro Spark e di analizzarli nel notebook.

Suggerimento

Poiché il nodo driver gestisce tutte le informazioni sullo stato dei notebook collegati, assicurarsi di scollegare i notebook inutilizzati dal nodo driver.

Tipi di istanza GPU

Per attività complesse dal calcolo che richiedono prestazioni elevate, ad esempio quelle associate all'apprendimento avanzato, Azure Databricks supporta risorse di calcolo accelerate con unità di elaborazione grafica (GPU). Per altre informazioni, si veda Risorse di calcolo con GPU.

Macchine virtuali di computing riservato di Azure

I tipi di macchina virtuale di computing riservato di Azure impediscono l'accesso non autorizzato ai dati mentre sono in uso, anche da parte dell'operatore del cloud. Questo tipo di macchina virtuale è vantaggioso per settori e aree altamente regolamentati, nonché per le aziende con dati sensibili nel cloud. Per altre informazioni sul computing riservato di Azure, si veda Panoramica sul computing riservato di Azure.

Per eseguire i carichi di lavoro usando le macchine virtuali di computing riservato di Azure, selezionare tra i tipi di VM della serie DC o EC negli elenchi a discesa ruolo di lavoro e nodo driver. Si veda Opzioni per la macchina virtuale riservata di Azure.

Istanze Spot

Per risparmiare sui costi, è possibile scegliere di usare istanze spot, note anche come macchine virtuali spot di Azure selezionando la casella di controllo Istanze spot.

La prima istanza sarà sempre su richiesta (il nodo driver è sempre su richiesta) e le istanze successive saranno istanze spot.

Se le istanze vengono rimosse a causa di un'indisponibilità, Azure Databricks tenterà di acquisire nuove istanze spot per sostituire quelle rimosse. Se non è possibile acquisire istanze spot, le istanze on demand vengono distribuite per sostituire le istanze rimosse. Questo failback on-demand è supportato solo per le istanze spot completamente acquisite e in esecuzione. Le istanze spot che non funzionano durante l'installazione non vengono sostituite automaticamente.

Inoltre, quando vengono aggiunti nuovi nodi alle risorse di calcolo esistenti, Azure Databricks tenta di acquisire istanze spot per quei nodi.

Abilitare la scalabilità automatica

Quando si seleziona Abilita scalabilità automatica, è possibile specificare un numero minimo e massimo di ruoli di lavoro per la risorsa di calcolo. Databricks sceglie allora il numero appropriato di ruoli di lavoro necessari per eseguire il processo.

Per impostare il numero minimo e il numero massimo di ruoli di lavoro tra cui la risorsa di calcolo verrà automaticamente ridimensionata, utilizzare i campi Ruoli di lavoro min. e Ruoli di lavoro max. accanto all'elenco a discesa Tipo di lavoro.

Se non si abilita la scalabilità automatica, è necessario immettere un numero fisso di ruoli di lavoro nel campo Ruoli di lavoro accanto all'elenco a discesa Tipo di ruolo di lavoro.

Nota

Quando la risorsa di calcolo è in esecuzione, nella pagina dei dettagli di calcolo viene visualizzato il numero di ruoli di lavoro assegnati. È possibile confrontare il numero di ruoli di lavoro assegnati con la configurazione del ruolo di lavoro e apportare modifiche in base alle esigenze.

Vantaggi della scalabilità automatica

Con la scalabilità automatica, Azure Databricks rialloca dinamicamente i ruoli di lavoro in base alle caratteristiche del processo. Alcune parti della pipeline possono essere più esigenti dal punto di vista computazionale di altre e Databricks aggiunge automaticamente altri ruoli di lavoro durante tali fasi del processo e (li rimuove quando non sono più necessari).

Con la scalabilità automatica è più facile ottenere un elevato utilizzo del cluster, perché non è necessario effettuare il provisioning della risorsa di calcolo per soddisfare un carico di lavoro. Questo vale soprattutto per i carichi di lavoro i cui requisiti cambiano nel tempo, ad esempio l'esplorazione di un set di dati durante il corso di un giorno, ma possono essere applicati anche a un carico di lavoro monouso più breve i cui requisiti di provisioning sono sconosciuti. La scalabilità automatica offre dunque due vantaggi:

- I carichi di lavoro possono essere eseguiti più velocemente rispetto a una risorsa di calcolo con provisioning costante.

- La scalabilità automatica può ridurre i costi complessivi rispetto a una risorsa di calcolo con dimensioni statiche.

A seconda delle dimensioni costanti della risorsa di calcolo e del carico di lavoro, la scalabilità automatica offre uno o entrambi questi vantaggi contemporaneamente. Le dimensioni di calcolo possono superare il numero minimo di ruoli di lavoro selezionati quando il provider di servizi cloud termina le istanze. In questo caso, Azure Databricks ritenta continuamente il provisioning delle istanze per mantenere il numero minimo di ruoli di lavoro.

Nota

La scalabilità automatica non è disponibile per i processi spark-submit.

Nota

La scalabilità automatica del calcolo ha dei limiti quando si riduce la dimensione del cluster per carichi di lavoro di streaming strutturati. Databricks consiglia di usare tabelle live Delta con scalabilità automatica avanzata per i carichi di lavoro di streaming. Vedere Ottimizzare l'utilizzo del cluster delle pipeline di tabelle live Delta con scalabilità automatica avanzata.

Comportamento del ridimensionamento automatico

L'area di lavoro del piano Premium usa la scalabilità automatica ottimizzata. Le aree di lavoro del piano tariffario standard usano la scalabilità automatica standard.

La scalabilità automatica ottimizzata presenta le seguenti caratteristiche:

- Aumenta da min a max in 2 passaggi.

- Può ridurre le prestazioni, anche se la risorsa di calcolo non è inattiva, osservando lo stato del file shuffle.

- Riduce le prestazioni in base a una percentuale di nodi correnti.

- Nel calcolo dei processi riduce le prestazioni se la risorsa di calcolo è stata sottoutilizzata negli ultimi 40 secondi.

- Nel calcolo universale, riduce le prestazioni se la risorsa di calcolo è stata sottoutilizzata negli ultimi 150 secondi.

- La proprietà di configurazione

spark.databricks.aggressiveWindowDownSdi Spark specifica in secondi la frequenza con cui il calcolo prende decisioni di ridimensionamento. Aumentando il valore, la risorsa di calcolo viene ridotta più lentamente. Il valore massimo è 600.

La scalabilità automatica standard viene utilizzata per le aree di lavoro del piano tariffario standard. La scalabilità automatica presenta le seguenti caratteristiche:

- Inizia aggiungendo 8 nodi. Poi aumenta in modo esponenziale, eseguendo tutti i passaggi necessari per raggiungere il numero massimo.

- Riduce le prestazioni quando il 90% dei nodi non è occupato per 10 minuti e la risorsa di calcolo è inattiva per almeno 30 secondi.

- Effettua la riduzione in modo esponenziale, a partire dal nodo 1.

Scalabilità automatica con pool

Se si collega la risorsa di calcolo a un pool, occorre tenere presente quanto segue:

Assicurarsi che le dimensioni della risorsa di calcolo richieste siano minori o uguali al numero minimo di istanze inattive nel pool. Se sono maggiori, il tempo di avvio della risorsa di calcolo sarà equivalente a quello di una risorsa che non usa un pool.

Assicurarsi che le dimensioni massime della risorsa di calcolo siano inferiori o uguali alla capacità massima del pool. Se sono maggiori, la creazione della risorsa di calcolo avrà esito negativo.

Esempio di scalabilità automatica

Se si riconfigura una risorsa di calcolo statica per la scalabilità automatica, Azure Databricks ridimensiona immediatamente la risorsa di calcolo entro i limiti minimo e massimo e quindi avvia la scalabilità automatica. Ad esempio, la tabella seguente illustra cosa accade a una risorsa di calcolo con una determinata dimensione iniziale se si riconfigura la risorsa di calcolo per la scalabilità automatica tra 5 e 10 nodi.

| Dimensioni iniziali | Dimensioni dopo la riconfigurazione |

|---|---|

| 6 | 6 |

| 12 | 10 |

| 3 | 5 |

Abilita il ridimensionamento automatico delle risorse di archiviazione locali

Spesso può essere difficile stimare la quantità di spazio su disco che un determinato processo richiederà. Per evitare di dover stimare il numero di gigabyte di disco gestito da collegare alla risorsa di calcolo in fase di creazione, Azure Databricks abilita automaticamente la scalabilità automatica dell'archiviazione locale in tutte le risorse di calcolo di Azure Databricks.

Con la scalabilità automatica dell'archiviazione locale, Azure Databricks monitora la quantità di spazio disponibile su disco nei ruoli di lavoro delle risorse di calcolo di Spark. Se un ruolo di lavoro inizia a essere troppo basso su disco, Databricks collega automaticamente un nuovo disco gestito al ruolo di lavoro prima che esaurisca lo spazio su disco. I dischi vengono collegati fino a un limite di 5 TB di spazio totale su disco per macchina virtuale (inclusa l'archiviazione locale iniziale della macchina virtuale).

I dischi gestiti collegati a una macchina virtuale vengono scollegati solo quando la macchina virtuale viene restituita ad Azure. Ovvero, i dischi gestiti non vengono mai scollegati da una macchina virtuale, purché faccia parte di una risorsa di calcolo in esecuzione. Per ridurre l'utilizzo del disco gestito, Azure Databricks consiglia di usare questa funzionalità nel calcolo configurato con risorse di calcolo con scalabilità automatica o terminazione automatica.

Crittografia del disco locale

Importante

Questa funzionalità è disponibile in anteprima pubblica.

Alcuni tipi di istanza usati per eseguire il calcolo possono avere dischi collegati in locale. Azure Databricks può archiviare dati casuali o dati temporanei in questi dischi collegati localmente. Per assicurarsi che tutti i dati inattivi siano crittografati per tutti i tipi di archiviazione, inclusi i dati casuali archiviati temporaneamente nei dischi locali della risorsa di calcolo, è possibile abilitare la crittografia del disco locale.

Importante

I carichi di lavoro potrebbero essere più lenti a causa dell'impatto sulle prestazioni della lettura e della scrittura di dati crittografati da e verso i volumi locali.

Quando la crittografia del disco locale è abilitata, Azure Databricks genera localmente una chiave di crittografia che è unica per ogni nodo di calcolo e viene utilizzata per crittografare tutti i dati memorizzati sui dischi locali. L'ambito della chiave è limitato a ciascun nodo di calcolo e viene eliminato definitivamente insieme al nodo di calcolo stesso. Nel corso della sua durata operativa, la chiave risiede in memoria per la crittografia e la decrittografia e viene memorizzata crittografata sul disco.

Per abilitare la crittografia del disco locale, è necessario usare l'API Clusters. Durante la creazione o la modifica della risorsa di calcolo, impostare enable_local_disk_encryption su true.

Terminazione automatica

È possibile impostare la terminazione automatica di una risorsa di calcolo. Durante la creazione della risorsa di calcolo, è possibile specificare un periodo di inattività in minuti dopo il quale si vuole che la risorsa di calcolo si arresti.

Se la differenza tra l'ora corrente e l'ultima esecuzione del comando nella risorsa di calcolo è maggiore del periodo di inattività specificato, Azure Databricks termina automaticamente tale ambiente di calcolo. risorsa Per altre informazioni sulla terminazione di una risorsa calcolo, si veda Terminare una risorsa di calcolo.

Tag

I tag consentono di monitorare facilmente il costo delle risorse cloud usate da vari gruppi nell'organizzazione. È possibile specificare tag come coppie chiave-valore quando si crea una risorsa di calcolo e Azure Databricks applica questi tag alle risorse cloud, ad esempio macchine virtuali e volumi di dischi, nonché report di utilizzo DBU.

Per le risorse di calcolo avviate dai pool, i tag personalizzati vengono applicati solo ai report di utilizzo DBU e non vengono propagati alle risorse cloud.

Per informazioni dettagliate su come i tipi di tag di pool e di calcolo funzionano insieme, vedere utilizzo degli attributi tramite tag

Per aggiungere tag alla risorsa di calcolo:

- Nella sezione Tag aggiungere una coppia chiave-valore per ogni tag personalizzato.

- Fare clic su Aggiungi.

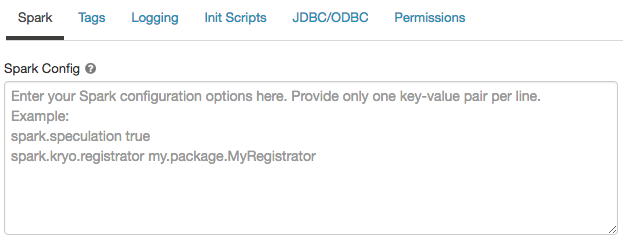

Configurazione di Spark

Per ottimizzare i processi Spark, è possibile fornire proprietà di configurazione Spark personalizzate in una configurazione del cluster.

Nella pagina configurazione della risorsa di calcolo fare clic sull'interruttore Opzioni avanzate.

Fare clic sulla scheda Spark.

Nella configurazione di Spark immettere le proprietà di configurazione come una coppia chiave-valore per riga.

Quando si configura il calcolo usando l'API Clusters, impostare le proprietà Spark nel campo spark_confnell'API di creazione del cluster o nell'API del cluster di aggiornamento.

Per applicare le configurazioni Spark nel calcolo, gli amministratori dell'area di lavoro possono usare i criteri per le risorse di calcolo.

Recuperare una proprietà di configurazione spark da un segreto

Databricks consiglia di archiviare informazioni riservate, ad esempio password, in un segreto anziché in testo non crittografato. Per fare riferimento a un segreto nella configurazione di Spark, usare la seguente sintassi:

spark.<property-name> {{secrets/<scope-name>/<secret-name>}}

Ad esempio, per impostare una proprietà di configurazione Spark denominata password sul valore del segreto archiviato in secrets/acme_app/password:

spark.password {{secrets/acme-app/password}}

Per altre informazioni, vedere Gestire i segreti.

Accesso SSH alle risorse di calcolo

Per motivi di sicurezza, in Azure Databricks la porta SSH viene chiusa per impostazione predefinita. Per abilitare l'accesso SSH ai cluster Spark, si veda SSH per il nodo driver.

Nota

SSH può essere abilitato solo se l'area di lavoro viene distribuita nella propria rete virtuale di Azure.

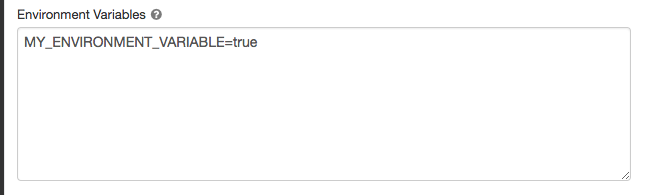

Variabili di ambiente

Configurare variabili di ambiente personalizzate a cui è possibile accedere dagli script init in esecuzione nella risorsa di calcolo. Databricks fornisce anche variabili di ambiente predefinite che è possibile usare negli script init. Non è possibile eseguire l'override di queste variabili di ambiente predefinite.

Nella pagina configurazione della risorsa di calcolo fare clic sull'interruttore Opzioni avanzate.

Fare clic sulla scheda Spark.

Impostare le variabili di ambiente nel campo Variabili di ambiente.

È anche possibile impostare le variabili di ambiente usando il campo spark_env_vars nell'API di creazione di un cluster o nell'API di aggiornamento del cluster.

Recapito dei log di calcolo

Quando si crea una risorsa di calcolo, è possibile specificare un percorso in cui recapitare i log per il nodo del driver, i nodi di lavoro e gli eventi Spark. I log vengono recapitati ogni cinque minuti alla destinazione prescelta, dove vengono archiviati con cadenza oraria. Quando una risorsa di calcolo viene terminata, Azure Databricks garantisce di distribuire tutti i log generati fino al momento in cui la risorsa viene effettivamente terminata.

La destinazione dei log dipende dalla risorsa di calcolo cluster_id. Se la destinazione specificata è dbfs:/cluster-log-delivery, i log di calcolo per 0630-191345-leap375 vengono recapitati a dbfs:/cluster-log-delivery/0630-191345-leap375.

Per configurare il percorso di recapito dei log:

- Nella pagina della risorsa di calcolo fare clic sull'interruttore Opzioni avanzate.

- Fare clic sulla scheda Accedi.

- Selezionare un tipo di destinazione.

- Immettere il percorso del log di calcolo.

Nota

Questa funzionalità è disponibile anche nell'API REST. Vedere l'API Cluster.