Eseguire un notebook di Databricks con l'attività dei notebook di Databricks in Azure Data Factory

SI APPLICA A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi all-in-one per le aziende. Microsoft Fabric copre tutto, dallo spostamento dati al data science, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Vedere le informazioni su come iniziare una nuova prova gratuita!

In questa esercitazione si usa il portale di Azure per creare una pipeline di Azure Data Factory che eseguirà un notebook di Databricks nel cluster dei processi Databricks e passerà i parametri di Azure Data Factory al notebook di Databricks durante l'esecuzione.

In questa esercitazione vengono completati i passaggi seguenti:

Creare una data factory.

Creare una pipeline che usa l'attività dei notebook di Databricks.

Attivare un'esecuzione della pipeline.

Monitorare l'esecuzione della pipeline.

Se non si ha una sottoscrizione di Azure, creare un account gratuito prima di iniziare.

Per un'introduzione di undici minuti e una dimostrazione di questa funzionalità, guardare il video seguente:

Prerequisiti

- Area di lavoro di Azure Databricks. Creare un'area di lavoro di Databricks o usarne una esistente. Creare un notebook Python nell'area di lavoro di Azure Databricks. Eseguire quindi il notebook e passare i parametri al notebook stesso usando Azure Data Factory.

Creare una data factory

Avviare il Web browser Microsoft Edge o Google Chrome. L'interfaccia utente di Data Factory è attualmente supportata solo nei Web browser Microsoft Edge e Google Chrome.

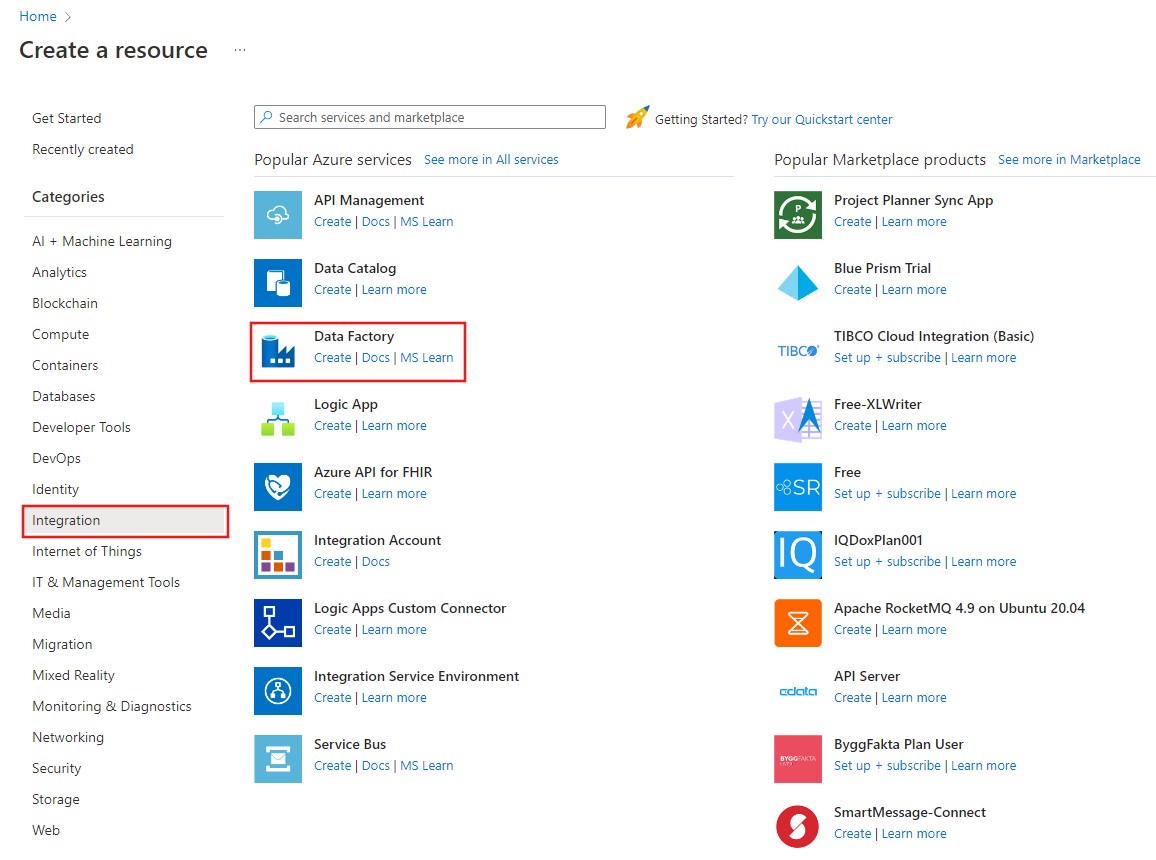

Selezionare Crea una risorsa nel menu portale di Azure, selezionare Integrazione e quindi Selezionare Data Factory.

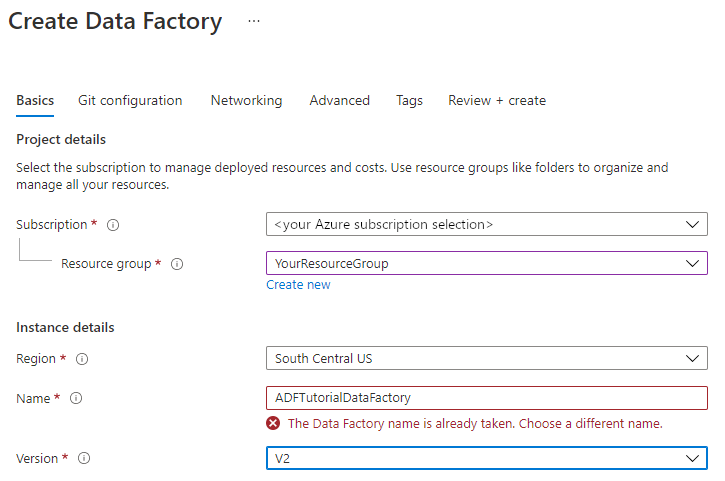

Nella scheda Informazioni di base della pagina Crea data factory selezionare la sottoscrizione di Azure in cui si vuole creare la data factory.

In Gruppo di risorse eseguire una di queste operazioni:

Selezionare un gruppo di risorse esistente dall'elenco a discesa.

Selezionare Crea nuovo e immettere il nome di un nuovo gruppo di risorse.

Per informazioni sui gruppi di risorse, vedere l'articolo relativo all'uso di gruppi di risorse per la gestione delle risorse di Azure.

In Area selezionare la località per la data factory.

L'elenco mostra solo le località supportate da Data Factory e in cui verranno archiviati i metadati di Azure Data Factory. Gli archivi dati associati (come Archiviazione di Azure e il database SQL di Azure) e le risorse di calcolo (come Azure HDInsight) usati da Data Factory possono essere eseguiti in altre aree.

In Nome immettere ADFTutorialDataFactory.

Il nome della data factory di Azure deve essere univoco a livello globale. Se viene visualizzato l'errore seguente, modificare il nome della data factory, ad esempio usare <il nome>ADFTutorialDataFactory. Per le regole di denominazione per gli elementi di Data Factory, vedere l'articolo Data Factory - Regole di denominazione.

Per Versione selezionare V2.

Selezionare Avanti: Configurazione Git e quindi selezionare Configura Git in un secondo momento .

Selezionare Rivedi e crea e quindi, una volta superata la convalida, selezionare Crea.

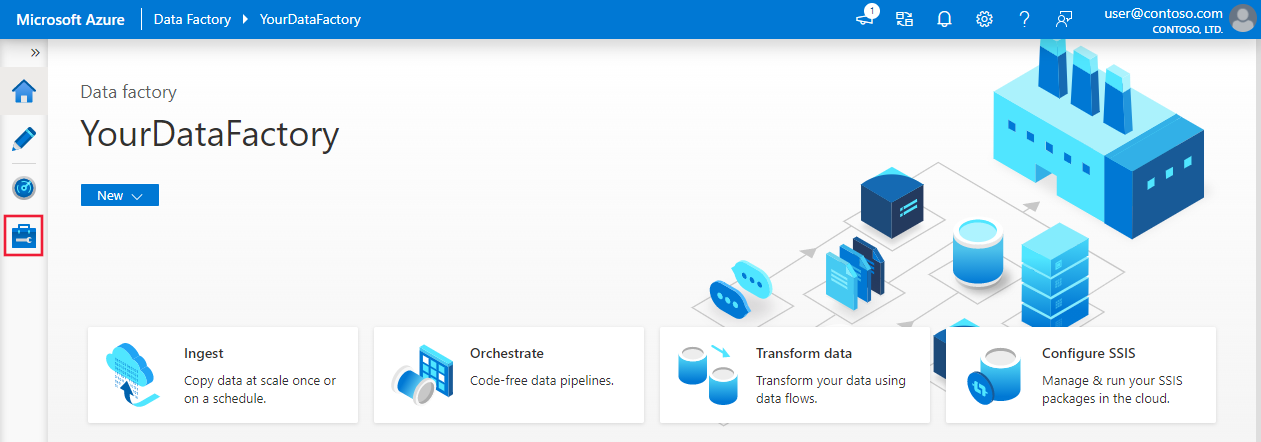

Al termine della creazione, selezionare Vai alla risorsa per passare alla pagina Data Factory. Selezionare il riquadro Apri Azure Data Factory Studio per avviare l'applicazione interfaccia utente di Azure Data Factory in una scheda separata del browser.

Creare servizi collegati

In questa sezione viene creato un servizio collegato Databricks. Questo servizio collegato contiene le informazioni di connessione al cluster Databricks:

Creare un servizio collegato Azure Databricks

Nella home page passare alla scheda Gestisci nel pannello sinistro.

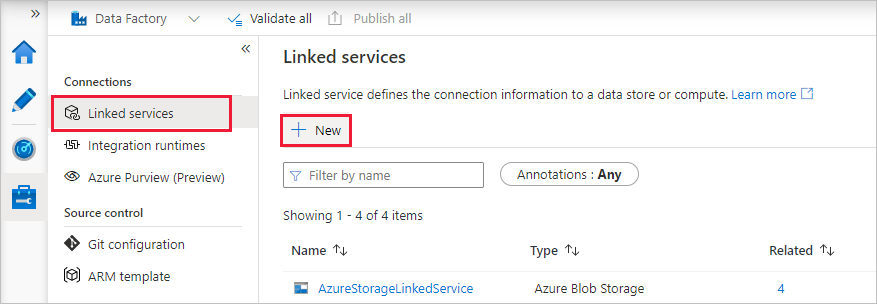

Selezionare Servizi collegati in Connessioni e quindi + Nuovo.

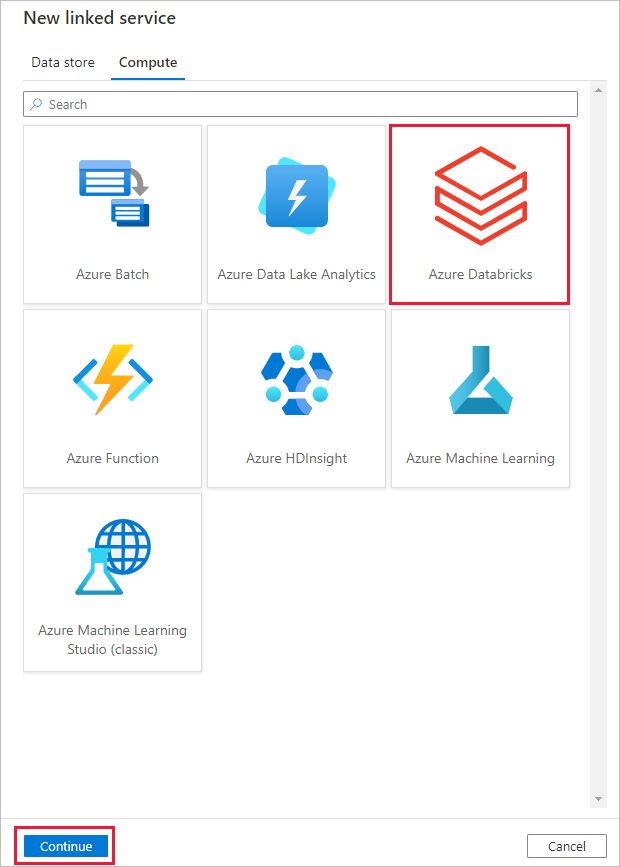

Nella finestra Nuovo servizio collegato selezionare Calcolo di Azure Databricks e quindi selezionare >Continua.

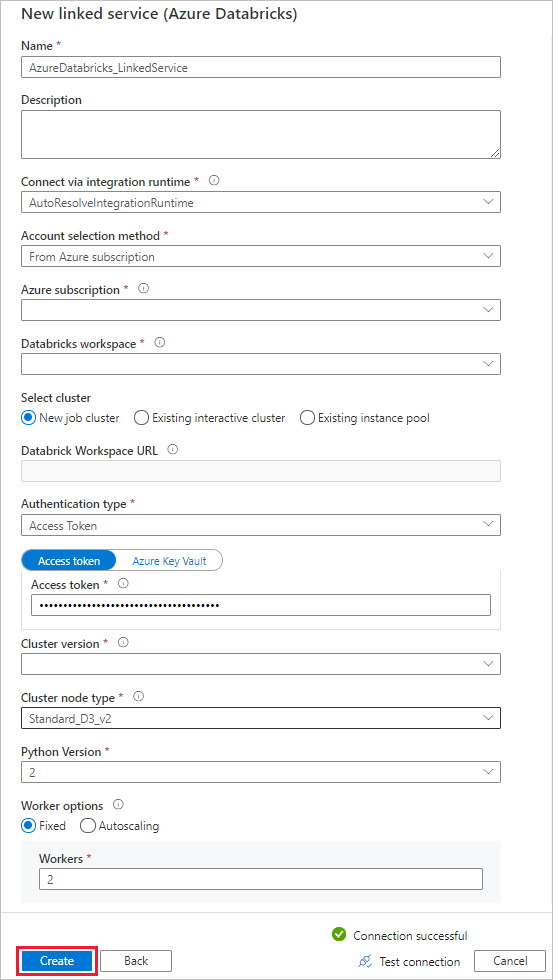

Nella finestra Nuovo servizio collegato completare la procedura seguente:

In Nome immettere AzureDatabricks_LinkedService.

Selezionare l'area di lavoro databricks appropriata in cui verrà eseguito il notebook.

Per Seleziona cluster selezionare Nuovo cluster di processo.

Per l'URL dell'area di lavoro di Databricks, le informazioni devono essere popolate automaticamente.

Per Tipo di autenticazione, se si seleziona Token di accesso, generarlo dall'area di lavoro di Azure Databricks. La procedura è disponibile qui. Per l'identità del servizio gestita e l'identità gestita assegnata dall'utente, concedere il ruolo Collaboratore a entrambe le identità nel menu di controllo di accesso della risorsa di Azure Databricks.

Per Versione cluster selezionare la versione da usare.

Per Tipo di nodo cluster selezionare Standard_D3_v2 nella categoria Utilizzo generico (HDD) per questa esercitazione.

In Workers (Ruoli di lavoro) immettere 2.

Selezionare Crea.

Creare una pipeline

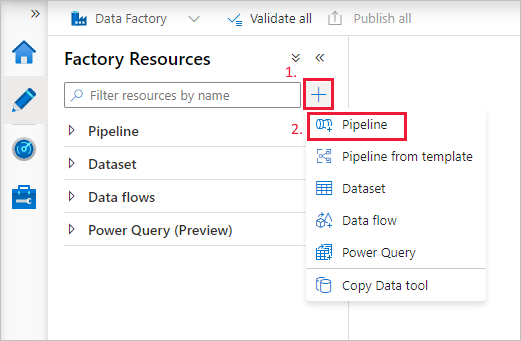

Selezionare il pulsante + (segno più) e quindi selezionare Pipeline dal menu.

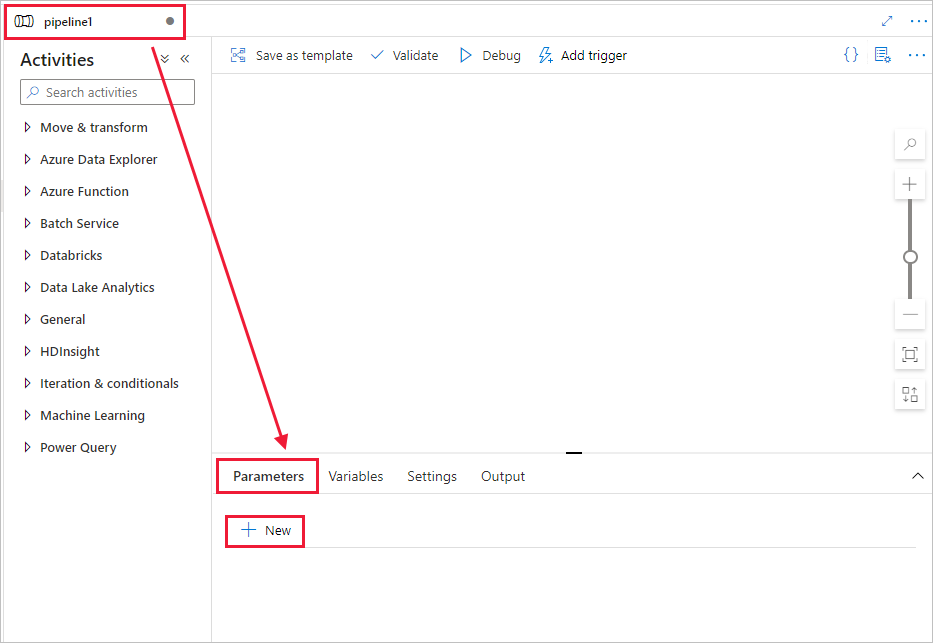

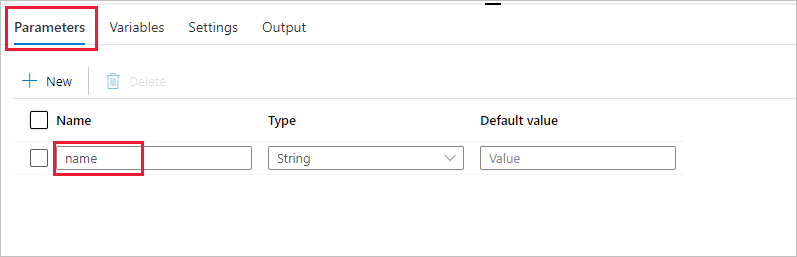

Creare un parametro da usare nella pipeline. Questo parametro verrà successivamente passato all'attività dei notebook di Databricks. Nella pipeline vuota selezionare la scheda Parametri, quindi selezionare + Nuovo e denominarla come 'name'.

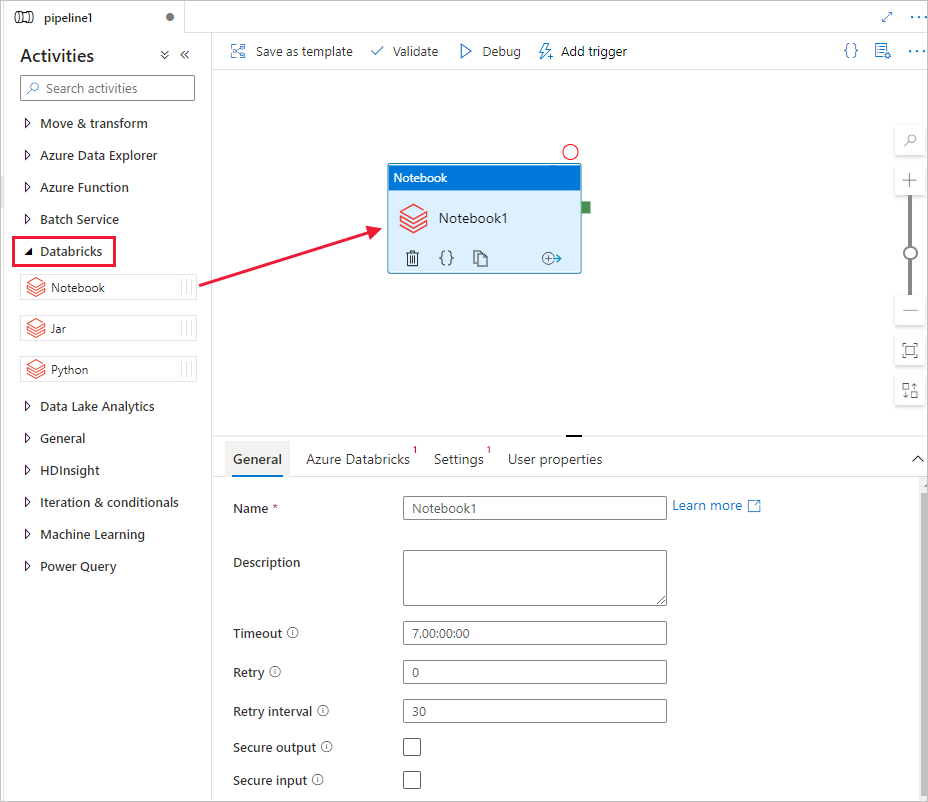

Nella casella degli strumenti Attività espandere Databricks. Trascinare l'attività Notebook dalla casella degli strumenti Attività nell'area di progettazione della pipeline.

Nelle proprietà della finestra dell'attività Databricks Notebook in basso completare questa procedura:

Passare alla scheda Azure Databricks.

Selezionare AzureDatabricks_LinkedService (creato nella procedura precedente).

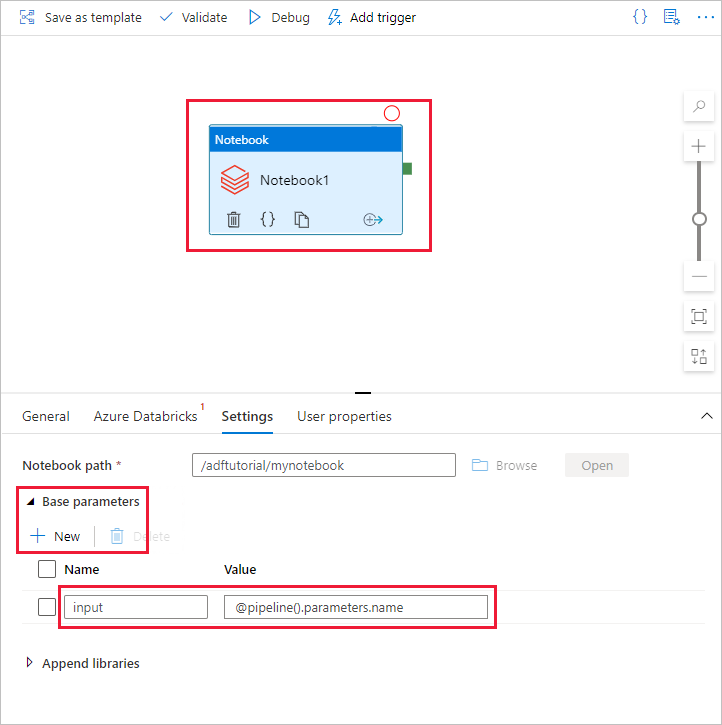

Passare alla scheda Impostazioni .

Sfogliare per selezionare un percorso del notebook di Databricks. Creare un notebook e specificare il percorso qui. Ottenere il percorso del notebook seguendo questi passaggi.

Avviare l'area di lavoro di Azure Databricks.

Creare una nuova cartella nell'area di lavoro e chiamarla adftutorial.

Creare un nuovo blocco appunti, che verrà chiamato mynotebook. Fare clic con il pulsante destro del mouse sulla cartella adftutorial e scegliere Crea.

Aggiungere il codice seguente nel notebook "mynotebook" appena creato:

# Creating widgets for leveraging parameters, and printing the parameters dbutils.widgets.text("input", "","") y = dbutils.widgets.get("input") print ("Param -\'input':") print (y)Il percorso del blocco appunti in questo caso è /adftutorial/mynotebook.

Tornare allo strumento di creazione dell'interfaccia utente di Data Factory. Passare alla scheda Impostazioni nell'attività Notebook1 .

a. Aggiungere un parametro all'attività Notebook. Usare lo stesso parametro aggiunto in precedenza alla pipeline.

b. Assegnare al parametro il nome input e specificare il valore come espressione @pipeline().parameters.name.

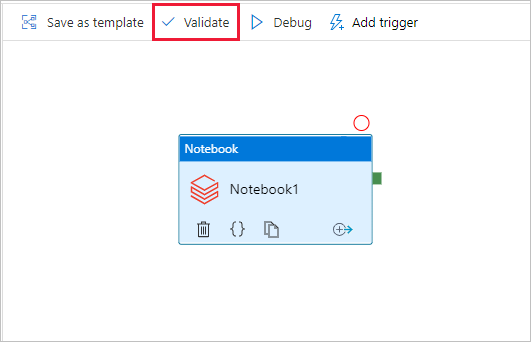

Per convalidare la pipeline, selezionare il pulsante Convalida sulla barra degli strumenti. Per chiudere la finestra di convalida, selezionare il pulsante Chiudi .

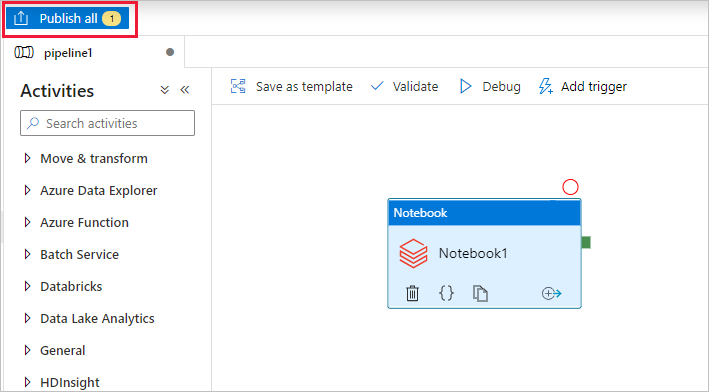

Selezionare Pubblica tutto. L'interfaccia utente di Data Factory pubblicherà le entità (servizi collegati e pipeline) nel servizio Azure Data Factory.

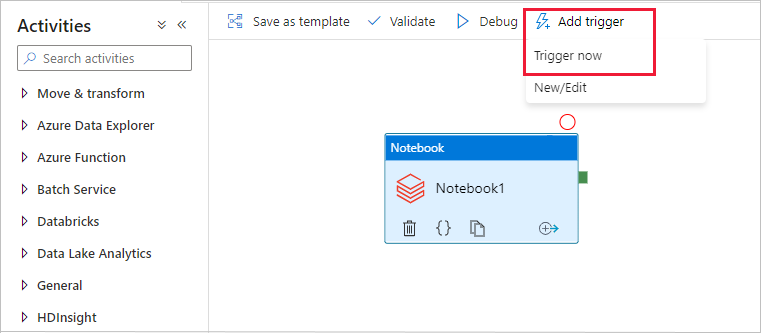

Attivare un'esecuzione della pipeline

Selezionare Aggiungi trigger sulla barra degli strumenti e quindi selezionare Attiva adesso.

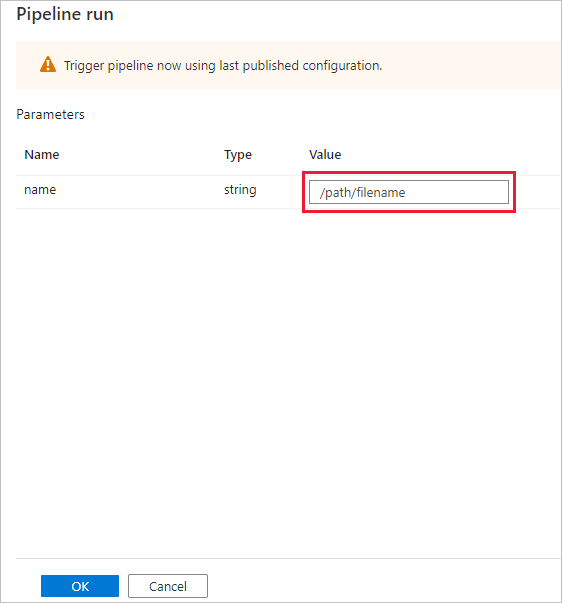

La finestra di dialogo Esecuzione pipeline richiede il parametro name . Usare /path/filename come parametro qui. Seleziona OK.

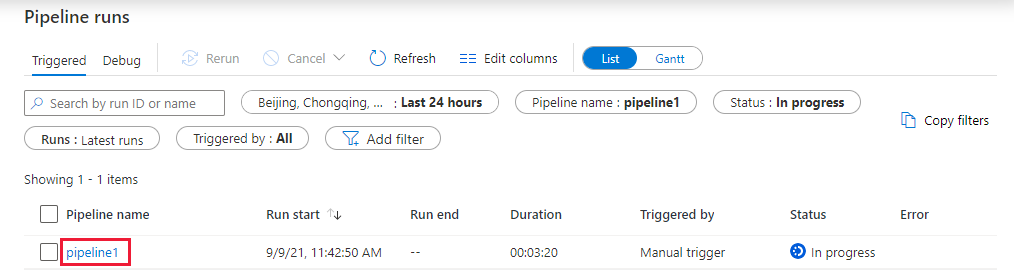

Monitorare l'esecuzione della pipeline

Passare alla scheda Monitoraggio . Verificare che venga visualizzata un'esecuzione della pipeline. Sono necessari all'incirca 5-8 minuti per creare un cluster dei processi Databricks in cui viene eseguito il notebook.

Selezionare periodicamente Aggiorna per controllare lo stato dell'esecuzione della pipeline.

Per visualizzare le esecuzioni di attività associate all'esecuzione della pipeline, selezionare il collegamento pipeline1 nella colonna Nome pipeline.

Nella pagina Esecuzioni attività selezionare Output nella colonna Nome attività per visualizzare l'output di ogni attività ed è possibile trovare il collegamento ai log di Databricks nel riquadro Output per i log Spark più dettagliati.

È possibile tornare alla visualizzazione esecuzioni della pipeline selezionando il collegamento Tutte le esecuzioni della pipeline nel menu di navigazione nella parte superiore.

Verificare l'output

È possibile accedere all'area di lavoro di Azure Databricks, passare a Esecuzioni processi ed è possibile visualizzare lo stato del processo come esecuzione, esecuzione o terminazione del processo.

È possibile selezionare il nome del processo e passare per visualizzare altri dettagli. Se l'esecuzione ha esito positivo, è possibile convalidare i parametri passati e l'output del notebook Python.

Riepilogo

La pipeline in questo esempio avvia un'attività dei notebook di Databricks e le passa un parametro. Contenuto del modulo:

Creare una data factory.

Creare una pipeline che usa un'attività dei notebook di Databricks.

Attivare un'esecuzione della pipeline.

Monitorare l'esecuzione della pipeline.