Attività If Condition nelle pipeline di Azure Data Factory e Synapse Analytics

SI APPLICA A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi all-in-one per le aziende. Microsoft Fabric copre tutto, dallo spostamento dati al data science, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Vedere le informazioni su come iniziare una nuova prova gratuita!

L'attività If Condition svolge la stessa funzione dell'istruzione If nei linguaggi di programmazione. Esegue un set di attività quando la condizione restituisce true e un altro set di attività quando la condizione restituisce false.

Creare un'attività If Condition con l'interfaccia utente

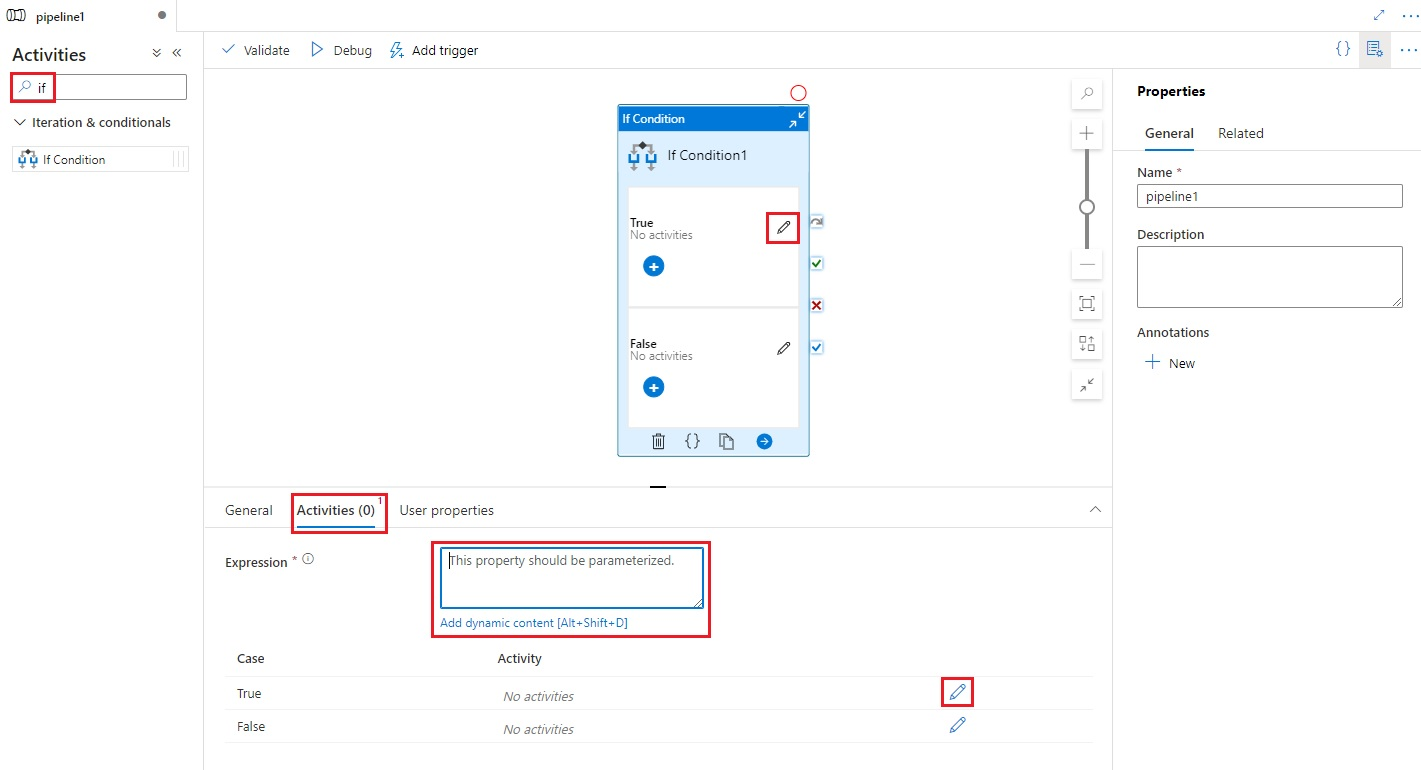

Per usare un'attività If Condition in una pipeline, completare la procedura seguente:

Cercare If nel riquadro Attività pipeline e trascinare un'attività If Condition nell'area di disegno della pipeline.

Selezionare la nuova attività If Condition nell'area di disegno se non è già selezionata e la relativa scheda Attività per modificarne i dettagli.

Immettere un'espressione che restituisce un valore booleano true o false. Può trattarsi di qualsiasi combinazione di funzioni, espressioni dinamiche, variabili di sistema o output di altre attività.

Selezionare i pulsanti Modifica attività nella scheda Attività per If Condition o direttamente dall'area di disegno If Condition (Condizione if) nell'area di disegno della pipeline per aggiungere attività che verranno eseguite quando l'espressione restituisce

trueofalse.

Sintassi

{

"name": "<Name of the activity>",

"type": "IfCondition",

"typeProperties": {

"expression": {

"value": "<expression that evaluates to true or false>",

"type": "Expression"

},

"ifTrueActivities": [

{

"<Activity 1 definition>"

},

{

"<Activity 2 definition>"

},

{

"<Activity N definition>"

}

],

"ifFalseActivities": [

{

"<Activity 1 definition>"

},

{

"<Activity 2 definition>"

},

{

"<Activity N definition>"

}

]

}

}

Proprietà del tipo

| Proprietà | Descrizione | Valori consentiti | Obbligatoria |

|---|---|---|---|

| name | Nome dell'attività if-condition. | String | Sì |

| type | Deve essere impostata su IfCondition | String | Sì |

| expression | Espressione che deve restituire true o false | Espressione con tipo di risultato booleano | Sì |

| ifTrueActivities | Set di attività che vengono eseguite quando l'espressione restituisce true. |

Array | Sì |

| ifFalseActivities | Set di attività che vengono eseguite quando l'espressione restituisce false. |

Array | Sì |

Esempio

La pipeline in questo esempio copia i dati da una cartella di input a una cartella di output. La cartella di output è determinata dal valore del parametro di pipeline routeSelection. Se il valore di routeSelection è true, i dati vengono copiati in outputPath1. E se il valore di routeSelection è false, i dati vengono copiati in outputPath2.

Nota

Questa sezione include le definizioni JSON e i comandi di PowerShell di esempio per eseguire la pipeline. Per una procedura dettagliata con istruzioni dettagliate per creare una pipeline usando Azure PowerShell e le definizioni JSON, vedere Esercitazione: Creare una data factory usando Azure PowerShell.

Pipeline con attività IF-Condition (Adfv2QuickStartPipeline.json)

{

"name": "Adfv2QuickStartPipeline",

"properties": {

"activities": [

{

"name": "MyIfCondition",

"type": "IfCondition",

"typeProperties": {

"expression": {

"value": "@bool(pipeline().parameters.routeSelection)",

"type": "Expression"

},

"ifTrueActivities": [

{

"name": "CopyFromBlobToBlob1",

"type": "Copy",

"inputs": [

{

"referenceName": "BlobDataset",

"parameters": {

"path": "@pipeline().parameters.inputPath"

},

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "BlobDataset",

"parameters": {

"path": "@pipeline().parameters.outputPath1"

},

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "BlobSource"

},

"sink": {

"type": "BlobSink"

}

}

}

],

"ifFalseActivities": [

{

"name": "CopyFromBlobToBlob2",

"type": "Copy",

"inputs": [

{

"referenceName": "BlobDataset",

"parameters": {

"path": "@pipeline().parameters.inputPath"

},

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "BlobDataset",

"parameters": {

"path": "@pipeline().parameters.outputPath2"

},

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "BlobSource"

},

"sink": {

"type": "BlobSink"

}

}

}

]

}

}

],

"parameters": {

"inputPath": {

"type": "String"

},

"outputPath1": {

"type": "String"

},

"outputPath2": {

"type": "String"

},

"routeSelection": {

"type": "String"

}

}

}

}

Un altro esempio per expression:

"expression": {

"value": "@equals(pipeline().parameters.routeSelection,1)",

"type": "Expression"

}

Servizio collegato di Archiviazione di Azure (AzureStorageLinkedService.json)

{

"name": "AzureStorageLinkedService",

"properties": {

"type": "AzureStorage",

"typeProperties": {

"connectionString": "DefaultEndpointsProtocol=https;AccountName=<Azure Storage account name>;AccountKey=<Azure Storage account key>"

}

}

}

Set di dati BLOB di Azure con parametri (BlobDataset.json)

La pipeline imposta folderPath sul valore del parametro outputPath1 o outputPath2 della pipeline.

{

"name": "BlobDataset",

"properties": {

"type": "AzureBlob",

"typeProperties": {

"folderPath": {

"value": "@{dataset().path}",

"type": "Expression"

}

},

"linkedServiceName": {

"referenceName": "AzureStorageLinkedService",

"type": "LinkedServiceReference"

},

"parameters": {

"path": {

"type": "String"

}

}

}

}

JSON dei parametri della pipeline (PipelineParameters.json)

{

"inputPath": "adftutorial/input",

"outputPath1": "adftutorial/outputIf",

"outputPath2": "adftutorial/outputElse",

"routeSelection": "false"

}

Comandi di PowerShell

Nota

È consigliabile usare il modulo Azure Az PowerShell per interagire con Azure. Per iniziare, vedere Installare Azure PowerShell. Per informazioni su come eseguire la migrazione al modulo AZ PowerShell, vedere Eseguire la migrazione di Azure PowerShell da AzureRM ad Az.

Questi comandi presuppongono che i file JSON siano stati salvati nella cartella C:\ADF.

Connect-AzAccount

Select-AzSubscription "<Your subscription name>"

$resourceGroupName = "<Resource Group Name>"

$dataFactoryName = "<Data Factory Name. Must be globally unique>";

Remove-AzDataFactoryV2 $dataFactoryName -ResourceGroupName $resourceGroupName -force

Set-AzDataFactoryV2 -ResourceGroupName $resourceGroupName -Location "East US" -Name $dataFactoryName

Set-AzDataFactoryV2LinkedService -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "AzureStorageLinkedService" -DefinitionFile "C:\ADF\AzureStorageLinkedService.json"

Set-AzDataFactoryV2Dataset -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "BlobDataset" -DefinitionFile "C:\ADF\BlobDataset.json"

Set-AzDataFactoryV2Pipeline -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -Name "Adfv2QuickStartPipeline" -DefinitionFile "C:\ADF\Adfv2QuickStartPipeline.json"

$runId = Invoke-AzDataFactoryV2Pipeline -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -PipelineName "Adfv2QuickStartPipeline" -ParameterFile C:\ADF\PipelineParameters.json

while ($True) {

$run = Get-AzDataFactoryV2PipelineRun -ResourceGroupName $resourceGroupName -DataFactoryName $DataFactoryName -PipelineRunId $runId

if ($run) {

if ($run.Status -ne 'InProgress') {

Write-Host "Pipeline run finished. The status is: " $run.Status -foregroundcolor "Yellow"

$run

break

}

Write-Host "Pipeline is running...status: InProgress" -foregroundcolor "Yellow"

}

Start-Sleep -Seconds 30

}

Write-Host "Activity run details:" -foregroundcolor "Yellow"

$result = Get-AzDataFactoryV2ActivityRun -DataFactoryName $dataFactoryName -ResourceGroupName $resourceGroupName -PipelineRunId $runId -RunStartedAfter (Get-Date).AddMinutes(-30) -RunStartedBefore (Get-Date).AddMinutes(30)

$result

Write-Host "Activity 'Output' section:" -foregroundcolor "Yellow"

$result.Output -join "`r`n"

Write-Host "\nActivity 'Error' section:" -foregroundcolor "Yellow"

$result.Error -join "`r`n"

Contenuto correlato

Vedere altre attività del flusso di controllo supportate: