Esaminare il modello di riferimento di rete per la distribuzione dell'archiviazione a server singolo per Azure Locale

Si applica a: Versione locale di Azure 2311.2 e versioni successive

Questo articolo descrive il modello di riferimento di rete di archiviazione a server singolo che è possibile usare per distribuire la soluzione locale di Azure. Le informazioni contenute in questo articolo consentono anche di determinare se questa configurazione è valida per le esigenze di pianificazione della distribuzione. Questo articolo è destinato agli amministratori IT che distribuiscono e gestiscono Azure Local nei data center.

Per informazioni su altri modelli di rete, vedere Modelli di distribuzione di rete locale di Azure.

Introduzione

Le distribuzioni a server singolo offrono vantaggi in termini di costi e spazio, consentendo allo stesso tempo di modernizzare l'infrastruttura e portare il calcolo ibrido di Azure in posizioni in grado di tollerare la resilienza di un singolo computer. L'esecuzione locale di Azure in un singolo computer si comporta in modo analogo a Locale di Azure in un cluster multinodo: offre l'integrazione nativa di Azure Arc, la possibilità di aggiungere server per aumentare il numero di istanze del sistema e include gli stessi vantaggi di Azure.

Supporta anche gli stessi carichi di lavoro, come Azure Virtual Desktop (AVD) e Azure Kubernetes Service su Azure Local, ed è supportato e fatturato lo stesso modo.

Scenari

Usare il modello di archiviazione a server singolo negli scenari seguenti:

Strutture che possono tollerare un livello inferiore di resilienza. Prendere in considerazione l'implementazione di questo modello ogni volta che la posizione o il servizio fornito da questo modello può tollerare un livello di resilienza inferiore senza influire sull'azienda.

Cibo, sanità, finanza, vendita al dettaglio, strutture governative. Alcuni scenari alimentari, sanitari, finanziari e di vendita al dettaglio possono applicare questa opzione per ridurre al minimo i costi senza influire sulle operazioni principali e sulle transazioni aziendali.

Anche se i servizi SDN (Software Defined Networking) Layer 3 (L3) sono completamente supportati in questo modello, potrebbe essere necessario configurare servizi di routing come BGP (Border Gateway Protocol) per il dispositivo firewall sul commutatore TOR (Top-of-Rack).

Le funzionalità di sicurezza di rete, ad esempio la microsegmentazione e la qualità del servizio (QoS) non richiedono una configurazione aggiuntiva per il dispositivo firewall, perché vengono implementate a livello di scheda di rete virtuale. Per ulteriori informazioni, vedere Microsegmentazione con Azure Locale.

Nota

I server singoli devono usare un solo tipo di unità: unità NVMe (Memory Express) non volatili o unità SSD (Solid-State).

Componenti di connettività fisica

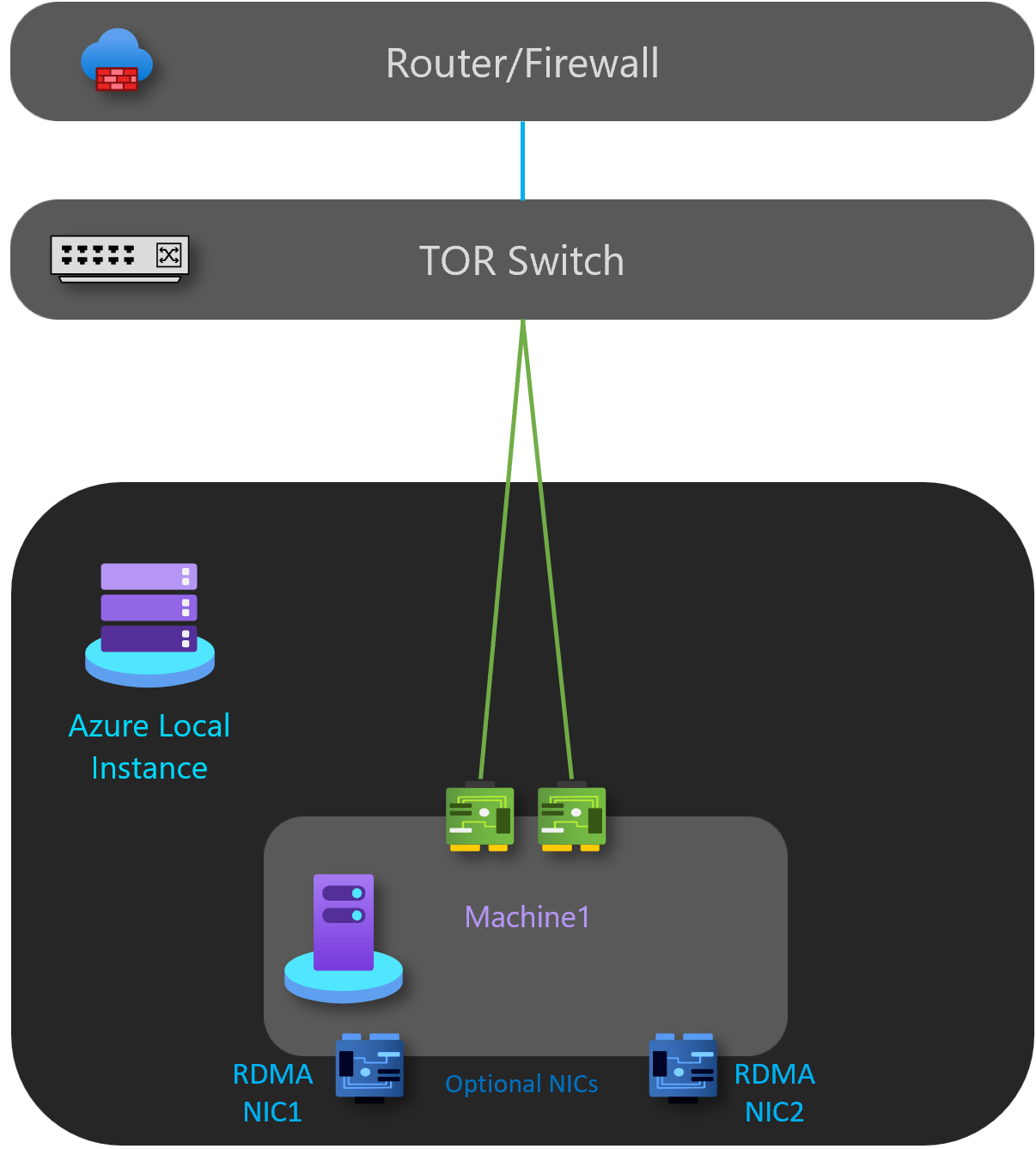

Come illustrato nel diagramma seguente, questo modello include i componenti di rete fisica seguenti:

- Per il traffico verso nord/sud, l'istanza locale di Azure viene implementata usando un singolo commutatore TOR L2 o L3.

- Due porte di rete in team per gestire la gestione e il traffico di calcolo connessi al commutatore.

- Due schede di interfaccia di rete RDMA disconnesse usate solo se si aggiunge un secondo server al sistema per la scalabilità orizzontale. Ciò significa che non sono stati aumentati i costi per il cablaggio o le porte del commutatore fisico.

- (Facoltativo) Una scheda BMC può essere usata per abilitare la gestione remota dell'ambiente. Per motivi di sicurezza, alcune soluzioni potrebbero usare una configurazione headless senza la scheda BMC.

La tabella seguente elenca alcune linee guida per una distribuzione a server singolo:

| Rete | Gestione e calcolo | Archiviazione | BMC |

|---|---|---|---|

| Velocità di collegamento | Almeno 1 Gbps se RDMA è disabilitato, sono consigliati 10 Gbps. | Almeno 10 Gbps. | Rivolgersi al produttore dell'hardware. |

| Tipo interfaccia | RJ45, SFP+o SFP28 | SFP+ o SFP28 | RJ45 |

| Porte e aggregazioni | Due porte aggregate | Facoltativo per consentire l'aggiunta di un secondo server; porte disconnesse. | Una porta |

| RDMA | Facoltativo. Dipende dai requisiti per il supporto RDMA e NIC per ospiti. | Non disponibile | N/D |

Finalità di Network ATC

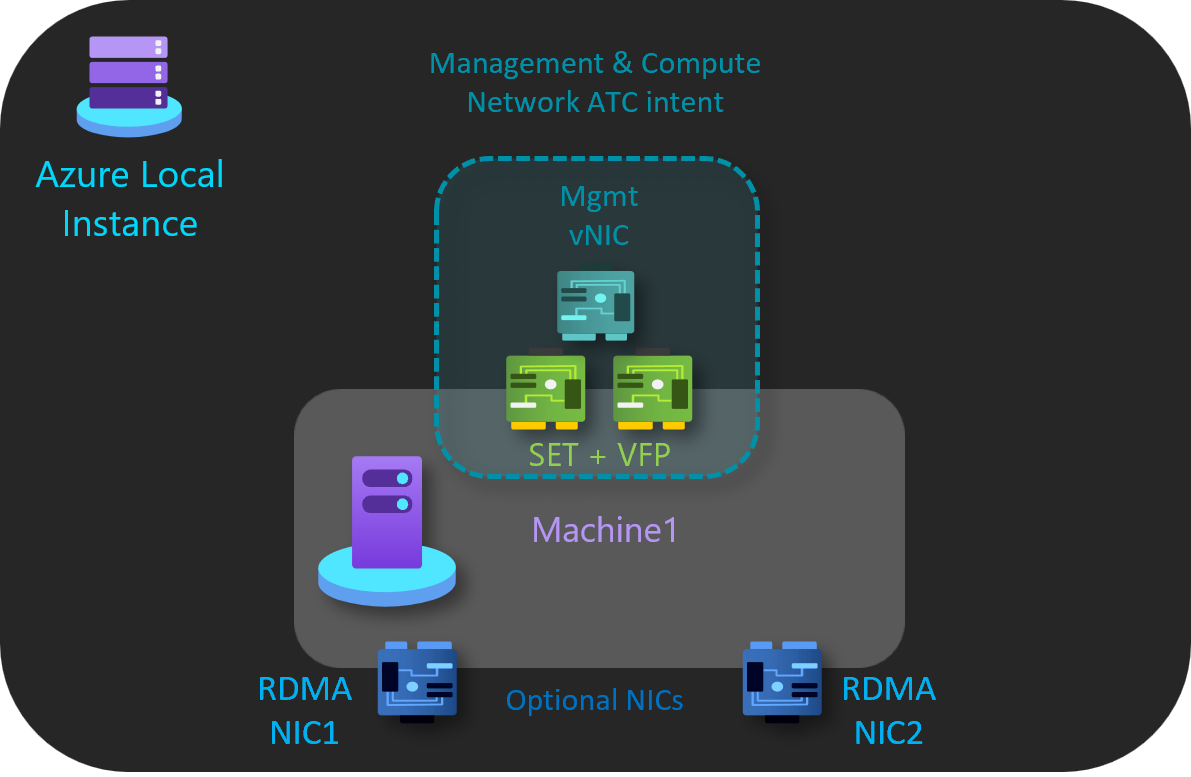

Il modello a server singolo usa una sola finalità network ATC per la gestione e il traffico di calcolo. Le interfacce di rete RDMA sono facoltative e disconnesse.

Finalità di gestione e calcolo

La finalità di gestione e calcolo presenta le caratteristiche seguenti:

- Tipo di finalità: gestione e calcolo

- Modalità intenzione: modalità cluster

- Raggruppamento: Sì - pNIC01 e pNIC02 sono raggruppati

- VLAN di gestione predefinita: la VLAN configurata per le schede di gestione è modificata

- VLAN e vNIC PA: Network ATC è trasparente per le vNIC e le VLAN PA

- Calcolo di VLAN e vNIC: Network ATC è trasparente per calcolare le vNIC e le VLAN delle macchine virtuali

Finalità di archiviazione

La finalità di archiviazione presenta le caratteristiche seguenti:

- Tipo di finalità: Nessuno

- Modalità intenti: Nessuno

- Raggruppamento: pNIC03 e pNIC04 sono disconnessi

- VLAN predefinite: Nessuna

- Subnet predefinite: Nessuno

Seguire questa procedura per creare una finalità di rete per questo modello di riferimento:

Eseguire PowerShell come amministratore.

Esegui questo comando:

Add-NetIntent -Name <management_compute> -Management -Compute -ClusterName <HCI01> -AdapterName <pNIC01, pNIC02>

Per altre informazioni, vedere Distribuire la rete host: Finalità di calcolo e gestione.

Componenti della rete logica

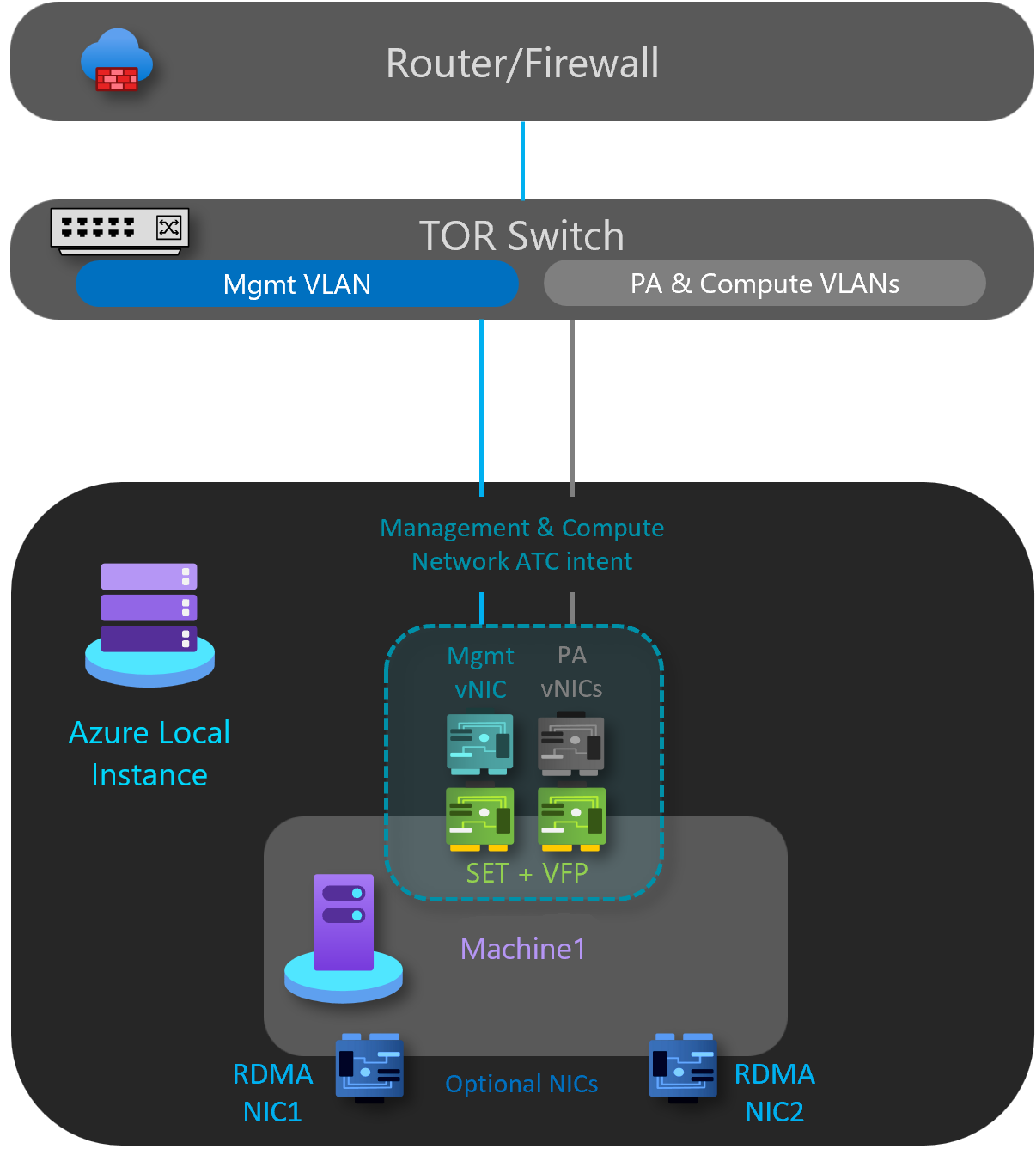

Come illustrato nel diagramma seguente, questo modello include i componenti di rete logici seguenti:

VLAN della rete di archiviazione

Facoltativo: questo modello non richiede una rete di archiviazione.

Rete OOB

La rete Out of Band (OOB) è dedicata al supporto dell'interfaccia di gestione del server "lights-out", nota anche come controller di gestione della scheda base (BMC). Ogni interfaccia BMC si connette a un commutatore fornito dal cliente. BMC viene usato per automatizzare gli scenari di avvio PXE.

La rete di gestione richiede l'accesso all'interfaccia BMC usando la porta UDP (Intelligent Platform Management Interface) User Datagram Protocol (UDP) 623.

La rete OOB è isolata dai carichi di lavoro di calcolo ed è facoltativa per le distribuzioni non basate su soluzioni.

VLAN di gestione

Tutti gli host di calcolo fisici richiedono l'accesso alla rete logica di gestione. Per la pianificazione degli indirizzi IP, ogni host di calcolo fisico deve avere almeno un indirizzo IP assegnato dalla rete logica di gestione.

Un server DHCP può assegnare automaticamente indirizzi IP per la rete di gestione oppure assegnare manualmente indirizzi IP statici. Quando DHCP è il metodo di assegnazione IP preferito, è consigliabile usare prenotazioni DHCP senza scadenza.

La rete di gestione supporta le configurazioni VLAN seguenti:

VLAN nativa: non è necessario fornire ID VLAN. Questa operazione è necessaria per le installazioni basate su soluzioni.

VLAN taggata: si specificano gli ID VLAN al momento della distribuzione. Le connessioni dei tenant su ogni gateway e passa il traffico di rete a un gateway di riserva in caso di errore di un gateway.

I gateway usano Border Gateway Protocol per annunciare gli endpoint GRE e stabilire connessioni da punto a punto. La distribuzione SDN crea un pool di gateway predefinito che supporta tutti i tipi di connessione. All'interno di questo pool è possibile specificare il numero di gateway riservati in standby in caso di errore di un gateway attivo.

Per altre informazioni, vedere Che cos'è il gateway RAS per SDN?

La rete di gestione supporta tutto il traffico usato per la gestione del cluster, tra cui Desktop remoto, Windows Admin Center e Active Directory.

Per ulteriori informazioni, vedere Pianifica un'infrastruttura SDN: Gestione e provider HNV.

VLAN di elaborazione

In alcuni scenari non è necessario usare Rete virtuale SDN con incapsulamento VXLAN (Virtual Extensible LAN). È invece possibile usare le VLAN tradizionali per isolare i carichi di lavoro del tenant. Tali VLAN sono configurate sulla porta del commutatore TOR in modalità trunk. Quando si connettono nuove macchine virtuali a queste VLAN, il tag VLAN corrispondente viene definito nella scheda di rete virtuale.

Rete di indirizzi dei fornitori HNV (PA)

La rete di virtualizzazione di rete Hyper-V (HNV) Provider Address (PA) funge da rete fisica sottostante per il traffico tenant Est/Ovest (interno-interno), il traffico del tenant Nord/Sud (esterno-interno) e per lo scambio di informazioni di peering BGP con la rete fisica. Questa rete è necessaria solo quando è necessaria la distribuzione di reti virtuali usando l'incapsulamento VXLAN per un altro livello di isolamento e per la multi-tenancy di rete.

Per ulteriori informazioni, vedere Pianificare un'infrastruttura SDN: Gestione e provider HNV.

Opzioni di isolamento della rete

Sono supportate le opzioni di isolamento di rete seguenti:

VLAN (IEEE 802.1Q)

Le VLAN consentono ai dispositivi che devono essere mantenuti separati per condividere il cablaggio di una rete fisica e tuttavia non possono interagire direttamente tra loro. Questa condivisione gestita produce vantaggi in termini di semplicità, sicurezza, gestione del traffico ed economia. Ad esempio, una VLAN può essere usata per separare il traffico all'interno di un'azienda in base a singoli utenti o gruppi di utenti o ruoli o in base alle caratteristiche del traffico. Molti servizi di hosting Internet usano VLAN per separare le zone private l'una dall'altra, consentendo di raggruppare i server di ogni cliente in un singolo segmento di rete indipendentemente dalla posizione in cui si trovano i singoli server nel data center. Alcune precauzioni sono necessarie per impedire l'escape del traffico da una determinata VLAN, un exploit noto come salto VLAN.

Per altre informazioni, vedere Informazioni sull'utilizzo di reti virtuali e VLAN.

Criteri di accesso alla rete predefiniti e microsegmentazione

I criteri di accesso alla rete predefiniti assicurano che tutte le macchine virtuali nel cluster Azure Stack HCI siano protette per impostazione predefinita dalle minacce esterne. Con questi criteri, l'accesso in ingresso a una macchina virtuale verrà bloccato per impostazione predefinita, offrendo al tempo stesso la possibilità di abilitare porte in ingresso selettive e di proteggere le macchine virtuali da attacchi esterni. Questa imposizione è disponibile tramite strumenti di gestione come Windows Admin Center.

La microsegmentazione comporta la creazione di criteri di rete granulari tra applicazioni e servizi. Ciò riduce essenzialmente il perimetro di sicurezza a un recinto intorno a ogni applicazione o macchina virtuale. Questa recinzione consente solo la comunicazione necessaria tra i livelli applicazione o altri limiti logici, rendendo così estremamente difficile la diffusione delle minacce informatiche in un secondo momento da un sistema a un altro. La microsegmentazione isola in modo sicuro le reti l'una dall'altra e riduce la superficie totale di attacco di un evento imprevisto di sicurezza di rete.

I criteri di accesso alla rete predefiniti e la microsegmentazione vengono realizzati come regole del firewall con stato a cinque tuple (prefisso dell'indirizzo di origine, porta di origine, prefisso degli indirizzi di destinazione, porta di destinazione e protocollo) nei cluster Azure Stack HCI. Le regole del firewall sono note anche come gruppi di sicurezza di rete.Firewall rules are also known as Network Security Groups (NSG). Questi criteri vengono applicati alla porta vSwitch di ogni macchina virtuale. I criteri vengono inseriti nel livello di gestione e il controller di rete SDN li distribuisce a tutti gli host applicabili. Questi criteri sono disponibili per le macchine virtuali nelle reti VLAN tradizionali e nelle reti di sovrimpressione SDN.

Per altre informazioni, vedere Che cos'è Il firewall del data center?.

QoS per le schede di rete delle macchine virtuali

È possibile configurare qualità del servizio (QoS) per una scheda di rete vm per limitare la larghezza di banda in un'interfaccia virtuale per impedire a una macchina virtuale a traffico elevato di lottare con altri traffico di rete delle macchine virtuali. È anche possibile configurare QoS per riservare una quantità specifica di larghezza di banda per una macchina virtuale per assicurarsi che la macchina virtuale possa inviare traffico indipendentemente da altro traffico in rete. Questa operazione può essere applicata alle macchine virtuali collegate alle reti VLAN tradizionali e alle macchine virtuali collegate alle reti di sovrimpressione SDN.

Per ulteriori informazioni, vedere Configurare QoS per una scheda di rete VM.

Reti virtuali

La virtualizzazione di rete fornisce reti virtuali alle macchine virtuali in modo analogo a come la virtualizzazione server (hypervisor) fornisce macchine virtuali al sistema operativo. La virtualizzazione di rete separa le reti virtuali dall'infrastruttura di rete fisica e rimuove i vincoli di VLAN e assegnazione di indirizzi IP gerarchici dal provisioning delle macchine virtuali. Tale flessibilità semplifica il passaggio a cloud IaaS IaaS (Infrastructure-as-a-Service) ed è efficiente per gli host e gli amministratori dei data center per gestire l'infrastruttura e mantenere l'isolamento multi-tenant, i requisiti di sicurezza e gli indirizzi IP delle macchine virtuali sovrapposti.

Per altre informazioni, vedere Virtualizzazione rete Hyper-V.

Opzioni dei servizi di rete L3

Sono disponibili le opzioni del servizio di rete L3 seguenti:

Peering di rete virtuale

Il peering di reti virtuali consente di connettere facilmente due reti virtuali. Dopo il peering, ai fini della connettività, le reti virtuali vengono visualizzate come una sola. Il peering di reti virtuali offre i vantaggi seguenti:

- Il traffico tra macchine virtuali nelle reti virtuali con peering viene instradato attraverso l'infrastruttura backbone solo tramite indirizzi IP privati. La comunicazione tra le reti virtuali non richiede internet pubblico o gateway.

- Connessione a bassa latenza e larghezza di banda elevata tra le risorse in reti virtuali diverse.

- Possibilità per le risorse in una rete virtuale di comunicare con le risorse in una rete virtuale diversa.

- Nessuna interruzione per le risorse in entrambe le reti virtuali durante l'installazione del peering.

Per altre informazioni, vedere Peering di rete virtuale.

Bilanciatore di carico software SDN

I provider di servizi cloud e le aziende che distribuiscono SDN (Software Defined Networking) possono usare Software Load Balancer (SLB) per distribuire uniformemente il traffico di rete dei clienti tra le risorse di rete virtuale. SLB consente di abilitare più server per l'hosting dello stesso carico di lavoro, offrendo disponibilità e scalabilità elevate. Viene usato anche per fornire servizi NAT (Network Address Translation) in ingresso per l'accesso in ingresso alle macchine virtuali e servizi NAT in uscita per la connettività in uscita.

Con SLB è possibile aumentare le funzionalità di bilanciamento del carico usando macchine virtuali SLB negli stessi server di calcolo Hyper-V usati per gli altri carichi di lavoro delle macchine virtuali. SLB supporta la creazione rapida e l'eliminazione degli endpoint di bilanciamento del carico in base alle esigenze per le operazioni CSP. Inoltre, l'SLB supporta decine di gigabyte per ogni cluster, offre un modello di provisioning semplice ed è facile da scalare verso l'alto e verso il basso. SLB usa Border Gateway Protocol per annunciare gli indirizzi IP virtuali alla rete fisica.

Per altre informazioni, vedere Che cos'è SLB per SDN?

Gateway VPN SDN

Il gateway SDN è un router BGP (Border Gateway Protocol) basato su software progettato per CSP e aziende che ospitano reti virtuali multi-tenant utilizzando la Virtualizzazione di rete Hyper-V. È possibile usare il gateway RAS per instradare il traffico di rete tra una rete virtuale e un'altra rete, locale o remota.

Il gateway SDN può essere usato per:

Creare connessioni IPsec sicure da sito a sito tra reti virtuali SDN e reti dei clienti esterne tramite Internet.

Creare connessioni GRE (Generic Routing Encapsulation) tra reti virtuali SDN e reti esterne. La differenza tra connessioni da sito a sito e connessioni GRE è che quest'ultima non è una connessione crittografata.

Per altre informazioni sugli scenari di connettività GRE, vedere Tunneling GRE in Windows Server.

Creare connessioni di livello 3 (L3) tra reti virtuali SDN e reti esterne. In questo caso, il gateway SDN funge semplicemente da router tra la rete virtuale e la rete esterna.

Il gateway SDN richiede il controller di rete SDN. Controller di rete esegue la distribuzione dei pool di gateway, configura

Passaggi successivi

Informazioni sui modelli di distribuzione della rete locale di Azure a due nodi .