Visualizzare le tracce

Importante

Gli elementi contrassegnati (anteprima) in questo articolo sono attualmente disponibili in anteprima pubblica. Questa anteprima viene fornita senza un contratto di servizio e non è consigliabile per i carichi di lavoro di produzione. Alcune funzionalità potrebbero non essere supportate o potrebbero presentare funzionalità limitate. Per altre informazioni, vedere le Condizioni supplementari per l'uso delle anteprime di Microsoft Azure.

Dopo aver instrumentato l'applicazione per registrare le tracce, verrà illustrato come visualizzare le tracce nelle soluzioni locali e cloud per eseguire il debug dell'applicazione.

Visualizzare le tracce per il debug locale

Per abilitare le tracce in locale, sono disponibili due opzioni:

- Con Prompty è possibile tracciare l'applicazione con Azure AI Inference SDK, che offre visibilità avanzata e risoluzione dei problemi semplificata per le applicazioni basate su LLM. Questo metodo segue la specifica OpenTelemetry, l'acquisizione e la visualizzazione dei dettagli di esecuzione interni di qualsiasi applicazione di intelligenza artificiale, migliorando così l'esperienza di sviluppo complessiva. Per altre informazioni, vedere Richiesta di debug.

- Dashboard aspirare: un dashboard OpenTelemetry gratuito e open source per ottenere informazioni approfondite sulle app nel computer di sviluppo locale. Per altre informazioni, vedere Aspira dashboard.

Visualizzare le tracce nel portale di Azure AI Foundry

Prima di poter accedere al portale di Azure AI Foundry, collegare una risorsa di Application Insights al progetto.

- Passare al progetto nel portale di Azure AI Foundry.

- Selezionare la pagina Traccia sul lato sinistro.

- Selezionare Crea nuovo per collegare una nuova risorsa di Application Insights al progetto.

- Specificare un nome e selezionare Crea.

Installare quindi l'SDK opentelemetry :

%pip install azure-monitor-opentelemetry

Abilitare ora la traccia con l'output nella console:

import os

from azure.monitor.opentelemetry import configure_azure_monitor

os.environ['AZURE_TRACING_GEN_AI_CONTENT_RECORDING_ENABLED'] = 'true'

# Enable Azure Monitor tracing

application_insights_connection_string = project.telemetry.get_connection_string()

if not application_insights_connection_string:

print("Application Insights was not enabled for this project.")

print("Enable it via the 'Tracing' tab in your Azure AI Foundry project page.")

exit()

configure_azure_monitor(connection_string=application_insights_connection_string)

Eseguire infine una chiamata di inferenza. La chiamata viene registrata in Azure AI Foundry. Questo codice stampa un collegamento alle tracce.

response = chat.complete(

model="gpt-4o-mini",

messages=[

{"role": "system", "content": "You are an AI assistant that is a travel planning expert especially with National Parks."},

{"role": "user", "content": "Hey, can you recommend me trails I should go on when I visit Mount Rainier?"},

]

)

print("View traces at:")

print(f"https://ai.azure.com/tracing?wsid=/subscriptions/{project.scope['subscription_id']}/resourceGroups/{project.scope['resource_group_name']}/providers/Microsoft.MachineLearningServices/workspaces/{project.scope['project_name']}")

Selezionare il collegamento e iniziare a visualizzare le tracce nel portale di Azure AI Foundry.

Eseguire il debug e filtrare le tracce

Nel progetto è possibile filtrare le tracce nel modo desiderato.

Selezionando una traccia, è possibile scorrere ogni intervallo e identificare i problemi osservando il modo in cui l'applicazione risponde.

Aggiornare la risorsa di Application Insights associata

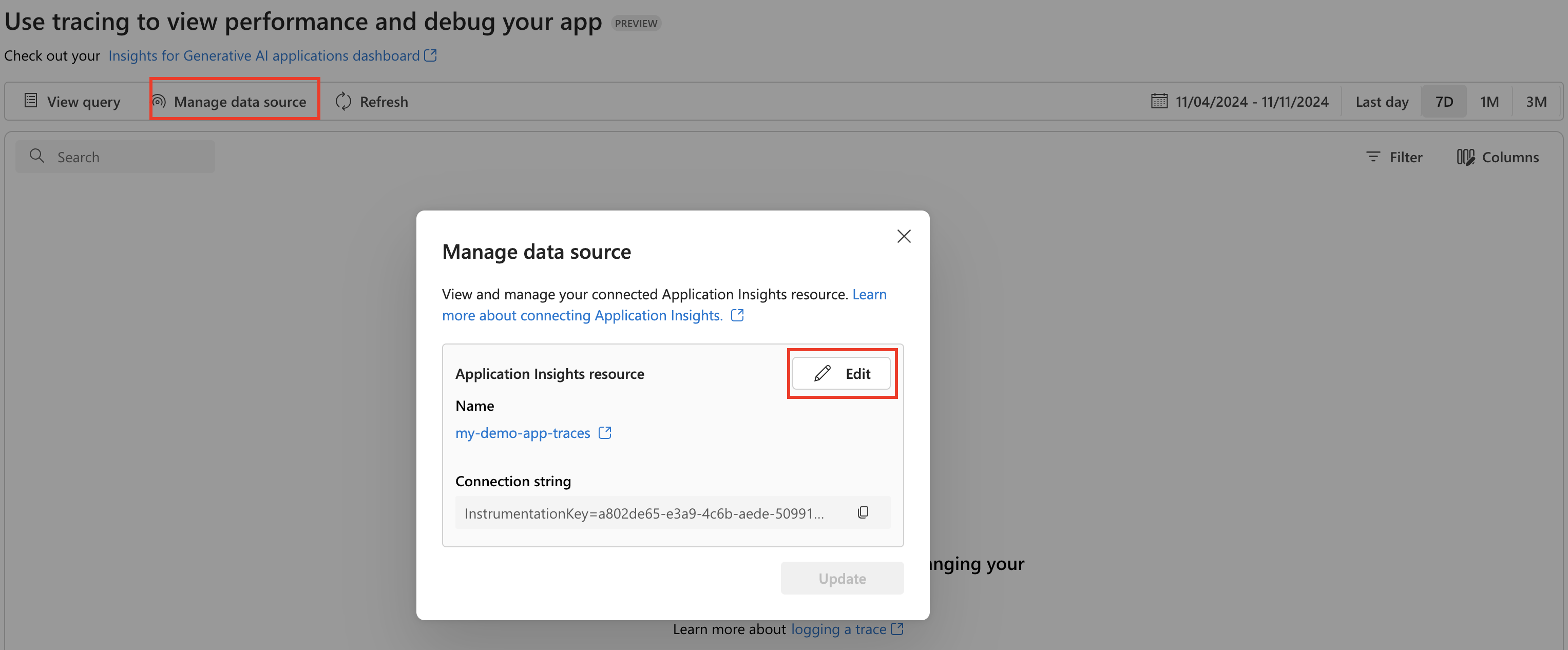

Per aggiornare la risorsa di Application Insights collegata al progetto, passare a Gestisci origine dati e Modifica per passare a una nuova risorsa di Application Insights.

Visualizzare le tracce in Monitoraggio di Azure

Se sono state registrate tracce usando il frammento di codice precedente, tutte sono impostate per visualizzare le tracce in Application Insights di Monitoraggio di Azure. È possibile aprire in Application Insights da Gestisci origine dati e usare la visualizzazione Dettagli transazione end-to-end per analizzare ulteriormente.

Per altre informazioni su come inviare tracce di inferenza di Intelligenza artificiale di Azure a Monitoraggio di Azure e creare una risorsa di Monitoraggio di Azure, vedere la documentazione di OpenTelemetry di Monitoraggio di Azure.

Visualizzare gli intervalli e le tracce generativi dell'intelligenza artificiale

Dal progetto Azure AI Foundry è anche possibile aprire il dashboard personalizzato che fornisce informazioni dettagliate specifiche per monitorare l'applicazione di intelligenza artificiale generativa.

In questa cartella di lavoro di Azure è possibile visualizzare gli intervalli di intelligenza artificiale di generazione e passare alla visualizzazione dei dettagli delle transazioni end-to-end di Monitoraggio di Azure per approfondire e analizzare.

Altre informazioni sull'uso di questa cartella di lavoro per monitorare l'applicazione, vedere la documentazione della cartella di lavoro di Azure.