Valutazione delle applicazioni di intelligenza artificiale generativa

Importante

Gli elementi contrassegnati (anteprima) in questo articolo sono attualmente disponibili in anteprima pubblica. Questa anteprima viene fornita senza un contratto di servizio e non è consigliabile per i carichi di lavoro di produzione. Alcune funzionalità potrebbero non essere supportate o potrebbero presentare funzionalità limitate. Per altre informazioni, vedere le Condizioni supplementari per l'uso delle anteprime di Microsoft Azure.

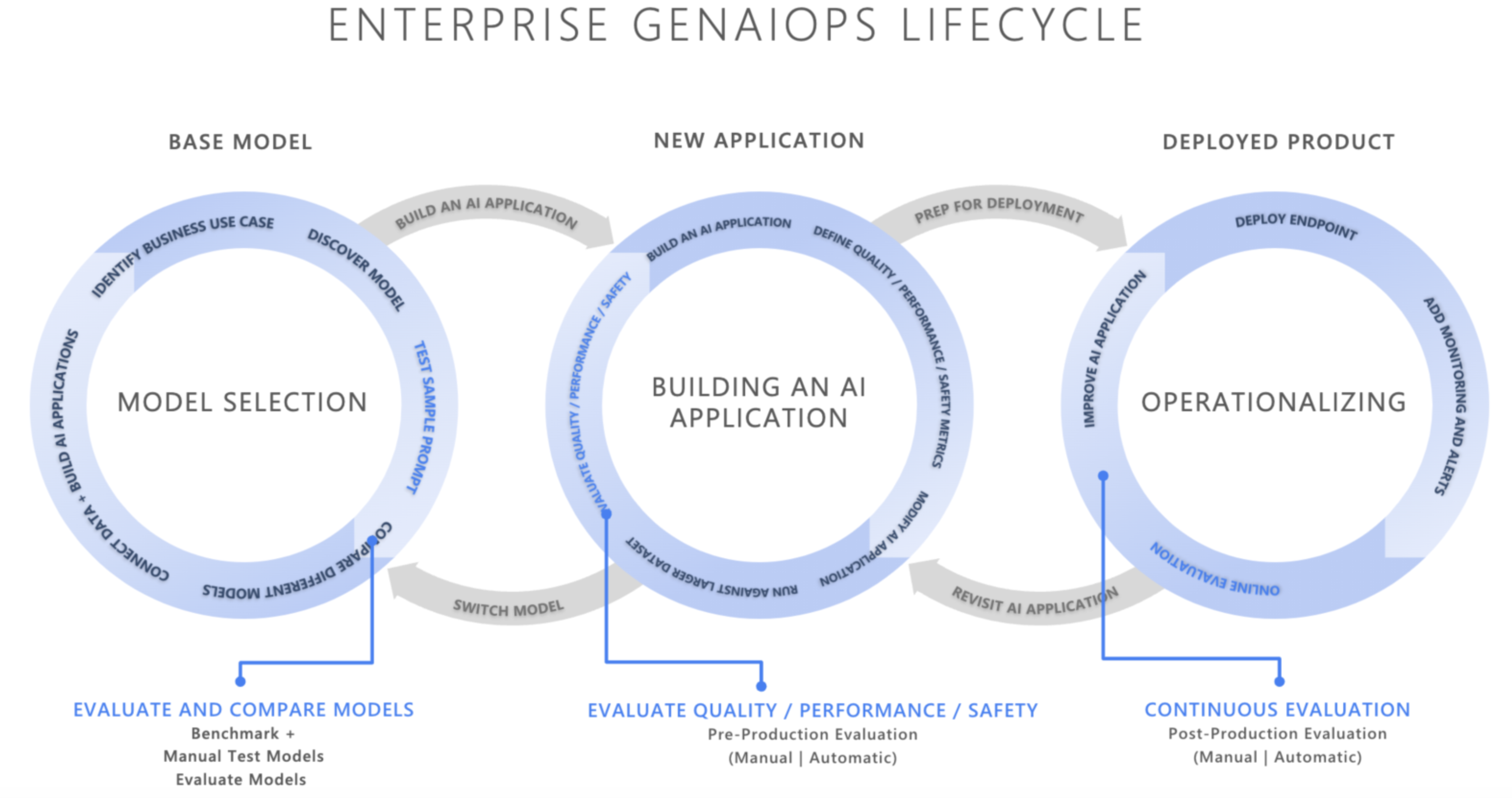

Nel panorama in rapida evoluzione dell'intelligenza artificiale, l'integrazione di Generative AI Operations (GenAIOps) sta trasformando il modo in cui le organizzazioni sviluppano e distribuiscono applicazioni di intelligenza artificiale. Man mano che le aziende si affidano sempre più all'IA per migliorare il processo decisionale, migliorare le esperienze dei clienti e favorire l'innovazione, l'importanza di un framework di valutazione affidabile non può essere superata. La valutazione è un componente essenziale del ciclo di vita generativo dell'intelligenza artificiale per creare fiducia e fiducia nelle applicazioni incentrate sull'intelligenza artificiale. Se non sono progettate con attenzione, queste applicazioni possono produrre output creati e non in primo piano nel contesto, irrilevanti o incoerenti, causando scarse esperienze dei clienti, o peggio, perpetuare stereotipi sociali, promuovere la disinformazione, esporre le organizzazioni ad attacchi dannosi o un'ampia gamma di altri impatti negativi.

Gli analizzatori sono strumenti utili per valutare la frequenza e la gravità dei rischi del contenuto o comportamenti indesiderati nelle risposte di intelligenza artificiale. L'esecuzione di valutazioni iterative e sistematiche con gli analizzatori corretti può aiutare i team a misurare e risolvere potenziali problemi di qualità, sicurezza o sicurezza della risposta durante tutto il ciclo di vita dello sviluppo di intelligenza artificiale, dalla selezione iniziale del modello attraverso il monitoraggio post-produzione. Valutazione nell'ambiente di produzione GenAI Ops Lifecycle.

Comprendendo e implementando strategie di valutazione efficaci in ogni fase, le organizzazioni possono garantire che le soluzioni di IA soddisfino non solo le aspettative iniziali, ma si adattino e prosperano anche in ambienti reali. Si esaminerà ora il modo in cui la valutazione rientra nelle tre fasi critiche del ciclo di vita dell'intelligenza artificiale

Selezione del modello di base

La prima fase del ciclo di vita dell'intelligenza artificiale prevede la selezione di un modello di base appropriato. I modelli generativi di intelligenza artificiale variano notevolmente in termini di funzionalità, punti di forza e limitazioni, quindi è essenziale identificare il modello più adatto al caso d'uso specifico. Durante la valutazione del modello di base, è possibile "spostarsi" per confrontare modelli diversi testandone gli output rispetto a un set di criteri rilevanti per l'applicazione.

Le considerazioni chiave in questa fase possono includere:

- Accuratezza/qualità: quanto bene il modello genera risposte pertinenti e coerenti?

- Prestazioni per attività specifiche: il modello può gestire il tipo di richieste e il contenuto necessari per il caso d'uso? Qual è la latenza e il costo?

- Distorsioni e considerazioni etiche: il modello produce output che potrebbero perpetuare o promuovere stereotipi dannosi?

- Rischio e sicurezza: esistono rischi per il modello che genera contenuto non sicuro o dannoso?

È possibile esplorare ibenchmark di Azure AI Foundry per valutare e confrontare i modelli sui set di dati disponibili pubblicamente, rigenerando al tempo stesso i risultati del benchmark sui propri dati. In alternativa, è possibile valutare uno dei molti modelli di intelligenza artificiale generativi di base tramite Azure AI Evaluation SDK, come illustrato, vedere Valutare gli endpoint del modello di esempio.

Valutazione pre-produzione

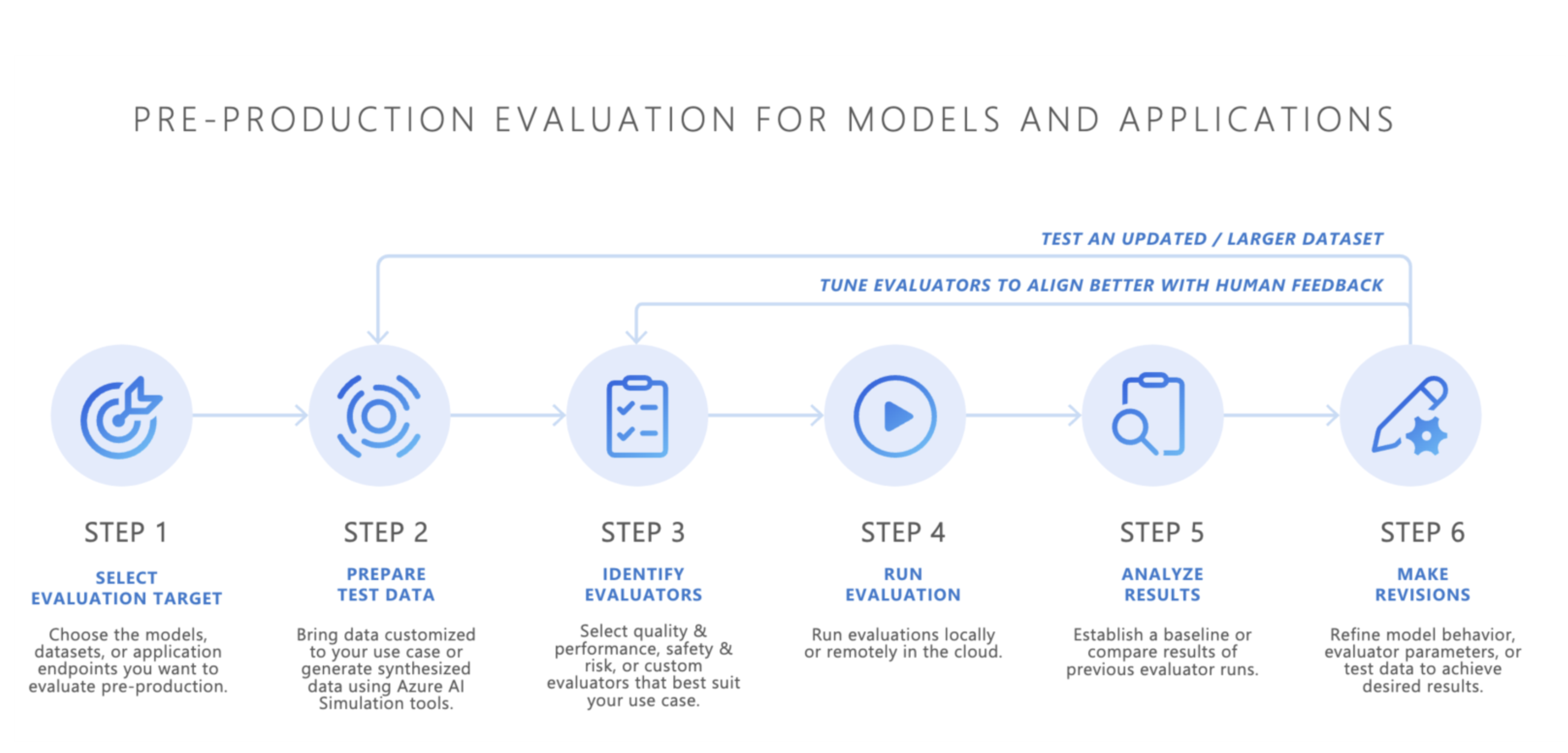

Dopo aver selezionato un modello di base, il passaggio successivo consiste nello sviluppare un'applicazione di intelligenza artificiale, ad esempio un chatbot basato sull'intelligenza artificiale, un'applicazione rag (Retrieval-Augmented Generation), un'applicazione di intelligenza artificiale agentica o qualsiasi altro strumento di intelligenza artificiale generativa. In seguito allo sviluppo, inizia la valutazione pre-produzione. Prima di distribuire l'applicazione in un ambiente di produzione, è essenziale eseguire test rigorosi per garantire che il modello sia realmente pronto per l'uso reale.

La valutazione pre-produzione prevede:

- Test con set di dati di valutazione: questi set di dati simulano interazioni utente realistiche per garantire che l'applicazione di intelligenza artificiale venga eseguita come previsto.

- Identificazione dei casi perimetrali: trovare scenari in cui la qualità della risposta dell'applicazione di intelligenza artificiale potrebbe degradare o produrre output indesiderati.

- Valutazione dell'affidabilità: garantire che il modello possa gestire una gamma di variazioni di input senza cali significativi di qualità o sicurezza.

- Misurazione delle metriche chiave: le metriche, ad esempio il livello di risposta, la pertinenza e la sicurezza, vengono valutate per confermare l'idoneità per la produzione.

La fase di pre-produzione funge da controllo di qualità finale, riducendo il rischio di distribuire un'applicazione di intelligenza artificiale che non soddisfa gli standard di sicurezza o prestazioni desiderati.

- Bring Your Own Data (Bring Your Own Data): è possibile valutare le applicazioni di intelligenza artificiale in pre-produzione usando i propri dati di valutazione con Azure AI Foundry o gli analizzatori supportati di Azure AI Evaluation SDK, tra cui qualità di generazione, sicurezza o analizzatori personalizzati e visualizzare i risultati tramite il portale di Azure AI Foundry.

- Simulatori: se non si hanno dati di valutazione (dati di test), i simulatori di Azure AI Evaluation SDK possono essere utili generando query correlate all'argomento o antagoniste. Questi simulatori testano la risposta del modello alle query appropriate o simili agli attacchi (casi perimetrali).

- Il simulatore antagonista inserisce query che simulano potenziali minacce alla sicurezza o tentativi di jailbreak, aiutando a identificare le limitazioni e preparare il modello per condizioni impreviste.

- I simulatori appropriati al contesto generano conversazioni tipiche e rilevanti che si prevede dagli utenti di testare la qualità delle risposte.

In alternativa, è anche possibile usare il widget di valutazione di Azure AI Foundry per testare le applicazioni di intelligenza artificiale generative.

Una volta ottenuti risultati soddisfacenti, l'applicazione di intelligenza artificiale può essere distribuita nell'ambiente di produzione.

Monitoraggio post-produzione

Dopo la distribuzione, l'applicazione di intelligenza artificiale entra nella fase di valutazione post-produzione, nota anche come valutazione o monitoraggio online. In questa fase, il modello viene incorporato all'interno di un prodotto reale e risponde alle query utente effettive. Il monitoraggio garantisce che il modello continui a comportarsi come previsto e si adatti alle modifiche apportate al comportamento o al contenuto dell'utente.

- Monitoraggio continuo delle prestazioni: misurazione regolare della risposta dell'applicazione di intelligenza artificiale usando le metriche chiave per garantire una qualità coerente dell'output.

- Risposta agli eventi imprevisti: rispondere rapidamente a eventuali output dannosi, ingiusti o inappropriati che possono verificarsi durante l'uso reale.

Monitorando continuamente il comportamento dell'applicazione di intelligenza artificiale nell'ambiente di produzione, è possibile mantenere esperienze utente di alta qualità e risolvere rapidamente eventuali problemi che si verificano.

Conclusione

GenAIOps riguarda la creazione di un processo affidabile e ripetibile per la gestione delle applicazioni di intelligenza artificiale generative nel ciclo di vita. La valutazione svolge un ruolo fondamentale in ogni fase, dalla selezione del modello di base, ai test di pre-produzione, al monitoraggio post-produzione in corso. Misurando e risolvendo sistematicamente i rischi e affinando i sistemi di IA in ogni passaggio, i team possono creare soluzioni di intelligenza artificiale generative che non sono solo potenti, ma anche affidabili e sicure per l'uso reale.

Foglio informativo:

| Scopo | Processo | Parametri |

|---|---|---|

| Che cosa stai valutando? | Identificare o compilare analizzatori pertinenti | - Qualità e prestazioni ( notebook di esempio di qualità e prestazioni) - Sicurezza e sicurezza (notebook di esempio sicurezza e sicurezza) - Personalizzato (notebook di esempio personalizzato) |

| Quali dati è necessario usare? | Caricare o generare un set di dati pertinente | Simulatore generico per misurare qualità e prestazioni (notebook di esempio del simulatore generico) - Simulatore antagonista per misurare sicurezza e sicurezza (notebook di esempio del simulatore antagonista) |

| Quali risorse devono eseguire la valutazione? | Eseguire la valutazione | - Esecuzione locale - Esecuzione del cloud remoto |

| Come ha eseguito il modello o l'app? | Analisi dei risultati | Visualizzare i punteggi aggregati, visualizzare i dettagli, i dettagli del punteggio, confrontare le esecuzioni di valutazione |

| Come posso migliorare? | Apportare modifiche a modelli, app o analizzatori | - Se i risultati della valutazione non sono allineati al feedback umano, modificare l'analizzatore. - Se i risultati della valutazione sono allineati al feedback umano ma non soddisfano le soglie di qualità/sicurezza, applicare mitigazioni mirate. |

Contenuto correlato

- Valutare le app di intelligenza artificiale generativa tramite il playground

- Valutare le app di intelligenza artificiale generative con Azure AI Foundry SDK o il portale

- Metriche di valutazione e monitoraggio per l'IA generativa

- Nota sulla trasparenza per le valutazioni di sicurezza di Azure AI Foundry