Eseguire il training e testare l'app LUIS

Importante

LUIS verrà ritirato il 1 ottobre 2025 e a partire dal 1 aprile 2023 non è più possibile creare nuove risorse LUIS. È consigliabile eseguire la migrazione delle applicazioni LUIS a comprensione del linguaggio di conversazione (CLU) per trarre vantaggio dal supporto continuo del prodotto e dalle funzionalità multilingua.

Il training è il processo di apprendimento per l'app Language Understanding (LUIS) al fine di estrarre finalità ed entità dalle espressioni dell'utente. Il training viene eseguito dopo aver apportato gli aggiornamenti al modello, ad esempio aggiunta, modifica, etichettatura o eliminazione di entità, finalità o espressioni.

Il training e il test di un'app costituiscono un processo iterativo. Dopo aver eseguito il training dell'app LUIS, testarla con espressioni di esempio per verificare se le finalità e le entità vengono riconosciute correttamente. Se così non fosse, aggiornare l'app LUIS, quindi eseguire nuovamente il training e il test.

Il training viene applicato alla versione attiva nel portale LUIS.

Come eseguire il training in modo interattivo

Prima di iniziare il training dell'app nel portale LUIS, assicurarsi che ogni finalità abbia almeno un'espressione. È necessario eseguire il training dell'app LUIS almeno una volta per testarla.

- Accedere all'app selezionando il relativo nome nella pagina My Apps (App personali).

- Nell'app selezionare Esegui training nella parte in alto a destra dello schermo.

- Una volta completato il training, viene visualizzata una notifica nella parte superiore del browser.

Nota

Le date e le ore del training sono in GMT + 2.

Avviare il processo di training

Suggerimento

Non è necessario eseguire il training dopo ogni singola modifica. È opportuno eseguire il training dopo l'applicazione di un gruppo di modifiche al modello o se si desidera testare o pubblicare l'app.

Per eseguire il training dell'app nel portale LUIS, è sufficiente selezionare il pulsante Esegui training nell'angolo in alto a destra della schermata.

Il training con le API REST è invece un processo in due passaggi.

- Inviare una richiesta HTTP POST per il training.

- Richiedere lo stato del training con una richiesta HTTP GET.

Per sapere quando il training è completo, è necessario eseguire il polling dello stato finché il training non risulta completato per tutti i modelli.

Testare l'applicazione

Il processo di test consiste nel fornire espressioni di esempio a LUIS e nell'ottenere una risposta di finalità ed entità riconosciute. È possibile testare l'app LUIS in modo interattivo, un'espressione per volta, o fornire un batch di espressioni. Durante il test, è possibile confrontare la risposta di previsione del modello attivo corrente con la risposta di previsione del modello pubblicato.

Il test di un'app costituisce un processo iterativo. Dopo aver eseguito il training dell'app LUIS, testarla con espressioni di esempio per verificare se le finalità e le entità vengono riconosciute correttamente. Se così non fosse, aggiornare l'app LUIS ed eseguire nuovamente il training e il test.

Test interattivi

I test interattivi vengono eseguiti nel pannello Test del portale LUIS. È possibile immettere un'espressione per vedere in che modo vengono identificate le finalità e le entità e quale punteggio viene attribuito loro. Se LUIS non stima le finalità e le entità di un'espressione come previsto, copiare l'espressione nella pagina Finalità come una nuova espressione. Etichettare quindi parti di tale espressione per permettere alle entità di eseguire il training dell'app LUIS.

Per altre informazioni sui punteggi di previsione, vedere Test batch se si testa più di un'espressione per volta, e l'articolo Punteggi di previsione per maggiori informazioni sui punteggi di previsione.

Eseguire il test di un'espressione

L'espressione di test non deve corrispondere esattamente a qualsiasi espressione di esempio nell'app. L'espressione di test deve includere la scelta delle parole, la lunghezza della frase e l'utilizzo delle entità previsto per un utente.

- Accedere al portale LUIS e quindi selezionare la sottoscrizione e la risorsa di creazione per vedere le app assegnate a tale risorsa.

- Aprire l’app selezionandone il nome alla pagina App personali.

- Selezionare Esegui test nell'angolo in alto a destra della schermata per l'app e verrà visualizzato un pannello a scorrimento.

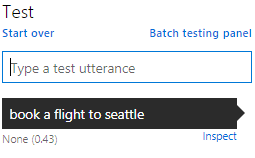

- Immettere un'espressione nella casella di testo e premere il pulsante Invio sulla tastiera. È possibile testare una singola espressione nella casella Esegui test o più espressioni come batch nel pannello Esegui test batch.

- L'espressione, la finalità principale relativa e il punteggio vengono aggiunti all'elenco di espressioni nella casella di testo. Nell'esempio precedente, questo viene visualizzato come "Nessuno (0,43)".

Esaminare la previsione

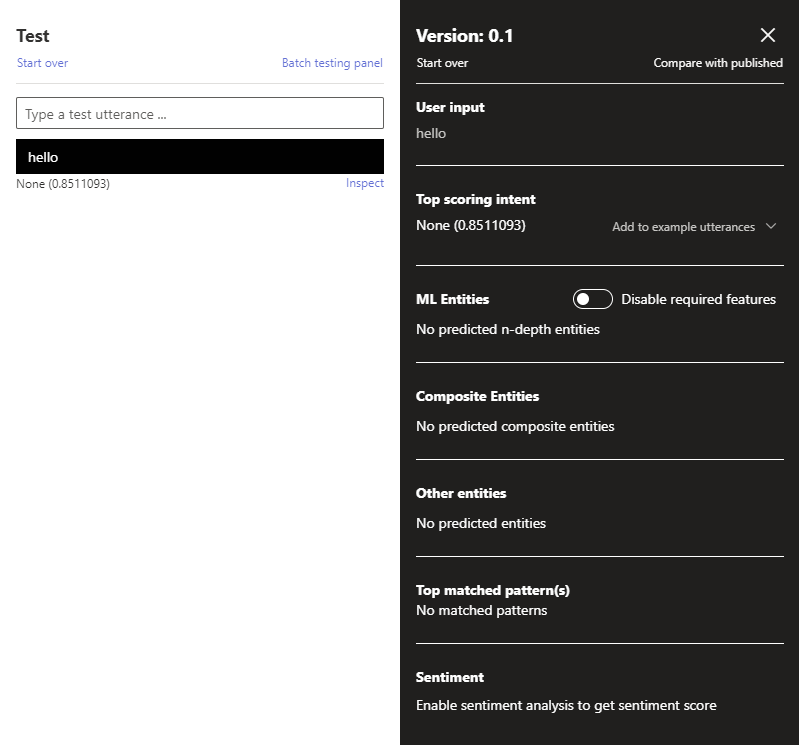

Esaminare i dettagli dei risultati del test nel pannello Ispeziona.

Con il pannello a scorrimento Esegui test aperto, selezionare Ispeziona per un'espressione da confrontare. Ispeziona si trova accanto alla finalità e al punteggio superiore dell'espressione. Fare riferimento all'immagine precedente.

Verrà visualizzato il pannello Ispeziona. Il pannello include la finalità con il punteggio più alto ed eventuali entità identificate. Il pannello mostra la previsione dell'espressione selezionata.

Suggerimento

Nel pannello di ispezione è possibile aggiungere l'espressione di test a una finalità selezionando Aggiungi alle espressioni di esempio.

Modificare le impostazioni di training deterministico usando l'API delle impostazioni della versione

Usare l'API delle impostazioni della versione con il set UseAllTrainingData impostato su true per disattivare il training deterministico.

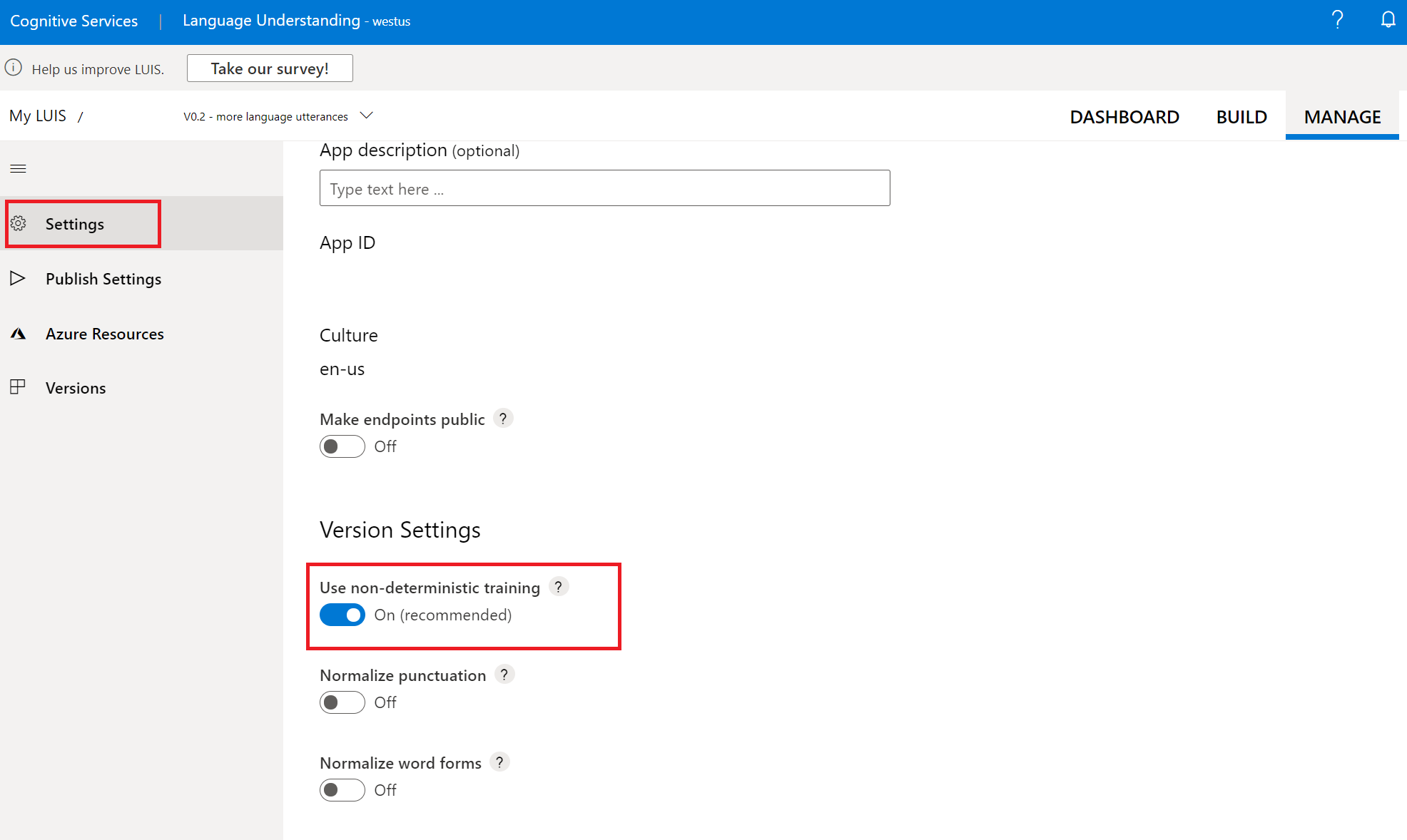

Modificare le impostazioni di training deterministico usando il portale LUIS

Accedere al portale LUIS e selezionare l'app. Selezionare Gestisci nella parte superiore della schermata, quindi selezionare Impostazioni. Abilitare o disabilitare l'opzione usa training non deterministico. Se disabilitata, il training userà tutti i dati disponibili. Il training userà solo un campione casuale di dati di altre finalità come dati negativi durante il training di ogni finalità

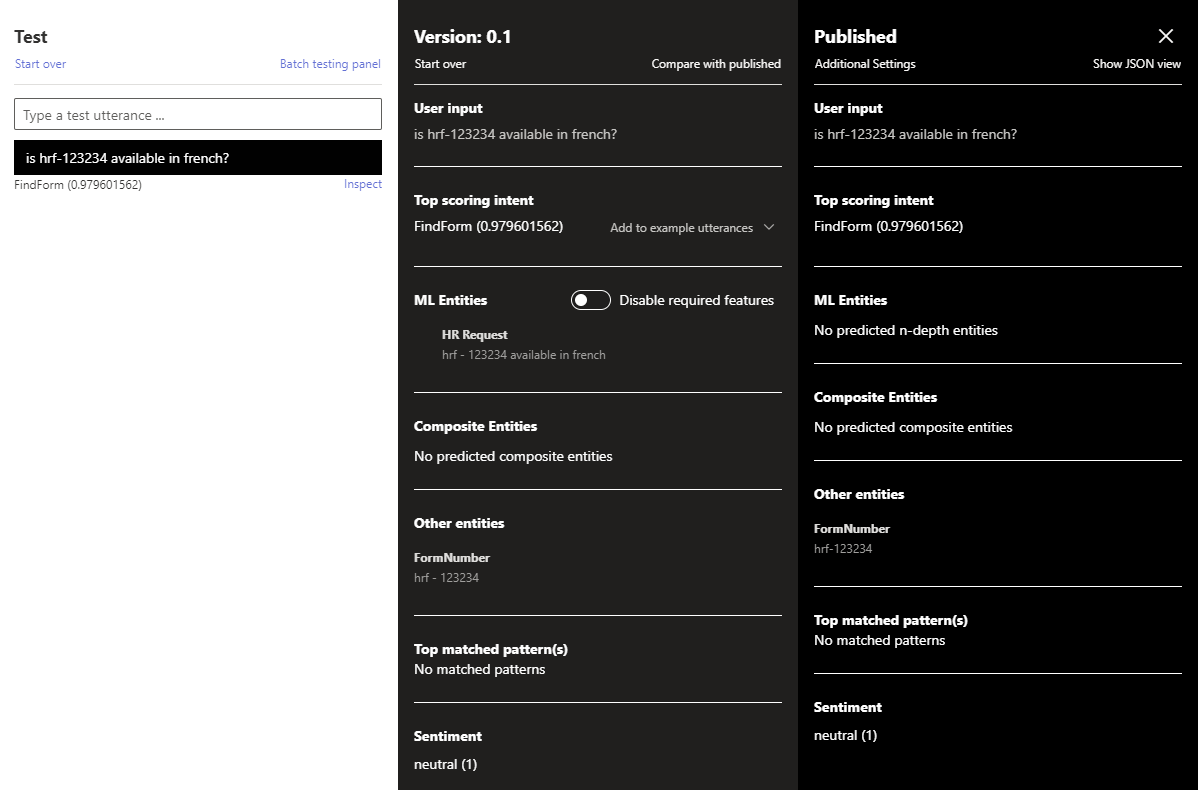

Visualizzare i risultati del sentiment

Se l'analisi del sentiment è stata configurata nella pagina Pubblica, i risultati del test includono il sentiment trovato nell'espressione.

Correggere la finalità del criterio corrispondente

Se si usano Criteri e l'espressione corrisponde a un criterio, ma è stata stimata la finalità errata, selezionare il collegamento Modifica del criterio, quindi selezionare la finalità corretta.

Eseguire il confronto con la versione pubblicata

È possibile testare la versione attiva dell'app con la versione endpoint pubblicata. Nel pannello Inspect (Ispeziona) selezionare Compare with published (Confronta con pubblicata).

Nota

Eventuali test sul modello pubblicato vengono dedotti dal saldo della quota di sottoscrizione di Azure.

Visualizzare l'endpoint JSON nel pannello test

È possibile visualizzare l'endpoint JSON restituito per il confronto selezionando Mostra visualizzazione JSON nell'angolo in alto a destra del riquadro.

Passaggi successivi

Se il test richiede il test di un batch di espressioni, vedere Esegui test batch.

Se il test indica che l'app LUIS non riconosce le finalità e le entità corrette, è possibile migliorare l'accuratezza dell'app LUIS etichettando più espressioni o aggiungendo funzionalità.