Configuration matérielle requise pour les espaces de stockage direct

Cet article décrit la configuration matérielle minimale requise pour les espaces de stockage direct. Pour connaître la configuration matérielle requise sur Azure Stack HCI, notre système d’exploitation conçu pour les déploiements hyperconvergés avec une connexion au cloud, consultez Avant de déployer Azure Stack HCI : déterminer la configuration matérielle requise.

Pour la production, Microsoft recommande d’acheter une solution matérielle/logicielle validée auprès de nos partenaires, notamment des outils de déploiement et des procédures. Ces solutions sont conçues, assemblées et validées dans le respect de notre architecture de référence pour garantir compatibilité et fiabilité, ce qui vous permet d’être opérationnel rapidement. Pour les solutions matérielles, visitez le site web des solutions Azure Stack HCI.

Conseil

Vous voulez évaluer les espaces de stockage direct mais n’avez pas de matériel ? Utilisez des machines virtuelles Hyper-V ou Azure, comme décrit dans Utilisation de espaces de stockage direct dans des clusters de machines virtuelles invitées.

Configuration de base requise

Important

Dans les scénarios où les nœuds de cluster sont implémentés, les adaptateurs de carte réseau, les pilotes et le microprogramme doivent correspondre exactement à l’association SET pour un fonctionnement approprié.

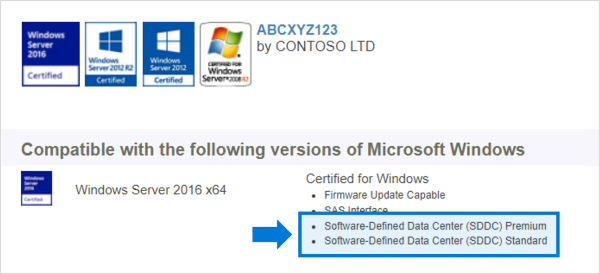

Les systèmes, composants, appareils et pilotes doivent être certifiés pour le système d’exploitation que vous utilisez dans le catalogue Windows Server. En outre, nous recommandons aux serveurs et aux cartes réseau de disposer des qualifications supplémentaires SDDC (Software-Defined Data Center) Standard et/ou Software-Defined Data Center (SDDC) Premium, comme illustré ci-dessous. Il existe plus de 1 000 composants avec les qualifications supplémentaires SDDC.

Le cluster entièrement configuré (serveurs, mise en réseau et stockage) doit passer tous les tests de validation de cluster par l’Assistant dans le Gestionnaire du cluster de basculement ou avec l’applet Test-Cluster de commande dans PowerShell.

En outre, les conditions suivantes s'appliquent :

Serveurs

- Deux serveurs minimum, 16 serveurs maximum

- Recommandation que tous les serveurs soient le même fabricant et le même modèle

UC

- Nehalem d’Intel ou un processeur plus récent et compatible ; ou

- AMD EPYC ou un processeur plus récent et compatible

Mémoire

- Mémoire pour Windows Server, machines virtuelles et autres applications ou charges de travail ; plus

- 4 Go de RAM par téraoctet (To) de capacité de lecteur de cache sur chaque serveur pour les métadonnées des espaces de stockage direct

Démarrage

- N’importe quel périphérique de démarrage pris en charge par Windows Server, qui contient à présent SATADOM

- Le miroir RAID 1 n’est pas obligatoire, mais il est pris en charge pour le démarrage

- Recommandé : taille minimale de 200 Go

Mise en réseau

Les espaces de stockage direct nécessitent une bande passante élevée fiable, une connexion réseau à faible latence entre chaque nœud.

Interconnexion minimale pour un nœud de petite échelle 2 à 3

- Carte d’interface réseau de 10 Gbits/s (carte réseau) ou plus rapide

- Plusieurs connexions réseau à partir de chaque nœud sont recommandées pour des questions de redondance et de performances

Interconnexion recommandée pour des performances élevées, à grande échelle ou des déploiements de 4+

- Cartes réseau avec accès direct à la mémoire à distance (RDMA), iWARP (recommandé) ou RoCE

- Plusieurs connexions réseau à partir de chaque nœud sont recommandées pour des questions de redondance et de performances

- 25 Gbits/s de carte réseau ou plus rapide

Interconnexions de nœuds commutées ou non

- Basculement : les commutateurs réseau doivent être correctement configurés pour gérer la bande passante et le type de réseau. Si vous utilisez RDMA qui implémente le protocole RoCE, la configuration du commutateur et du périphérique réseau est encore plus importante.

- Sans changement : les nœuds peuvent être interconnectés à l’aide de connexions directes, évitant l’utilisation d’un commutateur. Il est nécessaire que chaque nœud dispose d’une connexion directe avec chaque autre nœud du cluster.

Lecteurs

Les espaces de stockage direct fonctionnent avec des lecteurs en attachement direct SATA, SAS, NVMe ou mémoire persistante (PMem) qui sont physiquement attachés à un seul serveur chacun. Pour plus d’aide sur le choix des lecteurs, consultez les articles Choix de lecteurset Comprendre et déployer la mémoire persistante.

- Les lecteurs SATA, SAS, mémoire persistante et NVMe (M.2, U.2 et Carte de complément) sont tous pris en charge

- Les lecteurs natifs 512n, 512e et 4K sont tous pris en charge

- Les disques SSD doivent fournir une protection contre la perte de puissance

- Même nombre et types de lecteurs dans chaque serveur. Consultez les Considérations relatives à la symétrie de lecteur

- Les appareils de cache doivent être de 32 Go ou plus

- Les appareils de mémoire permanente sont utilisés en mode de stockage de blocs

- Lorsque vous utilisez des périphériques de mémoire persistante comme périphériques de cache, vous devez utiliser des périphériques de capacité NVMe ou SSD (vous ne pouvez pas utiliser de disques durs)

- Si vous utilisez des disques durs pour fournir une capacité de stockage, vous devez utiliser la mise en cache de bus de stockage. La mise en cache de bus de stockage n’est pas requise lors de l’utilisation de déploiements flash

- Le pilote NVMe est le pilote fourni par Microsoft inclus dans Windows (stornvme.sys)

- Recommandé : le nombre de lecteurs de capacité est un multiple entier du nombre de lecteurs de cache

- Recommandé : les lecteurs de cache doivent avoir une grande endurance en écriture : au moins 3 écritures de lecteur par jour (DWPD) ou au moins 4 téraoctets écrits (TBW) par jour. Consultez Présentation des écritures de lecteur par jour (DWPD), téraoctets écrits (TBW) et le minimum recommandé pour les espaces de stockage direct

Notes

Lorsque vous utilisez tous les lecteurs flash pour la capacité de stockage, les avantages de la mise en cache du pool de stockage seront limités. En savoir plus sur le cache du pool de stockage.

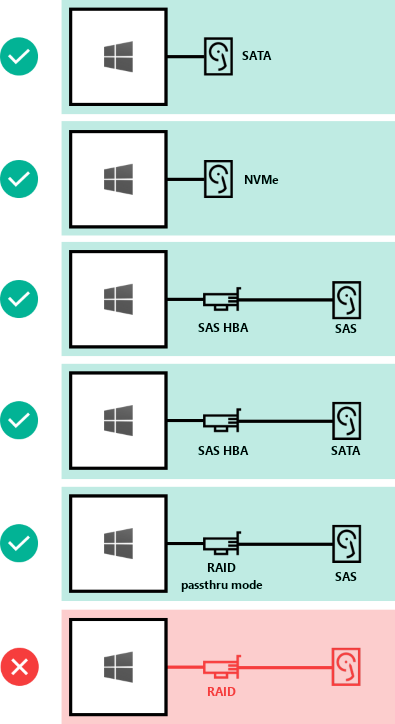

Voici comment les lecteurs peuvent être connectés pour les espaces de stockage direct :

- Lecteurs SATA attachés directement

- Lecteurs NVMe attachés direct

- Adaptateur de bus hôte SAS (HBA) avec lecteurs SAS

- Adaptateur de bus hôte SAS (HBA) avec lecteurs SATA

- Cartes de contrôleur RAID passant directement par des dispositifs de stockage physique SAS uniquement

- NON SUPPORTÉ : Les cartes de contrôleur RAID qui ne supportent pas le pass-through direct des périphériques de stockage physique SAS ou du stockage SAN (Fibre Channel, iSCSI, FCoE). Les cartes de bus hôte (HBA) doivent implémenter un mode Pass-through simple pour tous les dispositifs de stockage utilisés pour les espaces de stockage direct

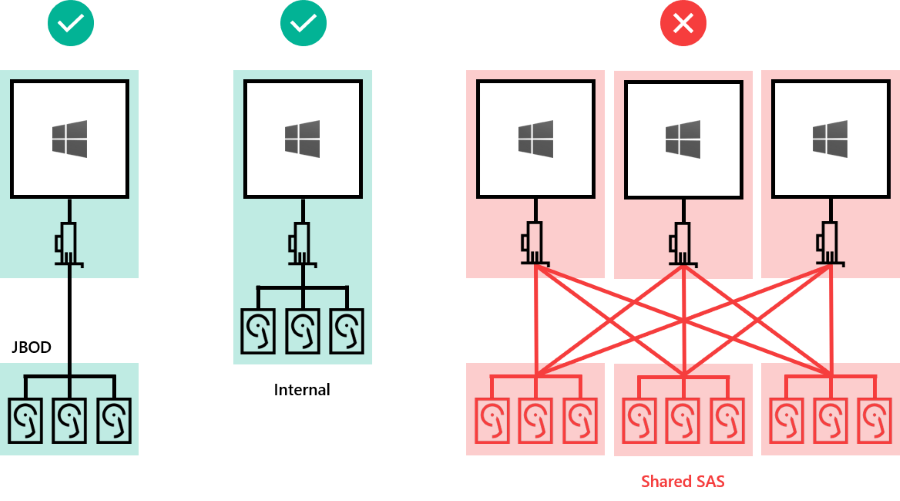

Les lecteurs peuvent être internes au serveur ou dans un boîtier externe connecté à un seul serveur. SCSI Enclosure Services (SES) est requis pour le mappage et l’identification des emplacements. Chaque boîtier externe doit présenter un identificateur unique (ID unique).

- Lecteurs internes au serveur

- Lecteurs dans un boîtier externe (« JBOD ») connecté à un serveur

- NON PRIS EN CHARGE : les boîtiers SAS partagés connectés à plusieurs serveurs, ou toute forme de MPIO (Multipath IO) où les lecteurs sont accessibles par plusieurs chemins d’accès.

Nombre minimal de lecteurs (exclut le lecteur de démarrage)

Le nombre minimal de lecteurs de capacité dont vous avez besoin varie selon votre scénario de déploiement. Si vous envisagez d’utiliser le cache du pool de stockage, il doit y avoir au moins 2 appareils de cache par serveur.

Vous pouvez déployer les espaces de stockage direct sur un cluster de serveurs physiques ou sur des clusters d’invités de machine virtuelle. Vous pouvez configurer votre conception des espaces de stockage direct pour les performances, la capacité ou les scénarios équilibrés en fonction de la sélection d’appareils de stockage physique ou virtuel. Les déploiements virtualisés tirent parti des performances et de la résilience du stockage sous-jacent du cloud privé ou public. Les espaces de stockage direct déployé sur des clusters invités de machine virtuelle vous permettent d’utiliser des solutions de haute disponibilité dans l’environnement virtuel.

Les sections suivantes décrivent les conditions minimales requises pour les déploiements physiques et virtuels.

Déploiements physiques

Ce tableau montre le nombre minimal de lecteurs de capacité par type pour les déploiements matériels tels qu’Azure Stack HCI version 21H2 ou ultérieure et Windows Server.

| Type de lecteur présent (capacité uniquement) | Lecteurs minimum requis (Windows Server) | Lecteurs minimum requis (Azure Stack HCI) |

|---|---|---|

| Toutes les mémoires persistantes (même modèle) | 4 mémoire persistantes | 2 mémoires persistantes |

| Tous NVMe (même modèle) | 4 NVMe | 2 NVMe |

| Tous SSD (même modèle) | 4 SSD | 2 SSD |

Si vous utilisez le cache du pool de stockage, il doit y avoir au moins 2 lecteurs supplémentaires configurés pour le cache. Le tableau indique le nombre minimal de lecteurs requis pour les déploiements Windows Server et Azure Stack HCI à l’aide de 2 nœuds ou plus.

| Type de lecteur présent | Disques minimaux requis |

|---|---|

| Mémoire persistante + NVMe ou SSD | 2 mémoires persistantes + 4 NVMe ou SSD |

| NVMe + SSD | 2 NVMe + 4 SSD |

| NVMe + HDD | 2 NVMe + 4 HDD |

| SSD + HDD | 2 SSD + 4 HDD |

Important

Le cache du pool de stockage ne peut pas être utilisé avec Azure Stack HCI dans un déploiement à nœud unique.

Déploiement virtuel

Ce tableau indique le nombre minimal de lecteurs par type pour les déploiements virtuels tels que les machines virtuelles invitées Windows Server ou Windows Server Azure Edition.

| Type de lecteur présent (capacité uniquement) | Disques minimaux requis |

|---|---|

| Disque dur virtuel | 2 |

Conseil

Pour améliorer les performances des machines virtuelles invitées lors de l’exécution sur Azure Stack HCI ou Windows Server, envisagez d’utiliser le cache de lecture CSV en mémoire pour mettre en cache les opérations de lecture non mises en cache.

Si vous utilisez les espaces de stockage direct dans un environnement virtuel, vous devez prendre en compte les éléments suivants :

- Les disques virtuels ne sont pas sensibles aux défaillances comme les lecteurs physiques, mais vous dépendez des performances et de la fiabilité du cloud public ou privé

- Il est recommandé d’utiliser un niveau unique de stockage à faible latence/hautes performances

- Les disques virtuels doivent être utilisés uniquement pour la capacité

En savoir plus sur le déploiement Espaces de stockage direct à l’aide de machines virtuelles et de stockage virtualisé.

Capacité maximale

| Maximums | Windows Server 2019 ou ultérieur | Windows Server 2016 |

|---|---|---|

| Capacité brute par serveur | 400 To | 100 To |

| Capacité du pool | 4 PB (4 000 TO) | 1 Po |