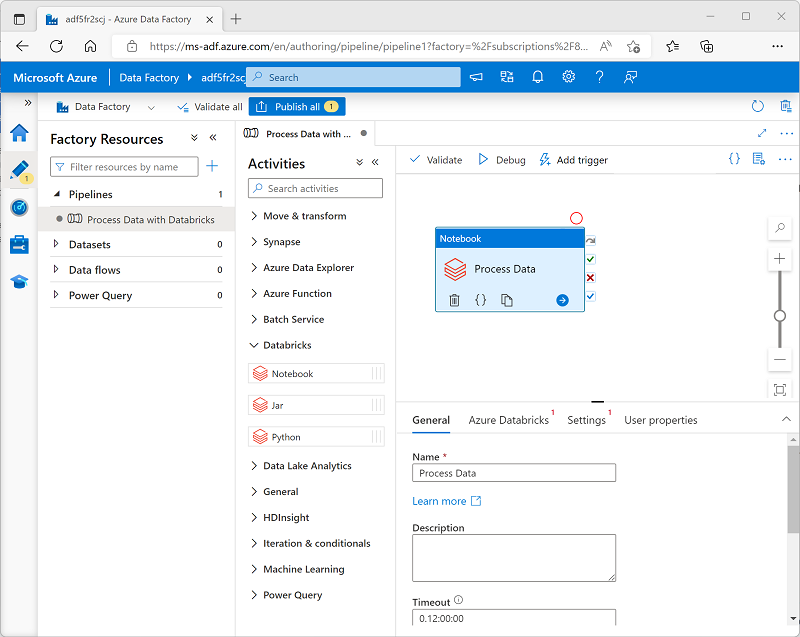

Utiliser une activité Notebook dans un pipeline

Une fois que vous avez créé un service lié dans Azure Data Factory pour votre espace de travail Azure Databricks, vous pouvez l’utiliser pour définir la connexion pour une activité Notebook dans un pipeline.

Pour utiliser une activité Notebook, créez un pipeline et, à partir de la catégorie Databricks, ajoutez une activité Notebook à l’aire du concepteur de pipelines.

Utilisez les propriétés suivantes de l’activité Notebook pour la configurer :

| Category | Paramètre | Descriptions |

|---|---|---|

| Général | Nom | Un nom unique pour l’activité. |

| Description | Une description explicite. | |

| Délai d'expiration | La durée pendant laquelle l’activité doit s’exécuter avant une annulation automatique. | |

| Nouvelle tentatives | Le nombre de fois qu’Azure Data Factory doit essayer avant de déclarer un échec. | |

| Intervalle avant nouvelle tentative | Le délai d’attente avant une nouvelle tentative. | |

| Sécuriser les entrées et les sorties | Détermine si les valeurs d’entrée et de sortie sont journalisées. | |

| Azure Databricks | Service Azure Databricks lié | Le service lié pour l’espace de travail Azure Databricks contenant le notebook. |

| Paramètres | Chemin d’accès du notebook | Le chemin d’accès au fichier du notebook dans l’espace de travail. |

| Paramètres de base | Utilisé pour passer des paramètres au notebook. | |

| Ajouter des bibliothèques | Bibliothèques de code nécessaires qui ne sont pas installées par défaut. | |

| Propriétés de l’utilisateur | Propriétés personnalisées définies par l’utilisateur. |

Exécution d’un pipeline

Quand le pipeline contenant l’activité Notebook est publié, vous pouvez l’exécuter en définissant un déclencheur. Vous pouvez ensuite superviser les exécutions du pipeline dans la section Superviser d’Azure Data Factory Studio.