Déboguer des pipelines de fabrique de données

Les exigences et les attentes des clients changent en fonction de l’intégration de données. La nécessité pour les utilisateurs de développer et de déboguer leurs workflows d’extraction, transformation et chargement (ETL) et d’extraction, chargement et transformation (ELT) de façon itérative devient donc plus impérative.

Azure Data Factory peut vous aider à créer et à développer des pipelines de débogage itératif Data Factory quand vous développez votre solution d’intégration de données. En créant un pipeline à l’aide de la zone de dessin du pipeline, vous pouvez tester vos activités et pipelines à l’aide de la fonctionnalité de débogage.

Dans Azure Data Factory, il n’est pas nécessaire de publier les modifications apportées au pipeline ou aux activités avant de procéder au débogage. Cela est utile dans un scénario où vous souhaitez tester les modifications et voir si elles fonctionnent comme prévu avant de les enregistrer et de les publier.

Parfois, vous ne souhaitez pas déboguer l’ensemble du pipeline, mais tester une partie du pipeline. Une exécution de débogage vous permet d’effectuer cette opération. Vous pouvez tester la fin du pipeline ou définir un point d’arrêt. En procédant ainsi en mode débogage, vous pouvez voir les résultats de chaque étape de manière interactive lorsque vous générez et déboguez votre pipeline.

Déboguer et publier un pipeline

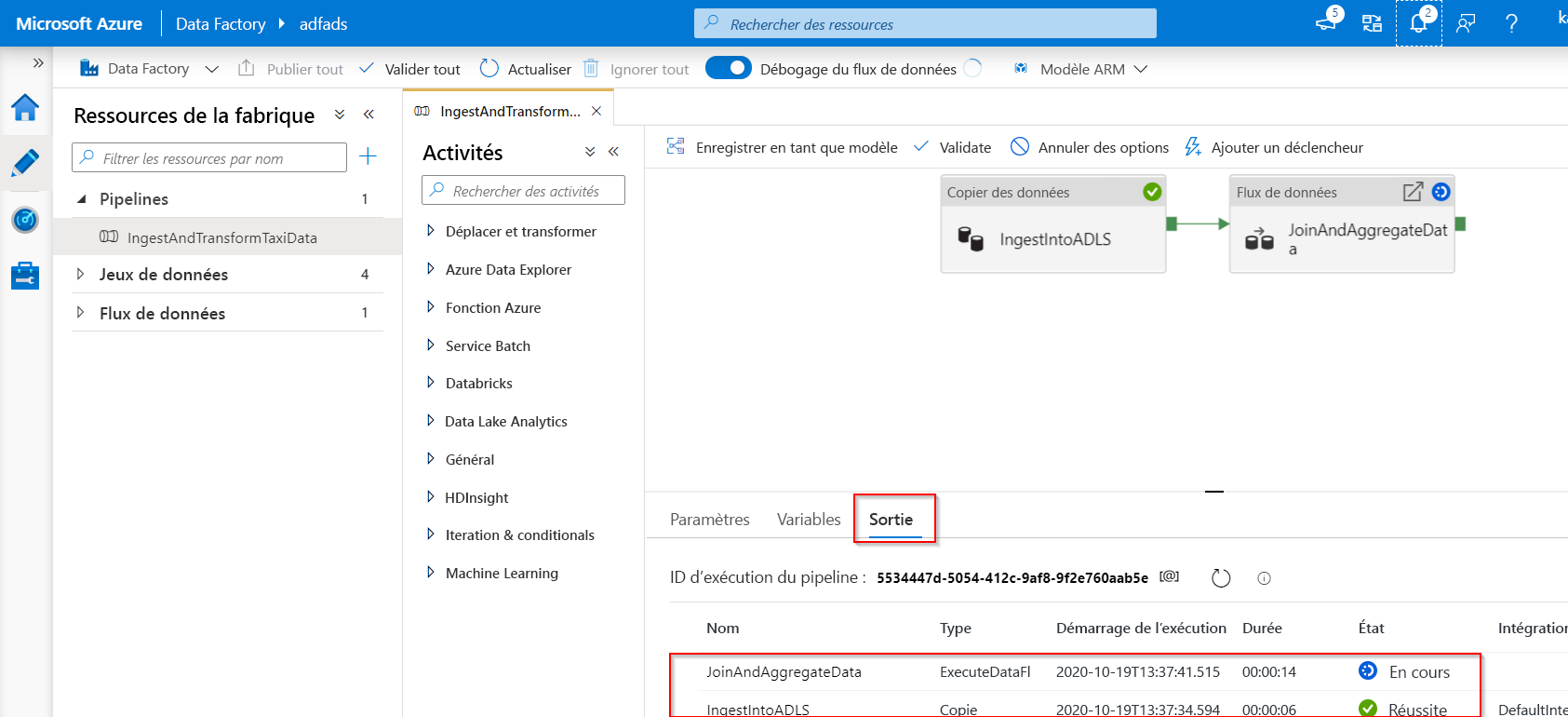

Lorsque vous créez ou modifiez un pipeline en cours d’exécution, vous pouvez voir les résultats de chaque activité dans l’onglet Sortie du canevas du pipeline.

Une fois qu’une série de tests a réussi et que vous êtes satisfait des résultats, vous pouvez ajouter d’autres activités au pipeline et poursuivre le débogage de façon itérative. Lorsque vous n’êtes pas satisfait ou que vous souhaitez arrêter le débogage du pipeline, vous pouvez annuler une série de tests pendant qu’elle est en cours. N’oubliez pas que si vous sélectionnez le curseur de débogage, le pipeline sera exécuté. Par conséquent, si le pipeline contient par exemple une activité de copie, la série de tests copiera des données de la source vers la destination.

Une bonne pratique consiste à utiliser des dossiers de test dans vos activités de copie et autres activités lors du débogage, de sorte que lorsque vous êtes satisfait des résultats et que vous avez débogué le pipeline, vous basculez vers les dossiers réels pour vos opérations normales.

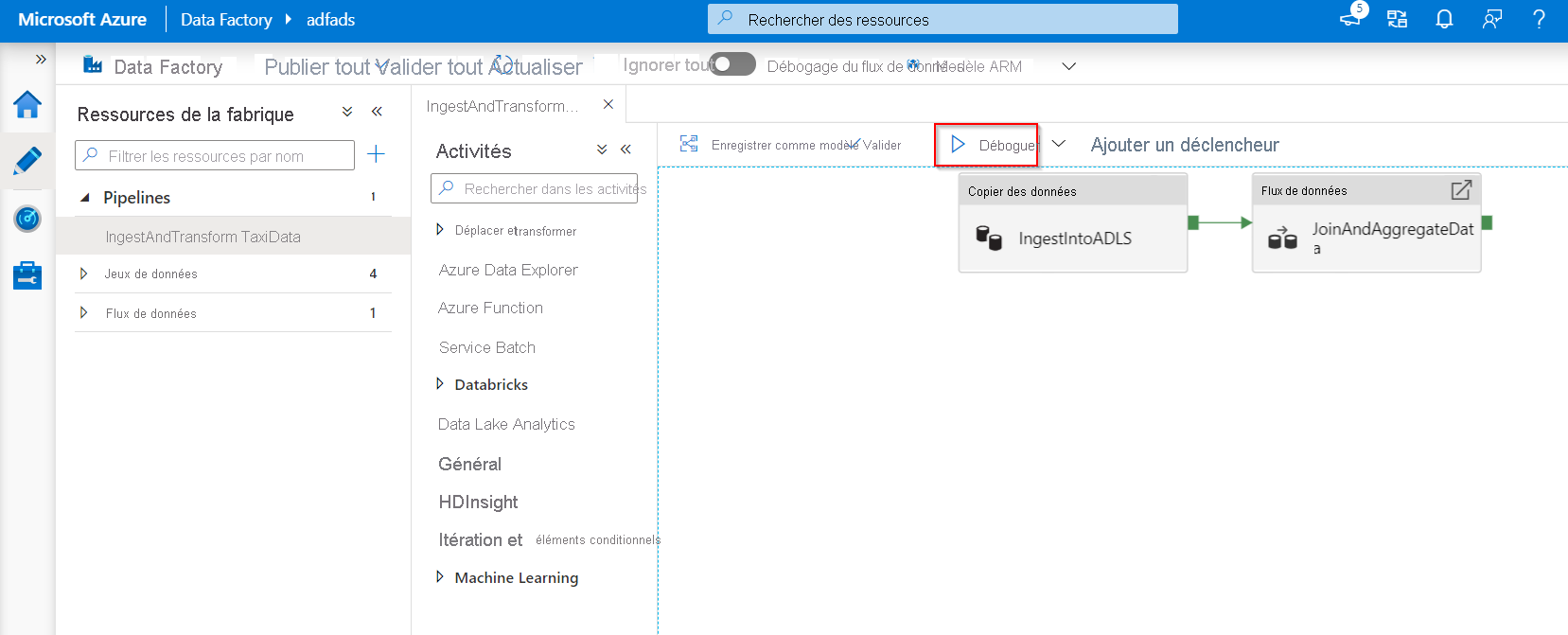

Pour déboguer le pipeline, sélectionnez Déboguer dans la barre d’outils. L’état d’exécution du pipeline apparaît dans l’onglet Sortie au bas de la fenêtre.

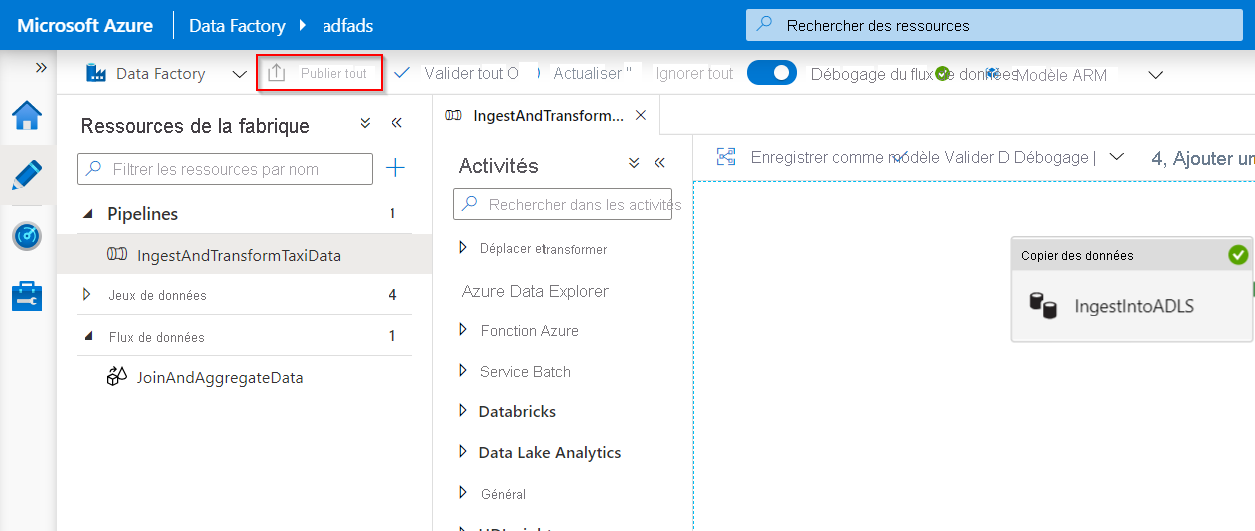

Une fois que le pipeline peut s’exécuter correctement, sélectionnez Tout publier dans la barre d’outils supérieure. Cette action publie les entités (jeux de données et pipelines) que vous avez créées dans Data Factory.

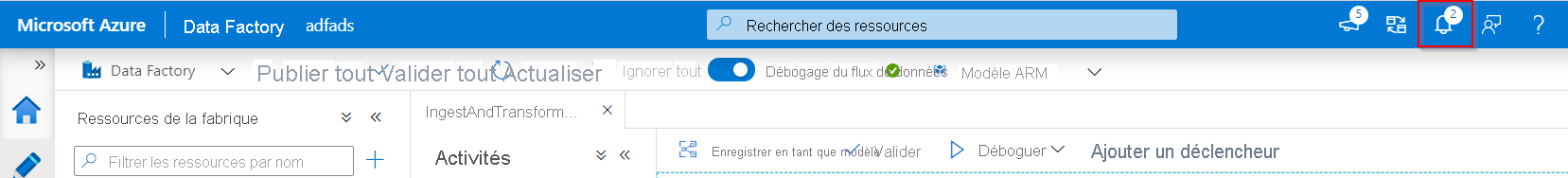

Patientez jusqu’à voir le message Publication réussie. Pour afficher les messages de notification, sélectionnez Afficher les notifications (icône en forme de cloche) en haut à droite du portail (bouton en forme de cloche).

Mapper le débogage de flux de données

Pendant la génération des flux de données de mappage, vous pouvez surveiller de manière interactive comment s’exécutent les formes et les transformations de données et ainsi les déboguer. Pour utiliser cette fonctionnalité, vous devez d’abord activer la fonctionnalité « Débogage du flux de données ».

La session de débogage peut être utilisée à la fois dans les sessions de conception de flux de données et lors de l’exécution du débogage de pipeline des flux de données. Une fois que le mode débogage est activé, vous créez le flux de données avec un cluster Spark actif. Le cluster Spark se ferme une fois que le débogage est désactivé. Vous avez le choix dans le calcul que vous allez utiliser. Lorsque vous utilisez un cluster de débogage existant, le temps de démarrage est réduit. Toutefois, pour les charges de travail complexes ou parallèles, vous souhaiterez peut-être créer votre propre cluster juste-à-temps.

Les bonnes pratiques pour déboguer les flux de données consistent à garder le mode de débogage activé, et à vérifier et valider la logique métier incluse dans le flux de données. L’affichage visuel des transformations et des formes de données vous permet de voir les modifications.

Si vous souhaitez tester le flux de données dans un pipeline que vous avez créé, il est préférable d’utiliser le bouton Débogage dans le panneau du pipeline. Bien que l’aperçu des données n’écrive pas de données, une exécution de débogage dans votre flux de données écrira les données, tout comme le débogage d’un pipeline, vers la destination de votre récepteur.

Paramètres de débogage

Comme mentionné précédemment, chaque session de débogage démarrée à partir de l’interface utilisateur Azure Data Factory est considérée comme une nouvelle session avec son propre cluster Spark. Pour superviser les sessions, vous pouvez utiliser la vue de monitoring de la session de débogage afin de gérer vos sessions de débogage pour la fabrique de données ayant été configurée.

Pour voir si un cluster Spark est prêt pour le débogage, vous pouvez vérifier l’indication de l’état du cluster en haut de l’aire de conception. S’il est vert, cela signifie que le cluster est prêt. Si le cluster n’était pas encore en cours d’exécution lorsque vous avez basculé en mode de débogage, la durée d’attente peut atteindre environ cinq à sept minutes car les clusters doivent s’exécuter.

Une fois que vous avez terminé le débogage, il est recommandé de désactiver le mode débogage de sorte que le cluster Spark se termine.

Lorsque vous effectuez un débogage, vous pouvez modifier l’aperçu des données dans un flux de données en sélectionnant Paramètre de débogage. Les exemples de modification de l’aperçu des données comprennent les limites de lignes ou les sources de fichier, si vous utilisez des transformations de source. Lorsque vous sélectionnez le service lié intermédiaire, vous pouvez utiliser Azure Synapse Analytics comme source.

Si vous avez des paramètres dans votre flux de données ou dans l’un de ses jeux de données référencés, vous pouvez spécifier les valeurs à utiliser pendant le débogage en sélectionnant l’onglet Paramètres. Lors du débogage, les récepteurs ne sont pas requis et sont ignorés dans le flux de données. Si vous souhaitez tester et écrire les données transformées sur votre récepteur, vous pouvez exécuter le flux de données à partir d’un pipeline et utiliser l’exécution du débogage à partir du pipeline.

Comme décrit précédemment, dans Azure Data Factory il est possible de déboguer uniquement jusqu’à un certain point ou une certaine activité. Pour ce faire, vous pouvez utiliser un point d’arrêt sur l’activité jusqu’à l’endroit où vous souhaitez effectuer le test, puis sélectionner Déboguer. Une option Déboguer jusqu’à apparaît sous la forme d’un cercle rouge vide dans le coin supérieur droit de l’élément. Après que vous avez sélectionné l’option Déboguer jusqu’à, elle se transforme en un cercle rouge plein pour indiquer que le point d’arrêt est activé. Azure Data Factory s’assurera ensuite que le test s’exécute uniquement jusqu’à l’activité de ce point d’arrêt dans le pipeline. Cette fonctionnalité est utile lorsque vous souhaitez tester uniquement un sous-ensemble des activités d’un pipeline.

Dans la plupart des scénarios, les fonctionnalités de débogage d’Azure Data Factory sont suffisantes. Toutefois, il est parfois nécessaire de tester les modifications dans un pipeline dans un environnement de bac à sable cloné. Un cas d’usage peut se présenter lorsque vous avez des pipelines ETL paramétrisés et que vous souhaitez tester la manière dont ils se comportent lorsqu’ils déclenchent une réception de fichier par rapport au basculement d’une fenêtre de temps. Dans ce cas, le clonage d’un environnement de bac à sable peut être plus approprié.

S’il y a une bonne chose à savoir sur Azure Data Factory, c’est qu’étant donné que la facturation ne se fait que par le nombre d’exécutions, une deuxième Data Factory n’entraîne pas de frais supplémentaires.

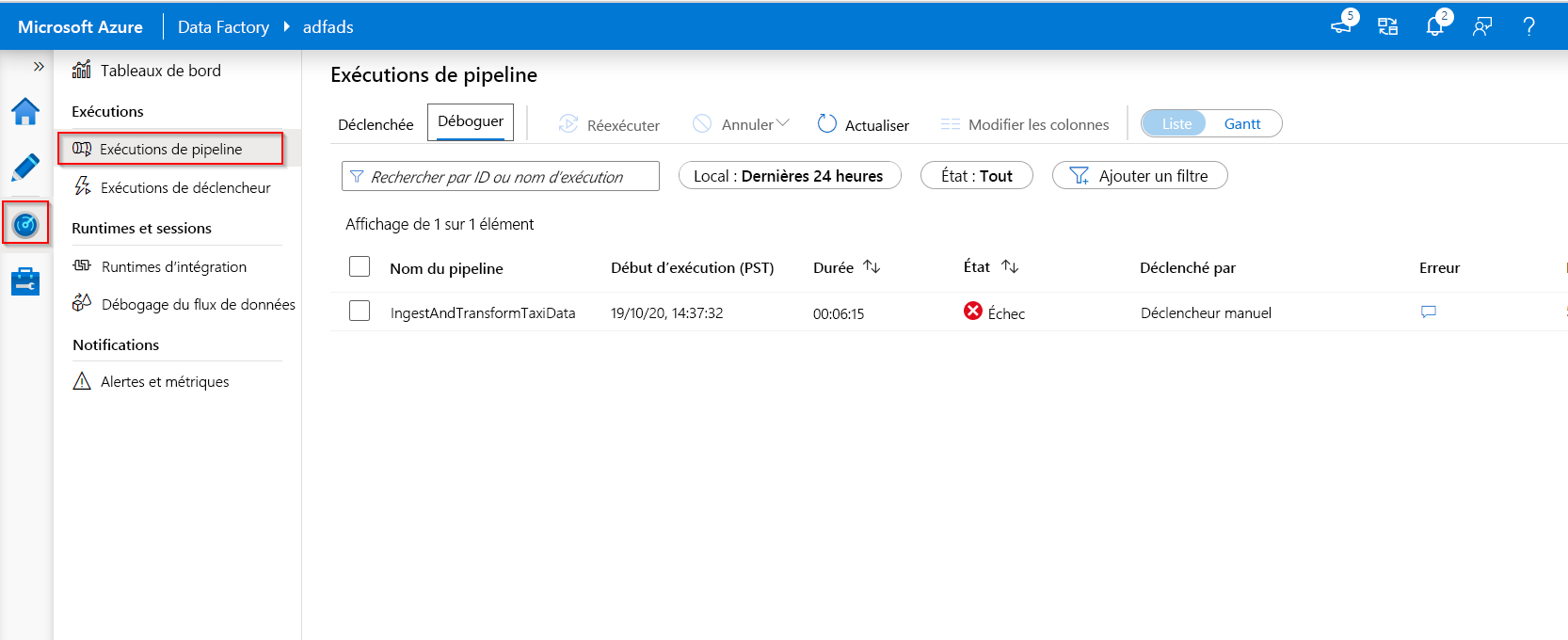

Superviser les exécutions de débogage

Pour superviser les exécutions de débogage, vous pouvez vérifier l’onglet de sortie, mais uniquement pour l’exécution la plus récente qui s’est produite durant la session de navigation, car vous n’aurez pas accès à l’historique. Si vous souhaitez obtenir un aperçu de l’historique des exécutions de débogage, ou voir l’ensemble des exécutions de débogage actives, vous pouvez accéder à l’onglet Superviser.

Gardez à l’esprit que le service Azure Data Factory ne garde qu’un historique des exécutions de débogage de 15 jours. En ce qui concerne le monitoring de vos sessions de débogage de flux de données, vous pouvez également accéder à l’onglet Superviser.