Surveiller les pipelines Azure Data Factory

Une fois que vous avez créé et publié un pipeline dans Azure Data Factory, vous pouvez l’associer à un déclencheur ou lancer manuellement une exécution à la demande. Vous pouvez surveiller l’ensemble de vos exécutions de pipeline en mode natif dans l’expérience utilisateur d’Azure Data Factory. Pour ouvrir l’expérience de surveillance, sélectionnez la vignette Surveiller et gérer dans le panneau de fabrique de données du Portail Azure. Si vous êtes déjà dans l’expérience utilisateur Azure Data Factory, cliquez sur l’icône Surveiller dans la barre latérale gauche.

Surveiller des exécutions de pipelines

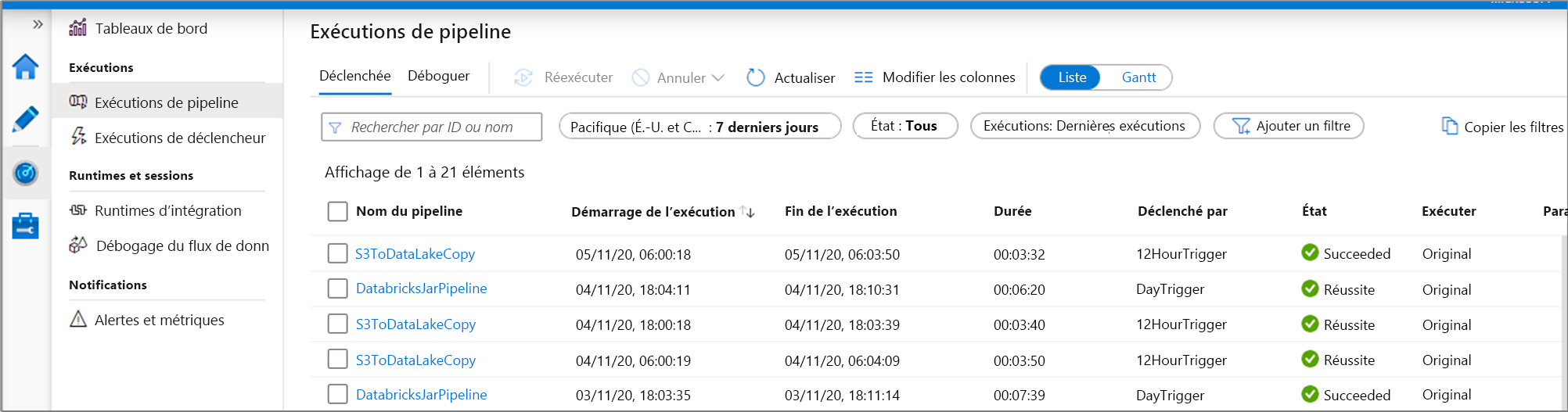

L’affichage de la surveillance par défaut est la liste des exécutions de pipeline déclenchées dans la période sélectionnée. Vous pouvez modifier l’intervalle de temps et filtrer par état, nom de pipeline ou annotation. Pointez sur l’exécution du pipeline spécifique pour recevoir des actions spécifiques de l’exécution, telles que réexécuter, et le rapport consommation.

La grille d’exécution du pipeline contient les colonnes suivantes :

| Nom de la colonne | Description |

|---|---|

| Nom du pipeline | Nom du pipeline |

| Démarrage de l’exécution | Date et heure de début de l’exécution de pipeline (MM/JJ/AAAA, HH:MM:SS AM/PM) |

| Fin de l’exécution | Date et heure de fin de l’exécution de pipeline (MM/JJ/AAAA, HH:MM:SS AM/PM) |

| Duration | Durée d’exécution (HH:MM:SS) |

| Déclenché par | Nom du déclencheur qui a démarré le pipeline |

| Statut | Échec, Réussite, En cours, Annulée ou En file d'attente |

| Annotations | Balises filtrables associées à un pipeline |

| Paramètres | Paramètres d’exécution de pipeline (paires nom/valeur) |

| Error | En cas d’échec du pipeline, l’erreur d’exécution |

| ID d’exécution | ID de l’exécution de pipeline |

Vous devez cliquer manuellement sur le bouton Actualiser pour actualiser la liste des exécutions de pipelines et d’activités. L’actualisation automatique n’est pas prise en charge actuellement.

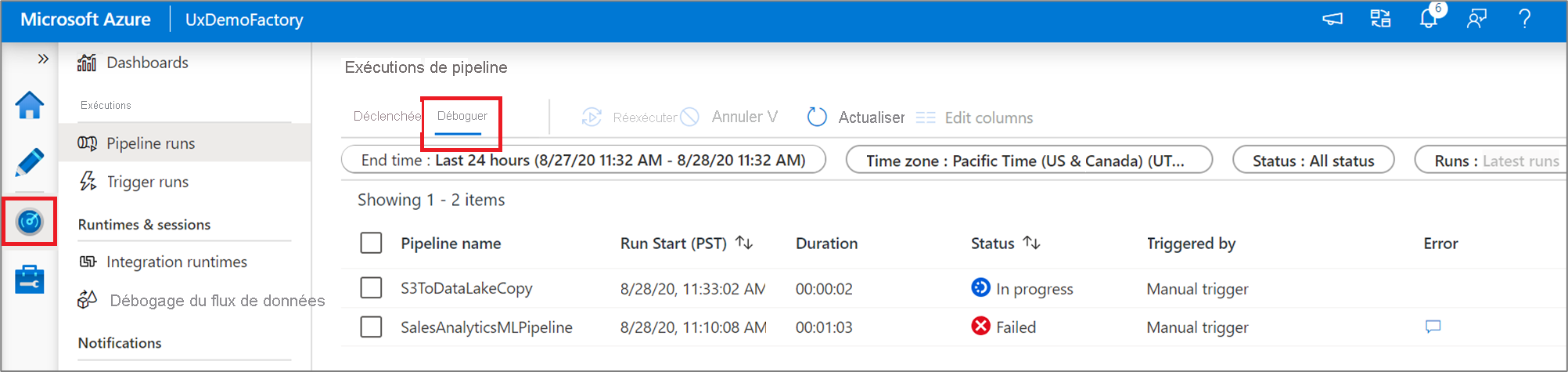

Pour afficher les résultats d’un débogage, sélectionnez l’onglet Débogage.

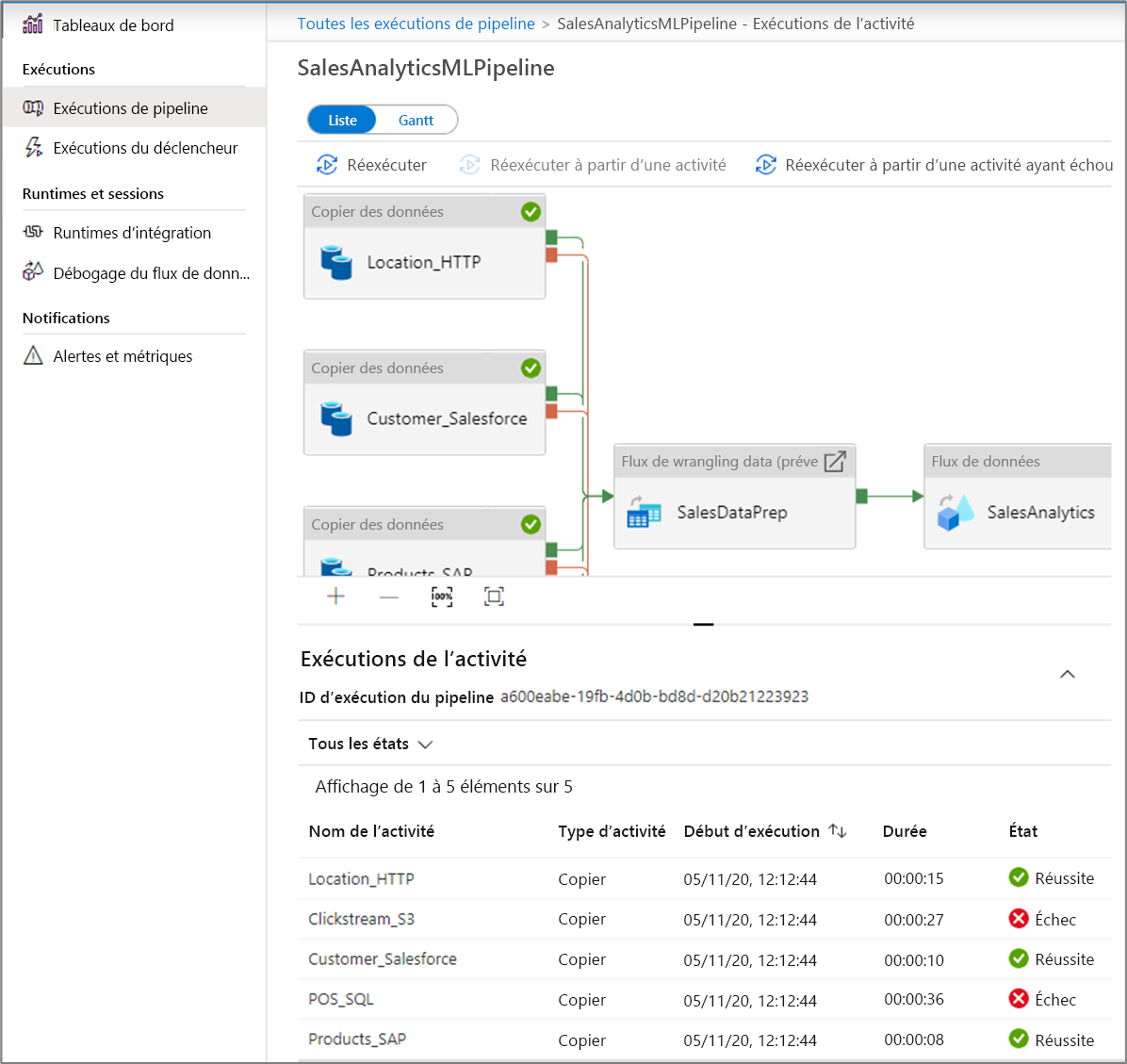

Surveiller des exécutions d’activités

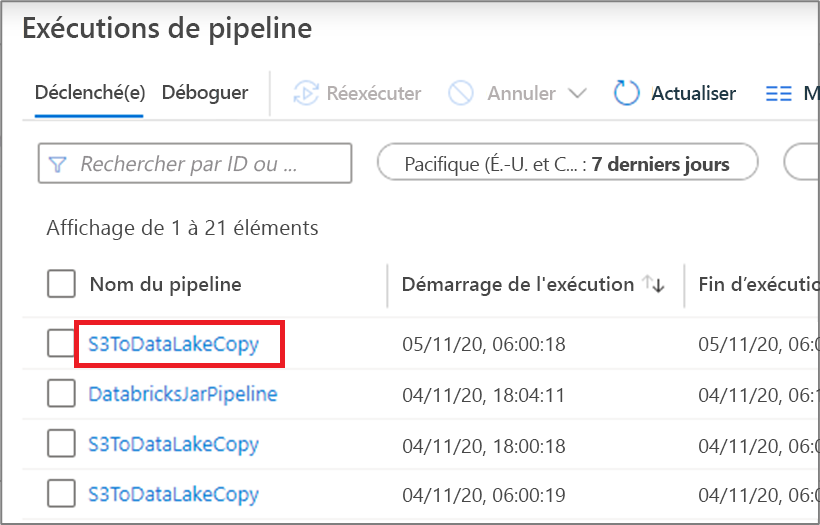

Pour obtenir une vue détaillée des activités individuelles d’un pipeline spécifique, cliquez sur le nom de celui-ci.

La liste montre les exécutions d’activités correspondant à chaque exécution de pipeline. Pointez sur l’activité spécifique pour obtenir des informations spécifiques de son exécution, telles que l’entrée JSON, la sortie JSON et des expériences de surveillance détaillées spécifiques de l’activité. Les activités telles que le workflow de données, la copie et Azure Databricks ont un affichage dédié qui peut être affiché en cliquant sur l’icône en forme de lunettes.

| Nom de la colonne | Description |

|---|---|

| Nom de l’activité | Nom de l’activité dans le pipeline |

| Type d’activité | Type de l’activité, par exemple Copy, ExecuteDataFlow ou AzureMLExecutePipeline |

| Actions | Icônes qui vous permettent de voir des informations d’entrée JSON, des informations de sortie JSON ou des expériences de surveillance détaillées sur les activités |

| Démarrage de l’exécution | Date et heure de début de l’exécution de l’activité (MM/JJ/AAAA, HH:MM:SS AM/PM) |

| Duration | Durée d’exécution (HH:MM:SS) |

| Statut | Échec, Réussite, En cours ou Annulée |

| Runtime d’intégration | Runtime d’intégration sur lequel l’activité a été exécutée |

| Propriétés de l’utilisateur | Propriétés définies par l’utilisateur de l’activité |

| Error | En cas d’échec de l’activité, l’erreur d’exécution |

| ID d’exécution | ID de l’exécution d’activité |

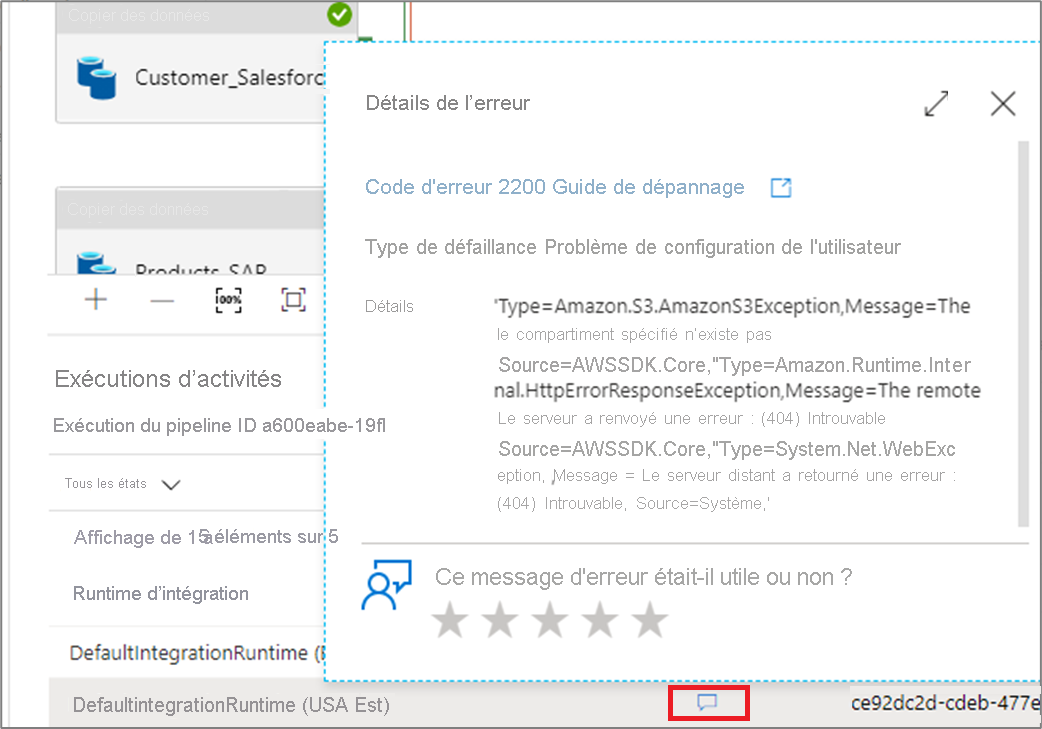

En cas d’échec d’une activité, vous pouvez voir le message d’erreur détaillé en cliquant sur l’icône dans la colonne d’erreur.

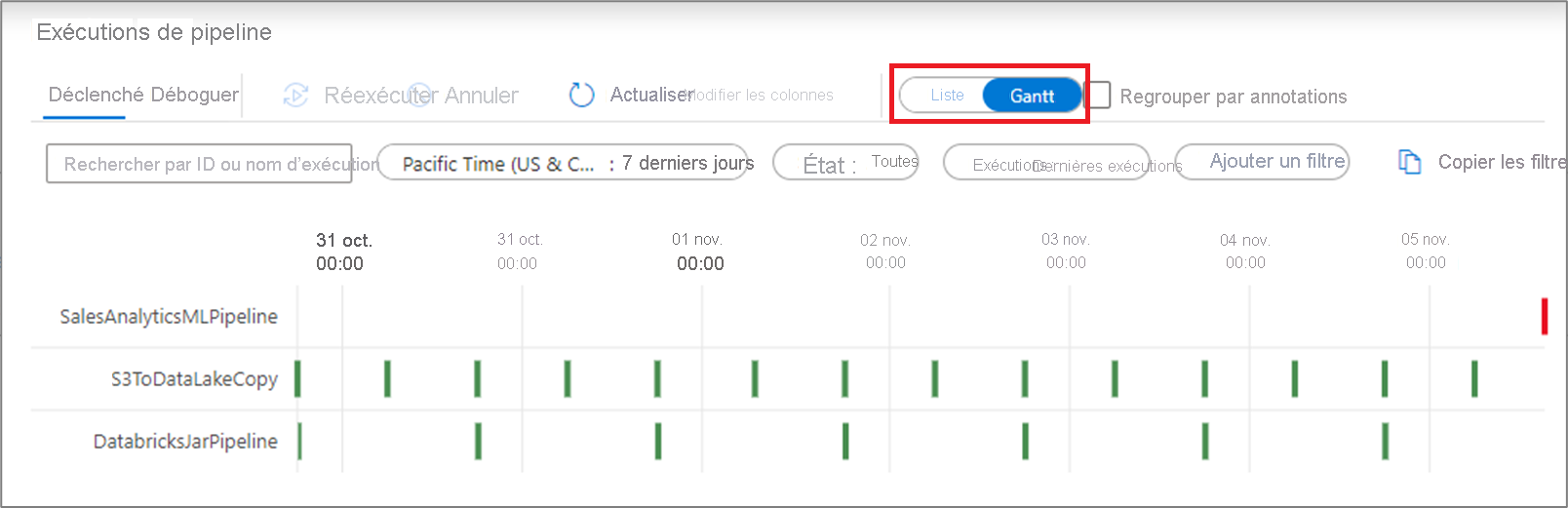

Affichage de Gantt

Un diagramme de Gantt est un affichage qui vous permet de voir l’historique des exécutions sur un intervalle de temps. En basculant vers un affichage de Gantt, vous pouvez voir toutes les exécutions de pipeline regroupées par nom, affichées sous forme de barres proportionnelles au temps d’exécution. Vous pouvez également regrouper par annotations/balises que vous avez créées sur votre pipeline. L’affichage de Gantt est également disponible au niveau de l’exécution de l’activité.

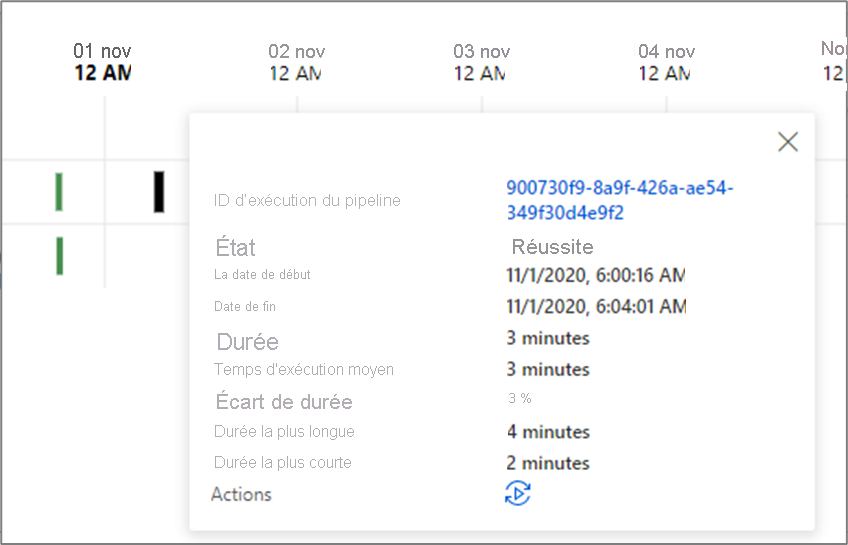

La longueur de la barre indique la durée du pipeline. Vous pouvez également sélectionner la barre pour voir plus de détails.

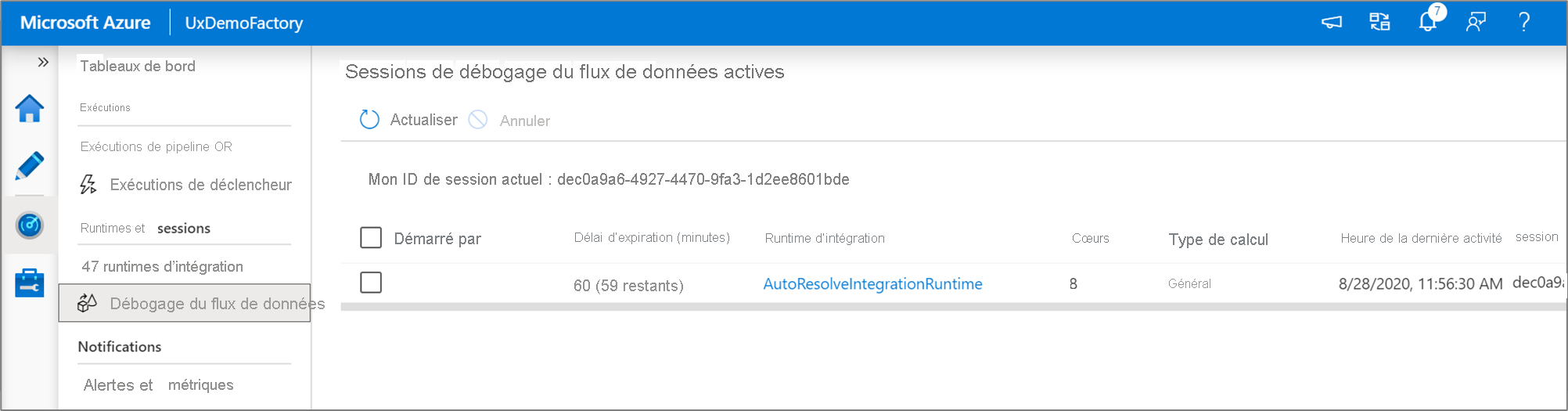

Surveiller les sessions de débogage du flux de données

Les flux de données de mappage vous permettent de créer une logique de transformation des données sans code qui s’exécute à grande échelle. Lors de la génération de votre logique, vous pouvez activer une session de débogage pour travailler de manière interactive avec vos données à l’aide d’un cluster Spark en direct.

Vous pouvez superviser les sessions de débogage du flux de données qui sont actives dans une fabrique dans l’expérience Superviser.

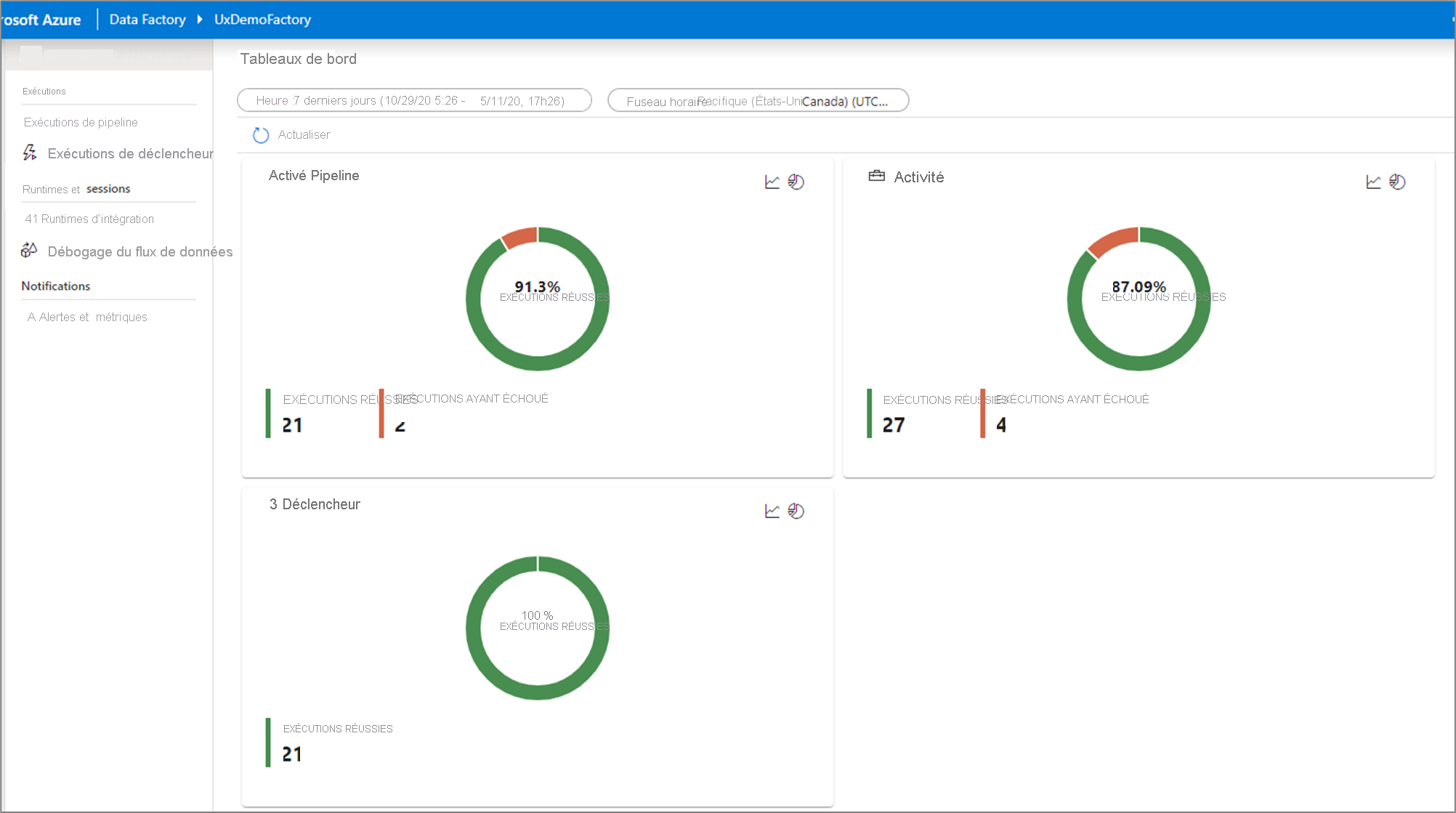

Tableaux de bord de surveillance

Pour obtenir un bon affichage visuel de vos exécutions de pipeline, d’activité et de déclencheur, accédez au volet Tableaux de bord. Ici, vous pouvez voir le nombre de réussites et d’échecs sur une période spécifiée.

Surveiller à l’aide d’Azure Monitor

Azure Monitor fournit des métriques et des journaux d’activité de niveau de base d’infrastructure pour la plupart des services Azure. Les journaux de diagnostic Azure sont générés par une ressource et fournissent des informations complètes et fréquentes sur le fonctionnement de cette ressource. Azure Data Factory (ADF) peut écrire les journaux de diagnostic dans Azure Monitor.

Data Factory ne stocke les données d’exécution du pipeline que pendant 45 jours. Utilisez Azure Monitor si vous souhaitez conserver ces données pendant une période plus longue. Monitor vous permet d’acheminer les journaux de diagnostic à des fins d’analyse pour multiplier les cibles.

- Compte de stockage : Enregistrez vos journaux de diagnostic dans un compte de stockage à des fins d’audit ou d’inspection manuelle. Vous pouvez utiliser les paramètres de diagnostic pour spécifier la durée de rétention en jours.

- Event Hub : Diffusez en continu les journaux vers Azure Event Hubs. Les journaux deviennent des entrées pour un service partenaire ou une solution d’analyse personnalisée telle que Power BI.

- Log Analytics : Analysez les journaux avec Log Analytics. L’intégration de Data Factory à Azure Monitor est utile dans les scénarios suivants :

- Vous souhaitez écrire des requêtes complexes sur un ensemble varié de mesures publiées par la Data Factory sur Monitor. Vous pouvez créer des alertes personnalisées sur ces requêtes via Monitor.

- Vous souhaitez surveiller l’activité de toutes les fabriques de données. Vous pouvez acheminer les données de plusieurs fabriques de données vers un seul espace de travail Monitor.

Vous pouvez également utiliser un compte de stockage ou un espace de noms Event Hub qui ne se trouve pas dans le même abonnement que la ressource émettrice des journaux. L'utilisateur qui configure le paramètre doit disposer d'un accès Azure RBAC (Contrôle d'accès en fonction du rôle Azure) approprié pour les deux abonnements.

Configurer les paramètres de diagnostic et l’espace de travail

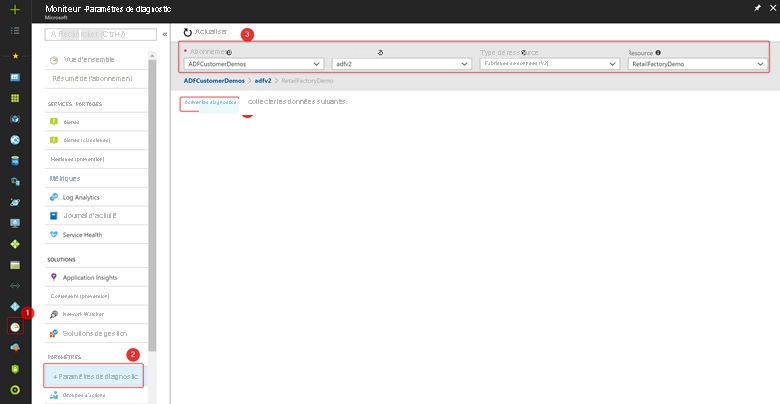

Créez ou ajoutez des paramètres de diagnostic pour votre fabrique de données.

Dans le portail, accédez à Monitor. Sélectionnez Paramètres>Paramètres de diagnostic.

Sélectionnez la fabrique de données pour laquelle vous souhaitez définir un paramètre de diagnostic.

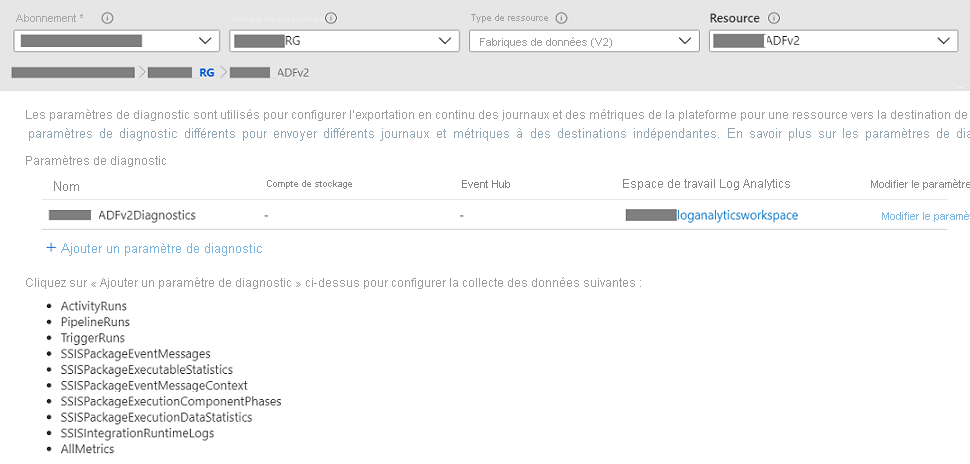

S’il n’existe aucun paramètre sur la fabrique de données sélectionnée, vous êtes invité à en créer un. Sélectionnez Activer les diagnostics.

S’il existe des paramètres sur la fabrique de données, vous voyez une liste de paramètres déjà configurés sur cette fabrique de données. Sélectionnez Ajouter le paramètre de diagnostic.

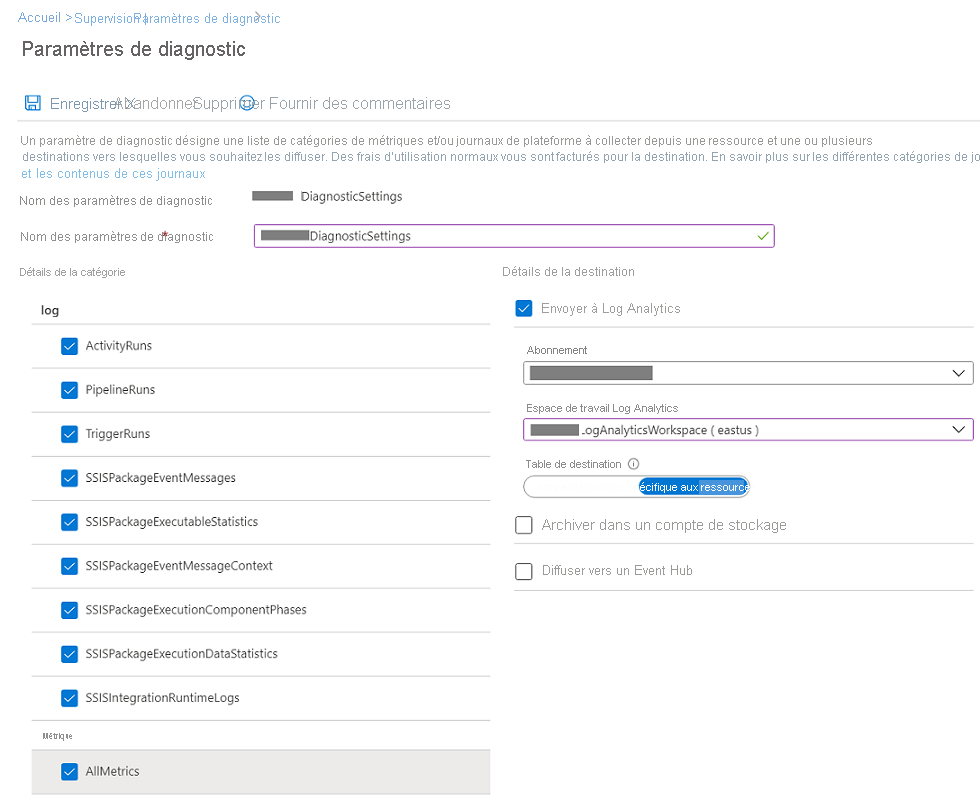

Nommez votre paramètre, sélectionnez Envoyer à log Analytics, puis sélectionnez un espace de travail dans Espace de travail Log Analytics.

En mode Diagnostics Azure, les journaux de diagnostic circulent dans la table AzureDiagnostics.

En mode Spécifique à la ressource, les journaux de diagnostic d’Azure Data Factory circulent dans les tables suivantes :

- ADFActivityRun

- ADFPipelineRun

- ADFTriggerRun

- ADFSSISIntegrationRuntimeLogs

- ADFSSISPackageEventMessageContext

- ADFSSISPackageEventMessages

- ADFSSISPackageExecutableStatistics

- ADFSSISPackageExecutionComponentPhases

- ADFSSISPackageExecutionDataStatistics

Vous pouvez sélectionner différents journaux pertinents pour vos charges de travail à envoyer vers les tableaux Log Analytics. Par exemple, si vous n’utilisez pas du tout SQL Server Integration Services (SSIS), vous n’avez pas besoin de sélectionner des journaux SSIS. Si vous souhaitez consigner les opérations de démarrage/arrêt et de maintenance du SSIS Integration Runtime (IR), vous pouvez sélectionner les journaux SSIS IR. Si vous appelez des exécutions de package SSIS via T-SQL sur SQL Server Management Studio (SSMS), SQL Server Agent ou d’autres outils désignés, vous pouvez sélectionner des journaux de packages SSIS. Si vous appelez des exécutions de package SSIS via des activités Exécuter le package SSIS dans des pipelines ADF, vous pouvez sélectionner tous les journaux.

Si vous sélectionnez AllMetrics, plusieurs métriques Azure Data Factory sont mises à votre disposition pour surveiller ou déclencher des alertes, y compris les métriques pour l’activité Azure Data Factory, le pipeline et les exécutions de déclencheur, ainsi que pour les opérations de runtime d’intégration de SSIS et les exécutions de packages SSIS.

> [!NOTE]

> Because an Azure log table can't have more than 500 columns, Select _Resource-Specific mode_.

- Sélectionnez Enregistrer.

Après quelques instants, le nouveau paramètre apparaît dans la liste des paramètres pour cette fabrique de données. Les journaux de diagnostic sont diffusés en continu vers cet espace de travail dès que de nouvelles données d’événement sont générées. Jusqu’à 15 minutes peuvent s’écouler entre l’émission d’un événement et son affichage dans Log Analytics.