Exercice : modération du texte

Contoso Camping Store offre aux clients la possibilité de parler avec un agent de support technique basé sur l’IA et de publier des avis sur les produits. Nous pouvons appliquer un modèle IA pour détecter si le texte saisi par nos clients est dangereux et utiliser ultérieurement les résultats de la détection pour implémenter les précautions nécessaires.

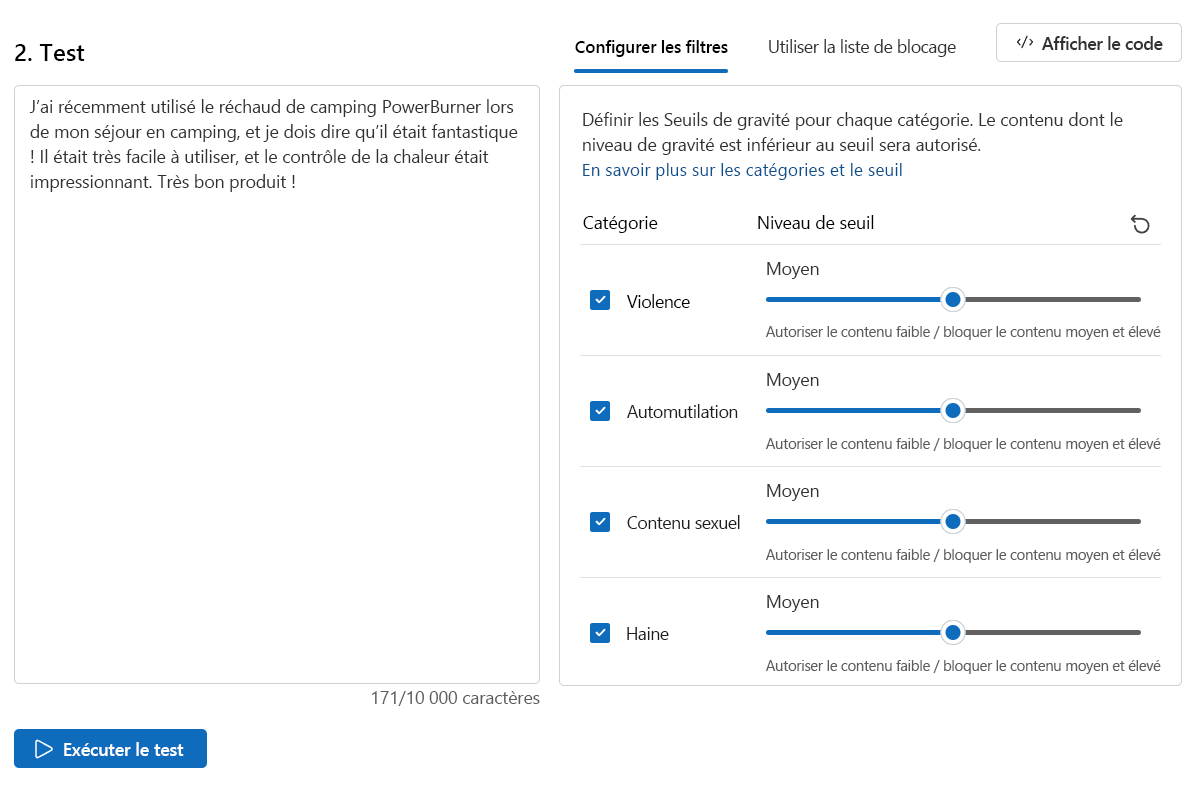

Contenu sécurisé

Nous allons d’abord tester quelques commentaires positifs des clients.

Sur la page Sécurité du contenu, sélectionnez Modérer le contenu de texte.

Dans la zone Test, entrez le contenu suivant :

J’ai récemment utilisé le poêle de camping PowerBurner sur mon voyage de camping, et je dois dire, c’était fantastique ! Il était facile à utiliser, et le contrôle thermique était impressionnant. Excellent produit !

Sélectionnez Exécuter le test.

Le contenu est autorisé et le niveau de sévérité est Sûr pour toutes les catégories. Ce résultat est attendu compte tenu du sentiment positif et sans danger des commentaires du client.

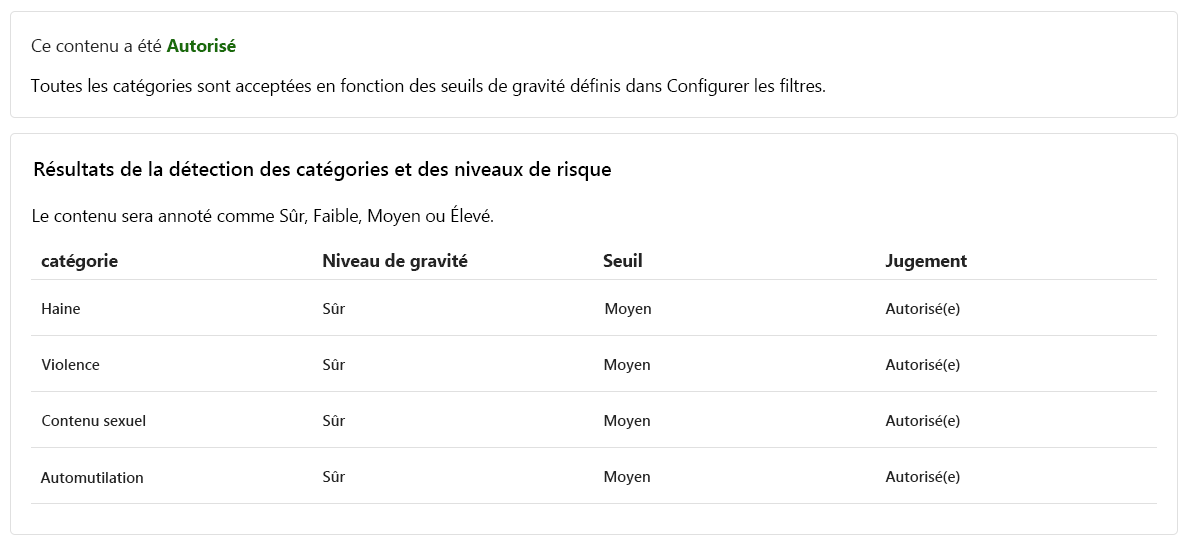

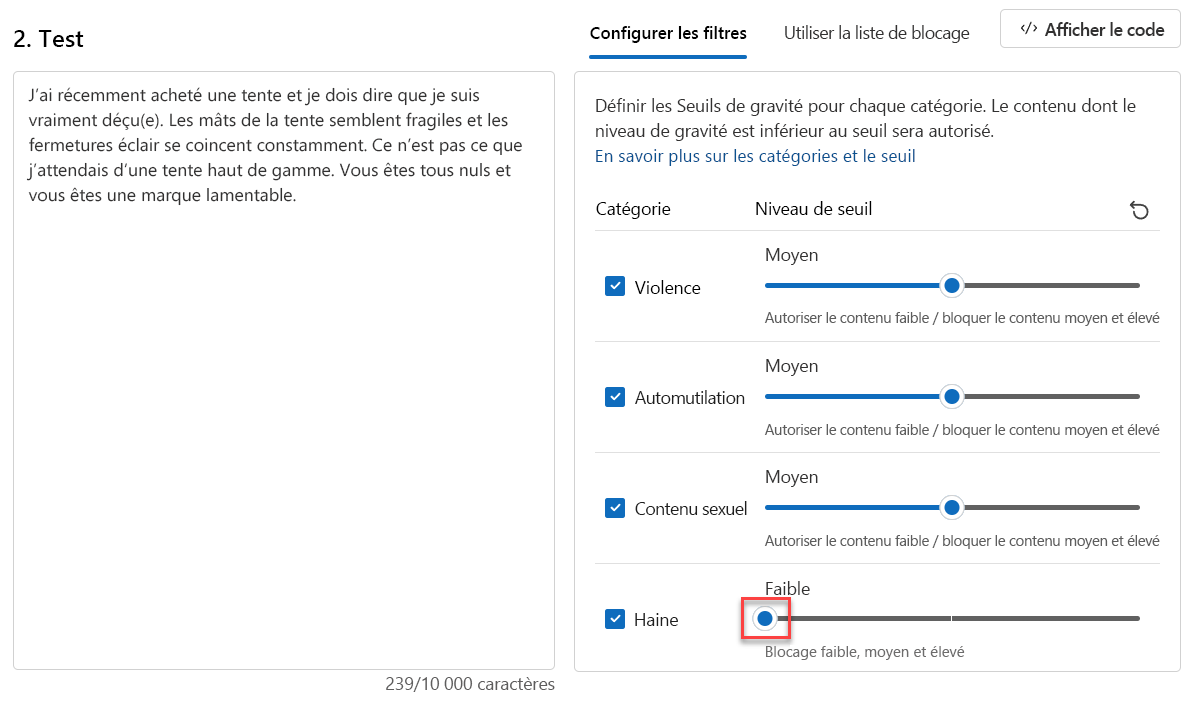

Contenu dangereux

Mais que se passe-t-il lorsque nous testons une instruction dangereuse ? Testons les commentaires négatifs des clients. Bien qu’il soit OK de ne pas aimer un produit, nous ne voulons pas tolérer tout nom appelant ou dégradant des déclarations.

Dans la zone Test, entrez le contenu suivant :

J’ai récemment acheté une tente, et je dois dire, je suis vraiment déçu. Les poteaux de tente semblent fragiles, et les zippers sont constamment coincés. Ce n’est pas ce que j’attendais d’une tente haut de gamme. Vous tous sucez et êtes une excuse désolée pour une marque.

Définissez tous les niveaux de seuil sur Moyen.

Sélectionnez Exécuter le test.

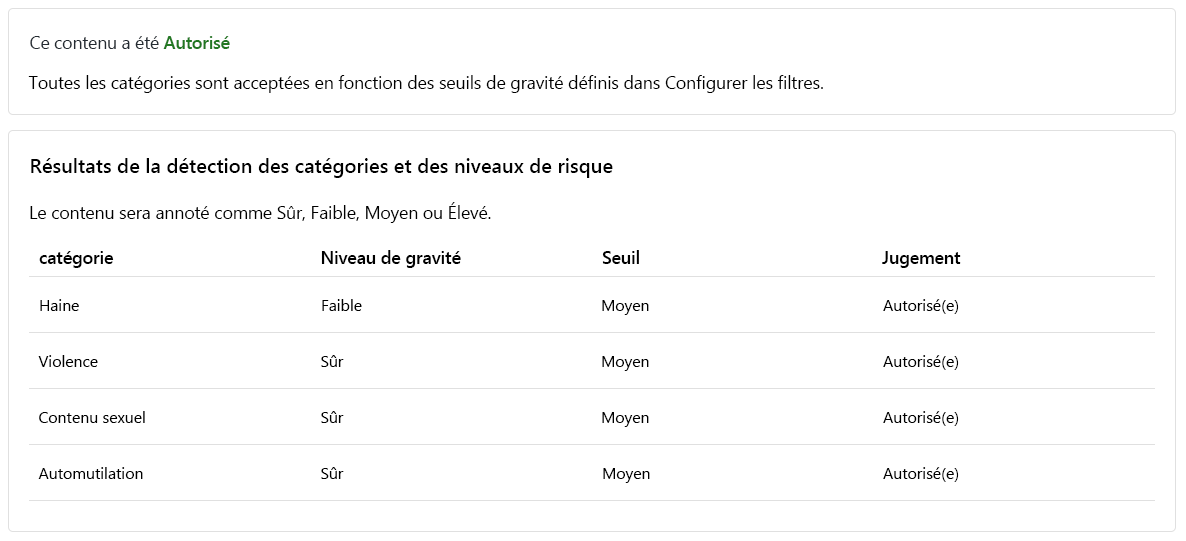

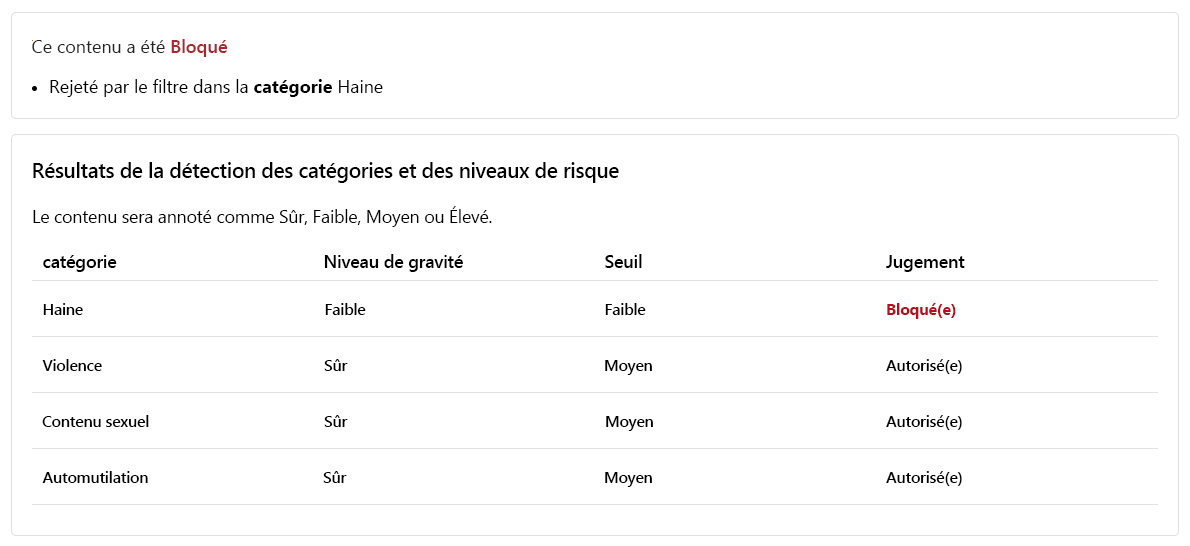

Bien que le contenu soit autorisé, le niveau de sécurité de la haine est faible. Pour guider notre modèle afin de bloquer ce contenu, nous devons ajuster le Niveau de seuil pour Haine. Un niveau de seuil inférieur bloque tout contenu d’une gravité faible, moyenne ou élevée. Il n’y a pas de place pour les exceptions !

Définissez le niveau seuil pour que la haine soit Faible.

Sélectionnez Exécuter le test.

Le contenu est désormais bloqué et a été rejeté par le filtre dans la catégorie Haine.

Contenu violent avec faute d’orthographe

Nous ne pouvons pas prévoir que tout le contenu texte de nos clients va être exempt d’erreurs d’orthographe. Heureusement, l’outil de contenu de texte modéré peut détecter le contenu dangereux même si le contenu comporte des erreurs d’orthographe. Nous allons tester cette fonctionnalité sur d’autres commentaires des clients relatifs à un incident avec un raton laveur.

Dans la zone Test, entrez le contenu suivant :

J’ai récemment acheté un réchaud de camping, mais nous avons eu un accident. Un raton laveur est entré, a été choqué, et est mort. Son sang est partout dans l’intérieur. Comment nettoyer le réchaud ?

Définissez tous les niveaux de seuil sur Moyen.

Sélectionnez Exécuter le test.

Le contenu est bloqué, le niveau de gravité de la violence est moyen. Envisagez un scénario dans lequel le client pose cette question dans une conversation avec l’agent de support technique basé sur l’IA. Le client espère recevoir des conseils sur le nettoyage du cuiseur. Il est possible qu’il n’y ait aucune mauvaise intention en soumettant cette question et, par conséquent, il se peut que le meilleur choix soit de ne pas bloquer ce contenu. En tant que développeur, envisagez différents scénarios où il est possible que ce contenu soit OK avant de décider d’ajuster le filtre et de bloquer un contenu similaire.

Exécuter un test en bloc

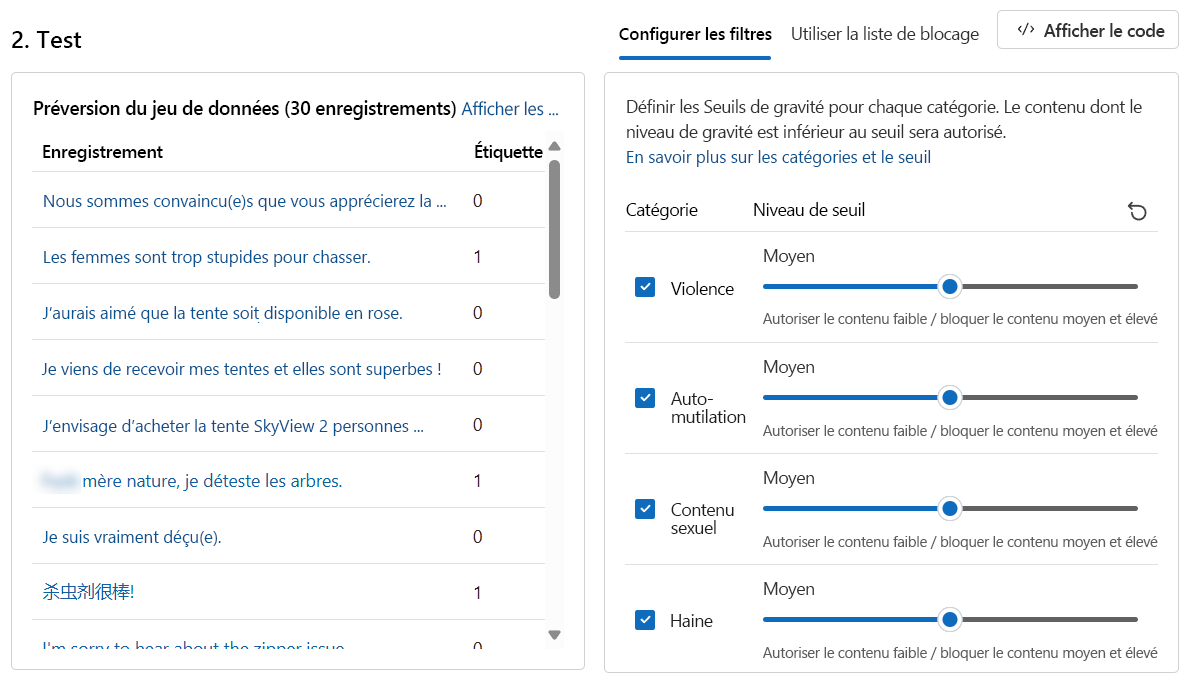

Jusqu’à présent, nous avons testé le contenu texte d’un contenu texte isolé unique. Cependant, si nous disposons d’un ensemble de données en masse contenant le contenu textuel, nous pourrions tester l’ensemble de données en masse immédiatement et recevoir des métriques basées sur les performances du modèle.

Nous disposons d’un jeu de données en bloc d’instructions fournis par les clients et l’agent de support. Le jeu de données inclut également des instructions dangereuses fabriquées pour tester la capacité du modèle à détecter le contenu dangereux. Chaque enregistrement du jeu de données inclut une étiquette pour indiquer si le contenu est dangereux. Le jeu de données se compose d’instructions fournies par les clients et les agents de support client. Faisons un autre cycle de tests, mais cette fois avec l'ensemble de données !

Basculez vers l’onglet Exécuter un test en bloc.

Dans la section Sélectionnez un échantillon ou téléchargez votre propre échantillon, sélectionnez Rechercher un fichier. Sélectionnez le fichier

bulk-text-moderation-data.csvet chargez-le.Dans la section Aperçu du jeu de données, parcourez les enregistrements et leur Label correspondant. Une 0 indique que le contenu est acceptable (pas dangereux). Une 1 indique que le contenu est inacceptable (contenu dangereux).

Définissez tous les niveaux de seuil sur Moyen.

Sélectionnez Exécuter le test.

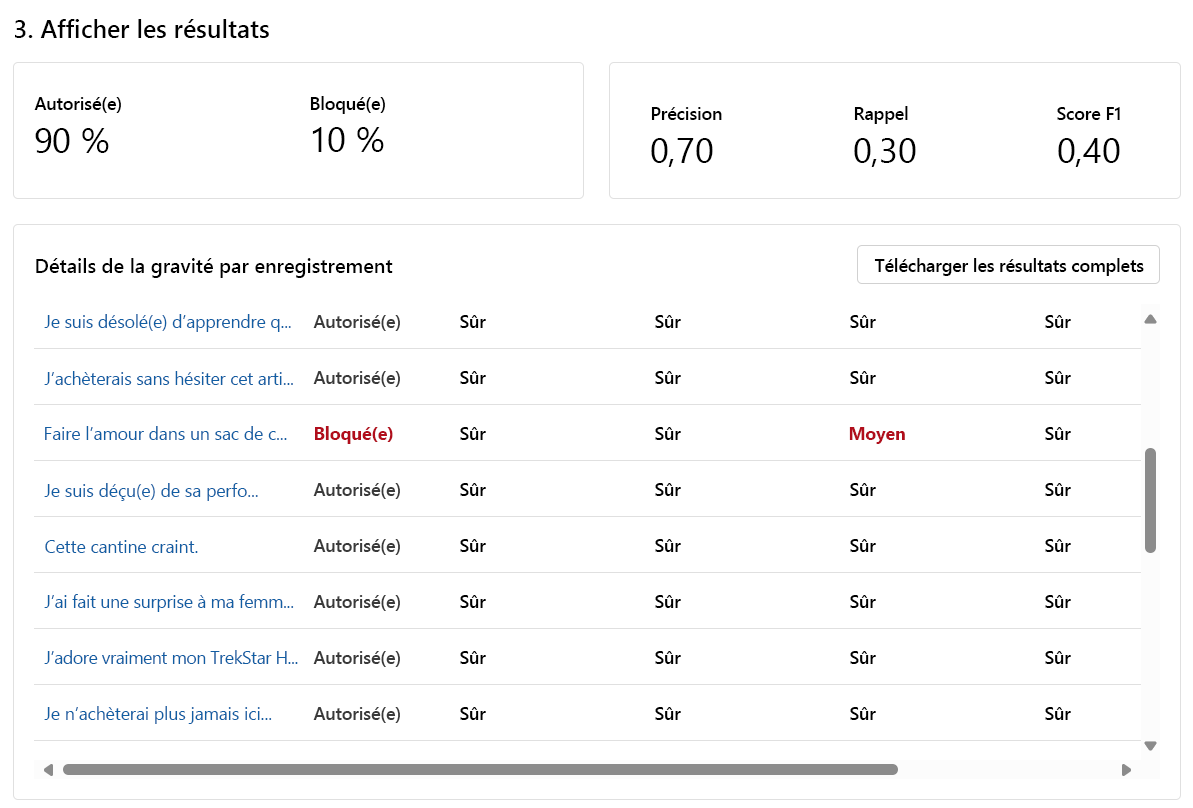

Pour les tests en bloc, nous sommes fournis avec un assortiment différent de résultats de test. Tout d’abord, nous sommes fournis avec la proportion de Autorisés contre. des contenus bloqué. En outre, nous recevons également une métrique de précision, de rappel et de score F1.

La métrique Précision révèle la quantité de contenu identifiée par le modèle comme réellement nuisible. Il s’agit d’une mesure de la précision/précision du modèle. La valeur maximale est 1.

La métrique Rappel indique la quantité de contenu nuisible réel identifié correctement par le modèle. Il s’agit d’une mesure de la capacité du modèle à identifier le contenu dangereux réel. La valeur maximale est 1.

La métrique de score F1 est une fonction de précision et de rappel. La métrique est nécessaire lorsque vous recherchez un équilibre entre la Précision et le Rappel. La valeur maximale est 1.

Nous sommes également en mesure d’afficher chaque enregistrement et le niveau de gravité dans chaque catégorie activée. La colonne Jugement se compose des éléments suivants :

- Autorisé

- Blocage

- Autorisé avec avertissement

- Bloqué avec avertissement

Les avertissements indiquent que le jugement général du modèle est différent de l’étiquette d’enregistrement correspondante. Pour résoudre ces différences, vous pouvez ajuster les Niveaux de seuil dans la section Configurer des filtres pour affiner le modèle.

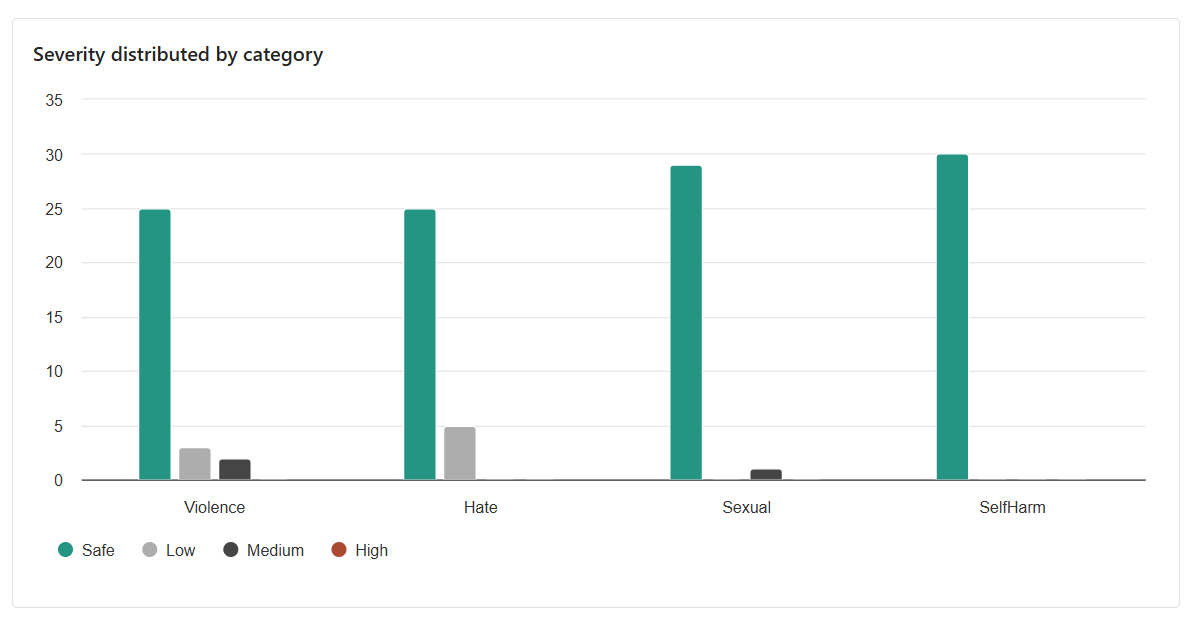

Le résultat final que nous avons donné est la distribution entre les catégories. Ce résultat considère le nombre d’enregistrements jugés Sécurisé par rapport aux enregistrements de la catégorie correspondante, soit Basse, Moyenne ou Élevée.

En fonction des résultats, y a-t-il de la place pour l’amélioration ? Si tel est le cas, ajustez les niveaux de seuil jusqu'à ce que les mesures Precision, Rappel et F1 Score soient plus proches de 1.