Exécuter des expériences avec MLflow

Les expériences de MLflow permettent aux scientifiques de données de suivre les exécutions d’apprentissage dans une collection appelée expérience. Les exécutions d’expérience sont utiles pour comparer les modifications au fil du temps ou pour comparer les performances relatives des modèles avec différentes valeurs d’hyperparamètres.

Exécution d’une expérience

La création d’une expérience dans Azure Databricks se produit automatiquement lorsque vous démarrez une exécution. Voici un exemple de démarrage d’une exécution dans MLflow, la journalisation de deux paramètres et la journalisation d’une métrique :

with mlflow.start_run():

mlflow.log_param("input1", input1)

mlflow.log_param("input2", input2)

# Perform operations here like model training.

mlflow.log_metric("rmse", rmse)

Dans ce cas, le nom de l’expérience est le nom du notebook. Il est possible d’exporter une variable nommée MLFLOW_EXPERIMENT_NAME pour modifier le nom de votre expérience si vous le souhaitez.

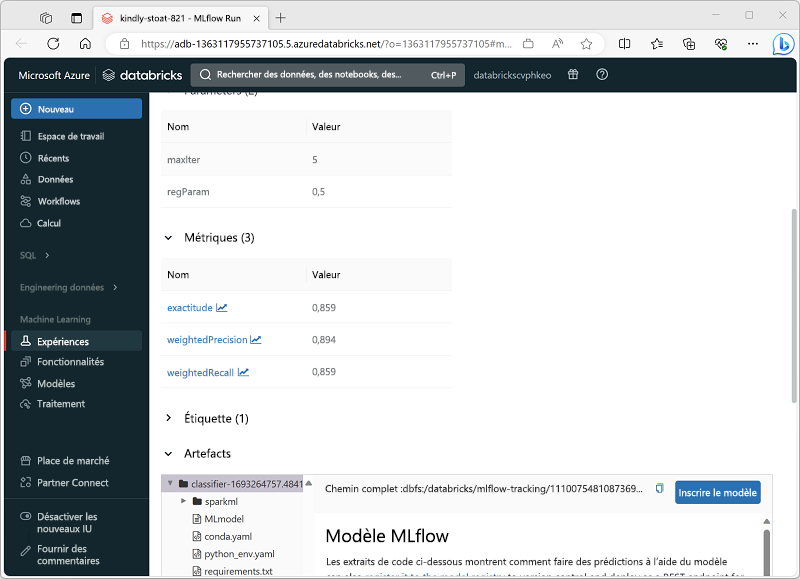

Examen d’une exécution d’expérience

Dans le portail Azure Databricks, la page Expériences vous permet d’afficher les détails de chaque exécution d’expérience ; y compris les valeurs journalisées pour les paramètres, les métriques et d’autres artefacts.