Évaluer le tableau de bord IA responsable

Lorsque votre tableau de bord IA responsable est généré, vous pouvez explorer son contenu dans Azure Machine Learning studio pour évaluer votre modèle.

Lorsque vous ouvrez le tableau de bord IA responsable, le studio tente de le connecter automatiquement à une instance de calcul. L’instance de calcul fournit le calcul nécessaire pour l’exploration interactive du tableau de bord.

La sortie de chaque composant que vous avez ajouté au pipeline est reflétée dans le tableau de bord. Selon les composants que vous avez sélectionnés, vous trouverez les insights suivants dans votre tableau de bord IA responsable :

- Analyse des erreurs

- Explications

- Contrefactuels

- Analyse causale

Explorons ce que nous pouvons examiner pour chacun de ces insights.

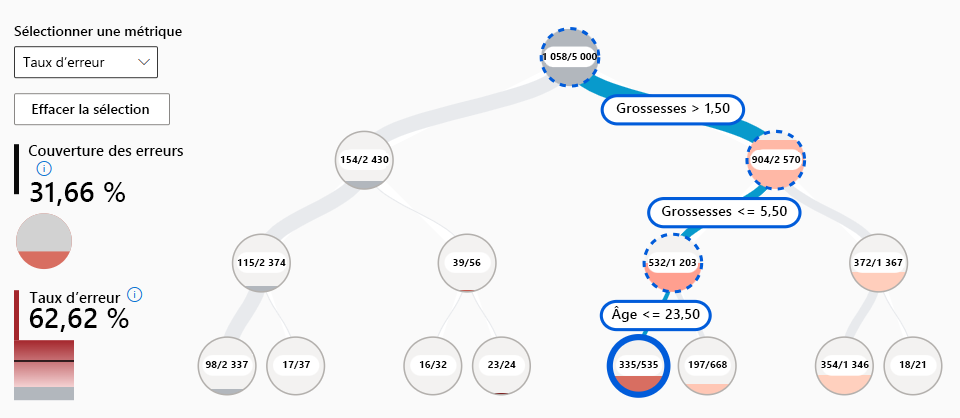

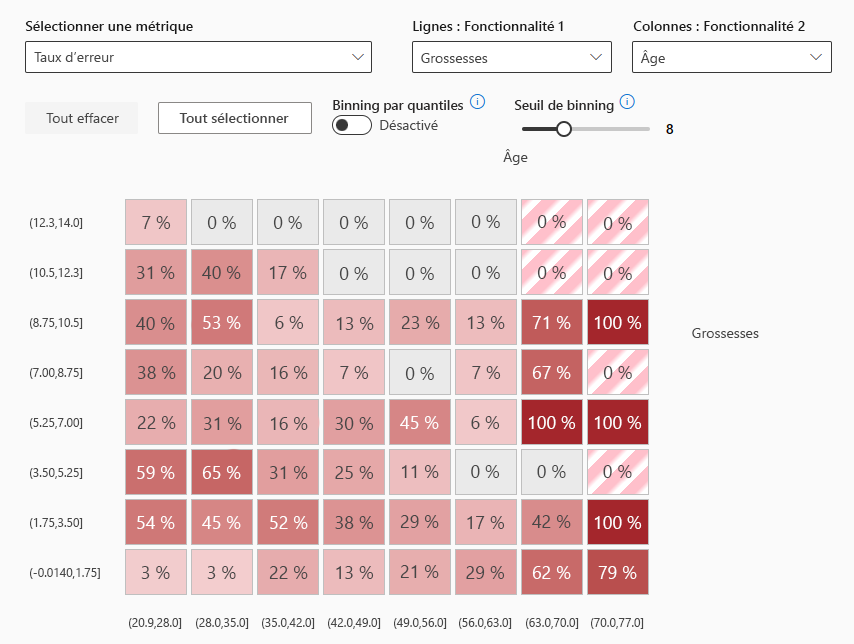

Explorer l’analyse des erreurs

Il est normal qu’un modèle fasse de mauvaises prédictions ou des erreurs. Avec la fonctionnalité d’analyse des erreurs dans le tableau de bord IA responsable, vous pouvez examiner et comprendre la façon dont les erreurs sont réparties dans votre jeu de données. Par exemple, y a-t-il des sous-groupes spécifiques, ou des cohortes, dans votre jeu de données pour lesquels le modèle fait davantage de mauvaises prédictions ?

Lorsque vous incluez l’analyse des erreurs, vous pouvez explorer deux types de visuels dans le tableau de bord IA responsable :

- Arborescence des erreurs : Vous permet d’explorer quelle combinaison de sous-groupes entraîne le plus de mauvaises prédictions par le modèle.

- Carte thermique des erreurs : Présente une vue d’ensemble de la grille des erreurs d’un modèle sur l’échelle d’une ou deux caractéristiques.

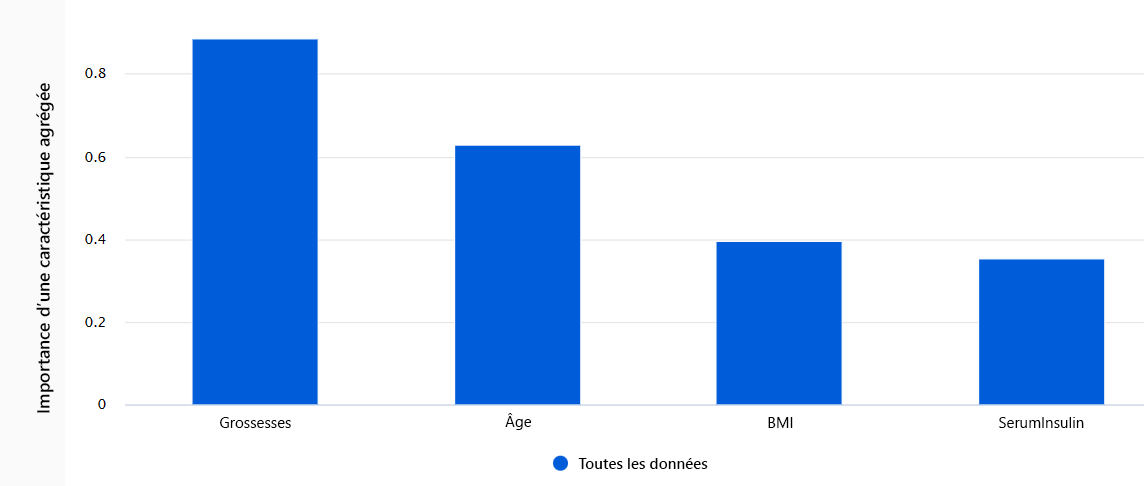

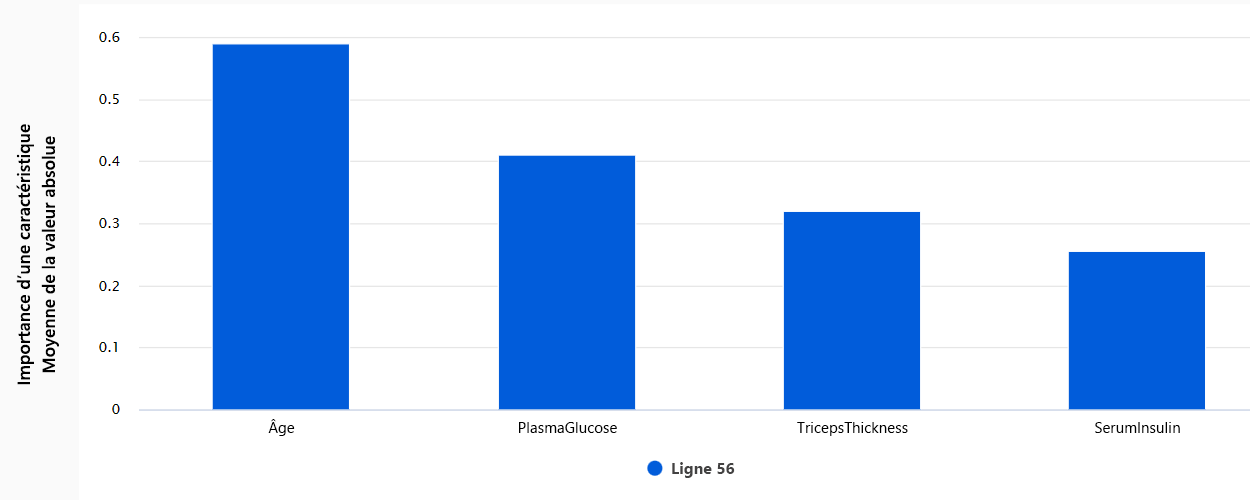

Explorer les explications

Chaque fois que vous utilisez un modèle pour la prise de décision, vous voulez comprendre comment un modèle arrive à une certaine prédiction. Chaque fois que vous entraînez un modèle trop complexe à comprendre, vous pouvez exécuter des facteurs explicatifs de modèle pour calculer l’importance des caractéristiques. En d’autres termes, vous voulez comprendre comment chacune des caractéristiques entrées influence la prédiction du modèle.

Il existe différentes techniques statistiques que vous pouvez utiliser comme facteurs explicatifs de modèle. Le plus souvent, le facteur explicatif de mimétisme entraîne un modèle interprétable simple sur les mêmes données et la même tâche. Par conséquent, vous pouvez explorer deux types d’importance des caractéristiques :

- Importance des caractéristiques agrégées : Montre comment chaque caractéristique dans les données de test influence les prédictions du modèle dans leur ensemble.

- Importance des caractéristiques individuelles : Montre dans quelle mesure chaque caractéristique affecte une prédiction individuelle.

Explorer les contrefactuels

Les explications peuvent vous donner des insights sur l’importance relative des caractéristiques dans les prédictions du modèle. Parfois, vous voudrez approfondir et comprendre si les prédictions du modèle changeraient si l’entrée était différente. Pour découvrir dans quelle mesure la sortie du modèle changerait si l’entrée était modifiée, vous pouvez utiliser des contrefactuels.

Vous pouvez choisir d’explorer des exemples de simulations de contrefactuels en sélectionnant un point de données et la prédiction du modèle souhaité pour ce point. Lorsque vous créez un contrefactuel de simulation, le tableau de bord ouvre un panneau pour vous aider à comprendre quelle entrée entraînerait la prédiction souhaitée.

Explorer l’analyse causale

Les explications et les contrefactuels vous aident à comprendre les prédictions du modèle et les effets des caractéristiques sur les prédictions. Bien que l’interprétabilité des modèles soit déjà un objectif en soi, vous aurez peut-être besoin de plus d’informations pour vous aider à améliorer la prise de décision.

L’analyse causale utilise des techniques statistiques pour estimer l’effet moyen d’une caractéristique sur une prédiction souhaitée. Elle analyse la façon dont certaines interventions ou certains traitements peuvent aboutir à un meilleur résultat au sein d’une population ou pour une personne en particulier.

Trois onglets sont disponibles dans le tableau de bord IA responsable lorsque vous y ajoutez l’analyse causale :

- Effets de causalité agrégés : Affiche les effets de causalité moyens pour les caractéristiques de traitement prédéfinies (les caractéristiques que vous souhaitez changer pour optimiser les prédictions du modèle).

- Effets de causalité individuels : Affiche des points de données individuels et vous permet de changer les caractéristiques de traitement pour explorer leur influence sur la prédiction.

- Stratégie de traitement : Affiche les parties de vos points de données qui ressentent le plus les bienfaits d’un traitement.