qu'est-ce qu'Azure Data Factory ?

Commençons par une vue d’ensemble d’Azure Data Factory pour vous aider à savoir s’il s’agit d’un bon choix pour organiser vos données en vue d’obtenir des insights métier.

Azure Data Factory est un service cloud d’ETL (extraction, transformation et chargement) et d’intégration de données qui vous aide à créer des workflows basés sur les données pour :

- Orchestrer le déplacement des données.

- Transformer les données à grande échelle.

Notes

Les workflows basés sur les données sont également appelés « pipelines ».

En utilisant Azure Data Factory, vous pouvez réorganiser les données brutes de façon logique dans des magasins de données et des lacs de données, ce qui vous permet de prendre de meilleures décisions métier.

Qu’est-ce que l’analytique données ?

L’analytique données est le processus qui consiste à collecter des données brutes et à les examiner pour en tirer des conclusions. Ce processus peut être difficile si les données se trouvent à plusieurs endroits, tels que des bases de données hébergées et des emplacements locaux.

Conseil

Les données brutes sont des données qui ont été collectées à partir d’une source et qui n’ont pas été traitées. Elles sont parfois appelées données non organisées.

Azure fournit plusieurs technologies que vous pouvez implémenter pour faciliter l’analytique données au sein de votre organisation, notamment :

- Azure Synapse Analytics

- Stockage Blob Azure

- Azure Data Lake Storage

- Service Analytique Azure Data Lake

- Azure Analysis Services

- Azure HDInsight

- Azure Databricks

- Azure Machine Learning

Vous pouvez utiliser tous ces services ou un seul d’entre eux selon vos besoins, pour analyser les données de votre organisation. Toutefois, aucun de ces services ne permet d’effectuer une intégration de données. L’intégration de données vous permet de collecter des données à partir de plusieurs sources, puis de charger ces données combinées dans un endroit approprié pour les analyser. Si nécessaire, vous pouvez transformer les données pendant ce processus. Même s’il est possible d’effectuer ces tâches manuellement, vous pouvez envisager d’utiliser Azure Data Factory.

Définition d’Azure Data Factory

Azure Data Factory est un service cloud d’intégration de données conçu pour répondre aux besoins de deux communautés spécifiques, comme l’explique le tableau ci-dessous :

| Community | Besoins de la communauté |

|---|---|

| Communauté Big Data | Cette communauté utilise des technologies permettant de gérer de grandes quantités de données diverses. Pour eux, Azure Data Factory constitue un moyen de créer et d’exécuter des pipelines dans le cloud. Ces pipelines peuvent accéder aux services de données cloud et locaux. Ces pipelines fonctionnent généralement avec des technologies comme Azure Synapse Analytics, les blobs Azure et Azure Data Lake. Et également Azure HDInsight, Azure Databricks et Azure Machine Learning. |

| Communauté d’entreposage de données relationnelles | Cette communauté utilise généralement des technologies comme Microsoft SQL Server. SQL Server Integration Services (SSIS) est souvent utilisé pour créer des packages SSIS. Azure Data Factory offre à cette communauté la capacité à exécuter des packages SSIS sur Azure, ce qui lui permet d’accéder aux services de données cloud et locaux. |

Remarque

Un package est semblable à un pipeline Azure Data Factory. Chaque package définit un processus d’extraction, de chargement et de transformation des données, ou autre opération de données.

La principale chose à noter est qu’Azure Data Factory est un service cloud pour l’intégration de données. Il fournit un ensemble d’outils ainsi qu’une interface de gestion commune pour l’ensemble de votre intégration de données, et prend en charge toutes vos sources de données, où qu’elles se trouvent :

- Azure

- Local

- Sur une plateforme de cloud public tierce

Comment Azure Data Factory peut faciliter l’analytique données

À l’aide d’Azure Data Factory, vous pouvez :

Générer des processus ETL complexes. Ces processus peuvent transformer les données visuellement en utilisant des flux de données ou des services de calcul comme :

- Azure HDInsight Hadoop

- Azure Databricks

- Azure SQL Database

Publiez ces données transformées dans des magasins de données pour que les applications décisionnelles les consomment.

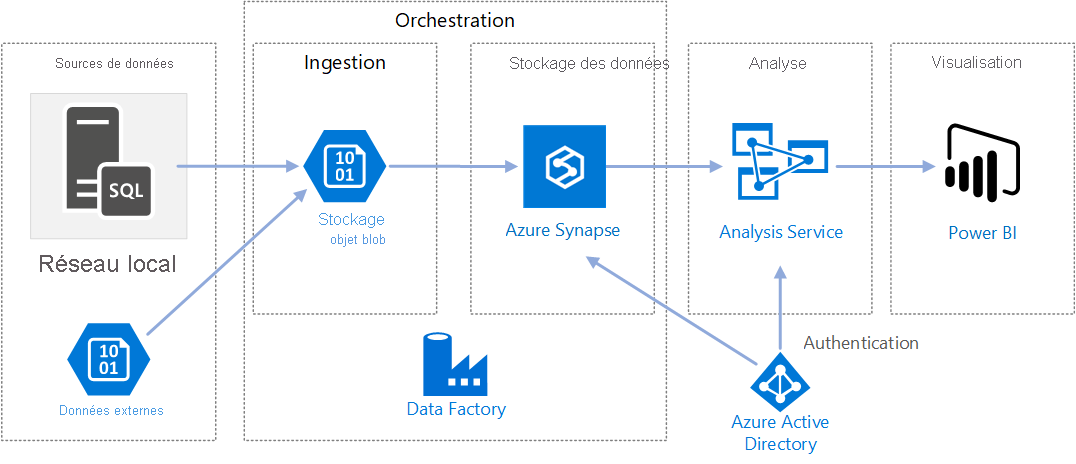

Dans le schéma suivant, les sources de données externes sont connectées à Azure Data Factory. Un objet blob de stockage est utilisé pour ingérer les données, tandis qu’Azure Synapse Analytics est utilisé pour les stocker. Ces éléments permettent l’orchestration. Les composants d’analyse et de visualisation, Azure Analysis Services et Power BI sont également connectés à Azure Data Factory.

Conseil

Azure Data Factory fournit plus de 90 connecteurs intégrés sans maintenance.