Explorer et traiter des données avec Microsoft Fabric

Les données sont la pierre angulaire de la science des données, en particulier lorsqu’il s’agit d’entraîner un modèle de Machine Learning pour atteindre l’intelligence artificielle. En règle générale, les modèles présentent des performances améliorées à mesure que la taille du jeu de données d’entraînement augmente. Outre la quantité de données, la qualité de celle-ci est tout aussi importante.

Pour garantir la qualité et la quantité de vos données, l’utilisation de moteurs robustes d’ingestion et de traitement des données de Microsoft Fabric est très utile. Vous avez la possibilité d’opter pour une approche à faible code ou orientée code lors de l’établissement des pipelines essentiels d’ingestion, d’exploration et de transformation de données.

Ingérer vos données dans Microsoft Fabric

Pour utiliser des données dans Microsoft Fabric, vous devez d’abord ingérer des données. Vous pouvez ingérer des données provenant de plusieurs sources, locales et cloud à la fois. Par exemple, vous pouvez ingérer des données à partir d’un fichier CSV stocké sur votre ordinateur local ou dans un Azure Data Lake Storage (Gen2).

Conseil

Découvrez-en davantage sur la façon d’ingérer et d’orchestrer des données à partir de différentes sources avec Microsoft Fabric.

Après vous être connecté à une source de données, vous pouvez enregistrer les données dans un lakehouse Microsoft Fabric. Vous pouvez utiliser le lakehouse comme emplacement central pour stocker tous les fichiers structurés, semi-structurés et non structurés. Vous pouvez ensuite vous connecter facilement au lakehouse chaque fois que vous souhaitez accéder à vos données à des fins d’exploration ou de transformation.

Explorer et transformer vos données

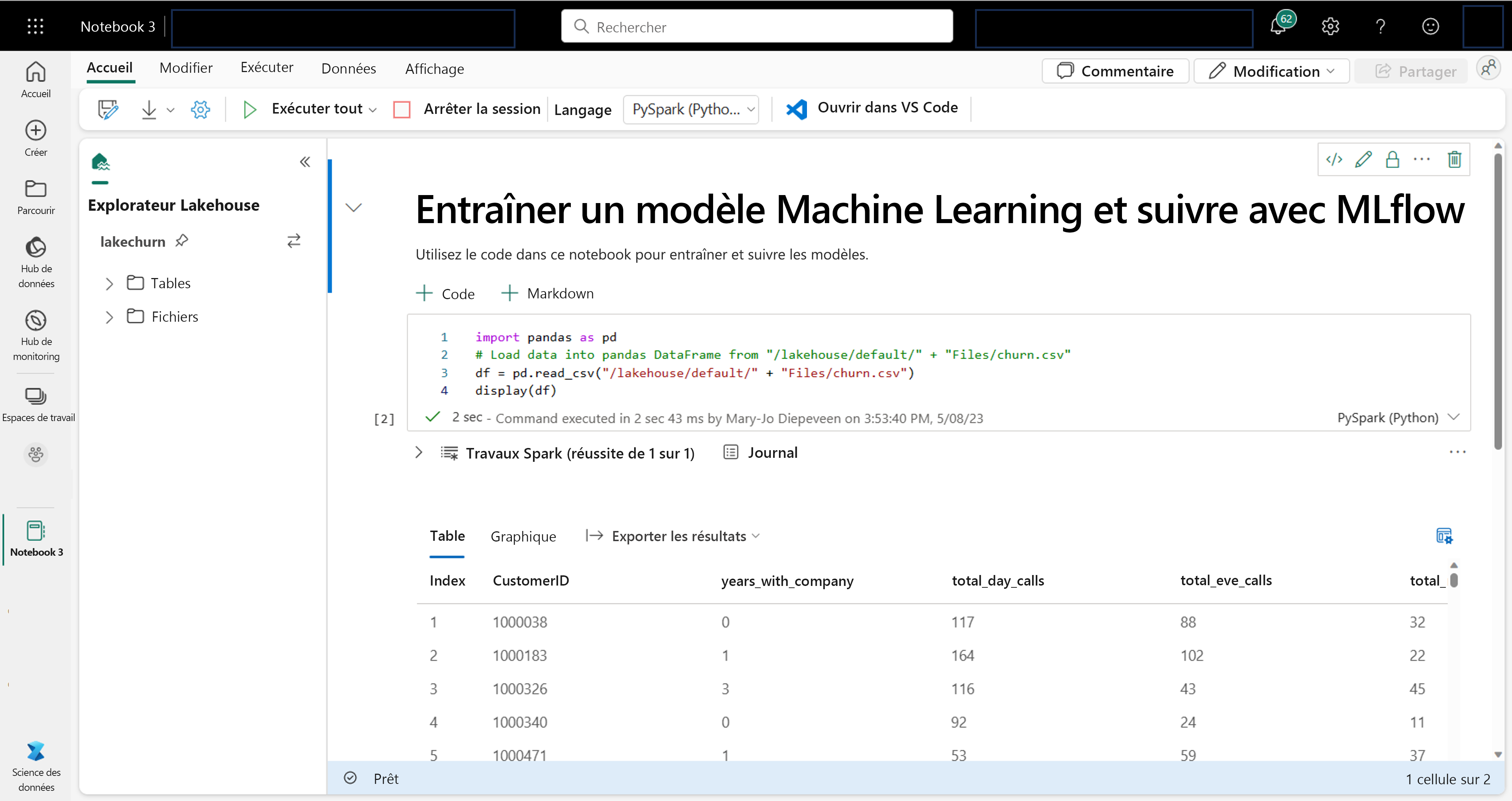

En tant que scientifique des données, vous êtes peut-être plus à l’aise avec l’écriture et l’exécution de code dans les notebooks. Microsoft Fabric offre une expérience de notebook familière, optimisée par le calcul Spark.

Apache Spark est un framework de traitement parallèle open source pour le traitement et l’analytique à grande échelle des données.

Les notebooks sont automatiquement attachés à un calcul Spark. Lorsque vous exécutez une cellule dans un notebook pour la première fois, une nouvelle session Spark démarre. La session persiste lorsque vous exécutez les cellules suivantes. La session Spark s’arrête automatiquement après un certain temps d’inactivité pour réduire les coûts. Vous pouvez également arrêter manuellement la session.

Lorsque vous travaillez dans un notebook, vous pouvez choisir le langage que vous souhaitez utiliser. Pour les charges de travail de science des données, vous êtes susceptible d’utiliser PySpark (Python) ou SparkR (R).

Dans le notebook, vous pouvez explorer vos données à l’aide de votre bibliothèque préférée ou avec l’une des options de visualisation intégrées. Si nécessaire, vous pouvez transformer vos données et enregistrer les données traitées en les réécrivant dans le lakehouse.

Préparer vos données avec Data Wrangler

Pour vous aider à explorer et à transformer vos données plus rapidement, Microsoft Fabric propose Data Wrangler, un outil facile à utiliser.

Après avoir lancé Data Wrangler, vous obtiendrez une vue d’ensemble descriptive des données que vous utilisez. Vous pouvez afficher les statistiques récapitulatives de vos données pour trouver des problèmes tels que des valeurs manquantes.

Pour nettoyer vos données, vous pouvez choisir l’une des opérations de nettoyage de données intégrées. Lorsque vous sélectionnez une opération, un aperçu du résultat et du code associé est généré automatiquement pour vous. Une fois que vous avez sélectionné toutes les opérations nécessaires, vous pouvez exporter les transformations vers du code et les exécuter sur vos données.