Évaluer les performances de vos applications IA génératives

Lorsque vous souhaitez créer une application d’IA générative, vous utilisez le flux d’invite pour développer l’application de conversation. Vous pouvez évaluer les performances d’une application en évaluant les réponses après avoir exécuté votre flux.

Tester votre flux avec des invites individuelles

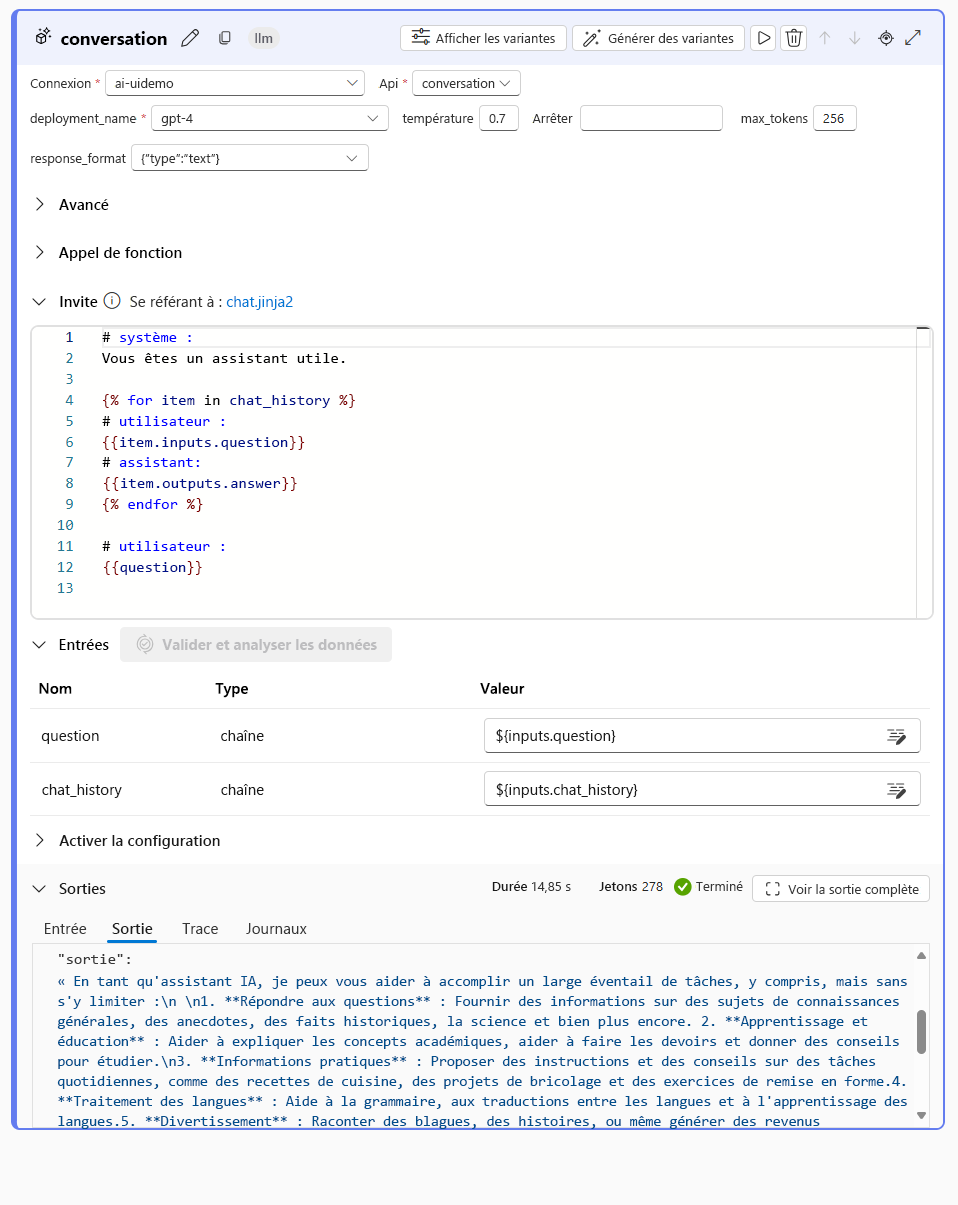

Pendant le développement actif, vous pouvez tester le flux de conversation que vous créez à l’aide de la fonctionnalité de conversation lorsque vous avez une session de calcul en cours d’exécution :

Lorsque vous testez votre flux avec une invite individuelle dans la fenêtre de conversation, votre flux s’exécute avec votre entrée fournie. Une fois l’exécution réussie, une réponse s’affiche dans la fenêtre de conversation. Vous pouvez également explorer la sortie de chaque nœud individuel de votre flux pour comprendre comment la réponse finale a été construite :

Tester automatiquement votre flux avec des flux d’évaluation

Pour évaluer un flux de conversation en bloc, vous pouvez exécuter des évaluations automatisées. Vous pouvez utiliser les évaluations automatisées intégrées ou définir vos évaluations personnalisées en créant votre propre flux d’évaluation.

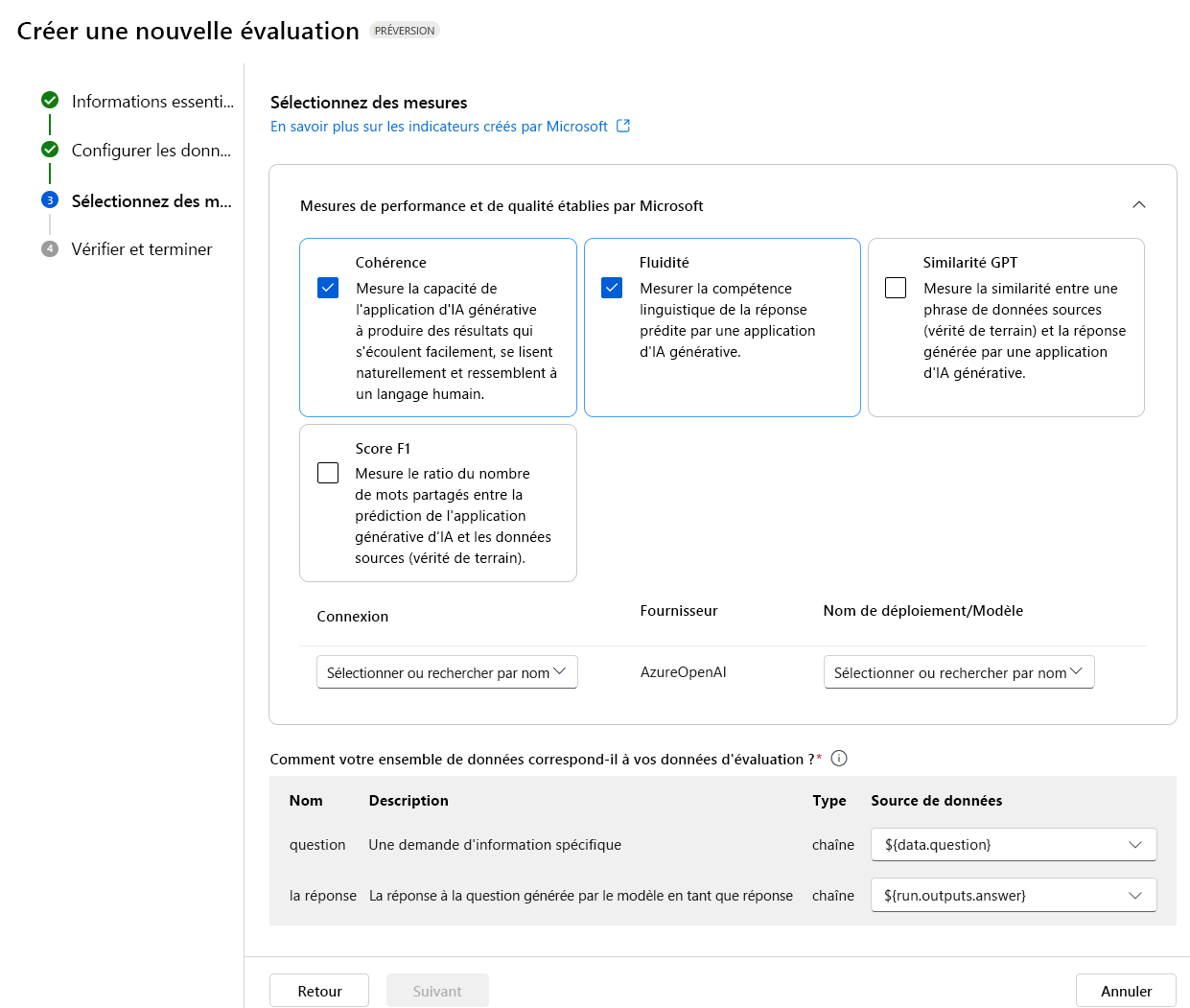

Évaluer avec les mesures organisées par Microsoft

Les mesures intégrées ou organisées par Microsoft incluent les mesures suivantes :

Performances et qualité :

- Cohérence : Mesure la façon dont l’application IA générative peut produire des sorties harmonieuses, qui se lisent naturellement et ressemblent à un langage semblable à celui de l’homme.

- Fluidité : Mesure la maîtrise du langage d’une application IA générative prédite.

- Similarité à GPT : Mesure la similarité entre une phrase de données sources (vérité de base) et la réponse générée par une application IA générative.

- Score F1 : Mesure la proportion du nombre de mots entre la prédiction de l’application IA générative et les données sources (vérité de base).

- Ancrage : Mesure la façon dont les réponses générées par l’application IA générative s’alignent sur les informations de la source d’entrée.

- Pertinence : Mesure à quel point les réponses générées par l’application IA générative sont pertinentes et directement liées aux questions données.

Risque et sécurité :

- Contenu lié à l'automutilation : Mesure la prédisposition de l’application IA générative à produire du contenu lié à l’automutilation.

- Contenu haineux et injuste : Mesure la prédisposition de l’application IA générative à produire du contenu haineux et injuste.

- Contenu violent : Mesure la prédisposition de l’application IA générative à produire du contenu violent.

- Contenu sexuel : Mesure la prédisposition de l’application IA générative à produire du contenu sexuel.

Pour évaluer votre flux de conversation avec les évaluations automatisées intégrées, vous devez :

- Créez un jeu de données de test.

- Créer une nouvelle évaluation automatisée dans le portail Azure AI Foundry.

- Sélectionnez un flux ou un jeu de données avec des sorties générées par le modèle.

- Sélectionnez les métriques que vous souhaitez utiliser pour l’évaluation.

- Exécutez le flux d’évaluation.

- Passez en revue les résultats.

Conseil

En savoir plus sur les mesures d’évaluation et de surveillance

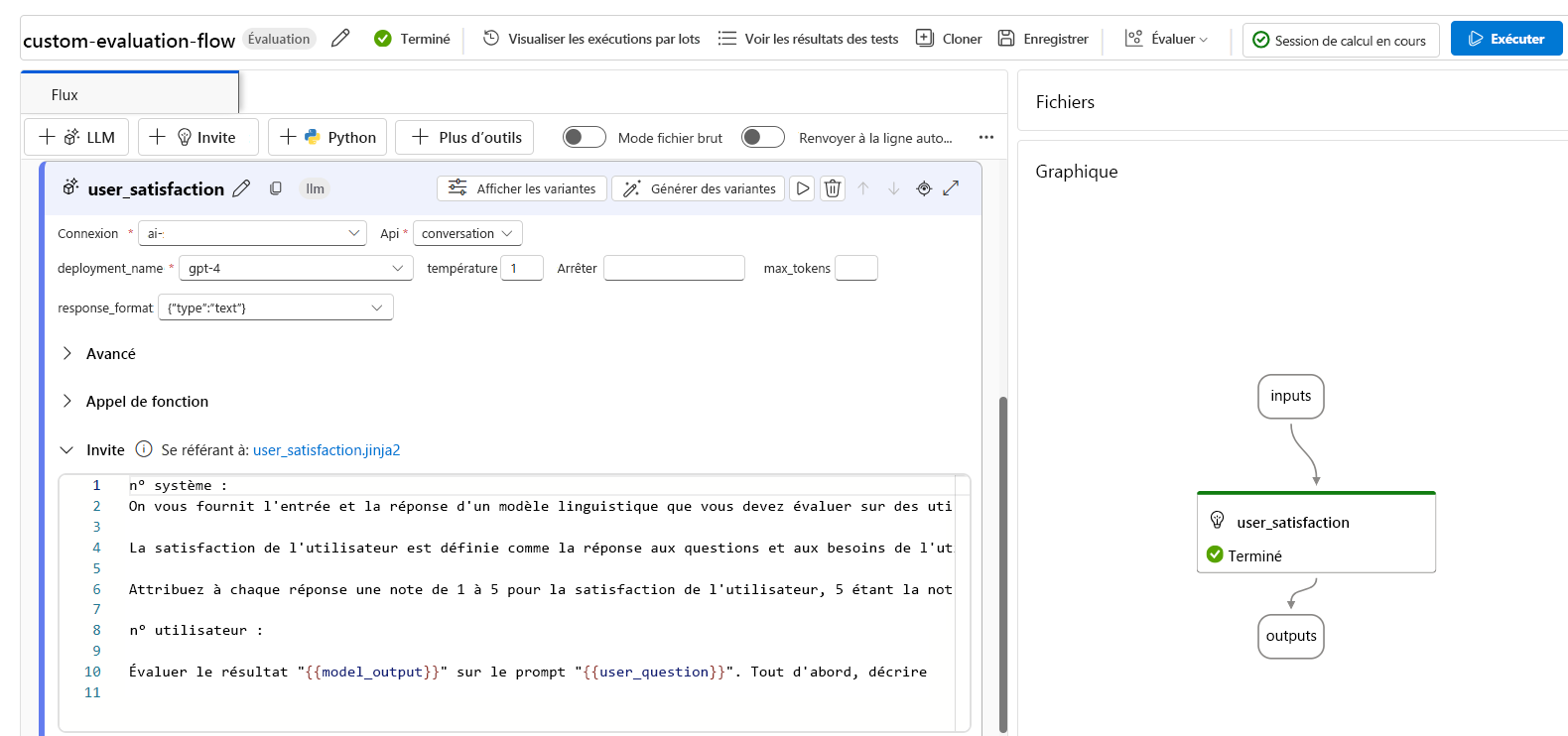

Créer des métriques d’évaluation personnalisées

Vous pouvez également créer votre propre flux d’évaluation personnalisé, dans lequel vous définissez la façon dont la sortie de votre flux de conversation doit être évaluée. Par exemple, vous pouvez évaluer la sortie à l’aide du code Python ou à l’aide d’un nœud LLM (grand modèle de langage) pour créer une mesuré assistée par l’IA. Examinons le fonctionnement d’un flux d’évaluation avec un exemple simple.

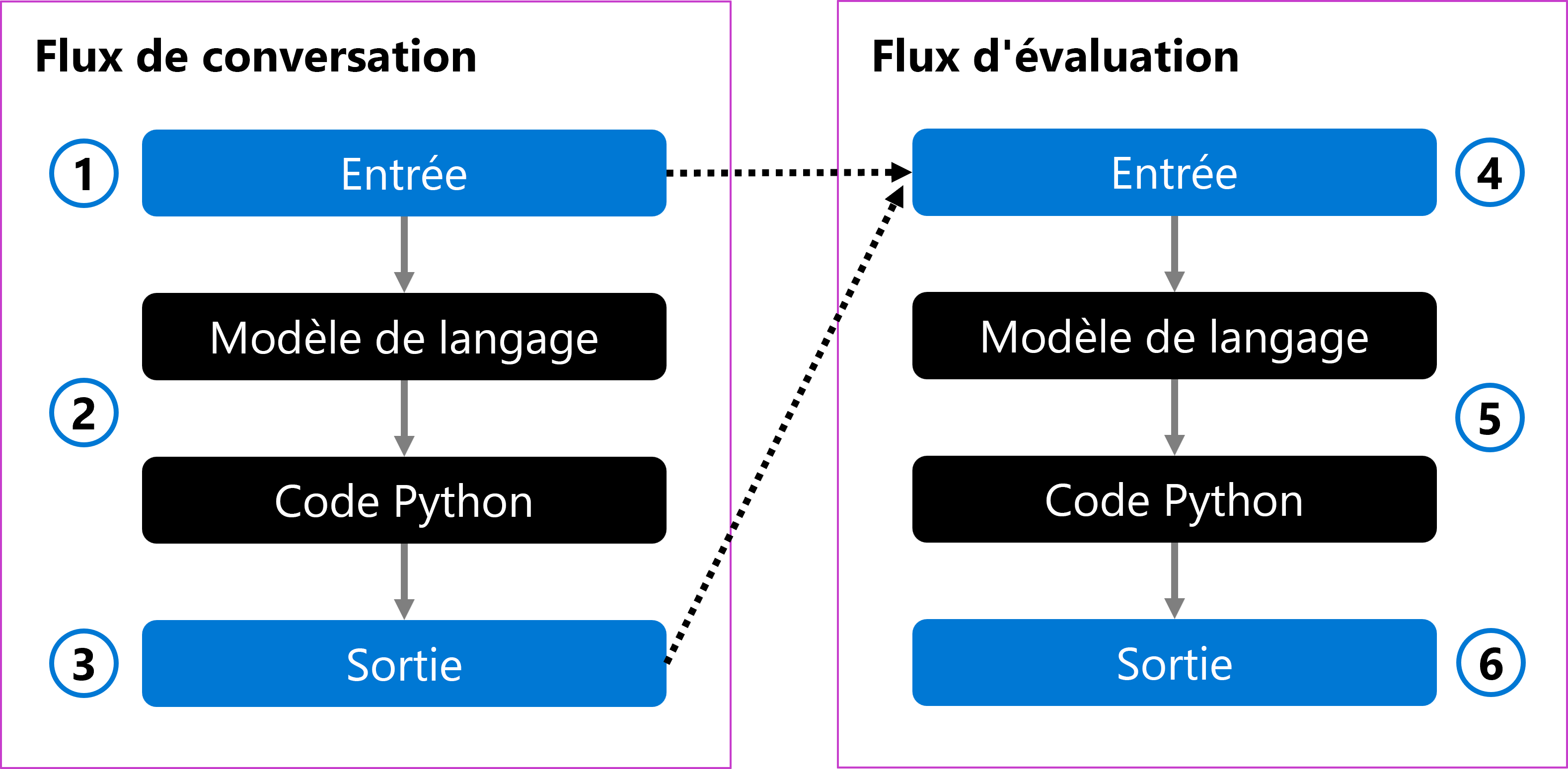

Vous pouvez avoir un flux de conversation qui accepte la question d’un utilisateur en tant qu’entrée (1). Le flux traite l’entrée à l’aide d’un modèle de langage et met en forme la réponse avec du code Python (2). Enfin, elle retourne la réponse en tant que sortie (3).

Pour évaluer le flux de conversation, vous pouvez créer un flux d’évaluation. Le flux d’évaluation accepte la question de l’utilisateur d’origine et la sortie générée en tant qu’entrée (4). Le flux l’évalue avec un modèle de langage et utilise du code Python pour définir une mesure d’évaluation (5), qui est ensuite retournée comme sortie (6).

Lorsque vous créez un flux d’évaluation, vous pouvez choisir comment évaluer un flux de conversation. Vous pouvez utiliser un modèle de langage pour créer vos propres mesures personnalisées assistées par l’IA. Dans l’invite, vous pouvez définir la mesure que vous souhaitez mesurer et l’échelle de notation que le modèle de langage doit utiliser. Par exemple, une invite d’évaluation peut être :

# Instructions

You are provided with the input and response of a language model that you need to evaluate on user satisfaction.

User satisfaction is defined as whether the response meets the user’s question and needs, and provides a comprehensive and appropriate answer to the question.

Assign each response a score of 1 to 5 for user satisfaction, with 5 being the highest score.

Après avoir créé un flux d’évaluation, vous pouvez évaluer un flux de conversation en fournissant un jeu de données test et en exécutant le flux d’évaluation.

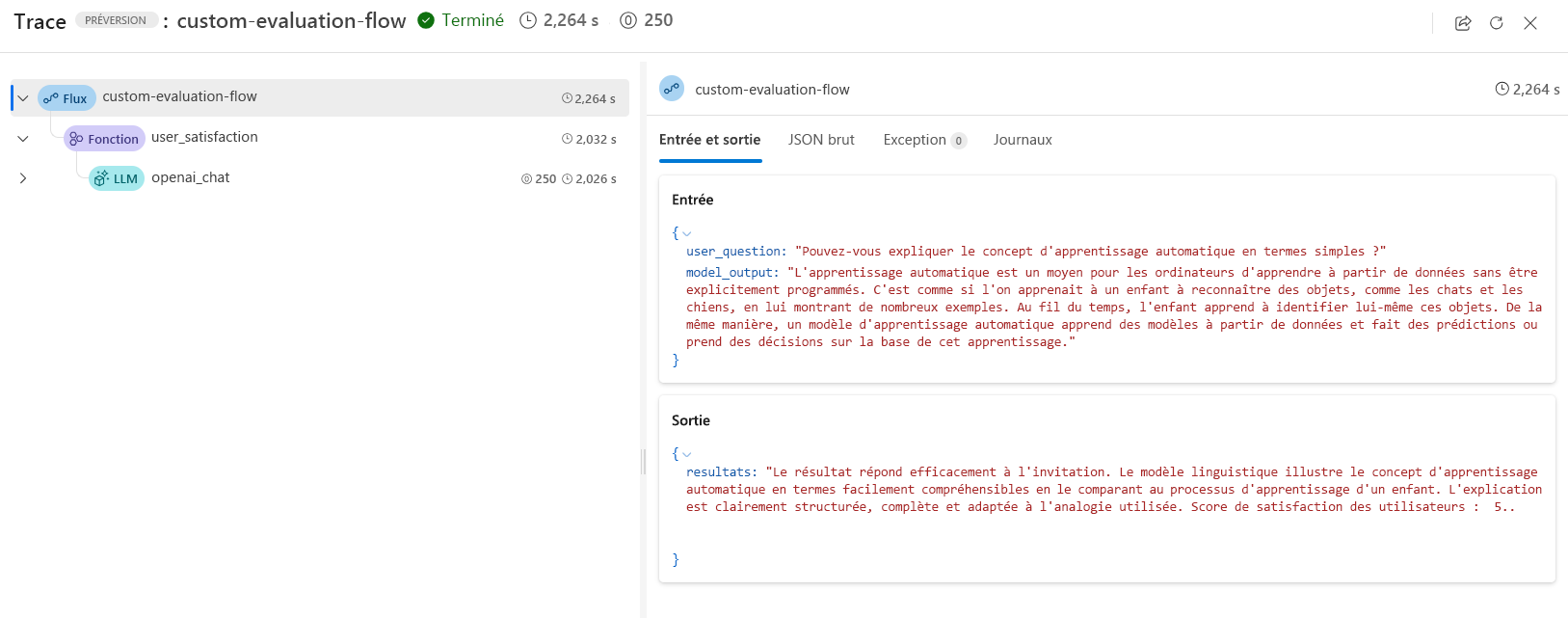

Lorsque vous utilisez un modèle de langage dans un flux d’évaluation, vous pouvez examiner les résultats dans le suivi de sortie :

En outre, vous pouvez ajouter un nœud Python dans le flux d’évaluation pour agréger les résultats de toutes les invites dans votre jeu de données test et retourner une mesure globale.

Conseil

Découvrez comment développer un flux d’évaluation dans Azure AI Studio.