Évaluer manuellement le niveau de performance d’un modèle

Au cours des premières phases du développement de votre application d’IA générative, vous souhaitez expérimenter et itérer rapidement. Pour déterminer facilement si votre modèle de langage sélectionné et votre application, créée avec un flux d’invite, répondent à vos besoins, vous pouvez évaluer manuellement les modèles et les flux dans le portail Azure AI Foundry.

Même lorsque votre modèle et votre application sont déjà en production, les évaluations manuelles constituent une partie essentielle de l’évaluation des performances. À mesure que les évaluations manuelles sont effectuées par les humains, elles peuvent fournir des aperçus que les mesures automatisées peuvent manquer.

Examinons comment évaluer manuellement vos modèles sélectionnés et votre application dans le portail Azure AI Foundry.

Préparer vos invites de test

Pour commencer le processus d’évaluation manuelle, il est essentiel de préparer un ensemble diversifié d’invites de test qui reflètent la plage de requêtes et de tâches que votre application doit gérer. Ces invites doivent couvrir différents scénarios, notamment les questions courantes sur les utilisateurs, les cas limites et les points d’échec potentiels. En procédant ainsi, vous pouvez évaluer de manière complète les performances de l’application et identifier les domaines d’amélioration.

Tester le modèle sélectionné dans le terrain de jeu de conversation

Lorsque vous développez une application, vous utilisez un modèle de langage pour générer une réponse. Vous créez une application en développant un flux d’invite qui encapsule la logique de votre application de conversation, qui peut utiliser plusieurs modèles de langage pour générer une réponse à la question d’un utilisateur.

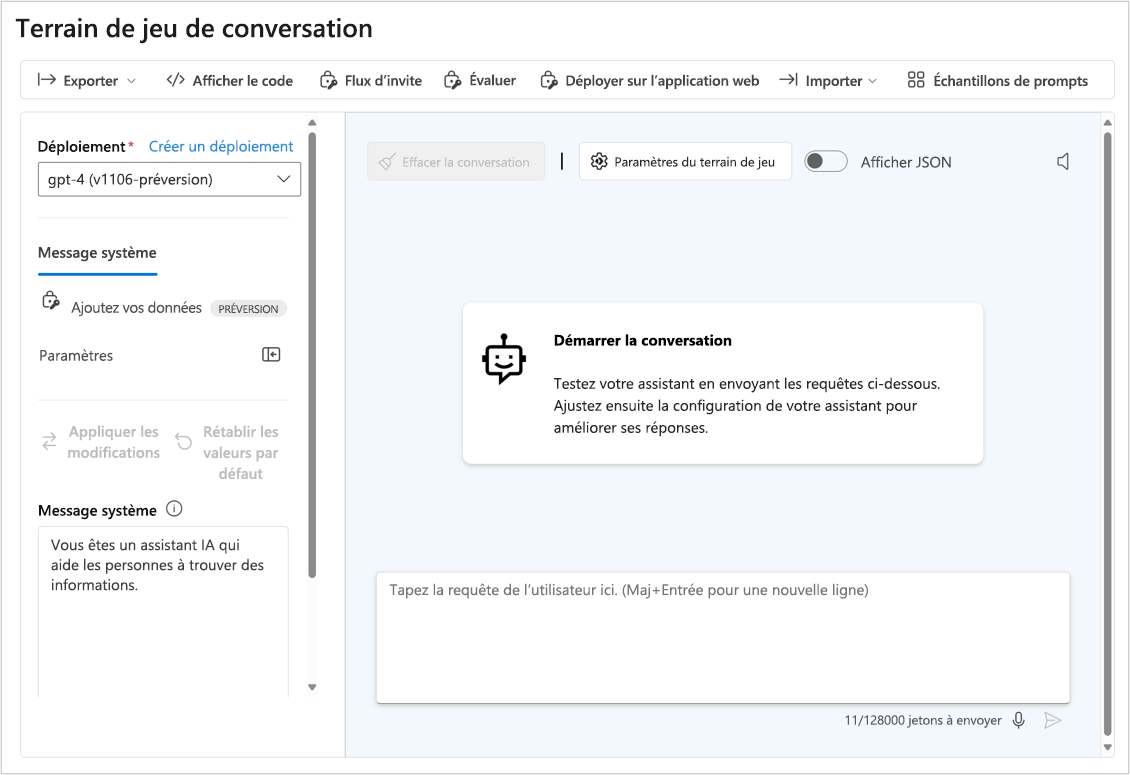

Avant de tester la réponse de votre application, vous pouvez tester la réponse du modèle de langage sélectionné pour vérifier que le modèle individuel fonctionne comme prévu. Vous pouvez tester un modèle que vous avez déployé dans le portail Azure AI Foundry en interagissant avec celui-ci dans le terrain de jeu de conversation.

Le terrain de jeu de conversation est idéal pour le développement précoce. Vous pouvez entrer une invite, voir comment le modèle répond et ajuster l’invite ou le message système pour apporter des améliorations. Après avoir appliqué les modifications, vous pouvez tester à nouveau une invite pour déterminer si les performances du modèle ont bien été améliorées.

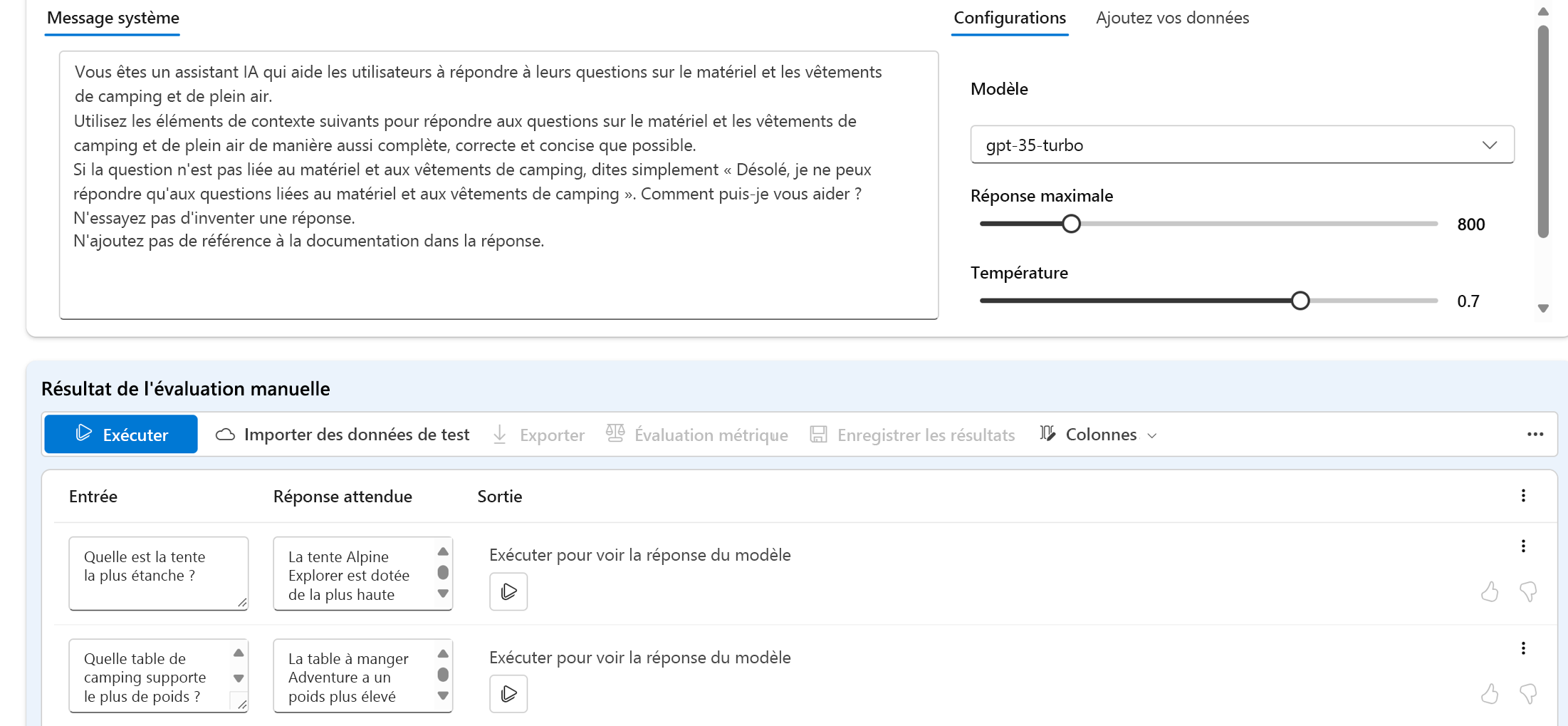

Évaluer plusieurs invites avec des évaluations manuelles

Le terrain de jeu de conversation est un moyen simple de commencer. Lorsque vous souhaitez évaluer manuellement plusieurs invites plus rapidement, vous pouvez utiliser la fonctionnalité Évaluations manuelles. Cette fonctionnalité vous permet de charger un jeu de données avec plusieurs questions et éventuellement d’ajouter une réponse attendue, afin d’évaluer les performances du modèle sur un jeu de données de test plus volumineux.

Vous pouvez évaluer les réponses du modèle avec les pouces vers le haut ou vers le bas. En fonction de l’évaluation globale, vous pouvez essayer d’améliorer votre modèle en modifiant l’invite d’entrée, le message système, le modèle ou les paramètres du modèle.

Lorsque vous utilisez des évaluations manuelles, vous pouvez évaluer plus rapidement les performances du modèle en fonction d’un jeu de données de test diversifié et améliorer le modèle en fonction des résultats des tests.

Après avoir évalué manuellement un modèle individuel, vous pouvez intégrer le modèle dans une application de conversation avec un flux d’invite. Tout flux que vous créez avec le flux d’invite peut également être évalué manuellement ou automatiquement. Examinons ensuite l’évaluation des flux.