Exercice : créer votre point de terminaison

Dans cet exercice, vous créez une ressource Azure OpenAI et fournissez les informations sur le déploiement au noyau Semantic Kernel. Le noyau Semantic Kernel se connecte au point de terminaison et vous permet d’exécuter des invites au modèle de langage volumineux (LLM) directement à partir de votre code. C’est parti !

Accédez à https://portal.azure.com.

Dans la barre de recherche, entrez « Azure OpenAI », puis sélectionnez le service Azure OpenAI.

Créez une ressource Azure OpenAI en utilisant les paramètres par défaut.

Remarque

Si vous disposez déjà d’une ressource Azure OpenAI, vous pouvez ignorer cette étape.

Après la création de la ressource créée, sélectionnez Accéder à la ressource.

Dans la page Vue d’ensemble, sélectionnez Accéder à Azure OpenAI Studio.

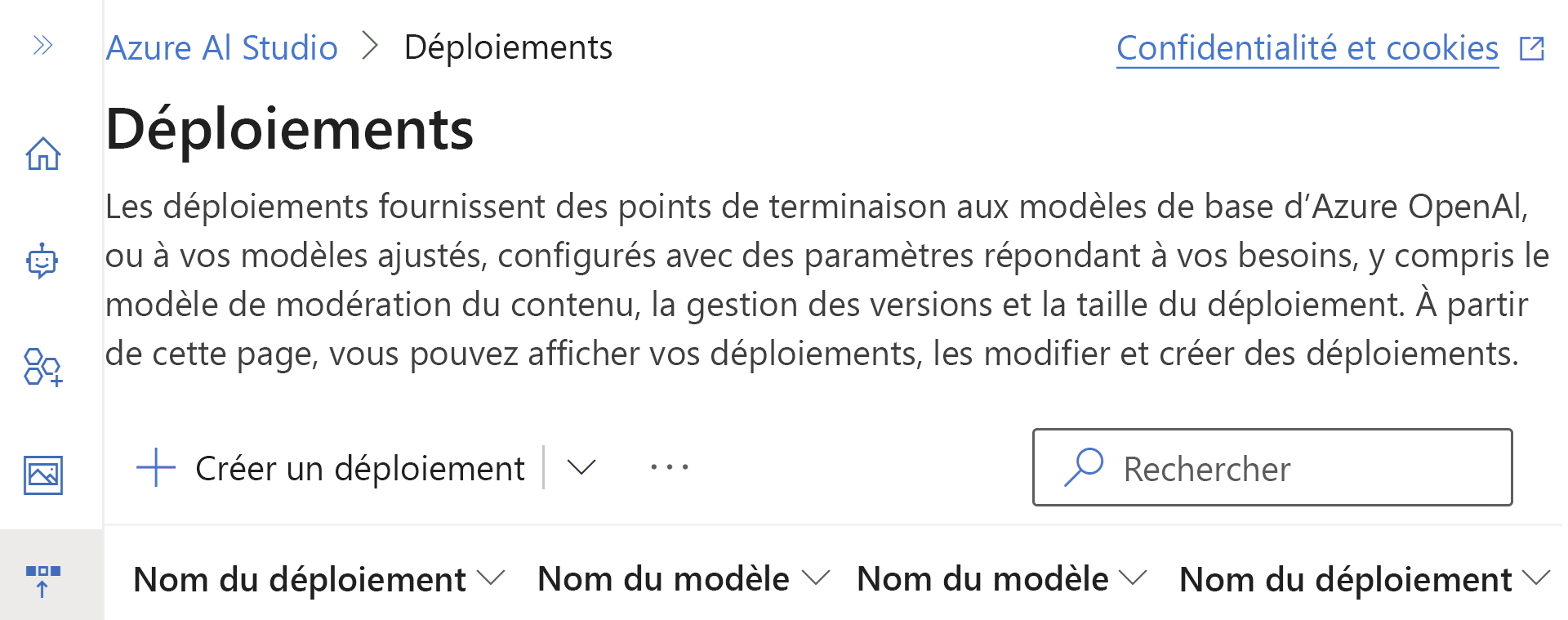

Sélectionnez Créer un déploiement, puis Déployer un modèle.

Sous Sélectionner un modèle, sélectionnez gpt-35-turbo-16k.

Utiliser la version de modèle par défaut

Entrez un nom pour votre déploiement.

Une fois le déploiement terminé, revenez à votre ressource Azure OpenAI.

Sous Gestion des ressources, accédez à Clés et points de terminaison.

Vous allez utiliser les données ici dans les exercices suivants pour générer votre noyau. N’oubliez pas de veiller à ce vos clés restent privées et sécurisées.

Important

Veillez à ne pas supprimer cette ressource tant que vous n’avez pas terminé ce parcours d’apprentissage. Vous en aurez besoin pour faire les exercices.