Aperçu des mesures environnementales, sociales et de gouvernance informatiques

Important

Tout ou partie de cette fonctionnalité est accessible dans le cadre d’une version préliminaire. Le contenu et la fonctionnalité sont susceptibles d’être modifiés.

Vous pouvez sélectionner et calculer les métriques prédéfinies à l’aide des blocs-notes et des pipelines prédéfinis déployés dans le cadre de cette fonctionnalité.

Nonte

Vous pouvez étendre les blocs-notes et les pipelines pour prendre en charge des métriques personnalisées. Pour plus d'informations, accédez à Créer des métriques personnalisées.

Prérequis

Chargez les définitions de métriques prédéfinies dans les tables MetricsDefinitions et MetricsLabels du lac ComputedESGMetrics_LH en exécutant le bloc-notes LoadDefinitionsForMetrics . Vous n’avez besoin d’effectuer cette étape qu’une seule fois. Les cahiers de calcul métrique extraient la définition de la métrique à partir de ces tables.

Vous pouvez ensuite interroger la table MetricsDefinitions pour afficher les définitions des métriques. Pour chaque métrique, vous pouvez voir les propriétés de la métrique :

- nom métrique

- mesure

- dimensions

- filters

- domaine de la durabilité

Vous pouvez également interroger la table MetricsLabels pour explorer les métriques par libellés, tels que Norme de reporting et Point de données de divulgation.

Vous pouvez ensuite explorer la bibliothèque de métriques prédéfinies pour déterminer l'ensemble de données agrégé à renseigner pour le calcul de la métrique prédéfinie respective.

Reportez-vous à Générer des tables agrégées pour découvrir les tables de modèle de données ESG respectives et les attributs à renseigner pour générer les tables agrégées.

Ingérez, transformez et chargez les données transformées dans les tables du modèle de données ESG dans le lakehouse ProcessedESGData_LH déployé dans le cadre de la capacité de parc de données ESG dans le même espace de travail.

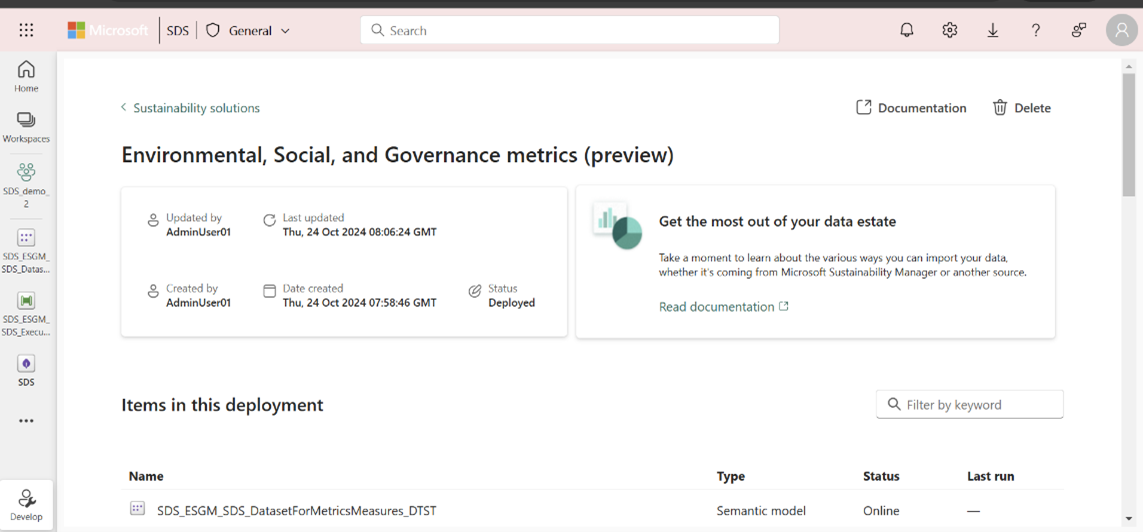

Authentifiez les modèles sémantiques prédéfinis (DatasetForMetricsMeasures et DatasetForMetricsDashboard) utilisés dans le calcul des métriques en créant une connexion. Vous n’avez besoin d’effectuer cette étape qu’une seule fois.

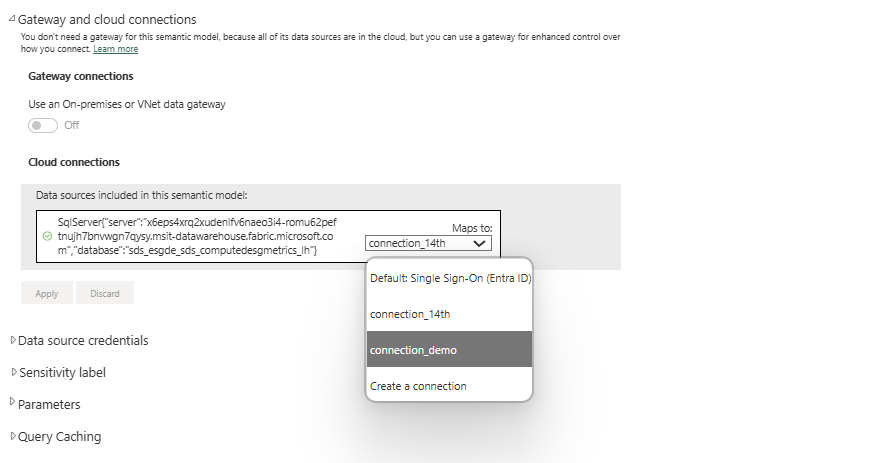

Sélectionnez le modèle sémantique DatasetForMetricsMeasures_DTST dans la page des capacités gérées pour ouvrir le modèle sémantique. Sélectionnez Paramètres dans le menu Fichier . Vous pouvez également ouvrir l’élément à partir de la page de l’espace de travail.

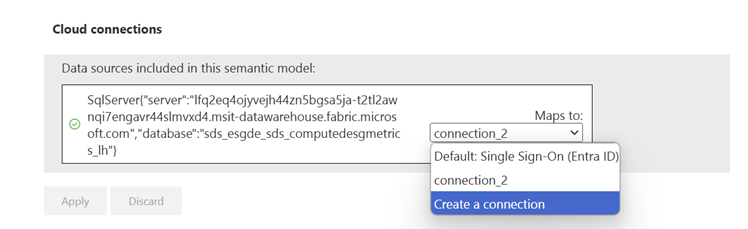

Sélectionnez Passerelle et connexions cloud, puis sélectionnez Créer une nouvelle connexion dans la liste déroulante Connexions cloud . Un panneau latéral Nouvelle connexion s'ouvre.

Dans le panneau latéral Nouvelle connexion , saisissez le nom de la connexion, entrez OAuth 2.0 comme méthode d'authentification, modifiez les informations d'identification et sélectionnez Créer.

Sélectionnez la connexion créée dans la section Connexions passerelle et cloud .

De la même manière, configurez une connexion pour le modèle sémantique DatasetForMetricsDashboard_DTST . Ouvrez le modèle sémantique à partir de la page de l'espace de travail, sélectionnez Paramètres dans le menu Fichier , puis suivez les mêmes étapes que pour DatasetForMetricsMeasures_DTST.

Utilisez Apache Spark runtime 1.3 (Spark 3.5, Delta 3.2) pour exécuter les notebooks et pipelines prédéfinis.

Si vous utilisez le pipeline ExecuteComputationForMetrics_DTPL pour calculer des métriques, vous devez également effectuer ces étapes :

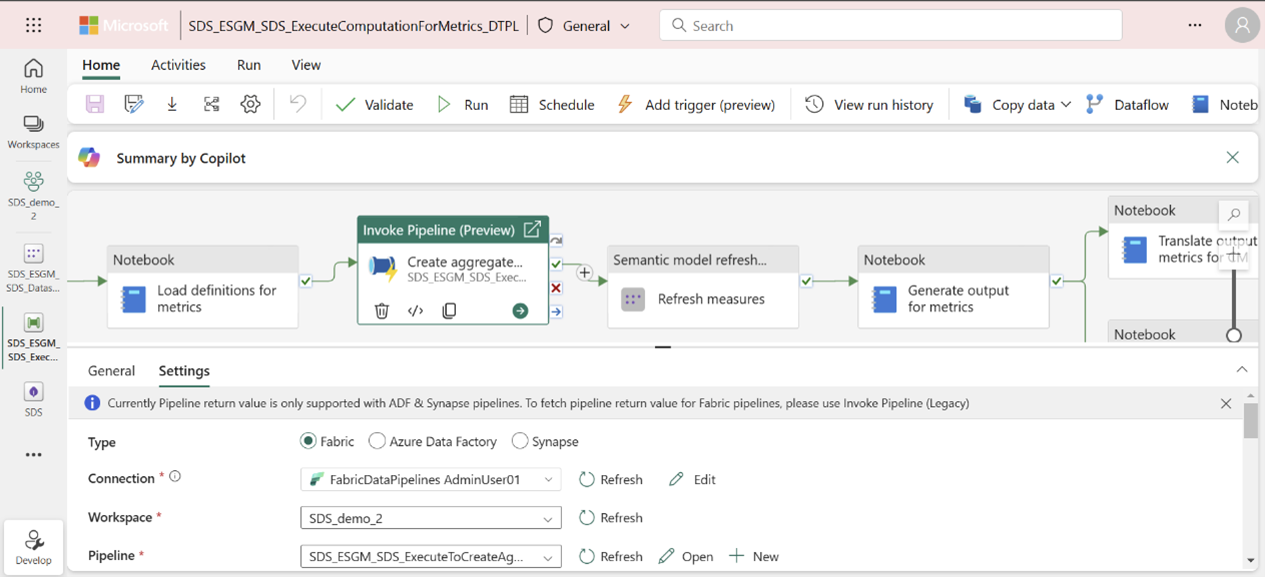

Créez une connexion pour authentifier l'activité Créer des tables d'agrégation du pipeline pour utiliser le pipeline GenerateAggregateForMetrics :

De la même manière, authentifiez-vous en configurant des connexions pour les mesures d’actualisation et les métriques d’actualisation pour les activités du tableau de bord du pipeline :

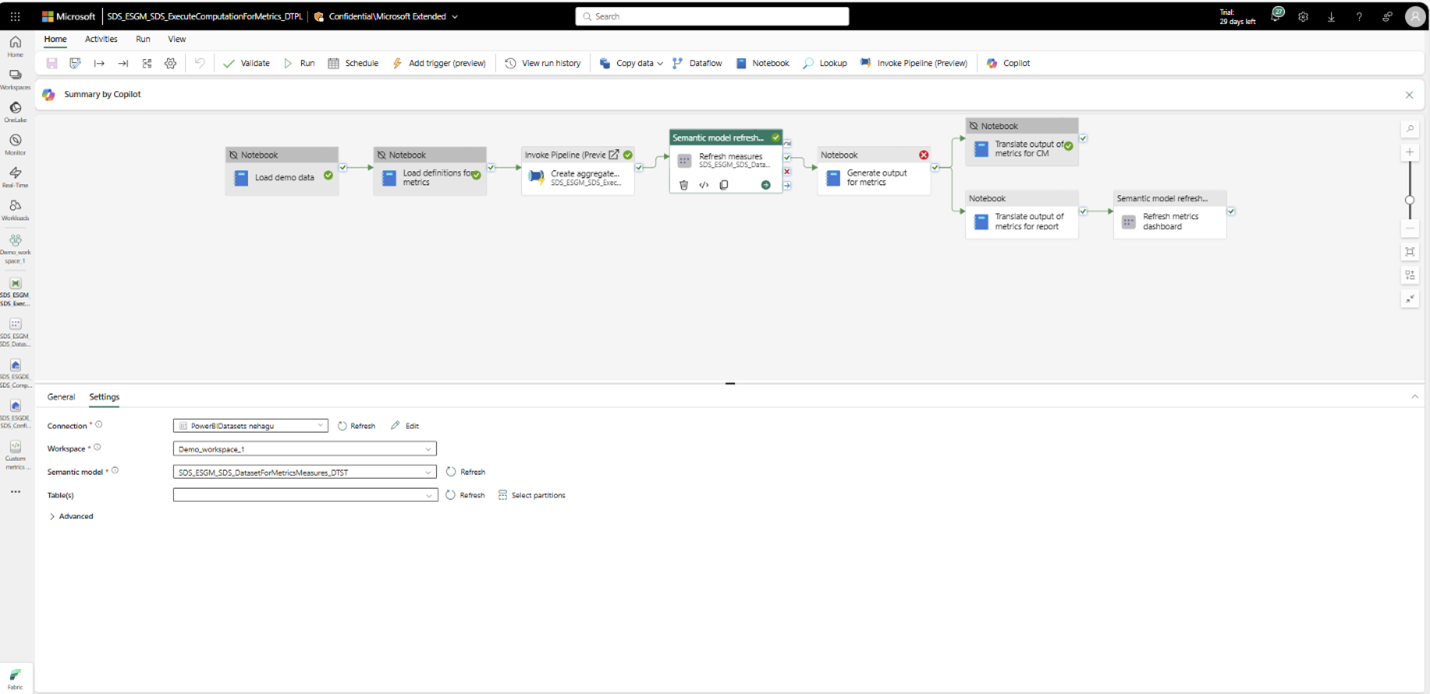

Explorez avec des données de démonstration

Si vous explorez la fonctionnalité avec des données de démonstration et que vous souhaitez simplement afficher la sortie de toutes les métriques, vous pouvez exécuter le pipeline ExecuteComputationForMetrics_DTPL . Ce pipeline fournit une expérience de bout en bout, depuis le chargement des données de démonstration dans le ProcessedESGData_LH lakehouse jusqu’au calcul des métriques prédéfinies. Pour en savoir plus sur la configuration des données de démonstration, accédez à Configurer les données de démonstration.

Avant d’exécuter le pipeline, assurez-vous d’avoir suivi les étapes #3-5 dans la section Prérequis .

Créez ensuite une connexion pour authentifier l’activité Créer des tables agrégées du pipeline pour utiliser le pipeline GenerateAggregateForMetrics :

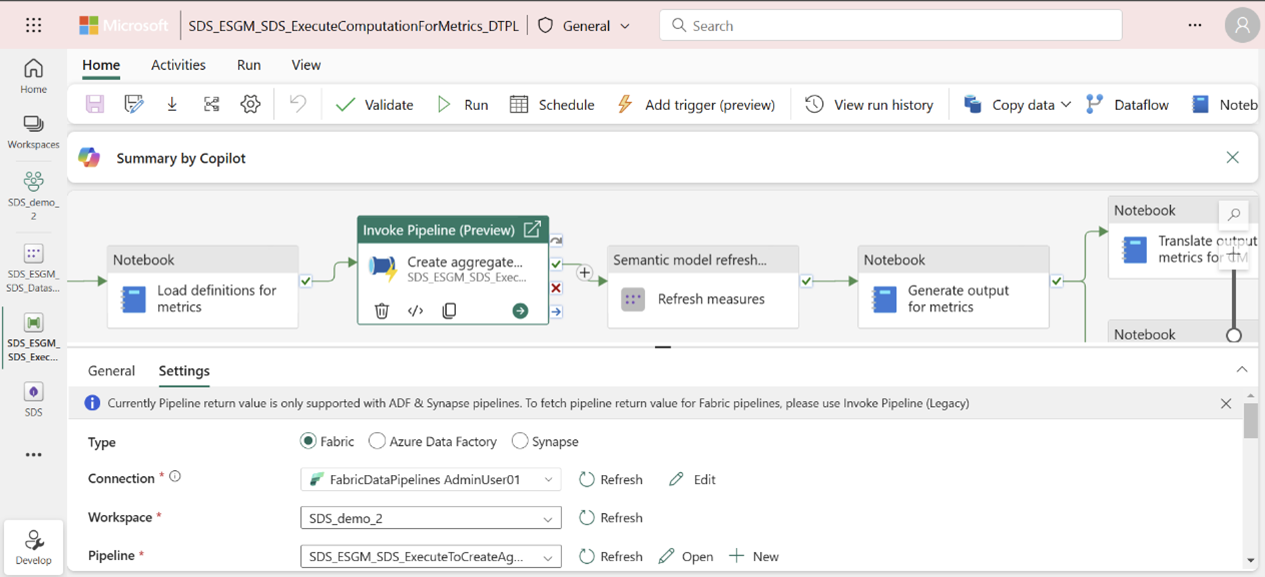

Ouvrez le pipeline ExecuteComputationForMetrics_DTPL à partir de la page de capacité gérée ou de l'espace de travail.

Sélectionnez l’activité de pipeline Créer des tables agrégées , puis sélectionnez Paramètres pour configurer une connexion.

De la même manière, authentifiez-vous en configurant des connexions pour les mesures d’actualisation et les métriques d’actualisation pour les activités du tableau de bord du pipeline. Sélectionnez l’activité, sélectionnez Paramètres, puis sélectionnez une connexion à partir de l’attribut Connexion .

Nonte

Ces étapes de configuration de connexion sont uniques et ne sont pas nécessaires pour les exécutions de pipeline ultérieures.

Une fois ces étapes terminées, sélectionnez Exécuter pour exécuter le pipeline. Vous pouvez surveiller le pipeline en sélectionnant le bouton Afficher l’historique d’exécution .

Ce pipeline effectue les activités suivantes :

Charger les données de démonstration : charge les données de démonstration fournies avec la fonctionnalité de parc de données ESG dans le lac ProcessedESGData_LH.

Nonte

Si vous avez mappé vos données sources dans le processedESGData lakehouse, vous pouvez désactiver cette activité avant d’exécuter le pipeline pour le calcul des métriques.

Charger les définitions de métriques : charge les définitions de métriques contenues dans metrics_definitions_config.json dans la table MetricsDefinitions dans ComputedESGMetrics_LH. Ce tableau est utilisé pour récupérer les détails des métriques tels que la logique de calcul, le nom de la métrique et la zone de durabilité.

Nonte

Cette activité ne doit être effectuée qu’une seule fois. Une fois les définitions de métriques prédéfinies chargées, vous pouvez désactiver cette activité de pipeline pour les exécutions de pipeline suivantes, sauf si les définitions de métriques sont mises à jour dans le fichier metrics_definitions_config.json .

Actualisez le modèle sémantique des mesures en suivant l’étape 2 de Générer des tables agrégées.

Traduire la sortie des métriques pour la consommation de Compliance Manager.

Traduire les sorties de métriques pour la consommation du tableau de bord prédéfini Power BI .

Actualiser le modèle sémantique pour le tableau de bord des métriques.

Nonte

Si vous souhaitez exécuter une activité spécifique du pipeline, vous pouvez désactiver les autres activités. Pour plus d’informations, accédez à Désactiver une activité.

Calculer des données de mesure

Pour calculer les indicateurs ESG, suivez les instructions de ces articles :

- Générer des tableaux agrégés

- Générer et stocker des données métriques

- Consommer des données métriques