Analyser les données sur les émissions

Important

Tout ou partie de cette fonctionnalité est accessible dans le cadre d’une version préliminaire. Le contenu et la fonctionnalité sont susceptibles d’être modifiés.

Vous pouvez utiliser deux méthodes pour accéder aux données d’émissions avec la fonctionnalité d’analyse des émissions Azure dans les solutions de données sur le développement durable dans Microsoft Fabric :

Accédez aux données sur les émissions via SQL

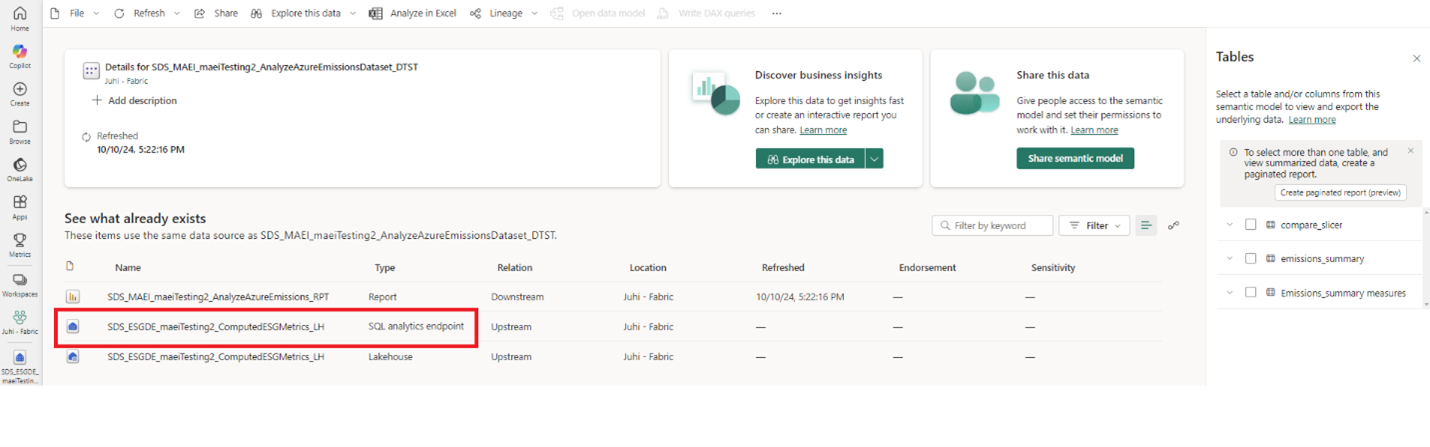

Vous pouvez accéder aux données agrégées dans ComputedESGMetrics lakehouse via le SQL point de terminaison disponible dans AnalyzeAzureEmissionsDataset en procédant comme suit :

Sur la page d’accueil de la fonctionnalité Azure emissions insights , Sélectionner le modèle sémantique AnalyzeAzureEmissionsDataset .

Accédez à ComputedESGMetrics SQL et à pointer.

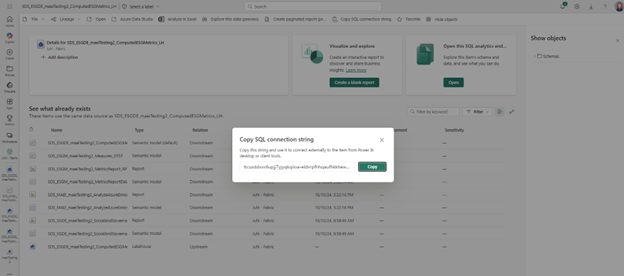

Vous pouvez utiliser Copier la chaîne de connexion SQL pour utiliser jeu de données en externe avec des outils clients SQL compatibles, tels que Azure Data Studio et SQL Server Management Studio (SSMS).

Accéder aux données d’émissions via des API

Créez une identité d’application dans votre Microsoft Entra locataire d’ID et créez un nouveau secret client pour l’identité d’application.

Pour ce cas d’utilisation, enregistrez l’application avec un type de compte de Comptes dans ce répertoire organisationnel uniquement. Ignorez l’URI de redirection, car elle n’est pas obligatoire dans ce cas. Vous pouvez également ignorer les étapes Configurer les paramètres de la plateforme , car elles ne sont pas nécessaires pour ce scénario.

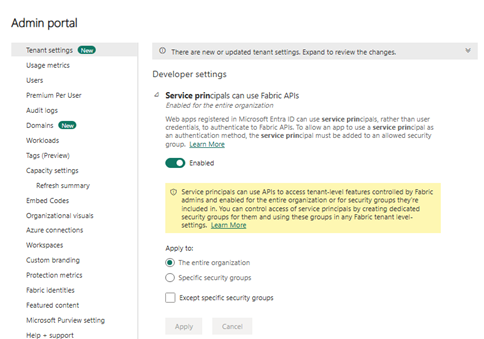

Configurer les paramètres du locataire au niveau administrateur. Assurez-vous que vous disposez de l’un des rôles d’administrateur tels que définis dans Comprendre Microsoft Fabric les rôles d’administrateur dans la Microsoft Fabric documentation. Vérifiez auprès de votre administrateur locataire pour effectuer ces étapes si nécessaire : Microsoft Fabric

Ouvrez l’espace de travail dans Fabric dans lequel vous avez déployé les solutions de données de développement durable.

Sélectionner l’icône Paramètres dans le coin supérieur droit pour ouvrir le panneau latéral des paramètres, puis Sélectionner Portail d’administration.

Dans la section Paramètres du locataire , accédez à Paramètres du développeur et activez l’autorisation Les principaux de service peuvent utiliser les API Fabric pour l’ensemble de l’organisation ou pour un groupe de sécurité spécifique.

Vérifiez que l’identité de l’application que vous avez créée précédemment est membre du groupe de sécurité.

Attribuer des autorisations à l’identité de l’application :

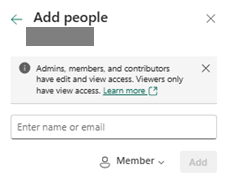

Accédez à la vue de l’espace de travail et Sélectionner l’option Gérer l’accès pour gérer les rôles au niveau de l’espace de travail.

#glsr_cfigha cliqué sur le bouton Ajouter des personnes ou des groupes pour ajouter l’identité de l’application avec l’un des rôles suivants : Membre, collaborateur ou Administrateur. Ce étape est obligatoire, car les données consultées sont un raccourci interne OneLake.

Appeler les API REST :

Note

Vous pouvez intégrer ces appels API REST dans n’importe quelle application client HTTP.

Récupérez le token pour l’identité de l’application configurée. Reportez-vous à Acquérir des jetons pour appeler une API Web à l’aide d’une application démon dans la Microsoft Entra documentation d’ID pour récupérer le jeton pour l’identité de l’application à l’aide des informations d’identification du client OAuth flux de travail 2.0. Le paramètre de portée doit être « https://storage.azure.com/.default" ; » dans la demande de jeton.

Répertoriez les fichiers de partition de données présents dans IngestedRawData lakehouse à l’aide de l’appel d’API suivant.

workspaceId : l’identifiant unique de l’ Microsoft Fabric espace de travail. Par exemple, il s’agit du premier GUID dans l’URL lorsque le fichier IngestedRawData lakehouse est ouvert dans le Microsoft Fabric.

lakehouseId : l’identifiant unique du lakehouse contenant les données d’émissions Azure importées. Ici, les données brutes ingérées lakehouse ID. Par exemple, il s’agit du deuxième GUID dans l’URL lorsque le fichier IngestedRawData lakehouse est ouvert dans le Microsoft Fabric.

enrollmentNumber : ID d’inscription à la facturation dont les données doivent être lues. L’ID d’inscription à la facturation transmis ici est le même que l’un des noms de dossier disponibles sous le chemin "Files/AzureEmissions" dans IngestedRawData lakehouse.

Demande :

HTTP GET https://onelake.dfs.fabric.microsoft.com/<workspaceId>?recursive=false&resource=filesystem&directory=<lakehouseId>%2FFiles%2FAzureEmissions%2F<enrollmentNumber>Réponse :

Renvoie une liste de propriétés de fichier. Il s’agit des fichiers de partition de données stockant les données d’émissions pour le numéro d’inscription spécifié.

Récupérer le contenu du fichier de partition de données spécifique.

workspaceId : l’identifiant unique de l’ Microsoft Fabric espace de travail.

emissionsPartitionFilePath : chemin relatif de l’un des fichiers de partition récupérés à partir de l’appel d’API précédent. Par exemple, cela peut être visualisé comme suit :

<lakehouseId>/Files/AzureEmissions/<enrollmentNumber>/<emissionsPartitionFileName>.parquet

Demande :

HTTP GET https://onelake.dfs.fabric.microsoft.com/<workspaceId>/<emissionsPartitionFilePath>Réponse :

Le contenu du fichier de partition des données d’émissions. Ici, pendant que l’API lit le fichier Parquet, le corps réponse doit être analysé via une bibliothèque ou un outil Parquet approprié. Par exemple, si vous utilisez une application .NET pour lire les données d’émissions à l’aide d’API, vous pouvez utiliser l’une des bibliothèques C# Parquet pour décoder le contenu Parquet et le stocker côté application.